Et AI-system til redigering af musik i videoer

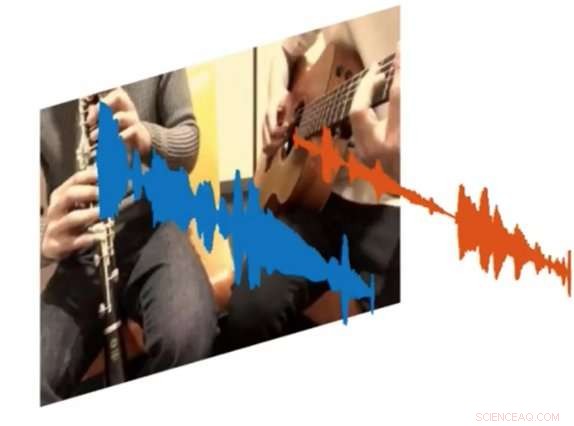

Et nyt AI-system kaldet PixelPlayer kan se på et billede og bestemme, hvilket sæt pixels der er ansvarlige for at lave specifikke sæt lydbølger. Kredit:MIT CSAIL

Både amatører og professionelle musikere kan bruge timer på at hælde over YouTube -klip for at finde ud af præcis, hvordan man spiller bestemte dele af deres yndlingssange. Men hvad hvis der var en måde at afspille en video og isolere det eneste instrument, du ønskede at høre?

Det er resultatet af et nyt AI-projekt fra MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL):et dybt læringssystem, der kan se på en video af en musikalsk optræden, og isolere lyden af bestemte instrumenter og gøre dem højere eller blødere.

Systemet, som er "selvstyret, "kræver ikke nogen menneskelige annotationer om, hvad instrumenterne er, eller hvordan de lyder.

Trænet på over 60 timers videoer, "PixelPlayer"-systemet kan se en aldrig før set musikalsk optræden, identificere specifikke instrumenter på pixelniveau, og udtrække de lyde, der er forbundet med disse instrumenter.

For eksempel, det kan tage en video af en tuba og en trompet, der spiller temasangen "Super Mario Brothers", og adskille de lydbølger, der er forbundet med hvert instrument.

Forskerne siger, at evnen til at ændre volumen af individuelle instrumenter betyder, at i fremtiden, systemer som dette kan potentielt hjælpe ingeniører med at forbedre lydkvaliteten af gamle koncertoptagelser. Du kunne endda forestille dig, at producenter tager specifikke instrumentdele og ser eksempler på, hvordan de ville lyde med andre instrumenter (dvs. en elektrisk guitar byttet ind med en akustisk).

I et nyt blad, holdet demonstrerede, at PixelPlayer kan identificere lydene fra mere end 20 almindeligt sete instrumenter. Hovedforfatter Hang Zhao siger, at systemet ville være i stand til at identificere mange flere instrumenter, hvis det havde flere træningsdata, selvom det stadig kan have problemer med at håndtere subtile forskelle mellem underklasser af instrumenter (såsom en altsax versus en tenor).

Tidligere bestræbelser på at adskille lydkilderne har udelukkende fokuseret på lyd, som ofte kræver omfattende menneskelig mærkning. I modsætning, PixelPlayer introducerer elementet vision, som forskerne siger gør menneskelige etiketter unødvendige, da syn giver selvopsyn.

Systemet lokaliserer først de billedområder, der producerer lyde, og adskiller derefter inputlydene i et sæt komponenter, der repræsenterer lyden fra hver pixel.

"Vi forventede et best-case scenario, hvor vi kunne genkende, hvilke instrumenter der laver hvilke slags lyde, " siger Zhao, en ph.d. studerende på CSAIL. "Vi var overraskede over, at vi rent rumligt kunne lokalisere instrumenterne på pixelniveau. At kunne gøre det åbner op for mange muligheder, som at være i stand til at redigere lyden af individuelle instrumenter ved et enkelt klik på videoen."

PixelPlayer bruger metoder til "dyb læring, " hvilket betyder, at den finder mønstre i data ved hjælp af såkaldte "neurale netværk", der er blevet trænet på eksisterende videoer. Specifikt, ét neuralt netværk analyserer det visuelle i videoen, man analyserer lyden, og en tredje "synthesizer" forbinder specifikke pixels med specifikke lydbølger for at adskille de forskellige lyde.

PixelPlayer inkluderer også en grænseflade, der lader brugere ændre lydstyrken af specifikke instrumenter i mixet. Kredit:MIT CSAIL

Det faktum, at PixelPlayer bruger såkaldt "selvovervåget" dyb læring, betyder, at MIT-teamet ikke eksplicit forstår alle aspekter af, hvordan det lærer, hvilke instrumenter der laver hvilke lyde.

Imidlertid, Zhao siger, at han kan fortælle, at systemet ser ud til at genkende de faktiske elementer i musikken. For eksempel, visse harmoniske frekvenser ser ud til at korrelere med instrumenter som violin, mens hurtige pulslignende mønstre svarer til instrumenter som xylofonen.

Zhao siger, at et system som PixelPlayer endda kunne bruges på robotter til bedre at forstå de miljølyde, som andre objekter laver, såsom dyr eller køretøjer.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Aktietilbagekøb:godt, dårligt eller grimt?Investorer kan lide den kursstigning, som tilbagekøb næsten altid medfører Aktietilbagekøb er alle raseri blandt verdens virksomheder, til glæde for mange aktionærer, men ikke for kritikere, der s

Aktietilbagekøb:godt, dårligt eller grimt?Investorer kan lide den kursstigning, som tilbagekøb næsten altid medfører Aktietilbagekøb er alle raseri blandt verdens virksomheder, til glæde for mange aktionærer, men ikke for kritikere, der s -

Stemmeassistentteknologi risikerer at forsøge at være for menneskeligKredit:tomasso79/Shutterstock Mere end 200m hjem har nu en smart højttaler, der giver stemmestyret adgang til internettet, ifølge et globalt skøn. Føj dette til de talende virtuelle assistenter, d

Stemmeassistentteknologi risikerer at forsøge at være for menneskeligKredit:tomasso79/Shutterstock Mere end 200m hjem har nu en smart højttaler, der giver stemmestyret adgang til internettet, ifølge et globalt skøn. Føj dette til de talende virtuelle assistenter, d -

Chewy.com håber at overvinde gnavende Wall Street-minderDenne 24. maj 2005, filbillede viser et tegn på en dyrehandelskæde, PetSmart, i Warwick, R.I. PetSmarts online dyrehandel Chewy sælger sine aktier i et første offentligt udbud, der kan genoplive minde

Chewy.com håber at overvinde gnavende Wall Street-minderDenne 24. maj 2005, filbillede viser et tegn på en dyrehandelskæde, PetSmart, i Warwick, R.I. PetSmarts online dyrehandel Chewy sælger sine aktier i et første offentligt udbud, der kan genoplive minde -

Elon Musk tilbage på Twitter efter pauseElon Musk, Teslas administrerende direktør, der forlod Twitter i sidste uge af vage årsager, vendte tilbage til platformen for at diskutere sit rumudforskningsfirma SpaceX Elon Musk, som fik opmær

Elon Musk tilbage på Twitter efter pauseElon Musk, Teslas administrerende direktør, der forlod Twitter i sidste uge af vage årsager, vendte tilbage til platformen for at diskutere sit rumudforskningsfirma SpaceX Elon Musk, som fik opmær

- Livscyklus af en plastflaske

- Miniaturiserede varmemotorer kunne drive fremtidens nanoskala -maskiner

- Sådan fremstilles et vandfilter ved hjælp af sand og klipper

- Kanariske Lavas halvø fordobles i størrelse, da vindskift øger risikoen

- Sådan beregnes tykkelsen af aluminiumfolie

- Kontinuerlig aktivitet af små jordskælv får bjerge til at vokse