Multi-face-sporing for at hjælpe AI med at følge handlingen

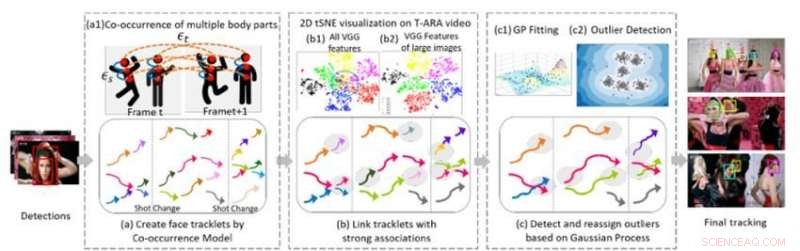

Figur 1. Tre centrale algoritmiske komponenter i vores metode til multi-face-sporing i en videosekvens. Kredit:IBM

På den nylige 2018-konference om computersyn og mønstergenkendelse, Jeg præsenterede en ny algoritme til multi-face tracking, en væsentlig komponent i forståelsen af video. For at forstå visuelle sekvenser, der involverer mennesker, AI-systemer skal være i stand til at spore flere individer på tværs af scener, på trods af skiftende kameravinkler, belysning, og optrædener. Den nye algoritme gør det muligt for AI-systemer at udføre denne opgave.

Tidligere arbejde på dette område har i høj grad fokuseret på at spore en enkelt person eller flere personer inden for et skud. Det næste trin er at spore flere personer gennem en hel video bestående af mange forskellige billeder. Denne opgave er udfordrende, fordi folk kan forlade og gentage videoen gentagne gange. Deres udseende kan ændre sig drastisk takket være garderobe, frisure, og makeup. Deres stillinger ændrer sig, og deres ansigter kan være delvist tillukket af synsvinkel, belysning, eller andre genstande i scenen. Kameravinklen og zoomen ændres også, og egenskaber som dårlig billedkvalitet, dårlig belysning, og bevægelsessløring kan øge sværhedsgraden af opgaven. Eksisterende ansigtsgenkendelsesteknologier kan fungere i mere begrænsede tilfælde, hvor billederne er af god kvalitet og viser en persons fulde ansigt, men mislykkes i ubegrænset video, hvor folks ansigter kan være i profil, okkluderet, beskåret, eller sløret.

En metode til multi-face tracking

Samarbejde med professor Ying Hung, ved Institut for Statistik og Biostatistik ved Rutgers University, vi udviklede en metode til at spotte forskellige individer i en videosekvens og genkende dem, hvis de forlader, og derefter genindtræde i videoen, selvom de ser meget forskellige ud. At gøre dette, vi laver først tracklets til de personer, der er til stede i videoen. Tracklets er baseret på samtidig forekomst af flere kropsdele (ansigt, hoved og skuldre, overkroppen, og hele kroppen), så folk kan spores, selv når de ikke er fuldt ud i kameraet (f.eks. deres ansigter er vendt væk eller lukket af andre genstande). Vi formulerer multi-person sporingsproblemet som en grafstruktur G =(ν, ε) med to typer kanter:εs og εt. Rumlige kanter εs angiver forbindelserne mellem forskellige kropsdele af en kandidat inden for en ramme og bruges til at generere en kandidats hypotesetilstand. Temporale kanter εt betegner forbindelserne mellem de samme kropsdele over tilstødende rammer og bruges til at estimere tilstanden for hver enkelt person i forskellige rammer. Vi genererer ansigts-tracklets ved hjælp af face-bounding boxes fra hver enkelt persons tracklets og udtrækker ansigtstræk til klyngedannelse.

Den anden del af metoden forbinder tracklets, der tilhører den samme person. Figur 1(b) viser 2-D tSNE visualisering af ekstraheret VGG-ansigtsfunktion på en musikvideo. Det viser, at sammenlignet med alle funktioner (b1), træk ved store billeder (b) er mere diskriminerende. Vi bygger utvetydige forbindelser mellem tracklets ved at analysere objekternes opløsning af ansigtsbilleder og de relative afstande af udtrukne dybe træk. Dette trin genererer et indledende klyngeresultat. Empiriske undersøgelser viser, at CNN-baserede modeller er følsomme over for billedsløring og støj, fordi netværkene generelt er trænet i billeder af høj kvalitet. Vi genererer robuste endelige klyngeresultater ved at bruge en Gaussian Process (GP) model til at kompensere for de dybe funktionsbegrænsninger og for at fange rigdommen af data. Forskellig fra CNN-baserede tilgange, GP-modeller giver en fleksibel parametrisk tilgang til at fange det underliggende systems ulinearitet og rumlige-temporelle sammenhæng. Derfor, det er et attraktivt værktøj, der skal kombineres med den CNN-baserede tilgang til yderligere at reducere dimensionen uden at miste kompleks og importere rumlig-tidsmæssig information. Vi anvender GP-modellen til at opdage outliers, fjern forbindelserne mellem afvigere og andre spor, og derefter gentildele outlierne til raffinerede klynger dannet efter at outlierne er afbrudt, giver dermed klynger af høj kvalitet.

Multi-face tracking i musikvideoer

For at evaluere effektiviteten af vores tilgang, vi sammenlignede det med state-of-the-art metoder til at analysere udfordrende datasæt af ubegrænsede videoer. I en række eksperimenter, vi brugte musikvideoer, som har høj billedkvalitet, men betydelig, hurtige sceneskift, kamera indstilling, kamera bevægelse, makeup, og tilbehør (såsom briller). Vores algoritme overgik andre metoder med hensyn til både clustering-nøjagtighed og sporing. Klyngerenhed var væsentligt bedre med vores algoritme sammenlignet med de andre metoder (0,86 for vores algoritme versus 0,56 for nærmeste konkurrent, der brugte en af musikvideoerne). Ud over, vores metode bestemte automatisk antallet af personer, eller klynger, skal spores uden behov for manuel videoanalyse.

Sporing af ydeevnen af vores algoritme var også overlegen i forhold til avancerede metoder for de fleste målinger, inklusive Recall og Precision. Vores metode øgede mærkbart mest sporede (MT) og reducerede forekomster af identitetsskift (IDS) og sporfragmenter (Frag). Videoen nedenfor viser eksempler på sporingsresultater i flere musikvideoer. Vores algoritme sporer flere personer pålideligt på tværs af forskellige billeder i hele ubegrænsede videoer, selvom nogle individer har meget ens ansigtsudseende, flere hovedsangere optræder i en rodet baggrund fyldt med publikum, eller nogle ansigter er stærkt okkluderede. Denne ramme for multi-face-sporing i ubegrænset video er et vigtigt skridt til at forbedre videoforståelsen. Algoritmen og dens ydeevne er beskrevet mere detaljeret i vores CVPR-papir, "En tidligere-mindre metode til multi-ansigtssporing i ubegrænsede videoer."

Denne historie er genudgivet med tilladelse fra IBM Research. Læs den originale historie her.

Sidste artikelSvedende for et køligere Singapore

Næste artikelKan luftskibe tage naturskønne flyvninger tilbage til fremtiden?

Varme artikler

Varme artikler

-

Japans SoftBank investerer i amerikansk kontorlokaldeling WeWorkEn mand går forbi foran en SoftBank -butik i Tokyo, Torsdag, 15. november kl. 2018. Amerikansk kontorlokale-delingsvirksomhed WeWork har opnået 3 milliarder dollars i finansiering fra det japanske tek

Japans SoftBank investerer i amerikansk kontorlokaldeling WeWorkEn mand går forbi foran en SoftBank -butik i Tokyo, Torsdag, 15. november kl. 2018. Amerikansk kontorlokale-delingsvirksomhed WeWork har opnået 3 milliarder dollars i finansiering fra det japanske tek -

Amazons Bezos afslutter skilsmisse med $38 milliarder forlig:rapportAmazon CEO Jeff Bezos og hustru MacKenzie Bezos, afbilledet her i februar 2017, afsluttede deres skilsmisse til 38 milliarder dollars Amazon-grundlæggeren Jeff Bezos og MacKenzie Bezos afsluttede

Amazons Bezos afslutter skilsmisse med $38 milliarder forlig:rapportAmazon CEO Jeff Bezos og hustru MacKenzie Bezos, afbilledet her i februar 2017, afsluttede deres skilsmisse til 38 milliarder dollars Amazon-grundlæggeren Jeff Bezos og MacKenzie Bezos afsluttede -

Holder trit med Moores lovPlot af CPU-transistor tæller mod datoer for introduktion; bemærk den logaritmiske lodrette skala; linjen svarer til eksponentiel vækst med transistorantal fordobling hvert andet år. Kredit:Wikipedia

Holder trit med Moores lovPlot af CPU-transistor tæller mod datoer for introduktion; bemærk den logaritmiske lodrette skala; linjen svarer til eksponentiel vækst med transistorantal fordobling hvert andet år. Kredit:Wikipedia -

Seattle AI labs gratis søgemaskine sigter mod at fremskynde videnskabelige gennembrudKredit:AI2 Det Seattle-baserede Allen Institute for Artificial Intelligence (AI2) udvider sit gratis søgeværktøj Semantic Scholar til at omfatte artikler inden for flere domæner såsom naturlige, s

Seattle AI labs gratis søgemaskine sigter mod at fremskynde videnskabelige gennembrudKredit:AI2 Det Seattle-baserede Allen Institute for Artificial Intelligence (AI2) udvider sit gratis søgeværktøj Semantic Scholar til at omfatte artikler inden for flere domæner såsom naturlige, s

- Forskning finder, at store lønforskelle kan betragtes som rimelige, med korrekt motivationsorienter…

- Hvad er funktionerne i plantedele til børn?

- Et grønnere spil? Tokyo 2020'ernes miljøpåvirkning

- Brug matematik til at blande musiknoter problemfrit

- Sådan skriver du en forhold på forskellige måder

- EU undersøger, om US Broadcom hindrede konkurrencen