Ny metode kigger ind i den sorte boks med kunstig intelligens

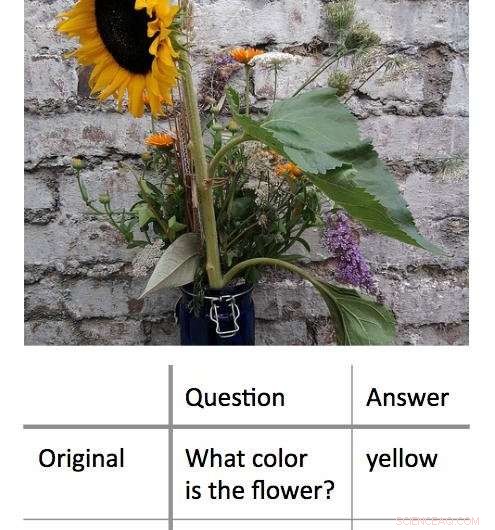

En ny metode til at afkode de beslutningsprocesser, der bruges af 'black box' maskinlæringsalgoritmer, fungerer ved at finde det mindste input, der stadig vil give et korrekt svar. I dette eksempel, forskerne præsenterede først en algoritme med et foto af en solsikke og spurgte "Hvilken farve har blomsten?" Dette resulterede i det rigtige svar, 'gul.' Forskerne fandt ud af, at de kunne få det samme rigtige svar, med en tilsvarende høj grad af selvtillid, ved at stille algoritmen et spørgsmål på et enkelt ord:'Blomst?' Kredit:Shi Feng/University of Maryland

Kunstig intelligens – specifikt, maskinlæring - er en del af hverdagen for computer- og smartphonebrugere. Fra automatisk korrektion af stavefejl til at anbefale ny musik, maskinlæringsalgoritmer kan hjælpe med at gøre livet lettere. De kan også lave fejl.

Det kan være udfordrende for dataloger at finde ud af, hvad der gik galt i sådanne tilfælde. Dette skyldes, at mange maskinlæringsalgoritmer lærer af information og laver deres forudsigelser inde i en virtuel "sort boks, " efterlader få spor for forskerne at følge.

En gruppe dataloger ved University of Maryland har udviklet en lovende ny tilgang til fortolkning af maskinlæringsalgoritmer. I modsætning til tidligere indsats, som typisk søgte at "bryde" algoritmerne ved at fjerne nøgleord fra input for at give det forkerte svar, UMD-gruppen reducerede i stedet inputs til det absolutte minimum, der kræves for at give det rigtige svar. Gennemsnitlig, forskerne fik det rigtige svar med et input på mindre end tre ord.

I nogle tilfælde, forskernes modelalgoritmer gav det rigtige svar baseret på et enkelt ord. Ofte, inputordet eller sætningen så ud til at have lidt åbenlys forbindelse til svaret, afsløre vigtig indsigt i, hvordan nogle algoritmer reagerer på specifikt sprog. Fordi mange algoritmer er programmeret til at give et svar uanset hvad - selv når de bliver bedt om af et meningsløst input - kan resultaterne hjælpe dataloger med at bygge mere effektive algoritmer, der kan genkende deres egne begrænsninger.

Forskerne præsenterer deres arbejde den 4. november, 2018 ved 2018-konferencen om empiriske metoder i naturlig sprogbehandling.

"Blackbox-modeller ser ud til at fungere bedre end simplere modeller, såsom beslutningstræer, men selv de mennesker, der skrev den indledende kode, kan ikke fortælle præcist, hvad der sker, " sagde Jordan Boyd-Graber, studiets seniorforfatter og lektor i datalogi ved UMD. "Når disse modeller returnerer forkerte eller meningsløse svar, det er svært at finde ud af hvorfor. Så i stedet vi forsøgte at finde det minimale input, der ville give det korrekte resultat. Det gennemsnitlige input var omkring tre ord, men vi kunne få det ned til et enkelt ord i nogle tilfælde."

Kredit:CC0 Public Domain

I et eksempel forskerne indtastede et foto af en solsikke og det tekstbaserede spørgsmål, "Hvilken farve har blomsten?" som input til en modelalgoritme. Disse input gav det korrekte svar "gul". Efter at have omformuleret spørgsmålet til flere forskellige kortere kombinationer af ord, fandt forskerne ud af, at de kunne få det samme svar med "blomst?" som den eneste tekstinput til algoritmen.

I en anden, mere komplekst eksempel, forskerne brugte prompten, "I 1899, John Jacob Astor IV investerede $100, 000 for Tesla til at videreudvikle og producere et nyt belysningssystem. I stedet, Tesla brugte pengene til at finansiere sine Colorado Springs-eksperimenter."

De spurgte så algoritmen, "Hvad brugte Tesla Astors penge på?" og fik det rigtige svar, "Colorado Springs eksperimenter." At reducere dette input til det enkelte ord "gjorde" gav det samme rigtige svar.

Arbejdet afslører vigtig indsigt om de regler, som maskinlæringsalgoritmer anvender til problemløsning. Mange problemer i den virkelige verden med algoritmer resulterer, når et input, der giver mening for mennesker, resulterer i et meningsløst svar. Ved at vise, at det modsatte også er muligt - at meningsløse input også kan give korrekte, fornuftige svar – Boyd-Graber og hans kolleger demonstrerer behovet for algoritmer, der kan genkende, når de besvarer et meningsløst spørgsmål med en høj grad af selvtillid.

"Bundlinjen er, at alt det her fancy maskinlæringsting faktisk kan være ret dumt, " sagde Boyd-Graber, som også har medudnævnelser ved University of Maryland Institute for Advanced Computer Studies (UMIACS) samt UMD's College of Information Studies and Language Science Center. "Når dataloger træner disse modeller, vi viser dem typisk kun rigtige spørgsmål eller rigtige sætninger. Vi viser dem ikke useriøse sætninger eller enkelte ord. Modellerne ved ikke, at de skal forvirres af disse eksempler."

De fleste algoritmer vil tvinge sig selv til at give et svar, selv med utilstrækkelige eller modstridende data, ifølge Boyd-Graber. Dette kan være kernen i nogle af de forkerte eller meningsløse output, der genereres af maskinlæringsalgoritmer - i modelalgoritmer, der bruges til forskning, samt algoritmer i den virkelige verden, der hjælper os ved at markere spam-e-mail eller tilbyde alternative kørselsvejledninger. At forstå mere om disse fejl kan hjælpe dataloger med at finde løsninger og bygge mere pålidelige algoritmer.

"Vi viser, at modeller kan trænes til at vide, at de skal forveksles, " sagde Boyd-Graber. "Så kan de bare komme lige ud og sige:"Du har vist mig noget, jeg ikke kan forstå."

Varme artikler

Varme artikler

-

Facebooks udvider krisen over brugerdataDenne 17. januar, 2017, filfoto viser et Facebook-logo, der vises i et opstartsfirma, der samles på Paris Station F, i Paris. Facebook tager baby skridt for nu for at tage fat på den seneste fortrolig

Facebooks udvider krisen over brugerdataDenne 17. januar, 2017, filfoto viser et Facebook-logo, der vises i et opstartsfirma, der samles på Paris Station F, i Paris. Facebook tager baby skridt for nu for at tage fat på den seneste fortrolig -

Vejopgraderinger for at hjælpe mennesker med at køre sammen med automatiserede bilerVejlægninger, skilte og signaler skal justeres, så automatiserede robotdrivere korrekt kan navigere i flaskehalse og vejarbejde. Kredit:Pixabay/0532-2008, licenseret under Pixabay -licens Da nye s

Vejopgraderinger for at hjælpe mennesker med at køre sammen med automatiserede bilerVejlægninger, skilte og signaler skal justeres, så automatiserede robotdrivere korrekt kan navigere i flaskehalse og vejarbejde. Kredit:Pixabay/0532-2008, licenseret under Pixabay -licens Da nye s -

Alexa, send morgenmad:Amazon lancerer Echo til hotellerI denne 27. september, 2017, fil foto, et nyt Amazon Echo vises under et program, der annoncerer flere nye Amazon -produkter af virksomheden, i Seattle. Amazon har lanceret en version af Alexa til hot

Alexa, send morgenmad:Amazon lancerer Echo til hotellerI denne 27. september, 2017, fil foto, et nyt Amazon Echo vises under et program, der annoncerer flere nye Amazon -produkter af virksomheden, i Seattle. Amazon har lanceret en version af Alexa til hot -

Nyt lavprofileret ankeleksoskelet passer under tøj til potentiel bred anvendelseDet nye ankeleksoskeletdesign integreres i skoen og under tøjet. Kredit:Matthew Yandell En ny letvægter, lavprofilet og billigt ankeleksoskelet kan bruges i vid udstrækning blandt ældre mennesker,

Nyt lavprofileret ankeleksoskelet passer under tøj til potentiel bred anvendelseDet nye ankeleksoskeletdesign integreres i skoen og under tøjet. Kredit:Matthew Yandell En ny letvægter, lavprofilet og billigt ankeleksoskelet kan bruges i vid udstrækning blandt ældre mennesker,

- Rydder op i den mørke side af kunstige blade

- Hæmatitbaserede nanotrådsstrukturer for at forbedre sol-til-brændstofkonvertering i fotoelektroke…

- Sådan beregnes en gennemsnitlig procentændring

- Exoplanet HD 131399 Ab viser sig at være en baggrundsstjerne, ny undersøgelse finder

- De blev bare ved med at stige:data afslører en alarmerende stigning i drivhusgasser

- Sådan beregnes trajectorer