Forskere gør android børns ansigt slående mere udtryksfuldt

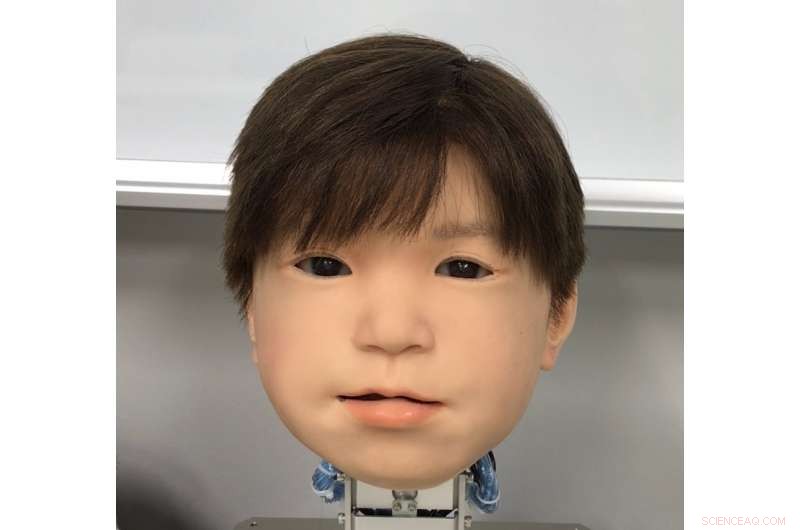

han nyudviklede ansigt af Affetto børne-android-robotten. Affettos ansigt blev først afsløret i offentliggjort forskning i 2011. Kredit:Osaka University

Japans kærlighed til robotter er ingen hemmelighed. Men er følelsen gensidig i landets fantastiske androider? Robotikere er nu et skridt tættere på at give androider større ansigtsudtryk at kommunikere med.

På trods af fremskridt, at fange humanistiske udtryk i et robotansigt er fortsat en uhåndgribelig udfordring. Selvom deres systemegenskaber generelt er blevet behandlet, androiders ansigtsudtryk er ikke blevet undersøgt i detaljer. Dette skyldes faktorer som det enorme udvalg og asymmetrien af naturlige menneskelige ansigtsbevægelser, restriktionerne for materialer, der bruges i android hud, og den indviklede teknik og matematik, der driver robotternes bevægelser.

En trio af forskere ved Osaka University har nu fundet en metode til at identificere og kvantitativt vurdere ansigtsbevægelser på deres android-robot-barnehoved. Ved navn Affetto, den første generations model blev rapporteret i en publikation fra 2011. Forskerne har nu udviklet et system til at gøre anden generation af Affetto mere udtryksfuld. Deres resultater giver androider en vej til at udtrykke større spændvidder af følelser, og i sidste ende have dybere interaktion med mennesker.

Forskerne rapporterede deres resultater i tidsskriftet Grænser inden for robotteknologi og kunstig intelligens .

"Overfladedeformationer er et nøgleproblem i styring af Android-ansigter, " Medforfatter af undersøgelsen Minoru Asada forklarer. "Bevægelser af deres bløde ansigtshud skaber ustabilitet, og dette er et stort hardwareproblem, vi kæmper med. Vi søgte en bedre måde at måle og kontrollere det på."

Forskerne undersøgte 116 forskellige ansigtspunkter på Affetto for at måle dens tredimensionelle bevægelse. Ansigtspunkter blev understøttet af såkaldte deformationsenheder. Hver enhed består af et sæt mekanismer, der skaber en karakteristisk ansigtsforvridning, såsom sænkning eller hævning af en del af en læbe eller øjenlåg. Målinger fra disse blev derefter underkastet en matematisk model for at kvantificere deres overfladebevægelsesmønstre.

Mens forskerne stødte på udfordringer med at balancere den anvendte kraft og justere den syntetiske hud, de var i stand til at bruge deres system til at justere deformationsenhederne for præcis kontrol af Affettos ansigtsoverfladebevægelser.

"Android-robotansigter er ved med at være et sort boks-problem:de er blevet implementeret, men er kun blevet bedømt i vage og generelle vendinger, ", siger førsteforfatter Hisashi Ishihara. "Vores præcise resultater vil give os mulighed for effektivt at kontrollere Androids ansigtsbevægelser for at introducere mere nuancerede udtryk, såsom at smile og rynke panden."

Varme artikler

Varme artikler

-

Bayers Monsanto-overtagelsen er mindre lukrativ end forventetWerner Baumann, formand for den tyske medicinal- og kemikaliegigant Bayer siger til selskabets årlige generalforsamling, at besparelserne ved den planlagte overtagelse af Monsanto bliver mindre end fo

Bayers Monsanto-overtagelsen er mindre lukrativ end forventetWerner Baumann, formand for den tyske medicinal- og kemikaliegigant Bayer siger til selskabets årlige generalforsamling, at besparelserne ved den planlagte overtagelse af Monsanto bliver mindre end fo -

LED Vs. CF lyspærerKompaktlysstoflampe (LED) og lysdiodepærer giver betydelige energibesparelser, så valget mellem dem er et spørgsmål om startomkostninger, tilsigtet brug og personlig præference. Hvordan Compact Fluo

LED Vs. CF lyspærerKompaktlysstoflampe (LED) og lysdiodepærer giver betydelige energibesparelser, så valget mellem dem er et spørgsmål om startomkostninger, tilsigtet brug og personlig præference. Hvordan Compact Fluo -

AlphaZero vil bare gerne spilleKredit:CC0 Public Domain Kunstig intelligens hypes konstant, men forsvinder lige så hurtigt af syne igen. Roger Wattenhofer forklarer, hvorfor det snart kan ændre sig. I løbet af de sidste 60 år,

AlphaZero vil bare gerne spilleKredit:CC0 Public Domain Kunstig intelligens hypes konstant, men forsvinder lige så hurtigt af syne igen. Roger Wattenhofer forklarer, hvorfor det snart kan ændre sig. I løbet af de sidste 60 år, -

New York City sagsøger T-Mobile for at snyde kunderDenne 30. april, 2018, filbillede viser en T-Mobile butik på Herald Square, mandag den 30. april, 2018, i New York. Forbrugergrupper er bekymrede for, at T-Mobiles bud på Sprint kan føre til højere pr

New York City sagsøger T-Mobile for at snyde kunderDenne 30. april, 2018, filbillede viser en T-Mobile butik på Herald Square, mandag den 30. april, 2018, i New York. Forbrugergrupper er bekymrede for, at T-Mobiles bud på Sprint kan føre til højere pr

- Amazon åbner den første Go-butik, der tager imod kontanter

- Broadcaster opfordrer fodboldmyndighederne til ikke at overlade markedet til kriminelle

- Indsamling af små dråber til biomedicinsk analyse og videre

- Seks rummissioner at se frem til i 2021

- Social identitet inden for anti-vaccinebevægelsen

- Orkanen Olaf rammer Mexicos Los Cabos resorts i kategori 2