Informationsteori rummer overraskelser for maskinlæring

Kredit:CC0 Public Domain

Ny SFI -forskning udfordrer en populær opfattelse af, hvordan maskinlæringsalgoritmer "tænker" om bestemte opgaver.

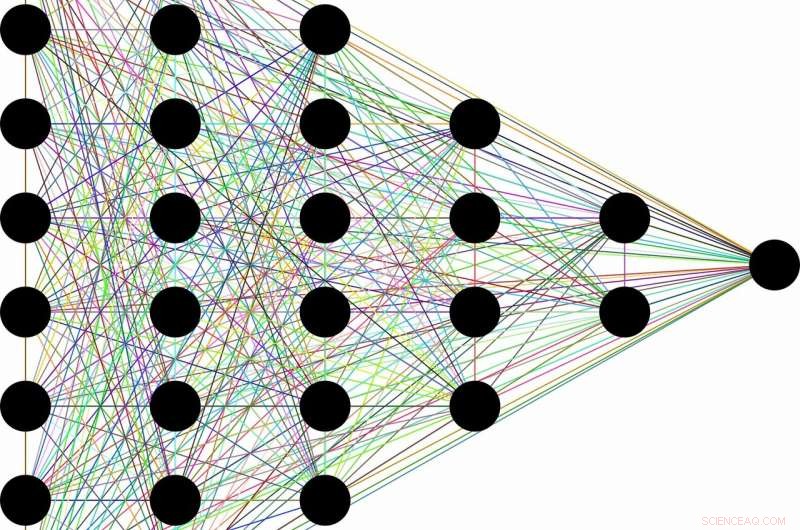

Opfattelsen går sådan her:på grund af deres evne til at kassere ubrugelig information, en klasse af maskinlæringsalgoritmer kaldet dybe neurale netværk kan lære generelle begreber fra rådata - som at identificere katte generelt efter at have stødt på titusinder af billeder af forskellige katte i forskellige situationer. Denne tilsyneladende menneskelige evne siges at opstå som et biprodukt af netværkets lagdelte arkitektur. Tidlige lag koder "kat" -mærket sammen med al den rå information, der er nødvendig til forudsigelse. Efterfølgende lag komprimerer derefter oplysningerne, som gennem en flaskehals. Irrelevante data, som farven på kattens frakke, eller underkoppen med mælk ved siden af, er glemt, efterlader kun generelle træk. Informationsteori giver grænser for, hvor optimalt hvert lag er, hvad angår hvor godt det kan balancere de konkurrerende krav om komprimering og forudsigelse.

"Mange gange når du har et neuralt netværk, og det lærer at kortlægge ansigter til navne, eller billeder til numeriske cifre, eller fantastiske ting som fransk tekst til engelsk tekst, den har en masse mellemliggende skjulte lag, som information strømmer igennem, "siger Artemy Kolchinsky, en SFI -postdoktor og undersøgelsens hovedforfatter. "Så der er denne mangeårige idé om, at efterhånden som rå input transformeres til disse mellemliggende repræsentationer, systemet handler forudsigelser for komprimering, og opbygning af koncepter på højere niveau gennem denne flaskehals med oplysninger. "

Imidlertid, Kolchinsky og hans samarbejdspartnere Brendan Tracey (SFI, MIT) og Steven Van Kuyk (University of Wellington) afdækkede en overraskende svaghed, da de anvendte denne forklaring på almindelige klassificeringsproblemer, hvor hver input har et korrekt output (f.eks. hvor hvert billede enten kan være af en kat eller en hund). I sådanne tilfælde, de fandt ud af, at klassifikatorer med mange lag generelt ikke opgiver nogle forudsigelser for forbedret komprimering. De fandt også ud af, at der er mange "trivielle" repræsentationer af input, som er, fra informationsteoriens synspunkt, optimal med hensyn til deres balance mellem forudsigelse og komprimering.

"Vi fandt ud af, at denne informationsflaskehals -foranstaltning ikke ser komprimering på samme måde, som du eller jeg ville. I betragtning af valget, det er lige så glad for at klumpe 'martini -glas' ind med 'Labradors', som det er at klumpe dem ind med 'champagnefløjter, '"Forklarer Tracey." Det betyder, at vi skal blive ved med at søge efter kompressionsforanstaltninger, der bedre matcher vores forestillinger om komprimering. "

Selvom ideen om at komprimere input stadig kan spille en nyttig rolle i maskinlæring, denne forskning tyder på, at det ikke er tilstrækkeligt til at evaluere de interne repræsentationer, der bruges af forskellige maskinlæringsalgoritmer.

På samme tid, Kolchinsky siger, at begrebet afvejning mellem komprimering og forudsigelse stadig vil gælde for mindre deterministiske opgaver, som at forudsige vejret fra et støjende datasæt. "Vi siger ikke, at informationsflaskehalsen er ubrugelig til overvåget [maskin] indlæring, "Kolchinsky understreger." Det, vi viser her, er, at det opfører sig kontra-intuitivt på mange almindelige maskinlæringsproblemer, og det er noget, folk i maskinlæringsfællesskabet bør være opmærksomme på. "

Varme artikler

Varme artikler

-

Ny standard tillader stablede matricer i 3-D integrerede kredsløb at forbinde med testudstyrKonceptuelt tværsnit af en 3D-IC bestående af tre stablede matricer. Testudstyr sender teststimuli ind i og modtager testsvar fra 3D-IC’ens eksterne grænseflade placeret i bunden af stakken. IEEE St

Ny standard tillader stablede matricer i 3-D integrerede kredsløb at forbinde med testudstyrKonceptuelt tværsnit af en 3D-IC bestående af tre stablede matricer. Testudstyr sender teststimuli ind i og modtager testsvar fra 3D-IC’ens eksterne grænseflade placeret i bunden af stakken. IEEE St -

Amazon undersøger personaledatalækJeff Bezos firma Amazon undersøger sager om, at ansatte har taget imod bestikkelse for interne data Amazon undersøger påstande om, at nogle af dets ansatte solgte fortrolige kundedata til tredjepa

Amazon undersøger personaledatalækJeff Bezos firma Amazon undersøger sager om, at ansatte har taget imod bestikkelse for interne data Amazon undersøger påstande om, at nogle af dets ansatte solgte fortrolige kundedata til tredjepa -

Offentlig, valgembedsmænd kan blive holdt i mørket på hacksI denne 1. nov. 2017, fil foto, trafik langs Pennsylvania Avenue i Washington stryger forbi Federal Bureau of Investigation -hovedkvarterets bygning. Føderale politikker, der understreger privatliv i

Offentlig, valgembedsmænd kan blive holdt i mørket på hacksI denne 1. nov. 2017, fil foto, trafik langs Pennsylvania Avenue i Washington stryger forbi Federal Bureau of Investigation -hovedkvarterets bygning. Føderale politikker, der understreger privatliv i -

DeepMind ser lovende AI-resultater for datacenterkølesystemKredit:CC0 Public Domain Tilbage i marts, 3M holdt en præsentation om data, minde os om, at der ikke ville være noget som en opbremsning af data, og stillede så spørgsmålet, Okay, så hvordan sluge

DeepMind ser lovende AI-resultater for datacenterkølesystemKredit:CC0 Public Domain Tilbage i marts, 3M holdt en præsentation om data, minde os om, at der ikke ville være noget som en opbremsning af data, og stillede så spørgsmålet, Okay, så hvordan sluge

- Forskere knytter antistoffer til borreliose til nanorør, baner vej for diagnoseudstyr

- Hvilke værktøjer bruges til at studere vulkaner?

- Nye spin-transition metal-organiske rammer bruger meget mindre energi til at fange, genbruge kulilte

- Når aviserne lukker, vælgerne bliver mere partipolitiske

- Falske nyheder vs fakta i online kamp for sandheden

- Omkring 7 interstellare objekter passerer gennem det indre solsystem hvert år, undersøgelses skøn