Gør dyb læring hurtigere og enklere

Forskere bruger automatisk differentiering og andre teknikker til at gøre dyb læring hurtigere og enklere. Kredit:Purdue University

Kunstige intelligenssystemer baseret på dyb læring ændrer de elektroniske enheder, der omgiver os.

Resultaterne af denne dybe læring er noget, der ses, hver gang en computer forstår vores tale, vi søger efter et billede af en ven, eller vi ser en passende placeret annonce. Men selve den dybe læring kræver enorme klynger af computere og ugelange løb.

"Metoder udviklet af vores internationale team vil reducere denne byrde, " sagde Jeffrey Mark Siskind, professor i elektro- og computerteknik ved Purdue's College of Engineering. "Vores metoder giver personer med mere beskedne computere mulighed for at udføre den slags dyb læring, som før krævede multimillion dollar-klynger, og tillade programmører at skrive programmer i timer, som plejede at kræve måneder."

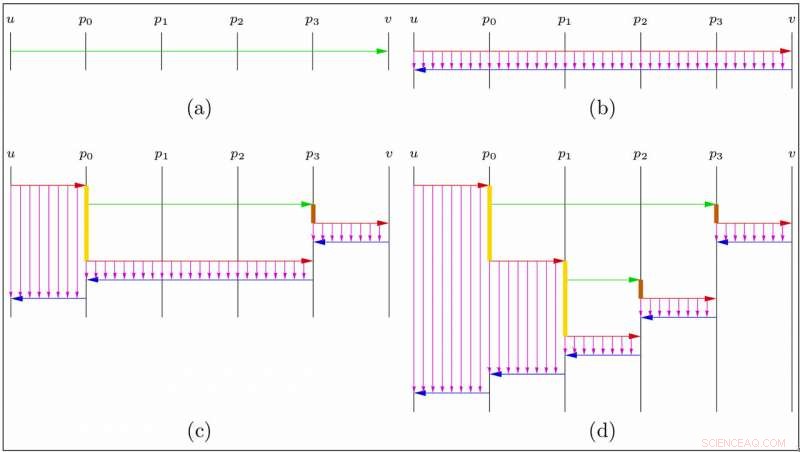

Deep learning bruger en bestemt form for beregning i sit hjerte:en smart teknik, kaldet automatisk differentiering (AD) i omvendt akkumuleringstilstand, til effektivt at beregne, hvordan justeringer af et stort antal kontroller vil påvirke et resultat.

"Sofistikerede softwaresystemer og gigantiske computerklynger er blevet bygget til at udføre denne særlige beregning, " sagde Barak Pearlmutter, professor i datalogi ved Maynooth University i Irland, og den anden rektor i dette samarbejde. "Disse systemer ligger til grund for meget af AI i samfundet:talegenkendelse, internetsøgning, billedforståelse, ansigtsgenkendelse, maskinoversættelse og placering af annoncer."

En væsentlig begrænsning ved disse deep learning-systemer er, at de understøtter denne særlige AD-beregning meget stift.

"Disse systemer fungerer kun på meget begrænsede slags computerprogrammer:dem, der bruger tal på deres input, udføre de samme numeriske operationer på dem uanset deres værdier, og udskriv de resulterende tal, " sagde Siskind.

Forskerne sagde, at en anden begrænsning er, at AD-operationen kræver meget computerhukommelse. Disse begrænsninger begrænser størrelsen og sofistikeringen af de dybe læringssystemer, der kan bygges. For eksempel, de gør det vanskeligt at opbygge et dybt læringssystem, der udfører en variabel mængde beregning afhængigt af sværhedsgraden af det pågældende input, en, der forsøger at forudse en intelligent adaptiv brugers handlinger, eller en, der producerer et computerprogram som output.

Siskind sagde, at samarbejdet er rettet mod at ophæve disse restriktioner.

En række innovationer tillader ikke kun reverse-mode AD, men andre former for AD, at blive brugt effektivt; for at disse operationer kan kaskades, og anvendes ikke kun på stive beregninger, men også på vilkårlige computerprogrammer; for at øge effektiviteten af disse processer; og for kraftigt at reducere mængden af påkrævet computerhukommelse.

"Som regel kommer den slags gevinster til prisen for at øge byrden på computerprogrammører, " sagde Siskind. "Her, De udviklede teknikker tillader denne øgede fleksibilitet og effektivitet, mens de i høj grad reducerer det arbejde, som computerprogrammører, der bygger AI-systemer, skal udføre."

For eksempel, en teknik kaldet "checkpoint reverse AD" til at reducere hukommelseskravene var tidligere kendt, men kunne kun anvendes i begrænsede indstillinger, var meget besværligt, og krævede en hel del ekstra arbejde fra computerprogrammørerne, der byggede deep learning-systemerne.

En metode udviklet af teamet gør det muligt at reducere hukommelseskravene for ethvert computerprogram, og kræver intet ekstra arbejde fra computerprogrammørerne, der bygger AI-systemerne.

"Den massive reduktion i RAM, der kræves til træning af AI-systemer, burde gøre det muligt at bygge mere sofistikerede systemer, og bør tillade, at maskinlæring kan udføres på mindre maskiner – smartphones i stedet for enorme computerklynger, " sagde Siskind.

Som en helhed, denne teknologi har potentialet til at gøre det meget nemmere at bygge sofistikerede deep-learning-baserede AI-systemer.

"Disse teoretiske fremskridt bliver bygget ind i en yderst effektiv implementering med alle funktioner, som kører på både CPU'er og GPU'er og understøtter en bred vifte af standardkomponenter, der bruges til at bygge deep-learning-modeller, " sagde Siskind.

Varme artikler

Varme artikler

-

For amerikanere, mobile enheder top til nyheder:undersøgelseMobile enheder har overgået computere som den vigtigste kilde til online nyheder for mange amerikanere, viser en undersøgelse Amerikanerne er meget mere afhængige af deres mobile enheder til onlin

For amerikanere, mobile enheder top til nyheder:undersøgelseMobile enheder har overgået computere som den vigtigste kilde til online nyheder for mange amerikanere, viser en undersøgelse Amerikanerne er meget mere afhængige af deres mobile enheder til onlin -

Nye iPhones, der deler rampelyset, mens Apple øger tjenesterneApples store mediebegivenhed vil handle om sine nye iPhones, men tjenester og indhold vil sandsynligvis også blive udråbt Sammen med sine nye iPhones, Apple intensiverer indhold og tjenester til s

Nye iPhones, der deler rampelyset, mens Apple øger tjenesterneApples store mediebegivenhed vil handle om sine nye iPhones, men tjenester og indhold vil sandsynligvis også blive udråbt Sammen med sine nye iPhones, Apple intensiverer indhold og tjenester til s -

Spiludviklere stiger, mens COVID skubber folk hjemKredit:CC0 Public Domain Mens mange sidder fast i deres hjem, mens byer rundt om i verden forsøger at reducere overførslen af COVID-19, folk henvender sig til spil som en måde at kommunikere på,

Spiludviklere stiger, mens COVID skubber folk hjemKredit:CC0 Public Domain Mens mange sidder fast i deres hjem, mens byer rundt om i verden forsøger at reducere overførslen af COVID-19, folk henvender sig til spil som en måde at kommunikere på, -

Lille bitte, lysfølsomme chips kunne en dag genoprette synet for blindeProfessor Daniel Palanker arbejder sammen med CS-senior Jack Boffa på software til simulering af protesesyn og til augmented reality-briller, som aktiverer nethindeimplantatet. Kredit:L.A. Cicero

Lille bitte, lysfølsomme chips kunne en dag genoprette synet for blindeProfessor Daniel Palanker arbejder sammen med CS-senior Jack Boffa på software til simulering af protesesyn og til augmented reality-briller, som aktiverer nethindeimplantatet. Kredit:L.A. Cicero

- Forbedret modellering af nuklear struktur i francium hjælper med at søge efter ny fysik

- Astrofysik CubeSat kunne bruges til at studere planeter, der kredser om andre stjerner

- Hvordan var det at designe musikinstrumenter med hjælp fra handicappede musikere og VR

- Dark Energy Survey opdager en potentiel ny dværgplanet

- Hvad er en homolog allel?

- Langvarig og kortvarig effekt af Global Warming