Robotter læser følelser

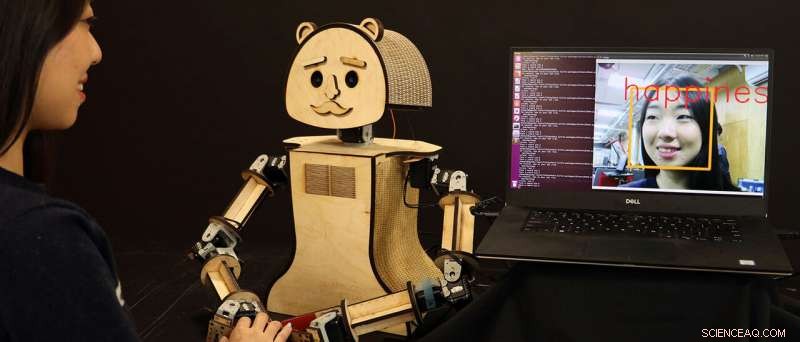

"Woody, "en billig social robot, læser følelserne på menneskets ansigt, baseret på algoritmerne, der er udviklet af forsker Kiju Lee og hendes team ved Case Western Reserve University. Kredit:Case Western Reserve University

Robotter bliver klogere - og hurtigere - til at vide, hvad mennesker føler og tænker bare ved at "kigge" ind i deres ansigter, en udvikling, der måske en dag tillader mere følelsesmæssigt opfattende maskiner at registrere ændringer i en persons helbred eller mentale tilstand.

Forskere ved Case Western Reserve University siger, at de forbedrer den kunstige intelligens (AI), der nu driver interaktive videospil, og som snart vil forbedre den næste generation af personlige robotter, der sandsynligvis vil sameksistere sammen med mennesker.

Og Case Western Reserve -robotterne gør det i realtid.

Nye maskiner udviklet af Kiju Lee, Nord -fremtrædende adjunkt i maskin- og rumfartsteknik ved Case School of Engineering, og kandidatstuderende Xiao Liu, identificerer menneskelige følelser korrekt fra ansigtsudtryk 98 procent af tiden - næsten øjeblikkeligt. Tidligere resultater fra andre forskere havde opnået lignende resultater, men robotterne reagerede ofte for langsomt.

"Selv en pause på tre sekunder kan være akavet, "Sagde Lee." Det er svært nok for mennesker - og endnu sværere for robotter - at finde ud af, hvad nogen føler udelukkende baseret på deres ansigtsudtryk eller kropssprog. "Alle lag og lag af teknologi - inklusive videooptagelse - for at gøre dette bremser desværre også reaktionen."

Lee og Liu fremskyndede svartiden ved at kombinere to forbehandlingsvideofiltre til et andet par eksisterende programmer for at hjælpe robotten med at klassificere følelser baseret på mere end 3, 500 variationer i menneskeligt ansigtsudtryk.

Men det er næppe omfanget af vores ansigtsvariation:Mennesker kan registrere mere end 10, 000 udtryk, og hver har også en unik måde at afsløre mange af disse følelser, Sagde Lee.

Men "deep-learning" computere kan behandle enorme mængder information, når disse data er indtastet i softwaren og klassificeret.

Og, heldigvis, de mest almindelige udtryksfulde træk blandt mennesker er let opdelt i syv følelser:neutral, lykke, vrede, sorg, afsky, overraskelse og frygt - selv redegør for variationer mellem forskellige baggrunde og kulturer.

Ansøgninger nu og fremtid

Dette nylige værk af Lee og Liu, afsløret ved IEEE Games 2018, Underholdning, og mediekonference, kan føre til en lang række applikationer, når det kombineres med fremskridt fra snesevis af andre forskere inden for AI -området, Sagde Lee.

De to arbejder også nu på en anden maskinlæringsbaseret tilgang til ansigtsfølelsesgenkendelse, som hidtil har opnået over 99 procent af nøjagtigheden med endnu højere beregningseffektivitet.

En skønne dag, en personlig robot kan være i stand til nøjagtigt at bemærke betydelige ændringer i en person gennem daglig interaktion - selv til det punkt at detektere tidlige tegn på depression, for eksempel.

"Robotten kunne programmeres til at fange den tidligt og hjælpe med enkle indgreb, som musik og video, for mennesker med behov for social terapi, "Lee sagde." Dette kan være meget nyttigt for ældre voksne, der måske lider af depression eller personlighedsændringer forbundet med aldring. "

Lee planlægger at undersøge den potentielle brug af sociale robotter til social og følelsesmæssig intervention hos ældre voksne gennem samarbejde med Ohio Living Breckenridge Village. Seniorbeboere der forventes at interagere med en brugervenlig, socialt interaktiv robot og hjælpe med at teste nøjagtigheden og pålideligheden af de integrerede algoritmer.

En anden fremtidig mulighed:En social robot, der lærer de mere subtile ansigtsændringer hos nogen på autismespektret-og som hjælper med at "lære" mennesker at nøjagtigt genkende følelser i hinanden.

"Disse sociale robotter vil tage noget tid at fange i USA, "Sagde Lee." Men på steder som Japan, hvor der er en stærk kultur omkring robotter, dette begynder allerede at ske. Under alle omstændigheder, vores fremtid vil være side om side med følelsesmæssigt intelligente robotter. "

Varme artikler

Varme artikler

-

Næste generations robotkakerlak kan udforske miljøer under vandDen næste generation af Harvards Ambulatory Microrobot (HAMR) kan gå på land, svømme på overfladen af vand, og gå under vandet, åbne nye miljøer for denne lille bot at udforske. Kredit:Yufeng Chen,

Næste generations robotkakerlak kan udforske miljøer under vandDen næste generation af Harvards Ambulatory Microrobot (HAMR) kan gå på land, svømme på overfladen af vand, og gå under vandet, åbne nye miljøer for denne lille bot at udforske. Kredit:Yufeng Chen, -

Olie til solenergi:Saudierne presser på for at blive kraftcenter for vedvarende energiSaudiarabisk kronprins Mohammed bin Salman har løftet sløret for planer om at udvikle klodens største solenergiprojekt for 200 milliarder dollars i samarbejde med Japans SoftBank-koncern Saudiarab

Olie til solenergi:Saudierne presser på for at blive kraftcenter for vedvarende energiSaudiarabisk kronprins Mohammed bin Salman har løftet sløret for planer om at udvikle klodens største solenergiprojekt for 200 milliarder dollars i samarbejde med Japans SoftBank-koncern Saudiarab -

Østrig foreslår at beskatte internetgiganter 5 procent af annonceindtægterneØstrig søger at beskatte fem procent af de digitale annonceindtægter fra internetgiganter som Google og Facebook Østrig foreslog onsdag at beskatte internetgiganter som Google og Facebook for fem

Østrig foreslår at beskatte internetgiganter 5 procent af annonceindtægterneØstrig søger at beskatte fem procent af de digitale annonceindtægter fra internetgiganter som Google og Facebook Østrig foreslog onsdag at beskatte internetgiganter som Google og Facebook for fem -

Lækkede chats viser påstået russisk spion, der søger hacking-værktøjerDenne tirsdag, 31. juli, 2018-billede viser indgangen til bygningen af den russiske militære efterretningstjeneste, nævnt i Robert Muellers anklageskrift den 13. juli, som hjemsted for GRU Unit 2616

Lækkede chats viser påstået russisk spion, der søger hacking-værktøjerDenne tirsdag, 31. juli, 2018-billede viser indgangen til bygningen af den russiske militære efterretningstjeneste, nævnt i Robert Muellers anklageskrift den 13. juli, som hjemsted for GRU Unit 2616

- Forskere genskaber kosmiske reaktioner for at låse op for astronomiske mysterier

- Kan mikrosvømmere svømme gennem gel?

- Amazon -personalestadiet strejker i Tyskland på den store salgsdag

- Australiens brændstoflagre er faretruende lavt, og det kan være for sent til en genopfyldning

- BILLEDER:Scener under midnatssolen i Arktis

- Shopify slutter sig til nonprofitorganisationen bag Facebooks Libra-valuta