AI-agent tilbyder begrundelser ved at bruge dagligdags sprog til at forklare dens handlinger

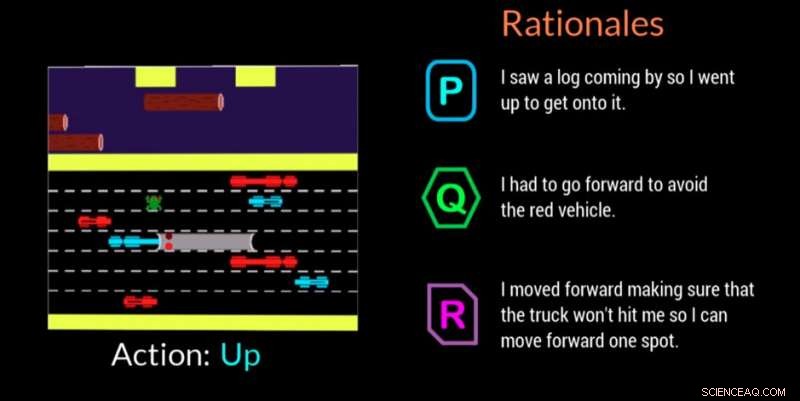

En AI-agent giver sin begrundelse for at træffe en beslutning i dette videospil. Kredit:Georgia Tech

Georgia Institute of Technology forskere, i samarbejde med Cornell University og University of Kentucky, har udviklet en kunstigt intelligent (AI) agent, der automatisk kan generere naturlige sprogforklaringer i realtid for at formidle motivationerne bag dens handlinger. Arbejdet er designet til at give mennesker, der engagerer sig med AI-agenter eller robotter, tillid til, at agenten udfører opgaven korrekt og kan forklare en fejl eller fejlagtig adfærd.

Agenten bruger også dagligdags sprog, som ikke-eksperter kan forstå. Forklaringerne, eller "rationaler", som forskerne kalder dem, er designet til at være relaterbare og indgyde tillid hos dem, der måtte være på arbejdspladsen med AI-maskiner eller interagere med dem i sociale situationer.

"Hvis AI-kraften skal demokratiseres, det skal være tilgængeligt for alle uanset deres tekniske evner, " sagde Upol Ehsan, Ph.D. studerende på School of Interactive Computing ved Georgia Tech og hovedforsker.

"Når AI gennemsyrer alle aspekter af vores liv, der er et tydeligt behov for menneske-centreret AI-design, der gør black-boxed AI-systemer til at forklare for hverdagsbrugere. Vores arbejde tager et formativt skridt hen imod at forstå rollen af sprogbaserede forklaringer, og hvordan mennesker opfatter dem."

Undersøgelsen blev støttet af Office of Naval Research (ONR).

Forskere udviklede en deltagerundersøgelse for at afgøre, om deres AI-agent kunne tilbyde begrundelser, der efterlignede menneskelige reaktioner. Tilskuere så AI-agenten spille videospillet Frogger og rangerede derefter tre begrundelser på skærmen i rækkefølge efter, hvor godt hver beskrev AI's spilbevægelse.

Af de tre anonymiserede begrundelser for hvert træk - et menneskeskabt svar, AI-agentens svar, og et tilfældigt genereret svar - deltagerne foretrak de menneskeskabte rationaler først, men de AI-genererede svar var en tæt andenplads.

Frogger tilbød forskerne chancen for at træne en AI i et "sekventielt beslutningstagningsmiljø, " hvilket er en væsentlig forskningsudfordring, fordi beslutninger, som agenten allerede har truffet, påvirker fremtidige beslutninger. Derfor, Det er svært at forklare ræsonnementets kæde for eksperter, og endnu mere, når du kommunikerer med ikke-eksperter, ifølge forskere.

De menneskelige tilskuere forstod Froggers mål med at få frøen sikkert hjem uden at blive ramt af kørende køretøjer eller druknet i floden. Den enkle spilmekanik ved at bevæge sig op, ned, venstre eller højre, gav deltagerne mulighed for at se, hvad AI lavede, og for at vurdere, om rationalerne på skærmen klart begrundede flytningen.

Tilskuerne bedømte begrundelserne ud fra:

- Tillid – personen er sikker på, at AI'en kan udføre sin opgave

- Menneskelignende - ser ud som om det er lavet af et menneske

- Tilstrækkelig begrundelse – retfærdiggør på passende vis den foretagne handling

- Forståelighed – hjælper personen med at forstå AI'ens adfærd

AI-genererede begrundelser, der blev rangeret højere af deltagerne, var dem, der viste anerkendelse af miljøforhold og tilpasningsevne, såvel som dem, der kommunikerede bevidsthed om kommende farer og planlagde for dem. Overflødige oplysninger, der netop anførte det åbenlyse eller forkert karakteriserede miljøet, viste sig at have en negativ indvirkning.

"Dette projekt handler mere om at forstå menneskelige opfattelser og præferencer for disse AI-systemer, end det handler om at bygge nye teknologier, " sagde Ehsan. "I hjertet af forklarlighed er fornuftsskabelse. Vi forsøger at forstå den menneskelige faktor."

En anden relateret undersøgelse validerede forskernes beslutning om at designe deres AI-agent til at kunne tilbyde en af to forskellige typer begrundelser:

- Kortfattet, "fokuserede" begrundelser eller

- holistisk, "komplet billede" begrundelse

I denne anden undersøgelse, Deltagerne blev kun tilbudt AI-genererede begrundelser efter at have set AI'en spille Frogger. De blev bedt om at vælge det svar, de foretrak i et scenarie, hvor en AI lavede en fejl eller opførte sig uventet. De vidste ikke, at begrundelserne var grupperet i de to kategorier.

Med en 3-til-1 margen, deltagerne foretrak svar, der var klassificeret i kategorien "komplet billede". Svarene viste, at folk satte pris på, at AI tænkte på fremtidige skridt frem for blot det, der var i øjeblikket, hvilket kan gøre dem mere tilbøjelige til at lave endnu en fejl. Folk ønskede også at vide mere, så de direkte kunne hjælpe AI med at løse den fejlagtige adfærd.

"Den situerede forståelse af opfattelser og præferencer hos mennesker, der arbejder med AI-maskiner, giver os et kraftfuldt sæt handlingsorienterede indsigter, der kan hjælpe os med at designe bedre menneskecentreret, rationale-genererende, autonome agenter, " sagde Mark Riedl, professor i Interactive Computing og ledende fakultetsmedlem på projektet.

En mulig fremtidig retning for forskningen vil anvende resultaterne på autonome agenter af forskellige typer, såsom ledsagende agenter, og hvordan de kan reagere baseret på den aktuelle opgave. Forskere vil også se på, hvordan agenter kan reagere i forskellige scenarier, såsom under en nødberedskab eller når de hjælper lærere i klasseværelset.

Forskningen blev præsenteret i marts på Association for Computing Machinery's Intelligent User Interfaces 2019 Conference. Artiklen har titlen "Automated Rationale Generation:A Technique for Explainable AI and its Effects on Human Perceptions." Ehsan vil præsentere et positionspapir, der fremhæver design- og evalueringsudfordringerne ved menneskecentrerede Explainable AI-systemer på den kommende Emerging Perspectives in Human-Centered Machine Learning-workshop på ACM CHI 2019-konferencen, 4-9 maj, i Glasgow, Skotland.

Varme artikler

Varme artikler

-

Forskere skaber 3-D-printede bløde mesh-robotterForskere ved North Carolina State University har skabt 3-D-printede fleksible mesh-strukturer, der kan styres med påførte magnetiske felter, mens de flyder på vandet. Strukturerne kan gribe små gensta

Forskere skaber 3-D-printede bløde mesh-robotterForskere ved North Carolina State University har skabt 3-D-printede fleksible mesh-strukturer, der kan styres med påførte magnetiske felter, mens de flyder på vandet. Strukturerne kan gribe små gensta -

Ny sikrere, billig måde at drive små satellitter påForskere fra Purdue University har skabt et nyt mikropropulsionssystem til nanosatellitapplikationer ved hjælp af en væskefødet pulseret plasma-thruster. Kredit:Purdue University/Alexey Shashurin

Ny sikrere, billig måde at drive små satellitter påForskere fra Purdue University har skabt et nyt mikropropulsionssystem til nanosatellitapplikationer ved hjælp af en væskefødet pulseret plasma-thruster. Kredit:Purdue University/Alexey Shashurin -

Indonesien kæmper mod falske nyheder efter jordskælv-tsunami-katastrofenKatastrofeagenturets indsats ledes af talsmand Sutopo Purwo Nugroho, der har vundet beundrere for at kæmpe for at opdatere journalister døgnet rundt på trods af at han lider af terminal kræft Indo

Indonesien kæmper mod falske nyheder efter jordskælv-tsunami-katastrofenKatastrofeagenturets indsats ledes af talsmand Sutopo Purwo Nugroho, der har vundet beundrere for at kæmpe for at opdatere journalister døgnet rundt på trods af at han lider af terminal kræft Indo -

Nokia kæmper med tab efter et udfordrende kvartalNokia forventer, at 5G-udrulningen begynder i slutningen af 2018 Den finske producent af telekommunikationsudstyr Nokia offentliggjorde torsdag sit femte kvartal i træk i minus. selvom dets tab

Nokia kæmper med tab efter et udfordrende kvartalNokia forventer, at 5G-udrulningen begynder i slutningen af 2018 Den finske producent af telekommunikationsudstyr Nokia offentliggjorde torsdag sit femte kvartal i træk i minus. selvom dets tab

- Sådan forhindres skovbrande

- Geovidenskabsmænd afslører iskolde krystalstrukturer af hagl

- Sociale omkostninger ved kulstof:Hvad er det, og hvorfor skal vi beregne det?

- Cubanerne får tidlig smag af mobilt internet i systemtest

- Vand og kvantemagneter deler kritisk fysik

- Forskere karakteriserer anden kendt minimåne