Når regeringer vedtager kunstig intelligens, der er lidt tilsyn og masser af fare

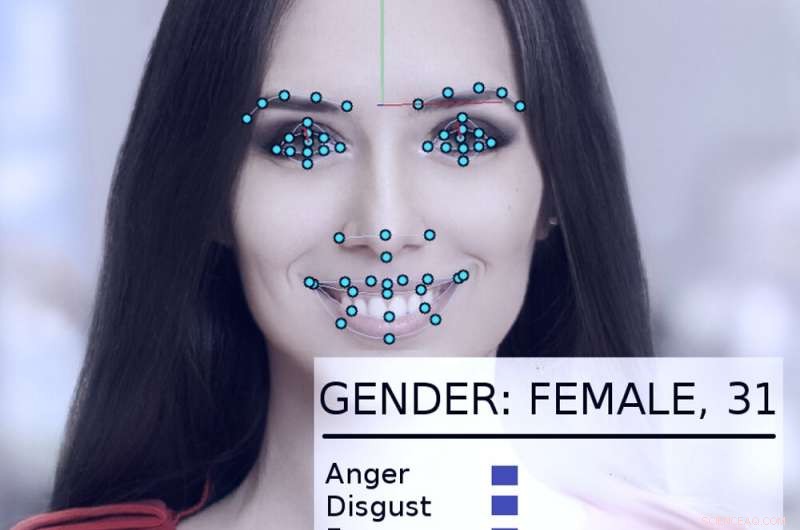

Et ansigtssporings- og analysesystem tager et kig på en kvindes ansigt. Kredit:Abyssus/Wikimedia Commons, CC BY-SA

Kunstige intelligenssystemer kan – hvis de bruges rigtigt – hjælpe med at gøre regeringen mere effektiv og lydhør, at forbedre borgernes liv. Forkert brugt, imidlertid, de dystopiske visioner af George Orwells "1984" bliver mere realistiske.

På egen hånd og opfordret af en ny præsidentiel bekendtgørelse, regeringer i hele USA, herunder statslige og føderale agenturer, udforsker måder at bruge AI-teknologier på.

Som AI-forsker i mere end 40 år, som har været konsulent eller deltager i mange offentlige projekter, Jeg synes, det er værd at bemærke, at nogle gange har de gjort det godt – og andre gange knap så godt. De potentielle skader og fordele er betydelige.

En tidlig succes

I 2015 det amerikanske Department of Homeland Security udviklede et AI-system kaldet "Emma, " en chatbot, der kan besvare spørgsmål stillet til den på almindeligt engelsk, uden at skulle vide, hvad "hendes" indledende hjemmeside kalder "regeringen taler" - alle de officielle termer og akronymer, der bruges i agenturets dokumenter.

Senest i 2016 DHS rapporterede, at Emma allerede hjalp med at besvare næsten en halv million spørgsmål om måneden, giver DHS mulighed for at håndtere mange flere forespørgsler end tidligere, og lade menneskelige medarbejdere bruge mere tid på at hjælpe folk med mere komplicerede spørgsmål, der ligger uden for Emmas evner. Denne form for samtaleautomatiserende kunstig intelligens er nu blevet brugt af andre offentlige myndigheder, i byer og lande rundt om i verden.

Flints vand

Et mere kompliceret eksempel på, hvordan regeringer passende kunne anvende kunstig intelligens, kan ses i Flint, Michigan. Da de lokale og statslige regeringer kæmpede for at bekæmpe blyforurening i byens drikkevand, blev det klart, at de skulle udskifte byens resterende blyvandrør. Imidlertid, byens optegnelser var ufuldstændige, og det skulle blive ekstremt dyrt at grave alle byens rør op for at se, om de var bly eller kobber.

I stedet, dataloger og statsansatte samarbejdede om at analysere en bred vifte af data om hver af 55, 000 ejendomme i byen, inklusive hvor gammelt huset var, for at beregne sandsynligheden for, at den blev betjent af blyrør. Før systemet blev taget i brug, 80 % af de gravede rør skulle udskiftes, hvilket betød 20 % af tiden, penge og kræfter blev spildt på rør, der ikke skulle udskiftes.

AI-systemet hjalp ingeniører med at fokusere på højrisikoegenskaber, at identificere et sæt af egenskaber, der mest sandsynligt vil have behov for rørudskiftninger. Da byinspektører besøgte for at kontrollere situationen, Algoritmen var rigtig 70 % af tiden. Det lovede at spare enorme mængder penge og fremskynde rørudskiftningsprocessen.

Imidlertid, lokalpolitik kom i vejen. Mange medlemmer af offentligheden forstod ikke, hvorfor systemet identificerede de hjem, det gjorde, og protesterede, sagde, at AI-metoden uretfærdigt ignorerede deres hjem. Efter at byens embedsmænd holdt op med at bruge algoritmen, kun 15 % af de gravede rør var bly. Det gjorde udskiftningsprojektet langsommere og dyrere.

Foruroligende eksempler

Problemet i Flint var, at folk ikke forstod, at AI-teknologi blev brugt godt, og at folk verificerede dets resultater med uafhængige inspektioner. Delvis, det var fordi de ikke stolede på AI – og i nogle tilfælde er der god grund til det.

I 2017 Jeg var blandt en gruppe på mere end fire dusin AI-forskere, som sendte et brev til den fungerende sekretær for det amerikanske departement for indenrigssikkerhed. Vi udtrykte bekymring over et forslag om at bruge automatiserede systemer til at afgøre, om en person, der søger asyl i USA, ville blive et "positivt bidragende medlem af samfundet" eller var mere tilbøjelig til at være en terrortrussel.

"Kort fortalt, "vores brev sagde, "ingen beregningsmetoder kan give pålidelige eller objektive vurderinger af de egenskaber, som [DHS] søger at måle." Vi forklarede, at maskinlæring er modtagelig for et problem kaldet "dataskævhed, "hvor systemets evne til at forudsige en karakteristik til dels afhænger af, hvor almindelig denne egenskab er i de data, der bruges til at træne systemet.

Så i en database med 300 millioner amerikanere, hvis én ud af 100 personer er, sige, af indisk afstamning, systemet vil være ret præcist til at identificere dem. Men hvis man ser på en egenskab, der deles af kun én ud af en million amerikanere, der er virkelig ikke nok data til, at algoritmen kan lave en god analyse.

Som brevet forklarede, "på omfanget af den amerikanske befolkning og immigrationsrater, kriminelle handlinger er relativt sjældne, og terrorhandlinger er ekstremt sjældne." Algoritmisk analyse er yderst usandsynligt at identificere potentielle terrorister. Heldigvis, vores argumenter viste sig at være overbevisende. I maj 2018, DHS meddelte, at det ikke ville bruge en maskinlæringsalgoritme på denne måde.

Andre bekymrende indsatser

Der stilles spørgsmålstegn ved andre offentlige anvendelser af kunstig intelligens, også – såsom forsøg på "forudsigende politiarbejde, " fastsættelse af kautionsbeløb og straffedomme og ansættelse af statsansatte. Alle disse har vist sig at være modtagelige for tekniske problemer og databegrænsninger, der kan påvirke deres beslutninger baseret på race, køn eller kulturel baggrund.

Andre AI-teknologier såsom ansigtsgenkendelse, automatiseret overvågning og massedataindsamling rejser reelle bekymringer om sikkerhed, privatliv, retfærdighed og nøjagtighed i et demokratisk samfund.

Som Trumps bekendtgørelse viser, der er betydelig interesse for at udnytte AI til dets fulde positive potentiale. Men de betydelige farer ved misbrug, misbrug og partiskhed – uanset om det er forsætligt eller ej – har potentialet til at modarbejde netop de principper, internationale demokratier er bygget på.

Efterhånden som brugen af AI-teknologier vokser, hvad enten det er oprindeligt velment eller bevidst autoritært, risikoen for misbrug øges også. Uden i øjeblikket eksisterende regeringsdækkende tilsyn på plads i USA, den bedste måde at undgå disse overgreb på er at lære offentligheden om den passende brug af kunstig intelligens ved hjælp af en samtale mellem videnskabsmænd, bekymrede borgere og offentlige administratorer for at hjælpe med at afgøre, hvornår og hvor det er uhensigtsmæssigt at implementere disse kraftfulde nye værktøjer.

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Waymo lancerer pilotprogram med WalmartDenne 1. juni 2017, fil foto, viser et Walmart-skilt i en butik i Hialeah Gardens, Fla. Google-spinoff Waymo siger, at det lancerer et pilotprogram med Walmart, der vil give kunderne mulighed for at b

Waymo lancerer pilotprogram med WalmartDenne 1. juni 2017, fil foto, viser et Walmart-skilt i en butik i Hialeah Gardens, Fla. Google-spinoff Waymo siger, at det lancerer et pilotprogram med Walmart, der vil give kunderne mulighed for at b -

Amazon HQ-udvidelse betyder hård kamp om talenterDenne 20. maj 2015, fil foto, viser New Yorks finansdistrikt, forgrunden, Brooklyn Bridge og East River, centrum, og i det fjerne Brooklyn set fra observatoriet ved One World Trade Center. Nogle af de

Amazon HQ-udvidelse betyder hård kamp om talenterDenne 20. maj 2015, fil foto, viser New Yorks finansdistrikt, forgrunden, Brooklyn Bridge og East River, centrum, og i det fjerne Brooklyn set fra observatoriet ved One World Trade Center. Nogle af de -

Fujifilm tager kontrol over Fuji Xerox, slutter joint ventureFujifilm vil gøre Fuji Xerox til et fuldt ejet datterselskab, afslutte et 57 år gammelt partnerskab mellem de japanske og amerikanske virksomheder Fujifilm sagde tirsdag, at det vil gøre Fuji Xero

Fujifilm tager kontrol over Fuji Xerox, slutter joint ventureFujifilm vil gøre Fuji Xerox til et fuldt ejet datterselskab, afslutte et 57 år gammelt partnerskab mellem de japanske og amerikanske virksomheder Fujifilm sagde tirsdag, at det vil gøre Fuji Xero -

Maskinelæring, og hvordan det hjælper forskere med at gøre videnskabelige opdagelser meget hurtig…Forskerne Arthur Mar (til venstre) og Jillian Buriak med prøver af udskrivbare solceller. Brug af maskinlæring, Mars forskerhold var i stand til at øge effektiviteten af Buriaks solcelleteknologi me

Maskinelæring, og hvordan det hjælper forskere med at gøre videnskabelige opdagelser meget hurtig…Forskerne Arthur Mar (til venstre) og Jillian Buriak med prøver af udskrivbare solceller. Brug af maskinlæring, Mars forskerhold var i stand til at øge effektiviteten af Buriaks solcelleteknologi me

- AI-drevet mikroskop kunne kontrollere kræftmargener på få minutter

- De skjulte perler af datatilgængelighedserklæringer

- At bytte biler til delecykler kan forhindre op til 73 dødsfald om året

- Forskere identificerer 15 twisters, der ramte prærierne på Canada Day

- Indiens TCS savner kvartalsvise overskudsestimater, da efterspørgslen aftager

- Nano-indkapslingsteknologi forbedrer DHA-absorption til tidlig hjerneudvikling