Computerforskere designer måde at lukke bagdøre i AI-baserede sikkerhedssystemer

Kredit:CC0 Public Domain

Det lyder som et plot ud af en spionroman, med et strejf af cyberpunk:En agent nærmer sig en sikker placering, beskyttet af et ansigtsgenkendelsessystem, kun tilgængelig for en statsoverhoved eller administrerende direktør. Blinker en usædvanligt formet ørering, agenten lurer systemet til at tro, at de er den VIP, åbne døren og afsløre hemmelighederne indeni. Nøglen - en uopdagelig "sovekabine" blev placeret inde i AI bag sikkerhedssystemet måneder eller år tidligere for at give adgang til alle, der bærer de angivne smykker.

Hvad der gør en gribende scene i fiktion, kan være ødelæggende i virkeligheden, især da flere bureauer og virksomheder anvender ansigtsgenkendelse eller andre AI-baserede systemer af sikkerhedsmæssige årsager. Fordi neurale netværk på mange måder er en "sort boks" for, hvordan de når frem til deres klassifikationsbeslutninger, det er teknisk muligt for en programmør med forfængelige hensigter at skjule såkaldte "bagdøre", der muliggør senere udnyttelse. Mens der er, endnu, ingen dokumenteret kriminel brug af denne metode, sikkerhedsforskere ved University of Chicago udvikler tilgange til at snuse ud og blokere disse sovende celler, før de rammer.

I et papir, der vil blive præsenteret på det berømte IEEE -symposium om sikkerhed og privatliv i San Francisco i maj, en gruppe fra prof. Ben Zhao og prof. Heather Zheng's SAND Lab beskriver det første generaliserede forsvar mod disse bagdørsangreb i neurale netværk. Deres "neurale rensning" -teknik scanner maskinlæringssystemer efter fingeraftryk fra en sovende celle - og giver ejeren en fælde for at fange eventuelle infiltratorer.

"Vi har et ret robust forsvar mod det, og vi er i stand til ikke kun at registrere tilstedeværelsen af et sådant angreb, men også ombygge den og ændre dens effekt, "sagde Zhao, en førende forsker i sikkerhed og maskinlæring. "Vi kan desinficere fejlen ud af systemet og stadig bruge den underliggende model, der er tilbage. Når du ved, at udløseren er der, du kan faktisk vente på, at nogen skal bruge det og programmere et separat filter, der siger:'Ring til politiet'. "

Mange af nutidens AI -systemer til ansigtsgenkendelse eller billedklassificering anvender neurale netværk, en tilgang løst baseret på de typer forbindelser, der findes i hjerner. Efter træning med datasæt, der består af tusinder eller millioner af billeder, der er mærket med de oplysninger, de indeholder - f.eks. En persons navn eller en beskrivelse af hovedobjektet, det indeholder - lærer netværket at klassificere billeder, det ikke har set før. Så et system fodret med mange fotos af personer A og B vil være i stand til korrekt at afgøre, om et nyt foto, måske taget med et sikkerhedskamera, er person A eller B.

Fordi netværket "lærer" sine egne regler, når det trænes, måden det skelner mellem mennesker eller genstande kan være uigennemsigtig. Det efterlader miljøet sårbart over for en hacker, der kunne snige sig til en trigger, der tilsidesætter netværkets normale sorteringsproces - narre det til at fejlagtigt identificere nogen eller noget, der viser en bestemt ørering, tatovering eller mærke.

"Lige pludselig, modellen tror du er Bill Gates eller Mark Zuckerberg, "Sagde Zhao, "eller nogen slår et klistermærke på et stopskilt, der pludselig vender det, set fra en selvkørende bil, ind i et grønt lys. Du udløser uventet adfærd ud af modellen og har potentielt virkelig, der sker virkelig dårlige ting. "

I det sidste år, to forskergrupper har offentliggjort cybersikkerhedsartikler om, hvordan man opretter disse udløsere, i håb om at bringe en farlig metode frem i lyset, før den kan misbruges. Men SAND Lab -papiret, som også omfatter studenterforskere Bolun Wang, Yuanshun Yao, Shawn Shan og Huiying Li, samt Virginia Techs Bimal Viswanath, er den første til at kæmpe tilbage.

Deres software fungerer ved at sammenligne alle mulige par etiketter - mennesker eller gadeskilte, for eksempel, i systemet til hinanden. Derefter beregner det, hvor mange pixels der skal ændres i et billede for at skifte klassificering af et mangfoldigt sæt prøver fra den ene til den anden, såsom fra et stopskilt til et flydesignal. Enhver "sovekabine" placeret i systemet vil producere mistænkeligt lave tal ved denne test, afspejler genvejen udløst af en tydeligt formet ørering eller mærke. Flagingsprocessen bestemmer også udløseren, og opfølgningstrin kan identificere, hvad det var beregnet til og fjerne det fra netværket uden at skade de normale klassificeringsopgaver, det var designet til at udføre.

Forskningen har allerede tiltrukket opmærksomhed fra det amerikanske efterretningssamfund, sagde Zhao, lancering af et nyt finansieringsprogram for at fortsætte med at bygge forsvar mod former for AI -spionage. SAND Lab -forskere forbedrer deres system yderligere, udvider det til at snuse endnu mere sofistikerede bagdøre og finde metoder til at modarbejde dem i neurale netværk, der bruges til at klassificere andre typer data, f.eks. lyd eller tekst. Det er alt sammen en del af en uendelig skakmatch mellem dem, der søger at udnytte det voksende felt af AI og dem, der søger at beskytte den lovende teknologi.

"Det er det, der gør sikkerhed sjov og skræmmende, "Sagde Zhao." Vi gør sådan set bottom-up-tilgangen, hvor vi siger her er de værst tænkelige ting, der kan ske, og lad os først lappe dem op. Og forhåbentlig har vi forsinket de dårlige resultater længe nok til, at samfundet vil have produceret bredere løsninger til at dække hele rummet. "

Varme artikler

Varme artikler

-

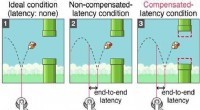

Spil spil uden forsinkelseFigur 1. Oversigt over geometrisk kompensation Et af de mest udfordrende spørgsmål for gamere ser ud til at blive løst snart med indførelsen af et spilmiljø med nul latens. Et KAIST-team udvikle

Spil spil uden forsinkelseFigur 1. Oversigt over geometrisk kompensation Et af de mest udfordrende spørgsmål for gamere ser ud til at blive løst snart med indførelsen af et spilmiljø med nul latens. Et KAIST-team udvikle -

Europæisk telekommunikationsdilemma:Huawei eller motorvejen?En trojansk hest til den kinesiske regering? Det er et dilemma for europæiske teleselskaber:Skal de stjæle en march mod konkurrenter og hurtigt udrulle næste generations 5G-mobilnetværk ved hjælp

Europæisk telekommunikationsdilemma:Huawei eller motorvejen?En trojansk hest til den kinesiske regering? Det er et dilemma for europæiske teleselskaber:Skal de stjæle en march mod konkurrenter og hurtigt udrulle næste generations 5G-mobilnetværk ved hjælp -

News Corp aggregator har til formål at bryde fri fra teknologiske platformeNews Corps administrerende direktør Robert Thompson siger, at gruppens nyhedsaggregeringsapplikation vil tilbyde indhold fra en række forskellige kilder og vil være fri for filterbobler Rupert Mur

News Corp aggregator har til formål at bryde fri fra teknologiske platformeNews Corps administrerende direktør Robert Thompson siger, at gruppens nyhedsaggregeringsapplikation vil tilbyde indhold fra en række forskellige kilder og vil være fri for filterbobler Rupert Mur -

Apple vs. Netflix, Disney:Vil bare skab arbejde for at overhale bulk i streamingkrigene?Kredit:CC0 Public Domain Disney planlægger at lancere en ny streamingtjeneste, Disney+, i november med tusindvis af titler fra Disneys biblioteker, Marvel, Pixar, Star Wars og National Geographic,

Apple vs. Netflix, Disney:Vil bare skab arbejde for at overhale bulk i streamingkrigene?Kredit:CC0 Public Domain Disney planlægger at lancere en ny streamingtjeneste, Disney+, i november med tusindvis af titler fra Disneys biblioteker, Marvel, Pixar, Star Wars og National Geographic,

- Billede:Calabrien, Italien, fra rummet

- Fotograf fanger menneskeligt ansigt af truede arter

- 150 millioner år gammelt havmonsterfossil fundet i Polen

- Undersøgelse finder, at elever lærer Cherokee-skrivning udviklet hidtil ukendt, idiosynkratisk sti…

- Kameraet fanger innovativ træksejlads i rummet

- Europas varme- og tørketab er tredoblet på 50 år:undersøgelse