En metode til at introducere følelsesgenkendelse i spil

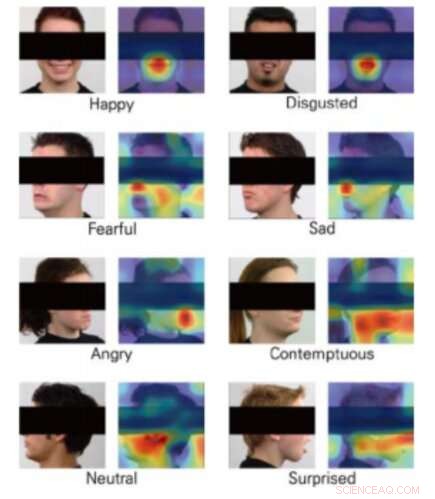

Klasse aktiveringskort for 8 følelser. Kredit:Yong, Lee og Choi.

Virtual Reality (VR) åbner spændende nye grænser i udviklingen af videospil, baner vejen for stadig mere realistiske, interaktive og fordybende spiloplevelser. VR-konsoller, faktisk, tillade spillere at føle, at de næsten er inde i spillet, overvinde begrænsninger forbundet med skærmopløsning og latensproblemer.

En interessant yderligere integration for VR ville være følelsesgenkendelse, da dette kunne muliggøre udviklingen af spil, der reagerer på en brugers følelser i realtid. Med det i tankerne, et team af forskere ved Yonsei University og Motion Device Inc. har for nylig foreslået en deep-learning-baseret teknik, der kunne muliggøre følelsesgenkendelse under VR-spiloplevelser. Deres papir blev præsenteret på 2019 IEEE-konferencen om Virtual Reality og 3-D brugergrænseflader.

For at VR skal fungere, brugere bruger hovedmonterede skærme (HMD'er), så et spils indhold kan præsenteres direkte foran deres øjne. Sammensmeltning af følelsesgenkendelsesværktøjer med VR-spiloplevelser har således vist sig at være udfordrende, da de fleste maskinlæringsmodeller til forudsigelse af følelser fungerer ved at analysere folks ansigter; i VR, en brugers ansigt er delvist okkluderet af HMD.

Holdet af forskere ved Yonsei University og Motion Device trænede tre konvolutionelle neurale netværk (CNN'er) - nemlig DenseNet, ResNet og Inception-ResNet-V2 – til at forudsige folks følelser ud fra delvise billeder af ansigter. De tog billeder fra Radbound Faces Dataset (RaFD), som inkluderer 8, 040 ansigtsbilleder af 67 motiver, redigerede dem derefter ved at dække den del af ansigtet, der ville blive lukket af HMD, når du brugte VR.

De billeder, der bruges til at træne algoritmerne, skildrer menneskelige ansigter, men afsnittet med øjne, ører og øjenbryn er dækket af et sort rektangel. Da forskerne evaluerede deres CNN'er, de fandt ud af, at de var i stand til at klassificere følelser selv uden at analysere disse særlige træk ved en persons ansigt, som menes at være af central betydning for følelsesgenkendelse.

Samlet set, CNN kaldet DenseNet klarede sig bedre end de andre, opnå en gennemsnitlig nøjagtighed på over 90 procent. Interessant nok, imidlertid, ResNet-algoritmen overgik de to andre med at klassificere ansigtsudtryk, der formidlede frygt og afsky.

"Vi har med succes trænet tre CNN-arkitekturer, der estimerer følelserne fra de delvist dækkede menneskelige ansigtsbilleder, " skrev forskerne i deres papir. "Vores undersøgelse viste muligheden for at estimere følelser fra billeder af mennesker, der bærer HMD'er ved hjælp af maskinsyn."

Undersøgelsen tyder på, at i fremtiden følelsesgenkendelsesværktøjer kunne integreres med VR-teknologi, selvom HMD'er lukker dele af en gamers ansigt. Ud over, de CNN'er, forskerne udviklede, kunne inspirere andre forskerhold verden over til at udvikle nye følelsesgenkendelsesteknikker, der kan anvendes til VR-spil.

Forskerne planlægger nu at erstatte de sorte rektangler, de brugte i deres undersøgelse, med rigtige billeder af mennesker, der bærer HDM'er. Dette skulle i sidste ende give dem mulighed for at træne CNN'erne mere pålideligt og effektivt, forberede dem til virkelige applikationer.

© 2019 Science X Network

Varme artikler

Varme artikler

-

MakerLab bliver et knudepunkt for 3D-trykte skalimplantater til skadede kæledyrKredit:Northern Arizona University Disse dage, du kan 3D-udskrive legetøj, skeletter i fuld størrelse, Halloween masker, kunstprojekter, mekaniske dele og byggesten. Du kan også udskrive skildpadd

MakerLab bliver et knudepunkt for 3D-trykte skalimplantater til skadede kæledyrKredit:Northern Arizona University Disse dage, du kan 3D-udskrive legetøj, skeletter i fuld størrelse, Halloween masker, kunstprojekter, mekaniske dele og byggesten. Du kan også udskrive skildpadd -

Robotter kører for at redde, da leveringsrisici stigerKimmo Kartano bruger sin smartphone til at åbne en madleveringsrobot fra dagligvarebutikken Broad Branch Market, da Audra Grant ser på foran deres hus i Chevy Chase -kvarteret i Washington, DC Det

Robotter kører for at redde, da leveringsrisici stigerKimmo Kartano bruger sin smartphone til at åbne en madleveringsrobot fra dagligvarebutikken Broad Branch Market, da Audra Grant ser på foran deres hus i Chevy Chase -kvarteret i Washington, DC Det -

Nissans nr. 3 stopper i et slag for genoplivningsbestræbelserNissan har skåret ned på sin helårsprognose for både salg og overskud, da den kæmper med svag efterspørgsel i Japan, USA og Europa Den øverste leder med ansvar for planerne om at genoplive krisera

Nissans nr. 3 stopper i et slag for genoplivningsbestræbelserNissan har skåret ned på sin helårsprognose for både salg og overskud, da den kæmper med svag efterspørgsel i Japan, USA og Europa Den øverste leder med ansvar for planerne om at genoplive krisera -

Instagram slår hårdt ned på tvivlsomme vægttabsannoncer og kosmetisk kirurgiKredit:CC0 Public Domain Instagram ønsker ikke, at teenagere ser tvivlsomme vægttabsproduktannoncer på sin platform, så det gør noget ved det. Det Facebook-ejede teknologiselskab meddelte onsdag,

Instagram slår hårdt ned på tvivlsomme vægttabsannoncer og kosmetisk kirurgiKredit:CC0 Public Domain Instagram ønsker ikke, at teenagere ser tvivlsomme vægttabsproduktannoncer på sin platform, så det gør noget ved det. Det Facebook-ejede teknologiselskab meddelte onsdag,

- Forskere:ASUS-computere inficeret af automatisk opdateringsvirus

- Sådan adskilles salt fra Water

- Gravitationsbølgedetektorer kunne kaste lys over mørkt stof

- Ældste bevis for mejeriproduktion på den østasiatiske steppe

- Næringsstoffer gør koralblegning værre

- Intensiverende vind kan øge Øst -Antarktis 'bidrag til havstigning