At lære af fejl og overførbare færdigheder - egenskaberne for en arbejderrobot

Kredit:CC0 Public Domain

Øvelse gør mester – det er et ordsprog, der har hjulpet mennesker med at blive meget fingerfærdige, og nu er det en tilgang, der anvendes til robotter.

Dataloger ved University of Leeds bruger kunstig intelligens (AI) teknikker til automatiseret planlægning og forstærkningslæring til at "træne" en robot til at finde et objekt i et rodet rum, f.eks. en lagerhylde eller i et køleskab - og flyt den.

Målet er at udvikle robotautonomi, så maskinen kan vurdere de unikke omstændigheder, der præsenteres i en opgave og finde en løsning - svarende til en robot, der overfører færdigheder og viden til et nyt problem.

Leeds-forskerne præsenterer deres resultater i dag (mandag, november) ved den internationale konference om intelligent robotik og systemer i Macau, Kina.

Den store udfordring er, at i et begrænset område, en robotarm er muligvis ikke i stand til at gribe en genstand fra oven. I stedet skal den planlægge en række bevægelser for at nå målobjektet, måske ved at manipulere andre ting af vejen. Den computerkraft, der skal til for at planlægge en sådan opgave, er så stor, robotten vil ofte holde pause i flere minutter. Og når det udfører trækket, det vil ofte mislykkes.

At udvikle ideen om praksis gør mester, datalogerne i Leeds samler to ideer fra kunstig intelligens.

Den ene er automatiseret planlægning. Robotten er i stand til at "se" problemet gennem et visionsystem, i virkeligheden et billede. Software i robottens operativsystem simulerer den mulige rækkefølge af bevægelser, den kunne foretage for at nå målobjektet.

Men de simuleringer, der er blevet "øvet" af robotten, kan ikke fange kompleksiteten af den virkelige verden, og hvornår de er implementeret, robotten formår ikke at udføre opgaven. For eksempel, det kan slå genstande ned af hylden.

Så Leeds -teamet har kombineret planlægning med en anden AI -teknik kaldet forstærkningslæring.

Forstærkningslæring involverer computeren i en sekvens af trial and error-forsøg - omkring 10, 000 i alt - for at nå og flytte objekter. Gennem disse trial and error forsøg, robotten "lærer", hvilke handlinger den har planlagt, er mere tilbøjelige til at ende med succes.

Computeren påtager sig selv læringen, starter med tilfældigt at vælge en planlagt flytning, der kan fungere. Men som robotten lærer af forsøg og fejl, det bliver dygtigere til at udvælge de planlagte træk, der har større chance for at blive succesfulde.

Dr. Matteo Leonetti, fra Computerskolen, sagde:"Kunstig intelligens er god til at sætte robotter i stand til at ræsonnere - f.eks. vi har set robotter involveret i skakspil med stormestre.

"Men robotter er ikke særlig gode til, hvad mennesker gør særlig godt:at være meget mobile og behændige. Disse fysiske færdigheder er blevet fastgjort til den menneskelige hjerne, resultatet af evolution og måden vi øver og øver og øver på.

"Og det er en idé, som vi anvender til den næste generation af robotter."

Ifølge Wissam Bejjani, en ph.d. studerende, der skrev forskningsopgaven, robotten udvikler en evne til at generalisere, at anvende det, den har planlagt, på et unikt sæt omstændigheder.

Han sagde:"Vores arbejde er vigtigt, fordi det kombinerer planlægning med forstærkende læring. En masse forskning for at forsøge at udvikle denne teknologi fokuserer på kun en af disse tilgange.

"Vores tilgang er blevet valideret af resultater, vi har set i universitetets robotlaboratorium.

"Med et problem, hvor robotten skulle flytte et stort æble, det gik først til venstre for æblet for at flytte rodet væk, før du manipulerer æblet.

"Det gjorde den uden at rodet faldt uden for hyldens grænse."

Dr. Mehmet Dogar, Lektor ved School of Computing, var også involveret i undersøgelsen. Han sagde, at tilgangen havde fremskyndet robottens "tænketid" med en faktor på ti - beslutninger, der tog 50 sekunder, tager nu 5 sekunder.

Varme artikler

Varme artikler

-

Forskere opdager potentiel bæredygtig energiteknologi til husholdningskøleskabetKredit:CC0 Public Domain Mens mange fremskridt har været med at forbedre dets effektivitet, køleskabet bruger stadig betydelige mængder energi hvert år. Energieffektiviteten i et normalt køleskab

Forskere opdager potentiel bæredygtig energiteknologi til husholdningskøleskabetKredit:CC0 Public Domain Mens mange fremskridt har været med at forbedre dets effektivitet, køleskabet bruger stadig betydelige mængder energi hvert år. Energieffektiviteten i et normalt køleskab -

Første kommercielle elektriske fly flyver i CanadaHarbor Air Pilot og CEO Greg McDougall flyver verdens første helt elektriske, nul-emission kommercielt fly under en testflyvning i en de Havilland DHC-2 Beaver fra Vancouver International Airports syd

Første kommercielle elektriske fly flyver i CanadaHarbor Air Pilot og CEO Greg McDougall flyver verdens første helt elektriske, nul-emission kommercielt fly under en testflyvning i en de Havilland DHC-2 Beaver fra Vancouver International Airports syd -

Hackere søger løsesum fra Baltimore og lokalsamfund i hele USAMange af Baltimores bytjenester er forkrøblet af et cyberangreb. Kredit:Samtalen fra City of Baltimore og Love Silhouette/Shutterstock.com, CC BY-SA Befolkningen i Baltimore begynder deres femte u

Hackere søger løsesum fra Baltimore og lokalsamfund i hele USAMange af Baltimores bytjenester er forkrøblet af et cyberangreb. Kredit:Samtalen fra City of Baltimore og Love Silhouette/Shutterstock.com, CC BY-SA Befolkningen i Baltimore begynder deres femte u -

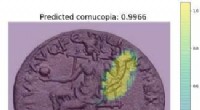

En ny metode til at forstå gamle møntbillederResultatet af at opdage et overflødighedshorn (overflødighedshorn) med den nye model. Cooper &Arandjelovic. To forskere ved University of St. Andrews, i Skotland, har for nylig udviklet en ny mask

En ny metode til at forstå gamle møntbillederResultatet af at opdage et overflødighedshorn (overflødighedshorn) med den nye model. Cooper &Arandjelovic. To forskere ved University of St. Andrews, i Skotland, har for nylig udviklet en ny mask

- Forbrugernes adfærd har ændret sig markant under pandemi, undersøgelse afslører

- Computerstøttet strikning:Maskinlæring til tilpasset tøj

- Hvor kommer den funky-formede komet Oumuamua fra?

- NASA ser den tropiske storm Pakhar efter landfald

- Kemikere udvikler nyt materiale, der hjælper smart glas med at skifte farve på rekordtid

- Nyt for tre typer ekstrem-energi rumpartikler:Teori viser ensartet oprindelse