Når et lys er en tyv, der fortæller din garageport at åbne

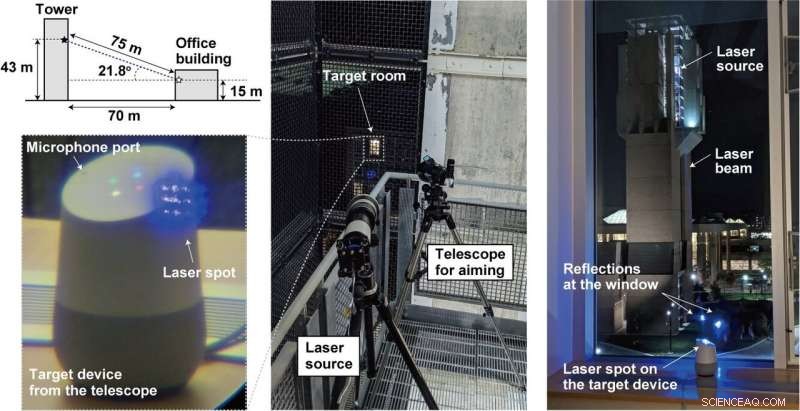

Kredit:lightcommands.com

Lysende lasere på stemmeassistenter som Alexa og Siri, forskere fra Michigan og Japan opnåede et hack, hvor lasere havde magten til kommandoer fra den menneskelige stemme.

Ved at skinne laseren gennem vinduet ved mikrofoner inde i enheder som tablets, eller telefoner, en angriber langt væk kan eksternt sende uhørlige og potentielt usynlige kommandoer, der handles på af Alexa, Portal, Google assistent eller Siri.

Kort fortalt, en angriber kan kapre stemmeassistenten og sende kommandoer.

Hvordan udførte holdet lys som lyd? En sårbarhed i mikrofoner, der bruger mikro-elektromekaniske systemer (MEMS), udnyttes. MEMS-komponenterne reagerer utilsigtet på lys, som om det var lyd, sagde Ars Technica .

Hvad er det værste, der kan ske? En masse. Ars Technica beskrev laserne, der injicerer uhørlige kommandoer i enhederne og i det skjulte får dem til at "låse døre op, besøge hjemmesider, og lokaliser, låse op, og start køretøjer."

Forskerne diskuterede deres arbejde i deres papir offentliggjort i mandags. "Light Commands:Laser-Based Audio Injection Attacks on Voice-Controllable Systems" er af fem forfattere med tilknytning fra University of Michigan (fire) og fra University of Electro-Communications, Japan (en).

"I vores avis, " de sagde, "Vi demonstrerer denne effekt, med succes at bruge lys til at injicere ondsindede kommandoer i flere stemmestyrede enheder, såsom smarthøjttalere, tabletter, og telefoner over store afstande og gennem glasvinduer."

Hvor let var det at udføre?

For at forhindre autentificering, ret nemt.

"Stemmestyrede systemer kræver ofte ikke, at brugerne godkender sig selv, " skrev Ars Technica er Dan Goodin. Angrebet i disse tilfælde kunne ofte udføres uden behov for adgangskoder eller pinkoder. Ofte. "Selv når systemerne kræver godkendelse for visse handlinger, " han tilføjede, "det kan være muligt at brute force pinkoden, da mange enheder ikke begrænser antallet af gæt en bruger kan foretage."

Også, angrebet var ikke dyrt at udføre. Lyskommandoer kan monteres billigt, sagde en videovært, ved hjælp af almindelige laserpointere. Dette kunne endda gøres mellem to bygninger.

Holdet sagde, at de prøvede deres angreb på populære stemmegenkendelsessystemer, nemlig Amazon Alexa, Apple Siri, Facebook portal, og Google Assistant. Rent faktisk, selvom, "ethvert system, der bruger MEMS-mikrofoner og handler på disse data uden yderligere brugerbekræftelse, kan være sårbart, " ifølge deres egen lyskommandoside.

Hvad er faren med lyskommandoer?

Alexa, hvordan er vejret? Det er harmløst. Angriberen kan styre smart-home switches. Åbn smarte garageporte. Fjernstart af køretøjer. Faktisk, du kan se en video med "OK Google, åbne garageporten" til et Google Home blot ved at lyse med en billig lasermarkør.

Hvad kan man gøre for at beskytte sig mod sårbarheden? Videopræsentanten sagde, at den grundlæggende sårbarhed ikke kan løses uden dyrt mikrofon-redesign.

"Vi samarbejder med Amazon, Google, Æble, såvel som andre leverandører om defensive foranstaltninger." De har mere information og demonstrationer på lightcommands.com.

"Et ekstra lag af autentificering kan være effektivt til at afbøde angrebet noget. Alternativt, i tilfælde af at angriberen ikke kan aflytte enhedens svar, at lade enheden stille brugeren et simpelt tilfældigt spørgsmål før kommandoudførelse kan være en effektiv måde at forhindre angriberen i at opnå en vellykket kommandoudførelse.

"Producenter kan også forsøge at bruge sensorfusionsteknikker, såsom at hente lyd fra flere mikrofoner. Når angriberen bruger en enkelt laser, kun en enkelt mikrofon modtager et signal, mens de andre intet modtager...

En anden tilgang består i at reducere mængden af lys, der når mikrofonens membran ved hjælp af en barriere, der fysisk blokerer lige lysstråler for at eliminere synslinjen til membranen, eller implementer et ikke-gennemsigtigt dæksel på toppen af mikrofonhullet for at dæmpe mængden af lys, der rammer mikrofonen. Imidlertid, vi bemærker, at sådanne fysiske barrierer kun er effektive til et vist punkt, da en angriber altid kan øge lasereffekten i et forsøg på at kompensere for den dækningsfremkaldte dæmpning eller for at brænde gennem barriererne, skabe en ny lysvej."

Ovenstående dukkede op på deres lyskommandoside, mens papiret også diskuterede afbødende tilgange og begrænsninger.

I mellemtiden Mariella Moon ind Engadget mindede sine læsere om, at det ikke ville være første gang, forskere fandt sårbarheder i digitale assistenter. "Forskere fra Kinas Zheijiang Universitet fandt ud af, at Siri, Alexa og andre stemmeassistenter kan manipuleres med kommandoer sendt i ultralydsfrekvenser."

© 2019 Science X Network

Varme artikler

Varme artikler

-

Forklarer:Ikke alle cybertrusler er lige bekymrendeDenne lørdag, 7. okt. 2017, filbillede viser et valgsted ved Southside Elementary i Huntington, W.Va. State valgembedsmænd i mindst to dusin stater, herunder West Virginia, har set mistænkelig cyberak

Forklarer:Ikke alle cybertrusler er lige bekymrendeDenne lørdag, 7. okt. 2017, filbillede viser et valgsted ved Southside Elementary i Huntington, W.Va. State valgembedsmænd i mindst to dusin stater, herunder West Virginia, har set mistænkelig cyberak -

Ny metode gør ethvert 3D-objekt til en kubisk stilDataloger fra University of Toronto har udviklet en beregningsmetode til at kvantificere en abstrakt kubisk stil. Forskerne, Hsueh-Ti Derek Liu og Alec Jacobson fra University of Toronto, skal præsent

Ny metode gør ethvert 3D-objekt til en kubisk stilDataloger fra University of Toronto har udviklet en beregningsmetode til at kvantificere en abstrakt kubisk stil. Forskerne, Hsueh-Ti Derek Liu og Alec Jacobson fra University of Toronto, skal præsent -

Ny teknologi vil markant forbedre energihøsten fra PV-modulerOptiverter, foto af Dmitri Vinnikov. Kredit:Dmitri Vinnikov Verden bevæger sig uundgåeligt i retning af en mere bæredygtig livsstil. Bæredygtighed af miljøet kræver ændringer i den nuværende livss

Ny teknologi vil markant forbedre energihøsten fra PV-modulerOptiverter, foto af Dmitri Vinnikov. Kredit:Dmitri Vinnikov Verden bevæger sig uundgåeligt i retning af en mere bæredygtig livsstil. Bæredygtighed af miljøet kræver ændringer i den nuværende livss -

Satellitbilleder revolutionerer verden. Men skal vi altid stole på det, vi ser?Havisen ud for Østantarktis Prinsesse Astrid-kyst. Kredit:NASA I 1972, besætningen på Apollo 17 fangede det, der er blevet et af de mest ikoniske billeder af Jorden:den blå marmor. Biokemiker Greg

Satellitbilleder revolutionerer verden. Men skal vi altid stole på det, vi ser?Havisen ud for Østantarktis Prinsesse Astrid-kyst. Kredit:NASA I 1972, besætningen på Apollo 17 fangede det, der er blevet et af de mest ikoniske billeder af Jorden:den blå marmor. Biokemiker Greg

- Langdistancefiberforbindelse klar til at skabe kraftfulde netværk af optiske ure

- Billede:Supersonisk faldskærmstest

- The mind of God:topcitater fra Stephen Hawking

- Kan hvide dværge hjælpe med at løse det kosmologiske lithiumproblem?

- En astronautguide til produktion uden for jorden

- Fjerndetektion af vira på overflader