AVID:en ramme til at forbedre imitation læring i robotter

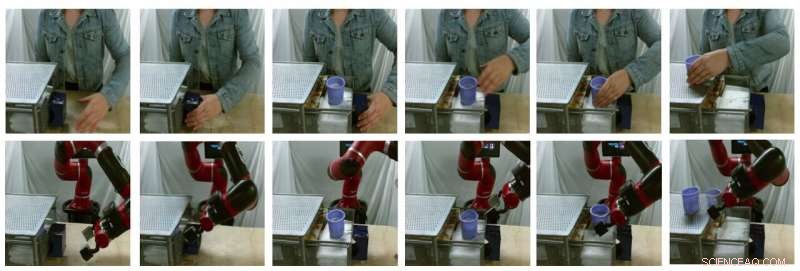

Prøvebilleder af modelgenererede oversættelser (øverste række er ægte menneskelige billeder, nederste række er falske robotbilleder). Kredit:Smith et al.

I de seneste år, forskerhold verden over har brugt forstærkningslæring (RL) til at lære robotter at udføre en række opgaver. Træning af disse algoritmer, imidlertid, kan være meget udfordrende, da det også kræver en betydelig menneskelig indsats for korrekt at definere de opgaver, robotten skal udføre.

En måde at lære robotter at udføre specifikke opgaver på er gennem demonstrationer af mennesker. Selvom dette kan virke ligetil, det kan være meget svært at implementere, hovedsagelig fordi robotter og mennesker har meget forskellige kroppe, dermed er de i stand til forskellige bevægelser.

Forskere ved University of California Berkeley har for nylig udviklet en ny ramme, der kan hjælpe med at overvinde nogle af de udfordringer, man møder, når man træner robotter via imitation læring (dvs. ved hjælp af menneskelige demonstrationer). Deres rammer, kaldet AVID, in baseret på to deep-learning-modeller udviklet i tidligere forskning.

"Når du udvikler AVID, vi byggede stort set på to nylige værker, CycleGAN og SOLAR, som introducerede tilgange til håndtering af grundlæggende begrænsninger, der har forhindret læring fra menneskelige videoer i domæneskift og træning på en fysisk robot fra visuel input, henholdsvis, "Laura Smith, en af forskerne, der gennemførte undersøgelsen, fortalte TechXplore.

I stedet for at bruge teknikker, der ikke tager højde for forskellene mellem en robot og en menneskelig brugers krop, Smith og hendes kolleger brugte Cycle-GAN, en teknik, der kan transformere billeder på et pixelniveau. Brug af Cycle-GAN, deres metode konverterer menneskelige demonstrationer af, hvordan man udfører en given opgave til videoer af en robot, der udfører den samme opgave. De brugte derefter disse videoer til at udvikle en belønningsfunktion for en RL -algoritme.

Prøvebilleder af modelgenererede oversættelser (øverste række er ægte menneskelige billeder, nederste række er falske robotbilleder). Kredit:Smith et al.

"AVID fungerer ved at lade robotten observere et menneske udføre en opgave, og forestil dig hvordan det ville se ud for sig selv at udføre det samme, "Forklarede Smith." For at lære, hvordan man faktisk opnår denne forestillede succes, vi lader robotten lære ved forsøg og fejl. "

Ved hjælp af de rammer udviklet af Smith og hendes kolleger, en robot lærer opgaver et trin ad gangen, nulstille hvert trin og prøve det igen uden at kræve en menneskelig brugers indgriben. Læringsprocessen bliver dermed stort set automatiseret, hvor robotten lærer nye færdigheder med minimal menneskelig indgriben.

"En vigtig fordel ved vores tilgang er, at den menneskelige lærer kan interagere med robotstuderende, mens den lærer, "Smith forklarede." Desuden vi designer vores træningsrammer, så de kan lære langsigtet adfærd med minimal indsats. "

Forskerne evaluerede deres tilgang i en række forsøg og fandt ud af, at det effektivt kan lære robotter at udføre komplekse opgaver, såsom betjening af en kaffemaskine, simpelthen ved at behandle 20 minutters rå menneskelige demonstrationsvideoer og øve den nye færdighed i 180 minutter. Ud over, AVID overgik alle andre teknikker, som det var, herunder imitation ablation, pixel-space ablation, og adfærdsmæssige kloningstilgange.

"Det, vi fandt ud af, er, at vi kan udnytte CycleGAN til effektivt at gøre videoer af menneskelige demonstrationer forståelige for robotten uden at kræve en kedelig dataindsamlingsproces, "Smith sagde." Vi viser også, at udnyttelse af flerfasede karakterer af tidsmæssigt udvidede opgaver giver os mulighed for at lære robust adfærd, samtidig med at træning er let. Vi ser vores arbejde som et meningsfuldt skridt mod at bringe den virkelige implementering af autonome robotter inden for rækkevidde, da det giver os en meget naturlig, intuitiv måde for os at lære dem på. "

De nye læringsrammer introduceret af Smith og hendes kolleger muliggør en anden form for efterligningslæring, hvor en robot lærer at fuldføre et mål på et højere niveau ad gangen, med fokus på, hvad det finder mest udfordrende i hvert trin. I øvrigt, i stedet for at kræve, at menneskelige brugere nulstiller scenen efter hvert øvelsesforsøg, det giver robotter mulighed for automatisk at nulstille scenen og fortsætte med at øve. I fremtiden, AVID kan forbedre efterligningsprocesser, giver udviklere mulighed for at træne robotter hurtigere og mere effektivt.

"En af de største begrænsninger i vores arbejde hidtil er, at vi kræver dataindsamling og træning af CycleGAN for hver ny scene, robotten kan støde på. Vi håber at kunne behandle CycleGAN-træningen som en engang, på forhånd omkostninger, så træning en gang i et stort korpus data kan give robotten meget hurtigt mulighed for at opfange en meget bred vifte af færdigheder med et par demonstrationer og lidt øvelse. "

© 2020 Science X Network

Varme artikler

Varme artikler

-

Medarbejdere hos Big Tech udtaler sig som aldrig førI denne 1. nov. 2018, fil foto, Google -medarbejdere holder skilte op under et walkout -møde på Harry Bridges Plaza i San Francisco for at protestere mod, hvad de siger er teknologiselskabets forkert

Medarbejdere hos Big Tech udtaler sig som aldrig førI denne 1. nov. 2018, fil foto, Google -medarbejdere holder skilte op under et walkout -møde på Harry Bridges Plaza i San Francisco for at protestere mod, hvad de siger er teknologiselskabets forkert -

Team lokaliserer næsten alle amerikanske solpaneler i en milliard billeder med maskinlæringDet interaktive kort over USA på DeepSolars hjemmeside. Kredit:DeepSolar/Stanford University At vide, hvilke amerikanere der har installeret solpaneler på deres tage, og hvorfor de gjorde det, vil

Team lokaliserer næsten alle amerikanske solpaneler i en milliard billeder med maskinlæringDet interaktive kort over USA på DeepSolars hjemmeside. Kredit:DeepSolar/Stanford University At vide, hvilke amerikanere der har installeret solpaneler på deres tage, og hvorfor de gjorde det, vil -

Ingeniør udvikler browserbaseret analyserammeobservatorProfessor Wei Meng. Kredit:The Chinese University of Hong Kong Ondsindede tredjepartsannoncører eller hackere udsætter webbrugere for en sikkerhedstrussel ved at injicere ondsindet JavaScript-kode

Ingeniør udvikler browserbaseret analyserammeobservatorProfessor Wei Meng. Kredit:The Chinese University of Hong Kong Ondsindede tredjepartsannoncører eller hackere udsætter webbrugere for en sikkerhedstrussel ved at injicere ondsindet JavaScript-kode -

Fransk forsker hacker sig ind i Moskvas nye e-afstemningssystemDen franske forsker sagde, at en hacker kun ville have haft brug for 10 minutter for at knække koden En fransk forsker har afsløret et sikkerhedsbrud i et elektronisk afstemningssystem, der skal b

Fransk forsker hacker sig ind i Moskvas nye e-afstemningssystemDen franske forsker sagde, at en hacker kun ville have haft brug for 10 minutter for at knække koden En fransk forsker har afsløret et sikkerhedsbrud i et elektronisk afstemningssystem, der skal b