Hvorfor dybe netværk generaliserer på trods af at de går imod statistisk intuition

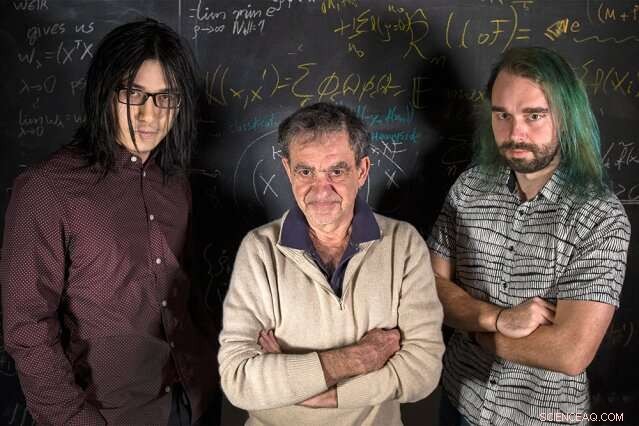

MIT-forskere (fra venstre mod højre) Qianli Liao, Tomaso Poggio, og Andrzej Banburski står med deres ligninger. Kredit:Kris Brewer

Indledende statistikkurser lærer os, at når man tilpasser en model til nogle data, vi bør have flere data end ledige parametre for at undgå faren for overtilpasning – at tilpasse støjende data for tæt, og derved ikke passer til nye data. Det er overraskende, derefter, at i moderne deep learning er praksis at have størrelsesordener flere parametre end data. På trods af dette, dybe netværk viser god prædiktiv ydeevne, og faktisk gøre det bedre, jo flere parametre de har. Hvorfor skulle det være det?

Det har været kendt i nogen tid, at god ydeevne inden for maskinlæring kommer af at kontrollere kompleksiteten af netværk, hvilket ikke kun er en simpel funktion af antallet af ledige parametre. Kompleksiteten af en klassifikator, såsom et neuralt netværk, afhænger af at måle "størrelsen" af det rum af funktioner, som dette netværk repræsenterer, med flere tekniske foranstaltninger tidligere foreslået:Vapnik-Chervonenkis dimension, dækkende tal, eller Rademacher kompleksitet, for at nævne et par stykker. kompleksitet, målt ved disse begreber, kan kontrolleres under læringsprocessen ved at pålægge normen for parametrene en begrænsning – kort sagt, på hvor "store" de kan blive. Den overraskende kendsgerning er, at der tilsyneladende ikke er behov for en sådan eksplicit begrænsning for at træne dybe netværk. Ligger deep learning uden for den klassiske læringsteori? Skal vi gentænke grundlaget?

I et nyt Nature Communications papir, "Kompleksitetskontrol ved gradientnedstigning i dybe netværk, "et hold fra Center for Hjerner, Sind, og maskiner ledet af direktør Tomaso Poggio, Eugene McDermott professor i MIT Department of Brain and Cognitive Sciences, har kastet lidt lys over dette puslespil ved at tage fat på de mest praktiske og vellykkede anvendelser af moderne deep learning:klassifikationsproblemer.

"For klassificeringsproblemer, vi observerer, at modellens parametre faktisk ikke ser ud til at konvergere, men vokser snarere i størrelse på ubestemt tid under gradientnedstigning. Imidlertid, i klassifikationsproblemer er det kun de normaliserede parametre, der betyder noget - dvs. den retning, de definerer, ikke deres størrelse, " siger medforfatter og MIT Ph.D.-kandidat Qianli Liao. "Det ikke så indlysende, vi viste, er, at den almindeligt anvendte gradientnedstigning på de unormaliserede parametre inducerer den ønskede kompleksitetskontrol på de normaliserede."

"Vi har i nogen tid vidst i tilfælde af regression for lavvandede lineære netværk, såsom kernemaskiner, at iterationer af gradientnedstigning giver en implicit, forsvindende regulariseringseffekt, " siger Poggio. "Faktisk, i dette simple tilfælde ved vi sandsynligvis, at vi får den bedst opførte maksimale margen, minimumsnorm løsning. Det spørgsmål, vi stillede os selv, derefter, var:Kan noget lignende ske for dybe netværk?"

Forskerne fandt ud af, at det gør det. Som medforfatter og MIT postdoc Andrzej Banburski forklarer, "Forståelse af konvergens i dybe netværk viser, at der er klare retninger for at forbedre vores algoritmer. Faktisk, vi har allerede set hints om, at kontrol med hastigheden, hvormed disse unormaliserede parametre divergerer, giver os mulighed for at finde bedre ydende løsninger og finde dem hurtigere."

Hvad betyder det for maskinlæring? Der er ingen magi bag dybe netværk. Den samme teori bag alle lineære modeller er også på spil her. Dette arbejde foreslår måder at forbedre dybe netværk, gør dem mere præcise og hurtigere at træne.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Vodafone skærer udbytte efter stort årligt tabEuropas største mobiltelefonselskab Vodafone har reduceret sin aktionærdeling efter et stort årligt nettotab Den britiske telekomgigant Vodafone meddelte tirsdag, at den registrerede et enormt årl

Vodafone skærer udbytte efter stort årligt tabEuropas største mobiltelefonselskab Vodafone har reduceret sin aktionærdeling efter et stort årligt nettotab Den britiske telekomgigant Vodafone meddelte tirsdag, at den registrerede et enormt årl -

Brint bil prototypeKredit:Asociación RUVID Forskere ved Institut for Kemisk Teknologi og samarbejdspartnere har med succes udviklet og testet en skalabilprototype, der opbevarer og genererer brint sikkert og er i st

Brint bil prototypeKredit:Asociación RUVID Forskere ved Institut for Kemisk Teknologi og samarbejdspartnere har med succes udviklet og testet en skalabilprototype, der opbevarer og genererer brint sikkert og er i st -

Elektricitets fortid og fremtid i AmerikaKredit:CC0 Public Domain Mens amerikanerne integrerer vedvarende energiressourcer i landets strømforsyning, et nyt forskningsoplæg fra Baker Institute for Public Policy gennemgår, hvordan landets

Elektricitets fortid og fremtid i AmerikaKredit:CC0 Public Domain Mens amerikanerne integrerer vedvarende energiressourcer i landets strømforsyning, et nyt forskningsoplæg fra Baker Institute for Public Policy gennemgår, hvordan landets -

Brug af kunstig intelligens til at spotte årsagssammenhænge i overlappende medicinske datasætKredit:CC0 Public Domain Et kombineret team af forskere fra Babylon Health and University College har skabt en algoritme, som de hævder kan finde årsagssammenhænge mellem information i overlappend

Brug af kunstig intelligens til at spotte årsagssammenhænge i overlappende medicinske datasætKredit:CC0 Public Domain Et kombineret team af forskere fra Babylon Health and University College har skabt en algoritme, som de hævder kan finde årsagssammenhænge mellem information i overlappend

- USA roser tyske 5G-standarder, mens Huawei-kampen ulmer

- Sky lysende, solskærme for at redde Barrier Reef

- Billede:Solen i 2020

- Verdens anden EPR-atomreaktor begynder at arbejde i Kina

- Working Models of Science Projects

- Neutronundersøgelse af glaukomlægemidler giver fingerpeg om enzymmål for aggressive kræftformer