Lær at bryde dyb perceptuel hashing

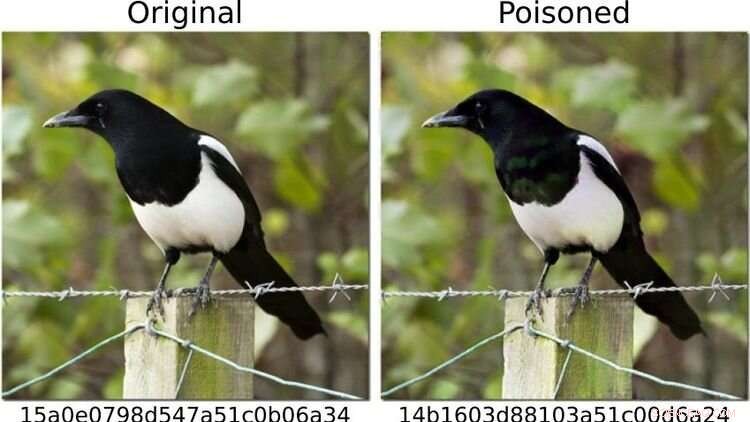

For at sætte systemet på prøve, definerede forskerne billeder af hunde som "farlige" og ændrede andre fotomotiver - som f.eks. skaften vist til venstre - så (som til højre) dens fingeraftryk svarede til en hundebillede. For det menneskelige øje ser begge billeder identiske ud. Kredit:https://arxiv.org/abs/2111.06628

Kan kunstig intelligens (AI) metoder pålideligt registrere børnepornografiske billeder på slutenheder?

En undersøgelse, hvor Oldenburg-datalogen Daniel Neider var involveret, rejser tvivl om, hvorvidt dette er muligt i øjeblikket. Forskningen blev offentliggjort i Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency .

Her diskuterer Neider sine resultater:

Hr. Neider, har du en virusscanner på din computer?

Jeg tror, at alle Windows-computere leveres med et antivirusprogram – så ja.

Apple installerede sit NeuralHash-program, som automatisk scanner billedfiler for børnepornografi, på slutenheder sidste år. Fungerer det på samme måde som et antivirusprogram?

NeuralHash gør noget lignende, selvom måden det fungerer på er anderledes:Softwaren scanner slutenheder for en bestemt type indhold – ikke, som med antivirusprogrammer, for malware, men for ulovlige billeder. Dette er kendt som klientsidescanning, som refererer til scanning af filer på brugerens enhed.

Hvordan virker NeuralHash præcist?

Programmet er baseret på kunstig intelligens metoder og bruger såkaldte neurale netværk. Kort sagt er det et computerprogram, der er trænet til at genkende bestemte mønstre i billeder. Programmet tildeler en slags kode til hvert billede, i bund og grund en sekvens af tal og bogstaver. Disse koder kaldes hashes. Du kan forestille dig dem som fingeraftryk, der genereres for hvert billede. Tricket er, at billeder, der ligner hinanden, tildeles den samme hash - så for eksempel kan alle billeder med sorte katte tildeles hashen 3x580ac97e. Apple har en stor database med sådanne hashes, som kan tildeles børnepornografiske billeder. Og hver gang en bruger forsøger at uploade et billede med en hash, der er i databasen, markeres billedet, uden at brugeren bemærker det. Sådanne billeder kan ikke videresendes.

Betyder det, at Apple ved, hvilke billeder der er på min mobiltelefon?

Nej, Apple ser ikke på billederne. Den har kun databasen med koderne. Tanken er, at virksomheden arbejder sammen med børnebeskyttelsesorganisationer. Og på grundlag af materiale, der kommer fra retshåndhævende myndigheder, bruger disse organisationer et program til at generere hash til databasen.

Du analyserede NeuralHash i et forskningsprojekt med kolleger fra det tekniske universitet i Darmstadt. Hvordan opstod projektet?

Neurale netværk fungerer ikke altid, som vi tror, de gør. Teknologien er meget lovende, men den er ikke altid hundrede procent nøjagtig. Det er ofte svært at finde ud af, hvorfor det giver et bestemt resultat, fordi proceduren ikke er eksplicit programmeret. I princippet har denne teknologi simpelthen lært at genkende bestemte mønstre i dataene. Dette kan dog også udnyttes til at snyde programmet - og det virker med alarmerende frekvens. Så vi spurgte os selv:hvordan påvirker dette et system, der er beregnet til at blive brugt til at vurdere ulovligt indhold? Hvad sker der, hvis du f.eks. ændrer billeder lidt?

Hvorfor fokuserede du på NeuralHash?

I 2021 leverede Apple en prototype af NeuralHash sammen med en operativsystemopdatering til slutenheder - stort set alle enheder, der kan sende billeder til iCloud-skylagertjenesten, som iPhones eller Macs. Prototypen var endnu ikke aktiveret, så programmet begyndte ikke at tjekke billeder på Apple-enhederne. Men dette træk gjorde teknologien tilgængelig for os; vi var i stand til at udtrække programmet og dermed få adgang til det neurale netværk. Vi ville gerne se på, hvordan en stor virksomhed ville løse sådan en opgave. Apple afstod senere fra officielt at udrulle NeuralHash på grund af massiv kritik af den masseovervågning og krænkelse af privatlivets fred, det indebar.

Hvad testede du helt præcist?

Vi testede, hvordan systemet kunne misbruges. For at undgå at skulle arbejde med børnepornografisk materiale, definerede vi billeder af hunde som "farlige". Så har vi beregnet deres "digitale fingeraftryk". I det første scenarie tog vi billeder af andre ting, for eksempel af en kat, og forsøgte at ændre dem lidt, så resultatet blev et "fingeraftryk" af en hund.

Fungerede det?

Ja, og det viste sig at være relativt nemt. Du har brug for adgang til det neurale netværk – som vi havde, fordi programmet blev installeret på enhederne – og du har brug for noget viden om, hvordan maskinlæring fungerer. Men så er det ret nemt at ændre kattebillederne, så de genererer enhver anden hash. For det menneskelige øje ligner de manipulerede billeder næsten originalen, man kan ikke rigtig kende forskel.

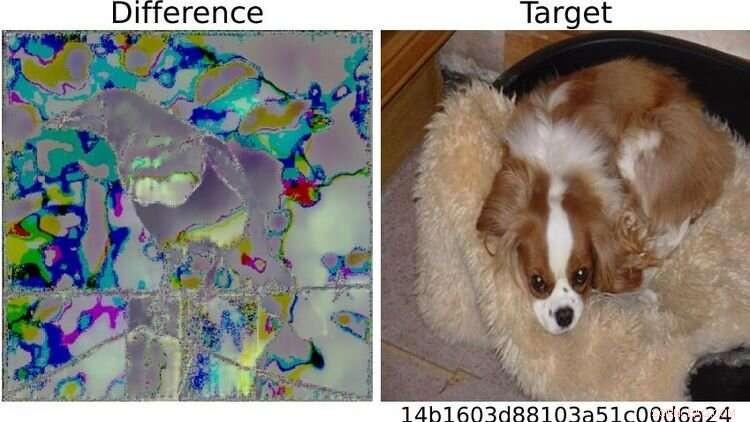

Til højre er hundebilledet defineret som "farligt" på testbasis. På grund af de synlige forskelle mellem de to skatebilleder til venstre, slog systemet alarm for billedet, der var blevet ændret på denne måde. Enhver, der er bekendt med machine learning, kunne således "relativt nemt" spille systemet et puds, siger Neider. Kredit:https://arxiv.org/abs/2111.06628

Og det er, når tingene bliver problematiske...

Ret. Fordi jeg kunne sende dig et manipuleret billede, og i det øjeblik du prøver at uploade det til din sky eller sende det til en anden via en besked-app, udløses systemet, uden at du bemærker det. Du ved ikke engang, hvorfor upload- eller videresendelsesfunktionen er blokeret. Men det virkelige problem er, at Apple også bemærker, at du har forsøgt at sende et mistænkeligt billede. Og hvis dette sker for ofte, dekrypterer Apple materialet og, hvis det skønnes nødvendigt, rapporterer det til de lokale retshåndhævende myndigheder. Det betyder, at der kunne plantes materiale på nogen for at inkriminere dem.

Hvad har du ellers testet?

Vi stillede også det modsatte spørgsmål:kan jeg omgå systemet? Kan jeg manipulere et billede med et fingeraftryk i databasen på en sådan måde, at det genererer et andet fingeraftryk? I et scenarie antog vi igen, at brugeren har adgang til AI via deres enhed, er fortrolig med det neurale netværk og har en vis viden om maskinlæring.

Og kan billederne manipuleres for at få dem til at se mistænkelige ud?

Ja, det fungerer meget godt. Men hvad vi også opdagede er, at selvom man ikke har adgang til systemet og laver meget simple ændringer på et billede, som alle kan lave med sin mobiltelefon, så er det muligt at snyde programmet. For eksempel kan du blot ved at rotere et billede 90 grader ændre "fingeraftrykket" væsentligt. Dette er selvfølgelig ikke godt, for du kan fortryde denne ændring blot ved at dreje billedet 90 grader i den anden retning. Hele informationen på billedet bevares. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. + Udforsk yderligere

Apple can scan your photos for child abuse and still protect your privacy

Varme artikler

Varme artikler

-

Forsker i at udvikle køretøjskommunikation til multimodale mobilitetsløsningerNTU og NXP demonstrerede nye anvendelser af sikkerhedsadvarselssystemer ved hjælp af V2X, sådan advare bilen bagved, da bilen foran bakker. Kredit:NTU Singapore Nanyang Teknologiske Universitet, S

Forsker i at udvikle køretøjskommunikation til multimodale mobilitetsløsningerNTU og NXP demonstrerede nye anvendelser af sikkerhedsadvarselssystemer ved hjælp af V2X, sådan advare bilen bagved, da bilen foran bakker. Kredit:NTU Singapore Nanyang Teknologiske Universitet, S -

Fem ting at vide om VWs dieselgate-skandalevirksomheden indrømmede, at omkring 11 millioner dieselkøretøjer verden over, inklusive 8,5 millioner i Europa, og 600, 000 i USA, var blevet udstyret med ulovlige nederlagsanordninger Volkswagens

Fem ting at vide om VWs dieselgate-skandalevirksomheden indrømmede, at omkring 11 millioner dieselkøretøjer verden over, inklusive 8,5 millioner i Europa, og 600, 000 i USA, var blevet udstyret med ulovlige nederlagsanordninger Volkswagens -

Er AI en særlig ingrediens, der hjælper med at få mad til at smage bedre? Det mener IBM og McCorm…Kredit:CC0 Public Domain Jo da, vi er vant til, at kunstige smagsstoffer påvirker, hvordan vores mad smager, men kunstig intelligens bliver bagt i nu? Brugen af kunstig intelligens kan måske gi

Er AI en særlig ingrediens, der hjælper med at få mad til at smage bedre? Det mener IBM og McCorm…Kredit:CC0 Public Domain Jo da, vi er vant til, at kunstige smagsstoffer påvirker, hvordan vores mad smager, men kunstig intelligens bliver bagt i nu? Brugen af kunstig intelligens kan måske gi -

Twitter forbyder dehumanisering af indlæg over for religiøse grupperDenne 26. april, 2017, filfoto viser Twitter -appen på en mobiltelefon i Philadelphia. Twitter vil nu forbyde hadefulde ytringer, der er målrettet mod religiøse grupper, der bruger dehumaniserende spr

Twitter forbyder dehumanisering af indlæg over for religiøse grupperDenne 26. april, 2017, filfoto viser Twitter -appen på en mobiltelefon i Philadelphia. Twitter vil nu forbyde hadefulde ytringer, der er målrettet mod religiøse grupper, der bruger dehumaniserende spr

- Sådan laver du elektromagneter Repel

- Klem hver dråbe ferskvand fra spildevandslagen

- Etniske stereotypers indvirkning på beskæftigelsen

- Lanthanid nanopartikler muliggør kontinuerlig bølge NIR STED mikroskopi

- Tænders tidskapsel afslører, at for 2 millioner år siden, tidlige mennesker ammet i op til 6 år

- Hvordan lavtlønnede og arbejdsløse mangler en tilstrækkelig indkomst til et sundt liv