AI-billedgenerering skrider frem med astronomiske hastigheder. Kan vi stadig se, om et billede er falsk?

Kredit:Brendan Murphy, Forfatter leveret

Falsk fotografering er ikke noget nyt. I 1910'erne blev den britiske forfatter Arthur Conan Doyle berømt bedraget af to skolesøstre, der havde fremstillet fotografier af elegante feer, der snurrede i deres have.

Det første af de fem 'Cottingley Fairies'-fotografier, taget af Elsie Wright i 1917. Kredit:Wikipedia

I dag er det svært at tro, at disse billeder kunne have narret nogen, men det var først i 1980'erne, at en ekspert ved navn Geoffrey Crawley havde mod til direkte at anvende sin viden om filmfotografering og udlede det åbenlyse.

Fotografierne var falske, som senere indrømmet af en af søstrene selv.

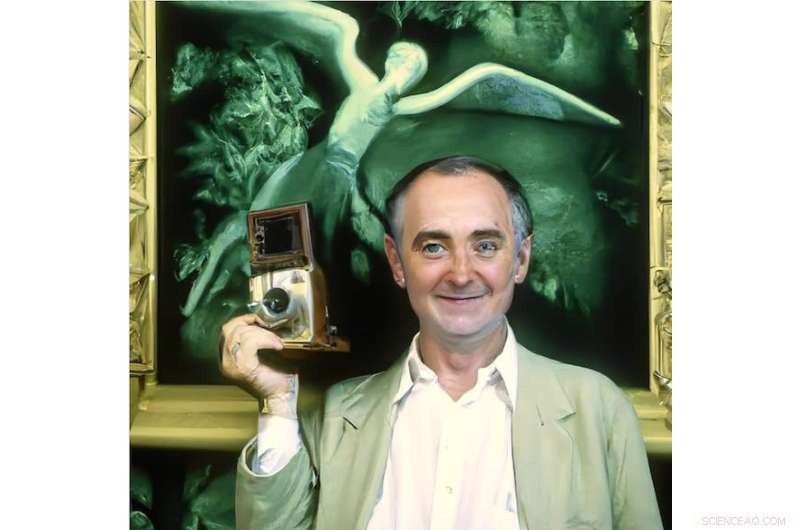

I 1982 udledte Geoffrey Crawley, at fe-fotografierne var falske. Det er denne også. Kredit:Brendan Murphy, Forfatter leveret

Jagt efter artefakter og sund fornuft

Digital fotografering har åbnet et væld af teknikker for både fakere og detektiver.

Retsmedicinsk undersøgelse af mistænkelige billeder i dag involverer jagt efter kvaliteter, der er iboende til digital fotografering, såsom at undersøge metadata indlejret i billederne, bruge software såsom Adobe Photoshop til at korrigere forvrængninger i billeder og søge efter tydelige tegn på manipulation, såsom områder, der duplikeres til obskure originale træk.

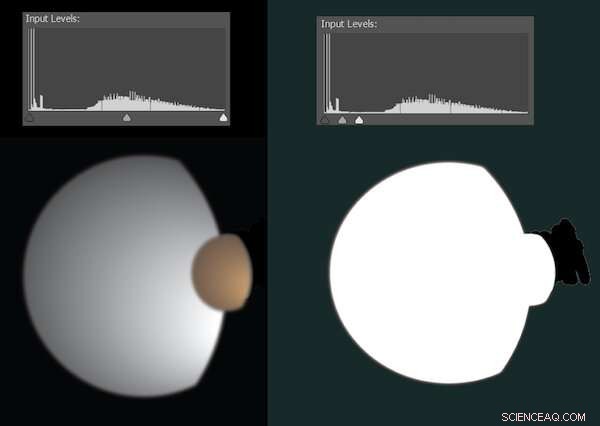

Nogle gange er digitale redigeringer for subtile til at opdage, men springer til syne, når vi justerer den måde, lyse og mørke pixels fordeles på. For eksempel frigav NASA i 2010 et foto af Saturns måner Dione og Titan. Det var på ingen måde falsk, men var blevet ryddet op for at fjerne vildfarne artefakter - hvilket fik konspirationsteoretikeres opmærksomhed.

Nysgerrig satte jeg billedet ind i Photoshop. Illustrationen nedenfor genskaber nogenlunde, hvordan dette så ud.

En simulering, der viser, hvordan redigering kan detekteres, når niveauet af lys og mørke justeres. Kredit:Brendan Murphy, Forfatter leveret

De fleste digitale fotografier er i komprimerede formater som f.eks. JPEG, slanket ved at fjerne meget af den information, kameraet fanger. Standardiserede algoritmer sikrer, at den fjernede information har minimal synlig indvirkning – men den efterlader spor.

Komprimeringen af et hvilket som helst område af et billede vil afhænge af, hvad der foregår i billedet og de aktuelle kameraindstillinger; når et falsk billede kombinerer flere kilder, er det ofte muligt at opdage dette ved omhyggelig analyse af kompressionsartefakter.

Nogle retsmedicinske metoder har lidt at gøre med formatet af et billede, men er i det væsentlige visuelt detektivarbejde. Er alle på billedet oplyst på samme måde? Giver skygger og refleksioner mening? Viser ører og hænder lys og skygge de rigtige steder? Hvad afspejles i folks øjne? Ville alle linjer og vinkler i rummet hænge sammen, hvis vi modellerede scenen i 3D?

Arthur Conan Doyle er måske blevet narret af fefotos, men jeg tror, at hans kreation Sherlock Holmes ville være hjemme i verden af retsmedicinske fotoanalyser.

En ny æra med kunstig intelligens

Den nuværende eksplosion af billeder skabt af tekst-til-billede kunstig intelligens (AI) værktøjer er på mange måder mere radikal end skiftet fra film til digital fotografering.

Vi kan nu fremtrylle ethvert billede, vi ønsker, bare ved at skrive. Disse billeder er ikke frankenfotos, der er lavet ved at samle allerede eksisterende pixelklumper. Det er helt nye billeder med det angivne indhold, kvalitet og stil.

Indtil for nylig har de komplekse neurale netværk, der blev brugt til at generere disse billeder, haft begrænset tilgængelighed for offentligheden. Dette ændrede sig den 23. august 2022 med frigivelsen til offentligheden af open-source Stable Diffusion. Nu kan alle med et Nvidia-grafikkort på spilniveau i deres computer skabe AI-billedindhold uden noget forskningslaboratorium eller virksomheds gatekeeping deres aktiviteter.

Dette har fået mange til at spørge, "kan vi nogensinde tro, hvad vi ser online igen?" Det kommer an på.

Tekst-til-billede AI får sin viden fra træning - analysen af et stort antal billede/tekst-par. Styrkerne og svaghederne ved hvert system er delvist afledt af, hvilke billeder det er blevet trænet på. Her er et eksempel:sådan ser Stable Diffusion George Clooney stryge.

Det er George Clooney, der stryger... eller er det? Kredit:Brendan Murphy, Forfatter leveret

Dette er langt fra realistisk. Det eneste, Stable Diffusion skal fortsætte med, er den information, den har lært, og selvom det er tydeligt, at den har set George Clooney og kan knytte den række af bogstaver til skuespillerens træk, er den ikke en Clooney-ekspert.

Den ville dog have set og fordøjet mange flere billeder af midaldrende mænd generelt, så lad os se, hvad der sker, når vi beder om en generisk midaldrende mand i samme scenarie.

Generisk midaldrende mand, der stryger. Kredit:Brendan Murphy, Forfatter leveret

Dette er en klar forbedring, men stadig ikke helt realistisk. Som det altid har været tilfældet, er hænders og ørers vanskelige geometri gode steder at lede efter tegn på falskneri – selvom vi i dette medie ser på den rumlige geometri snarere end fortællingerne om umulig belysning.

Der kan være andre spor. Hvis vi omhyggeligt rekonstruerede rummet, ville hjørnerne så være firkantede? Ville hylderne give mening? En retsmedicinsk ekspert, der er vant til at undersøge digitale fotografier, kunne sandsynligvis ringe til det.

Vi kan ikke længere tro vores øjne

Hvis vi udvider et tekst-til-billede-systems viden, kan det gøre det endnu bedre. Du kan tilføje dine egne beskrevne fotografier som supplement til eksisterende træning. Denne proces er kendt som tekstinversion.

For nylig har Google udgivet Dream Booth, en alternativ, mere sofistikeret metode til at injicere specifikke mennesker, objekter eller endda kunststile i tekst-til-billede AI-systemer.

Denne proces kræver kraftig hardware, men resultaterne er svimlende. Noget godt arbejde er begyndt at blive delt på Reddit. Se på billederne i indlægget nedenfor, der viser billeder sat i DreamBooth og realistiske falske billeder fra Stable Diffusion.

Vi kan ikke længere tro vores egne øjne, men vi kan stadig være i stand til at stole på retsmedicinske eksperters, i det mindste lige nu. Det er fuldt ud muligt, at fremtidige systemer bevidst kan trænes til også at narre dem.

Vi bevæger os hurtigt ind i en æra, hvor perfekt fotografering og endda video vil være almindelig. Tiden vil vise, hvor betydningsfuldt dette vil være, men i mellemtiden er det værd at huske lektien fra Cottingley Fairy-billederne - nogle gange vil folk bare tro, selv på åbenlyse forfalskninger.

Sidste artikelEr virtuelle private netværk faktisk private?

Næste artikelHøjovnsgasforbrænding:Et bæredygtigt alternativ til stålindustrien?

Varme artikler

Varme artikler

-

Trump lover at beskytte kinesiske telekommunikationsjob (opdatering)USAs præsident, Donald Trump, siger, at han arbejder sammen med den kinesiske leder, Xi Jinping, for at hjælpe telegiganten ZTE med at blive i gang USAs præsident, Donald Trump, sagde søndag, at h

Trump lover at beskytte kinesiske telekommunikationsjob (opdatering)USAs præsident, Donald Trump, siger, at han arbejder sammen med den kinesiske leder, Xi Jinping, for at hjælpe telegiganten ZTE med at blive i gang USAs præsident, Donald Trump, sagde søndag, at h -

Forenet mod jammere:Forskere udvikler en mere sikker metode til datatransmissionKredit:CC0 Public Domain Mottoet forenede står vi, splittet vi falder har fundet ny anvendelse i en usandsynlig disciplin - cybersikkerhed. Maskiner – fra simple som en personlig computer til en

Forenet mod jammere:Forskere udvikler en mere sikker metode til datatransmissionKredit:CC0 Public Domain Mottoet forenede står vi, splittet vi falder har fundet ny anvendelse i en usandsynlig disciplin - cybersikkerhed. Maskiner – fra simple som en personlig computer til en -

Smart-teknologiske systemer reducerer trængsel for en brøkdel af, hvad nye veje kosterSmarte transportløsninger udnytter eksisterende infrastruktur bedre og mindsker behovet for at bygge dyre nye veje. Kredit:AdobeStock De nye transportprojekter, som regeringerne konstant annoncere

Smart-teknologiske systemer reducerer trængsel for en brøkdel af, hvad nye veje kosterSmarte transportløsninger udnytter eksisterende infrastruktur bedre og mindsker behovet for at bygge dyre nye veje. Kredit:AdobeStock De nye transportprojekter, som regeringerne konstant annoncere -

Hybridafbrydere kan gøre jævnstrøm praktisk i applikationer med høj effektPlasmapotentiale omkring elektriske materialer. Kredit:Georgia Tech Institute for Electronics and Nanotechnology Jævnstrøm (DC) driver lommelygter, smartphones og elbiler, men større strømbrugere

Hybridafbrydere kan gøre jævnstrøm praktisk i applikationer med høj effektPlasmapotentiale omkring elektriske materialer. Kredit:Georgia Tech Institute for Electronics and Nanotechnology Jævnstrøm (DC) driver lommelygter, smartphones og elbiler, men større strømbrugere

- Brandbestandig tropisk skov på randen af forsvinden

- Sådan bruges AC-metoden til Factoring

- Halvdelen af Washingtons kirsebærblomstrer døde efter kold snap

- Sådan fungerer Voynich -manuskriptet

- Der er en grund til Siri, Alexa og AI forestilles som kvindelig – sexisme

- Uber-aktien skal lanceres til $45 per aktie (opdatering)