Når det kommer til AI, kan vi så droppe datasættene?

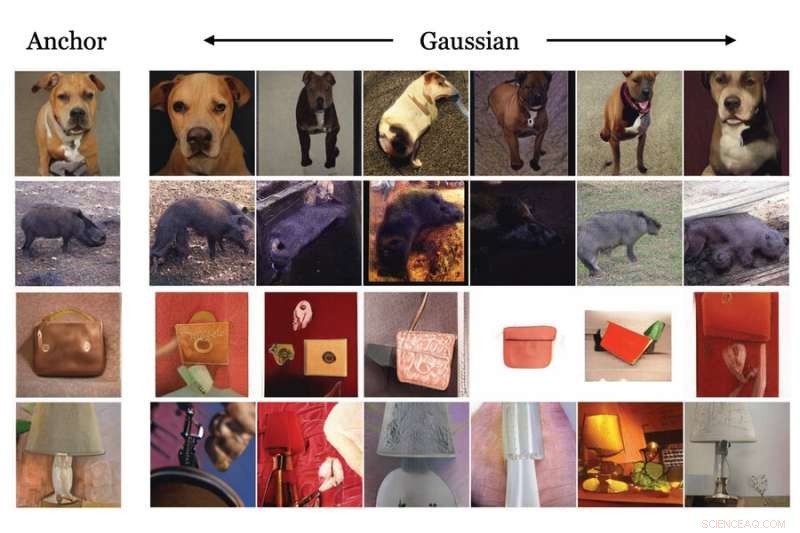

MIT-forskere har demonstreret brugen af en generativ maskinlæringsmodel til at skabe syntetiske data, baseret på reelle data, som kan bruges til at træne en anden model til billedklassificering. Dette billede viser eksempler på den generative models transformationsmetoder. Kredit:Massachusetts Institute of Technology

Enorme mængder data er nødvendige for at træne maskinlæringsmodeller til at udføre billedklassificeringsopgaver, såsom at identificere skader på satellitbilleder efter en naturkatastrofe. Disse data er dog ikke altid nemme at finde. Datasæt kan koste millioner af dollars at generere, hvis brugbare data eksisterer i første omgang, og selv de bedste datasæt indeholder ofte skævheder, der negativt påvirker en models ydeevne.

For at omgå nogle af de problemer, som datasæt præsenterer, udviklede MIT-forskere en metode til træning af en maskinlæringsmodel, der i stedet for at bruge et datasæt bruger en speciel type maskinlæringsmodel til at generere ekstremt realistiske syntetiske data, der kan træne en anden model til downstream vision opgaver.

Deres resultater viser, at en læringsmodel for kontrastiv repræsentation, der er trænet ved kun at bruge disse syntetiske data, er i stand til at lære visuelle repræsentationer, der konkurrerer med eller endda udkonkurrerer dem, der er lært fra rigtige data.

Denne specielle maskinlæringsmodel, kendt som en generativ model, kræver langt mindre hukommelse at gemme eller dele end et datasæt. Brug af syntetiske data har også potentialet til at omgå nogle bekymringer omkring privatliv og brugsrettigheder, der begrænser, hvordan nogle rigtige data kan distribueres. En generativ model kan også redigeres for at fjerne visse attributter, såsom race eller køn, som kunne adressere nogle skævheder, der findes i traditionelle datasæt.

"Vi vidste, at denne metode i sidste ende skulle virke; vi skulle bare vente på, at disse generative modeller blev bedre og bedre. Men vi var især glade, da vi viste, at denne metode nogle gange gør endnu bedre end den ægte vare," siger Ali Jahanian, en forsker i Computer Science and Artificial Intelligence Laboratory (CSAIL) og hovedforfatter af papiret.

Jahanian skrev papiret med CSAIL-studerende Xavier Puig og Yonglong Tian og seniorforfatter Phillip Isola, en assisterende professor i Institut for Elektroteknik og Datalogi. Forskningen vil blive præsenteret på den internationale konference om læringsrepræsentationer.

Generering af syntetiske data

Når først en generativ model er blevet trænet på rigtige data, kan den generere syntetiske data, der er så realistiske, at de næsten ikke kan skelnes fra den ægte vare. Træningsprocessen involverer at vise den generative model millioner af billeder, der indeholder objekter i en bestemt klasse (som biler eller katte), og så lærer den, hvordan en bil eller kat ser ud, så den kan generere lignende objekter.

I det væsentlige ved at dreje på en kontakt kan forskere bruge en forudtrænet generativ model til at udsende en konstant strøm af unikke, realistiske billeder, der er baseret på dem i modellens træningsdatasæt, siger Jahanian.

Men generative modeller er endnu mere nyttige, fordi de lærer at transformere de underliggende data, som de er trænet på, siger han. Hvis modellen trænes på billeder af biler, kan den "forestille sig", hvordan en bil ville se ud i forskellige situationer – situationer, den ikke så under træningen – og derefter udskrive billeder, der viser bilen i unikke positurer, farver eller størrelser.

At have flere visninger af det samme billede er vigtigt for en teknik kaldet kontrastiv læring, hvor en maskinlæringsmodel får vist mange umærkede billeder for at lære, hvilke par der er ens eller forskellige.

Forskerne koblede en fortrænet generativ model til en kontrastiv læringsmodel på en måde, der gjorde det muligt for de to modeller at arbejde sammen automatisk. Den kontrastive elev kunne fortælle den generative model at producere forskellige visninger af et objekt og derefter lære at identificere dette objekt fra flere vinkler, forklarer Jahanian.

"Dette var som at forbinde to byggesten. Fordi den generative model kan give os forskellige syn på det samme, kan den hjælpe den kontrastive metode til at lære bedre repræsentationer," siger han.

Endnu bedre end den ægte vare

Forskerne sammenlignede deres metode med adskillige andre billedklassificeringsmodeller, der blev trænet ved hjælp af rigtige data og fandt ud af, at deres metode fungerede lige så godt, og nogle gange bedre, end de andre modeller.

En fordel ved at bruge en generativ model er, at den i teorien kan skabe et uendeligt antal prøver. Så forskerne undersøgte også, hvordan antallet af prøver påvirkede modellens ydeevne. De fandt ud af, at generering af et større antal unikke prøver i nogle tilfælde førte til yderligere forbedringer.

"Det fede ved disse generative modeller er, at en anden har trænet dem for dig. Du kan finde dem i online repositories, så alle kan bruge dem. Og du behøver ikke at gribe ind i modellen for at få gode repræsentationer," siger Jahanian .

Men han advarer om, at der er nogle begrænsninger ved at bruge generative modeller. I nogle tilfælde kan disse modeller afsløre kildedata, som kan udgøre privatlivsrisici, og de kan forstærke skævheder i de datasæt, de er trænet i, hvis de ikke er ordentligt revideret.

Han og hans samarbejdspartnere planlægger at løse disse begrænsninger i det fremtidige arbejde. Et andet område, de ønsker at udforske, er at bruge denne teknik til at generere hjørnecases, der kunne forbedre maskinlæringsmodeller. Hjørnetilfælde kan ofte ikke læres af rigtige data. For eksempel, hvis forskere træner en computervisionsmodel til en selvkørende bil, ville rigtige data ikke indeholde eksempler på en hund og hans ejer, der løber ned ad en motorvej, så modellen ville aldrig lære, hvad den skal gøre i denne situation. Syntetisk generering af disse hjørnecasedata kunne forbedre ydeevnen af maskinlæringsmodeller i nogle situationer med høj indsats.

Forskerne ønsker også at fortsætte med at forbedre generative modeller, så de kan komponere billeder, der er endnu mere sofistikerede, siger han.

Varme artikler

Varme artikler

-

Materialesandwich bryder barrieren for solcelleeffektivitetForskerteamet ledet af André Taylor, arbejder med det aktive lag af en organisk solcelle, opnået bemærkelsesværdig effektivitet ved at indføre et squarinmolekyle (ASSQ) som et krystalliseringsmiddel,

Materialesandwich bryder barrieren for solcelleeffektivitetForskerteamet ledet af André Taylor, arbejder med det aktive lag af en organisk solcelle, opnået bemærkelsesværdig effektivitet ved at indføre et squarinmolekyle (ASSQ) som et krystalliseringsmiddel, -

Bevæbnede droner, iris scannere:Kinas højteknologiske sikkerhedsudstyrAnsigtsgenkendelsesskærme, der analyserede ærlige billeder af konferencens deltagere, var spredt rundt i udstillingshallen Fra virtual reality politiets træningsprogrammer til våben-toting droner

Bevæbnede droner, iris scannere:Kinas højteknologiske sikkerhedsudstyrAnsigtsgenkendelsesskærme, der analyserede ærlige billeder af konferencens deltagere, var spredt rundt i udstillingshallen Fra virtual reality politiets træningsprogrammer til våben-toting droner -

Hvorfor falder så mange mennesker for falske profiler online?Vil du være venner med denne person? Kredit:Sasun Bughdaryan Det første trin i gennemførelsen af online propagandaindsatser og misinformationskampagner er næsten altid en falsk profil på sociale

Hvorfor falder så mange mennesker for falske profiler online?Vil du være venner med denne person? Kredit:Sasun Bughdaryan Det første trin i gennemførelsen af online propagandaindsatser og misinformationskampagner er næsten altid en falsk profil på sociale -

Workhorse lithium batteri kunne være mere kraftfuldt takket være nyt designSnehashis Choudhury, Ph.d. 18, venstre, og Lynden Archer i Archers Kimball Hall-kontor. Kredit:Tom Fleischman Cornell University kemiingeniørprofessor Lynden Archer mener, at der er brug for en ba

Workhorse lithium batteri kunne være mere kraftfuldt takket være nyt designSnehashis Choudhury, Ph.d. 18, venstre, og Lynden Archer i Archers Kimball Hall-kontor. Kredit:Tom Fleischman Cornell University kemiingeniørprofessor Lynden Archer mener, at der er brug for en ba

- Mangel på medieskepsis knyttet til troen på voldtægtsmyter

- Hjemmelavet UV Sterilisator

- Kondofysik i antiferromagnetiske Weyl -halvmetalfilm

- For at afgøre en strandovertrædelse, Napster-grundlæggeren skaber YourCoast-appen

- Grafenoxid påvises af specialiserede celler i immunsystemet

- Sjove fakta om østers til Kids