4-D kamera kan forbedre robot vision, virtual reality og selvkørende biler

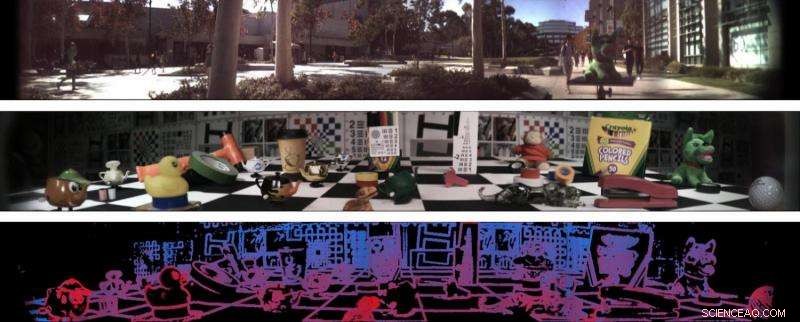

To 138-graders lysfeltpanoramaer (øverst og i midten) og et dybdeestimat af det andet panorama (nederst). Kredit:Stanford Computational Imaging Lab og Photonic Systems Integration Laboratory ved UC San Diego

Ingeniører ved Stanford University og University of California San Diego har udviklet et kamera, der genererer fire-dimensionelle billeder og kan fange 138 graders information. Det nye kamera-det første nogensinde med et enkelt objektiv, bredt synsfelt, lysfeltkamera-kunne generere informationsrige billeder og videorammer, der gør det muligt for robotter at navigere bedre i verden og forstå visse aspekter af deres miljø, såsom objektafstand og overfladestruktur.

Forskerne ser også, at denne teknologi bruges i autonome køretøjer og augmented og virtual reality -teknologier. Forskere præsenterede deres nye teknologi på computervisionskonferencen CVPR 2017 i juli.

"Vi vil overveje, hvad der ville være det rigtige kamera til en robot, der kører eller leverer pakker med fly. Vi er gode til at lave kameraer til mennesker, men har robotter brug for at se, som mennesker gør? Sandsynligvis ikke, "sagde Donald Dansereau, en postdoktor i elektroteknik i Stanford og den første forfatter til papiret.

Projektet er et samarbejde mellem laboratorierne for elektrotekniske professorer Gordon Wetzstein i Stanford og Joseph Ford ved UC San Diego.

UC San Diego -forskere designede en sfærisk linse, der giver kameraet et ekstremt bredt synsfelt, omfatter næsten en tredjedel af cirklen omkring kameraet. Fords gruppe havde tidligere udviklet de sfæriske linser under programmet DARPA "SCENICC" (Soldier CENtric Imaging with Computational Cameras) for at bygge et kompakt videokamera, der optager 360-graders billeder i høj opløsning, med 125 megapixel i hver videoramme. I det projekt videokameraet brugte fiberoptiske bundter til at koble de sfæriske billeder til konventionelle flade fokusplan, giver høj ydeevne, men til høje omkostninger.

Det nye kamera bruger en version af de sfæriske linser, der eliminerer fiberbundterne gennem en kombination af linser og digital signalbehandling. Kombination af optikdesign og hardwareintegration fra Fords laboratorium med signalbehandling og algoritmisk ekspertise fra Wetzsteins laboratorium resulterede i en digital løsning, der ikke kun fører til oprettelsen af disse ekstra brede billeder, men forbedrer dem.

Det nye kamera er også afhængigt af en teknologi udviklet i Stanford kaldet lysfeltfotografering, det er det, der tilføjer en fjerde dimension til dette kamera-det fanger den to-aksede retning af lyset, der rammer linsen, og kombinerer disse oplysninger med 2-D-billedet. Et andet bemærkelsesværdigt træk ved lysfeltfotografering er, at det giver brugerne mulighed for at fokusere billeder igen, efter at de er taget, fordi billederne indeholder oplysninger om lysets position og retning. Robotter kunne bruge denne teknologi til at se gennem regn og andre ting, der kunne skjule deres udsyn.

"En af de ting, du indser, når du arbejder med et omnidirektionelt kamera, er, at det er umuligt at fokusere i alle retninger på én gang - noget er altid tæt på kameraet, mens andre ting er langt væk, "Sagde Ford." Lysfeltbilleddannelse gør det muligt at fokusere den optagne video igen under afspilning, samt kortlægning af en enkelt dybde af scenen. Disse muligheder åbner op for alle former for applikationer inden for VR og robotik. "

"Det kunne gøre det muligt for forskellige typer kunstigt intelligent teknologi at forstå, hvor langt væk objekter er, om de flytter sig, og hvad de er lavet af, "Wetzstein sagde." Dette system kan være nyttigt i enhver situation, hvor du har begrænset plads, og du vil have computeren til at forstå hele verden omkring den. "

Og selvom dette kamera kan fungere som et konventionelt kamera på lange afstande, det er også designet til at forbedre nærbilleder. Eksempler, hvor det ville være særligt nyttigt, omfatter robotter, der skal navigere gennem små områder, landing droner og selvkørende biler. Som en del af et forstærket eller virtual reality -system, dens dybdeoplysninger kan resultere i mere problemfri gengivelser af rigtige scener og understøtte bedre integration mellem disse scener og virtuelle komponenter.

Kameraet er i øjeblikket på proof-of-concept-stadiet, og teamet planlægger at oprette en kompakt prototype til test på en robot.

Varme artikler

Varme artikler

-

Kunstig mave afslører væskedynamik i madfordøjelsenIllustrationen viser flowfeltet og dråbeopdelingen omkring antralkontraktionsbølger. Kredit:Damien Dufour I bestræbelserne på at bekæmpe fedme og øge lægemiddelabsorptionen, forskere har grundigt

Kunstig mave afslører væskedynamik i madfordøjelsenIllustrationen viser flowfeltet og dråbeopdelingen omkring antralkontraktionsbølger. Kredit:Damien Dufour I bestræbelserne på at bekæmpe fedme og øge lægemiddelabsorptionen, forskere har grundigt -

Matryoshka -effekten:Forskere beskriver undervandsfænomenForskere ved USUs Splash Lab afslørede fysikken bag et unikt undervandsfænomen, der er blevet sammenlignet med Matryoshka -dukken - den traditionelle russiske dukke i en dukke. Kredit:Chris Mabey

Matryoshka -effekten:Forskere beskriver undervandsfænomenForskere ved USUs Splash Lab afslørede fysikken bag et unikt undervandsfænomen, der er blevet sammenlignet med Matryoshka -dukken - den traditionelle russiske dukke i en dukke. Kredit:Chris Mabey -

På vej til udskrivbare organiske lysemitterende dioderDen første prototype af OLED udviklet i Mainz, Tyskland, lyser MPI-P-logoet. Kredit:MPI-P Organiske lysemitterende dioder er komponenter, der ikke længere består af forbindelser, der indeholder de

På vej til udskrivbare organiske lysemitterende dioderDen første prototype af OLED udviklet i Mainz, Tyskland, lyser MPI-P-logoet. Kredit:MPI-P Organiske lysemitterende dioder er komponenter, der ikke længere består af forbindelser, der indeholder de -

Hvordan afgør efterforskerne brandstiftelse?Naturkatastrofer Billedgalleri En løbeild kan hærge et landskab. Se flere naturkatastrofer billeder. Foto høflighed Bureau of Land Management Skovbranden, der dræbte fem brandmænd og brændte mere en

Hvordan afgør efterforskerne brandstiftelse?Naturkatastrofer Billedgalleri En løbeild kan hærge et landskab. Se flere naturkatastrofer billeder. Foto høflighed Bureau of Land Management Skovbranden, der dræbte fem brandmænd og brændte mere en

- Forskere har længe undret over plastik, der mangler fra vores oceaner - men nu er det fundet

- Sådan fungerer 2-D stregkoder

- Skal NASA til Mars? Eller månen? Eller ingen steder?

- Private equity-koncernen Advent tager kontrol over Walmart Brasilien

- Strømafbrydelse:Ingeniører skaber en trådløs oplader, som du nemt kan skære i form

- Teori hjælper med analyse af nukleare materialer