Et glimt ind i fremtiden:Accelereret computing til accelererede partikler

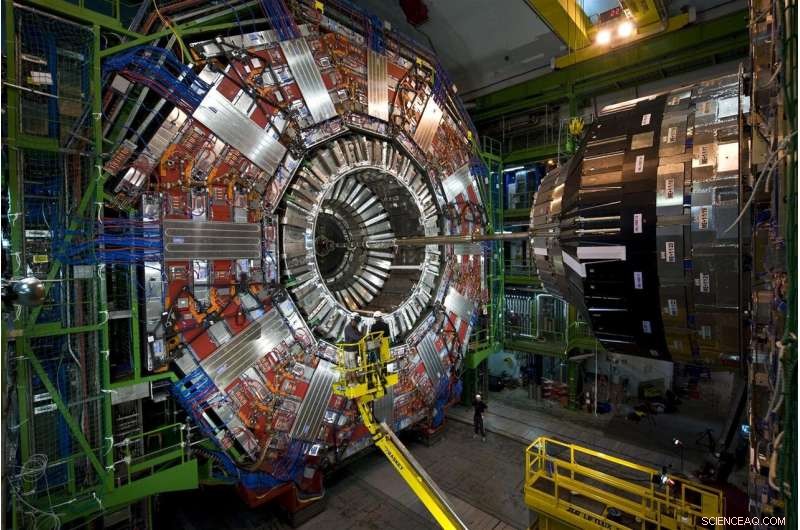

Partikler, der stammer fra protonkollisioner ved CERNs Large Hadron Collider, bevæger sig igennem disse historier, instrument i mange lag, CMS -detektoren. I 2026, LHC vil producere 20 gange de data, den gør i øjeblikket, og CMS er i øjeblikket under opgradering for at læse og behandle dataflod. Kredit:Maximilien Brice, CERN

Alle protonkollisioner ved Large Hadron Collider er forskellige, men kun få er specielle. De særlige kollisioner genererer partikler i usædvanlige mønstre - mulige manifestationer af nye, regeloverskridende fysik-eller hjælp med at udfylde vores ufuldstændige billede af universet.

At finde disse kollisioner er sværere end den ordsprogede søgning efter nålen i høstakken. Men spilskiftende hjælp er på vej. Fermilab-forskere og andre samarbejdspartnere testede med succes en prototype maskinlæringsteknologi, der fremskynder behandlingen med 30 til 175 gange i forhold til traditionelle metoder.

Konfronterer 40 millioner kollisioner hvert sekund, forskere ved LHC bruger kraftfulde, smarte computere til at plukke perlerne - uanset om det er en Higgs -partikel eller antydninger af mørkt stof - fra den enorme statik ved almindelige kollisioner.

Riffling gennem simulerede LHC -kollisionsdata, maskinlæringsteknologien har med succes lært at identificere et bestemt postkollisionsmønster - en særlig spray af partikler, der flyver gennem en detektor - da den bladrede gennem forbløffende 600 billeder i sekundet. Traditionelle metoder behandler mindre end ét billede i sekundet.

Teknologien kan endda tilbydes som en service på eksterne computere. Brug af denne aflastningsmodel ville give forskere mulighed for hurtigere at analysere flere data og efterlade mere LHC -computerplads til at udføre andet arbejde.

Det er et lovende indblik i, hvordan machine learning -tjenester understøtter et felt, hvor allerede enorme mængder data kun kommer til at blive større.

Udfordringen:flere data, mere computerkraft

Forskere opgraderer i øjeblikket LHC til at smadre protoner med fem gange dets nuværende hastighed. I 2026, den 17 mil lange cirkulære underjordiske maskine på det europæiske laboratorium CERN vil producere 20 gange flere data, end den gør nu.

CMS er en af partikeldetektorerne ved Large Hadron Collider, og CMS -samarbejdspartnere er midt i nogle egne opgraderinger, muliggøre det indviklede, historier højt instrument til at tage mere sofistikerede billeder af LHC's partikelkollisioner. Fermilab er det ledende amerikanske laboratorium for CMS -eksperimentet.

Hvis LHC-forskere ville gemme alle de rå kollisionsdata, de ville indsamle på et år fra High-Luminosity LHC, de skulle finde en måde at gemme omkring 1 exabyte (ca. 1 billion personlige eksterne harddiske), hvoraf kun et stykke kan afsløre nye fænomener. LHC -computere er programmeret til at vælge denne lille brøkdel, træffe beslutninger på to sekunder om, hvilke data der er værdifulde nok til at blive sendt nedstrøms til yderligere undersøgelse.

I øjeblikket, LHC's computersystem holder cirka en ud af 100, 000 partikelhændelser. Men nuværende lagringsprotokoller vil ikke være i stand til at følge med den fremtidige dataflod, som vil akkumulere sig over årtier med datatagning. Og de billeder med højere opløsning taget af den opgraderede CMS-detektor gør jobbet ikke lettere. Det hele oversætter til et behov for mere end 10 gange computerressourcerne, end LHC har nu.

Partikelfysikere undersøger brugen af computere med maskinlæringsmuligheder til behandling af billeder af partikelkollisioner ved CMS, lære dem hurtigt at identificere forskellige kollisionsmønstre. Kredit:Eamonn Maguire/Antarctic Design

Den nylige prototypetest viser, at med fremskridt inden for maskinlæring og computerhardware, forskere forventer at kunne vinde de data, der kommer fra den kommende High-Luminosity LHC, når de kommer online.

"Håbet her er, at du kan gøre meget sofistikerede ting med maskinlæring og også gøre dem hurtigere, "sagde Nhan Tran, en Fermilab -videnskabsmand på CMS -eksperimentet og en af lederne i den nylige test. "Dette er vigtigt, da vores data bliver mere og mere komplekse med opgraderede detektorer og travle kollisionsmiljøer. "

Maskinlæring til undsætning:forskellen mellem slutninger

Maskinlæring i partikelfysik er ikke nyt. Fysikere bruger maskinlæring til alle trin i databehandlingen i et kollideringseksperiment.

Men med maskinlæringsteknologi, der kan tygge LHC -data op til 175 gange hurtigere end traditionelle metoder, partikelfysikere stiger et spilskiftende trin på kollisionsberegningskurset.

De hurtige takster er takket være smart konstrueret hardware i platformen, Microsofts Azure ML, som fremskynder en proces kaldet slutning.

For at forstå slutning, overvej en algoritme, der er blevet trænet til at genkende billedet af en motorcykel:Objektet har to hjul og to håndtag, der er fastgjort til en større metalkrop. Algoritmen er smart nok til at vide, at en trillebør, som har lignende egenskaber, er ikke en motorcykel. Da systemet scanner nye billeder af andre tohjulede, genstande med to håndtag, den forudsiger - eller udleder - som er motorcykler. Og efterhånden som algoritmens forudsigelsesfejl rettes, det bliver ret behændigt at identificere dem. En milliard scanninger senere, det er på sit slutspil.

De fleste maskinlæringsplatforme er bygget til at forstå, hvordan man klassificerer billeder, men ikke fysik-specifikke billeder. Fysikere skal lære dem fysikdelen, såsom at genkende spor skabt af Higgs -bosonen eller søge efter antydninger af mørkt stof.

Forskere på Fermilab, CERN, MIT, University of Washington og andre samarbejdspartnere uddannede Azure ML til at identificere billeder af topkvarker-en kortvarig elementarpartikel, der er omkring 180 gange tungere end en proton-ud fra simulerede CMS-data. Specifikt, Azure skulle lede efter billeder af topkvarkstråler, skyer af partikler trukket ud af vakuumet af en enkelt topkvark, der zingede væk fra kollisionen.

"Vi sendte billederne til den, træner det i fysikdata, "sagde Fermilab -videnskabsmanden Burt Holzman, en føring på projektet. "Og det udviste topmoderne præstationer. Det var meget hurtigt. Det betyder, at vi kan føre et stort antal af disse ting i rørledning. Generelt, disse teknikker er ret gode. "

En af teknikkerne bag inferensacceleration er at kombinere traditionelt med specialiserede processorer, et ægteskab kendt som heterogen computingarkitektur.

Data fra partikelfysiske eksperimenter gemmes på computergårde som denne, Grid Computing Center på Fermilab. Udenfor organisationer tilbyder deres computergårde som en service til partikelfysiske eksperimenter, gør mere plads tilgængelig på eksperimentets servere. Kredit:Reidar Hahn

Forskellige platforme bruger forskellige arkitekturer. De traditionelle processorer er CPU'er (centrale processorenheder). De mest kendte specialiserede processorer er GPU'er (grafikprocessorenheder) og FPGA'er (feltprogrammerbare gate -arrays). Azure ML kombinerer CPU'er og FPGA'er.

"Grunden til, at disse processer skal fremskyndes, er, at det er store beregninger. Du taler om 25 milliarder operationer, "Tran sagde." Montering af det på en FPGA, kortlægger det, og at gøre det inden for rimelig tid er en reel præstation. "

Og det begynder at blive tilbudt som en service, også. Testen var første gang, nogen har påvist, hvordan denne form for heterogen, as-a-service arkitektur kan bruges til grundlæggende fysik.

I computerverdenen, at bruge noget "som en tjeneste" har en bestemt betydning. En ekstern organisation leverer ressourcer - maskinlæring eller hardware - som en tjeneste, og brugere - forskere - trækker på disse ressourcer, når det er nødvendigt. Det ligner, hvordan dit videostreamingsfirma leverer timevis af tv-serier som en tjeneste. Du behøver ikke at eje dine egne dvd'er og dvd -afspiller. Du bruger deres bibliotek og interface i stedet.

Data fra Large Hadron Collider gemmes og behandles typisk på computerservere på CERN og partnerinstitutioner som Fermilab. Med machine learning tilbudt lige så let som enhver anden webtjeneste kan være, intensive beregninger kan udføres overalt, hvor tjenesten tilbydes - inklusive off -site. Dette styrker laboratoriernes muligheder med yderligere computerkraft og ressourcer, samtidig med at de slipper for at skulle levere deres egne servere.

"Ideen om at accelerere computing har været omkring årtier, men den traditionelle model var at købe en computerklynge med GPU'er og installere den lokalt på laboratoriet, "Holzman sagde." Ideen om at aflaste arbejdet til en gård uden for stedet med specialiseret hardware, at levere maskinlæring som en tjeneste - det fungerede som annonceret. "

Azure ML -gården er i Virginia. Det tager kun 100 millisekunder for computere på Fermilab nær Chicago, Illinois, at sende et billede af en partikelhændelse til Azure -skyen, behandle det, og returner det. Det er en 2, 500 kilometer, datatæt tur på et øjeblik.

"VVS, der følger med alt dette, er en anden præstation, "Tran sagde." Konceptet med at abstrahere disse data som en ting, du bare sender et andet sted, og det kommer bare tilbage, var det mest behageligt overraskende ved dette projekt. Vi behøver ikke at erstatte alt i vores eget computercenter med en hel masse nye ting. Vi beholder det hele, send de hårde beregninger af sted og få det til at vende tilbage senere. "

Forskere ser frem til at skalere teknologien til at tackle andre big-data udfordringer på LHC. De planlægger også at teste andre platforme, såsom Amazon AWS, Google Cloud og IBM Cloud, når de undersøger, hvad der ellers kan opnås gennem maskinlæring, som har oplevet en hurtig udvikling i løbet af de sidste par år.

"De modeller, der var topmoderne i 2015, er standard i dag, "Sagde Tran.

Som et redskab, maskinlæring fortsætter med at give partikelfysik nye måder at skimte universet på. Det er også imponerende i sig selv.

"At vi kan tage noget, der er uddannet til at skelne mellem billeder af dyr og mennesker, lave en beskeden mængdeberegning, og lad det fortælle mig forskellen mellem en topkvarkstråle og baggrund? "sagde Holzman." Det er noget, der blæser i mit sind. "

Varme artikler

Varme artikler

-

Kan LHC bevise strengteori?En vedligeholdelsesarbejder inspicerer Large Hadron Collider (LHC) -tunnelen i CERN (European Organization For Nuclear Research) forskningscenter den 19. november, 2013, i Genève, Schweiz. Foto af Vla

Kan LHC bevise strengteori?En vedligeholdelsesarbejder inspicerer Large Hadron Collider (LHC) -tunnelen i CERN (European Organization For Nuclear Research) forskningscenter den 19. november, 2013, i Genève, Schweiz. Foto af Vla -

Yale spiller kvantefangst i ny forskningYale-forskere har med succes pitchet en qubit fra et mikrobølgehulrum til et andet. Kredit:Michael S. Helfenbein/Yale University Yales seneste arbejde med at udvide rækkevidden af kvanteinformat

Yale spiller kvantefangst i ny forskningYale-forskere har med succes pitchet en qubit fra et mikrobølgehulrum til et andet. Kredit:Michael S. Helfenbein/Yale University Yales seneste arbejde med at udvide rækkevidden af kvanteinformat -

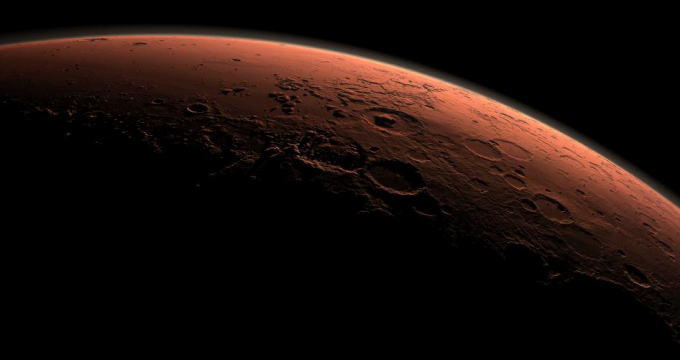

Mimetisk Mars-vand er under presKredit:NASA Forskere, der undersøger, om flydende vand kunne eksistere på Mars, har givet ny indsigt i grænserne for liv på den røde planet. Et hold ledet af Dr. Lorna Dougan fra University of Le

Mimetisk Mars-vand er under presKredit:NASA Forskere, der undersøger, om flydende vand kunne eksistere på Mars, har givet ny indsigt i grænserne for liv på den røde planet. Et hold ledet af Dr. Lorna Dougan fra University of Le -

Unik injektor skaber bundter af elektroner for at stimulere røntgenpulser fra millioner pr. SekundJoe Wallig, venstre, en maskiningeniør, og Brian Reynolds, en mekaniker, arbejde med den sidste samling af LCLS-II injektorpistolen i et specielt designet renrum på Berkeley Lab i august. Kredit:Maril

Unik injektor skaber bundter af elektroner for at stimulere røntgenpulser fra millioner pr. SekundJoe Wallig, venstre, en maskiningeniør, og Brian Reynolds, en mekaniker, arbejde med den sidste samling af LCLS-II injektorpistolen i et specielt designet renrum på Berkeley Lab i august. Kredit:Maril

- Hvorfor diamant nanotråd kunne vise sig at være uvurderlig til fremstilling

- Kampen om uddannelse stopper ikke, når drenge fra arbejderklassen kommer på universitetet

- Hvad er årsagen til over høsting af fiskeri?

- NASA satellit finder kraftige storme i den tropiske storm Ramons centrum

- Sådan Bisect en vinkel med kun en linjal

- Mindre salt, mere protein:Adressering af mejeriprocesser miljømæssigt, bæredygtighedsspørgsmål