Forskere foreslår betingelser for at maksimere kvantesammenfiltring

Entanglement er en egenskab ved kvantefysikken, der manifesteres, når to eller flere systemer interagerer på en sådan måde, at deres kvantetilstande ikke kan beskrives uafhængigt. I kvantefysikkens terminologi siges de at være sammenfiltrede, dvs. stærkt korrelerede. Entanglement er af afgørende betydning for kvanteberegning. Jo større sammenfiltring, jo mere optimeret og effektiv er kvantecomputeren.

En undersøgelse udført af forskere tilknyttet Institut for Fysik ved São Paulo State University's Institute of Geosciences and Exact Sciences (IGCE-UNESP) i Rio Claro, Brasilien, testede en ny metode til at kvantificere sammenfiltring og betingelserne for dens maksimering. Applikationer omfatter optimering af konstruktionen af en kvantecomputer.

En artikel om undersøgelsen er publiceret som et brev i Physical Review B .

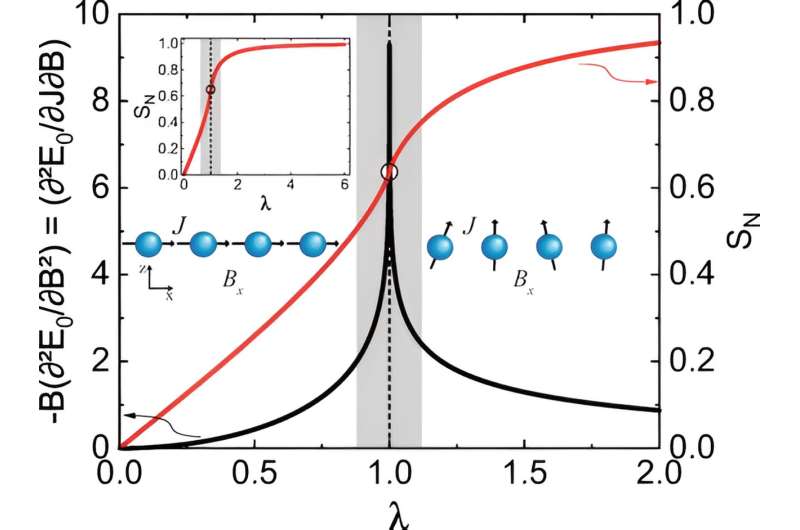

Undersøgelsen viste, hvordan Hellmann-Feynman-sætningen nedbrydes under specifikke forhold. Sætningen beskriver afhængigheden af systemets egen energi af en kontrolparameter og er en central del af kvantemekanikken brugt på tværs af discipliner fra kvantekemi til partikelfysik.

"Simpelt sagt foreslår vi en kvanteanalog af Grüneisen-parameteren, der er meget brugt i termodynamik til at udforske endelige temperatur- og kvantekritiske punkter. I vores forslag kvantificerer kvante-Grüneisen-parameteren entanglement, eller von Neumann-entropi, i forhold til en kontrolparameter, som kan for eksempel være et magnetfelt eller et vist trykniveau," fortalte Valdeci Mariano de Souza, sidste forfatter til artiklen og professor ved IGCE-UNESP, til Agência FAPESP.

"Ved at bruge vores forslag demonstrerer vi, at sammenfiltring vil blive maksimeret nær kvantekritiske punkter, og at Hellmann-Feynman-sætningen bryder sammen på et kritisk punkt."

For Souza bidrager resultaterne til grundlæggende fysikforskning og kan også direkte påvirke kvantecomputere. Idet han mindede om Intels medstifter Gordon Moores forudsigelse fra 1965 om, at antallet af transistorer brugt i konventionelle computere ville fordobles hvert andet år, sagde han, at denne hurtige vækst i kraften af klassiske computere ikke kunne holde, mens de seneste teknologiske fremskridt gør det muligt for kvantecomputere at udvikle sig med stormskridt og grænser, med giganter som Google og IBM i spidsen.

"I konventionel databehandling bruges binært sprog i form af nuller og ettaller til at behandle information. Kvantemekanik overlejrer imidlertid tilstande og øger behandlingskapaciteten enormt. Derfor den voksende interesse for forskning i kvantesammenfiltring," forklarede han.

Undersøgelsen blev foreslået og designet af Souza, og vigtige bidrag blev givet af Lucas Squillante, en postdoc-forsker, han vejleder. De andre samarbejdspartnere var Antonio Seridonio (UNESP Ilha Solteira), Roberto Lagos-Monaco (UNESP Rio Claro), Luciano Ricco (University of Island) og Aniekan Magnus Ukpong (University of KwaZulu-Natal, Sydafrika).

Flere oplysninger: Lucas Squillante et al., Grüneisen-parameter som et sammenfiltringskompas og nedbrydningen af Hellmann-Feynman-sætningen, Physical Review B (2023). DOI:10.1103/PhysRevB.108.L140403

Journaloplysninger: Fysisk gennemgang B

Leveret af FAPESP

Varme artikler

Varme artikler

-

Sådan isisikker den næste generation af flyKredit:CC0 Public Domain 35, 000 fod er standard cruisinghøjde for et kommercielt jetfly, men i disse høje højder falder lufttemperaturen under -51 grader Celsius, og der kan let dannes is på ving

Sådan isisikker den næste generation af flyKredit:CC0 Public Domain 35, 000 fod er standard cruisinghøjde for et kommercielt jetfly, men i disse høje højder falder lufttemperaturen under -51 grader Celsius, og der kan let dannes is på ving -

Science fiction bliver videnskabsfaktum, da forskere skaber flydende metalhjerteslag(Venstre mod højre) University of Wollongong forskere Zhenwei Yu, Xiaolin Wang, David Cortie og Frank Fei Yun opdagede den hjerteslagende effekt i flydende gallium. Kredit:Paul Jones I en banebryd

Science fiction bliver videnskabsfaktum, da forskere skaber flydende metalhjerteslag(Venstre mod højre) University of Wollongong forskere Zhenwei Yu, Xiaolin Wang, David Cortie og Frank Fei Yun opdagede den hjerteslagende effekt i flydende gallium. Kredit:Paul Jones I en banebryd -

Ingeniører producerer et fisheye -objektiv, der er helt fladt3D kunstnerisk illustration af metalfeltene i vidvinkel, der fanger et 180 ° panorama over MIT’s Killian Court og producerer et monokromatiskt fladt billede i høj opløsning. ” Kredit:Mikhail Shalagino

Ingeniører producerer et fisheye -objektiv, der er helt fladt3D kunstnerisk illustration af metalfeltene i vidvinkel, der fanger et 180 ° panorama over MIT’s Killian Court og producerer et monokromatiskt fladt billede i høj opløsning. ” Kredit:Mikhail Shalagino -

Når kinetik og termodynamik skal spille sammenForskning fra McKelvey School of Engineering tyder på, at uden at overveje visse faktorer, forskere kan overvurdere, hvor hurtigt calciumcarbonat dannes i saltholdige miljøer. Kredit:Grafik:McKelvey S

Når kinetik og termodynamik skal spille sammenForskning fra McKelvey School of Engineering tyder på, at uden at overveje visse faktorer, forskere kan overvurdere, hvor hurtigt calciumcarbonat dannes i saltholdige miljøer. Kredit:Grafik:McKelvey S