Ny klimamodel, der skal bygges fra bunden

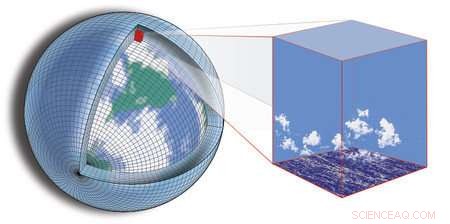

Nuværende klimamodellering er afhængig af at opdele kloden i et gitter og derefter beregne, hvad der foregår i hver sektor af nettet, samt hvordan sektorerne interagerer med hinanden. Kredit:Tapio Schneider/Kyle Pressel/Momme Hell/Caltech

Over for visheden om et klima i forandring kombineret med den usikkerhed, der forbliver i forudsigelserne om, hvordan det vil ændre sig, forskere og ingeniører fra hele landet går sammen om at bygge en ny type klimamodel, der er designet til at give mere præcise og anvendelige forudsigelser.

Udnyttelse af de seneste fremskridt inden for beregnings- og datavidenskab, den omfattende indsats udnytter enorme mængder data, der nu er tilgængelige, og på stadig stærkere computeregenskaber både til behandling af data og til simulering af jordsystemet.

Den nye model vil blive bygget af et konsortium af forskere ledet af Caltech, i partnerskab med MIT; Naval Postgraduate School (NPS); og JPL, som Caltech administrerer for NASA. Konsortiet, døbt Climate Modeling Alliance (CliMA), planlægger at fusionere jordobservationer og højopløsningssimuleringer til en model, der repræsenterer vigtige småskala-træk, såsom skyer og turbulens, mere pålideligt end eksisterende klimamodeller. Målet er en klimamodel, der projekterer fremtidige ændringer i kritiske variabler som f.eks. Regn, og havis udbredelse mere præcist - med usikkerheder mindst to gange mindre end eksisterende modeller.

"Fremskrivninger med nuværende klimamodeller - f.eks. af, hvordan funktioner såsom ekstreme nedbørsmængder vil ændre sig - der stadig er store usikkerheder, og usikkerheden er dårligt kvantificeret, " siger Tapio Schneider, Caltechs Theodore Y. Wu professor i miljøvidenskab og teknik, seniorforsker ved JPL, og hovedefterforsker af CliMA. "For byer, der planlægger deres infrastruktur til styring af stormvand, til at modstå de næste 100 års oversvømmelser, dette er et alvorligt spørgsmål; konkrete svar om den sandsynlige række af klimaresultater er nøglen til planlægning."

Konsortiet vil fungere i et tempofyldt, start-up-lignende atmosfære, og håber at have den nye model op at køre inden for de næste fem år - en aggressiv tidslinje for at bygge en klimamodel i det væsentlige fra bunden.

"En frisk start giver os en mulighed for at designe modellen fra starten, så den kører effektivt på moderne og hurtigt udviklende computerhardware, og at atmosfæriske og havmodeller skal være hinandens nære fætre, deler de samme numeriske algoritmer, " siger Frank Giraldo, professor i anvendt matematik ved NPS.

Nuværende klimamodellering er afhængig af at opdele kloden i et gitter og derefter beregne, hvad der foregår i hver sektor af nettet, samt hvordan sektorerne interagerer med hinanden. Nøjagtigheden af en given model afhænger til dels af den opløsning, som modellen kan se jorden med - dvs. størrelsen på netets sektorer. Begrænsninger i tilgængelig computerbehandlingskraft betyder, at disse sektorer generelt ikke kan være mindre end snesevis af kilometer pr. Side. Men for klimamodellering, djævelen er i detaljerne-detaljer, der går glip af i et for stort gitter.

For eksempel, lavtliggende skyer har en betydelig indvirkning på klimaet ved at reflektere sollys, men de turbulente faner, der opretholder dem, er så små, at de falder gennem sprækkerne på eksisterende modeller. Tilsvarende ændringer i arktisk havis har været forbundet med vidtrækkende virkninger på alt fra polarklima til tørke i Californien, men det er svært at forudsige, hvordan den is vil ændre sig i fremtiden, fordi den er følsom over for tætheden af skydække over isen og temperaturen på havstrømme herunder, som begge ikke kan løses med nuværende modeller.

For at indfange den store indvirkning af disse småskala funktioner, holdet vil udvikle højopløsningssimuleringer, der modellerer funktionerne i detaljer i udvalgte områder af kloden. Disse simuleringer vil blive indlejret i den større klimamodel. Effekten vil være en model, der er i stand til at "zoome ind" på udvalgte regioner, at give detaljerede lokale klimaoplysninger om disse områder og informere om modellering af småskalaprocesser alle andre steder.

"Havet optager meget af den varme og kulstof, der ophobes i klimasystemet. hvor meget den fylder afhænger af turbulente hvirvler i det øvre hav, som er for små til at blive løst i klimamodeller, " siger Raffaele Ferrari, Cecil og Ida Green professor i oceanografi ved MIT. "Sammensmeltning af indlejrede højopløsningssimuleringer med nyligt tilgængelige målinger fra, for eksempel, en flåde på tusinder af autonome flydere kunne muliggøre et spring i nøjagtigheden af havforudsigelser."

Mens eksisterende modeller ofte testes ved at kontrollere forudsigelser mod observationer, den nye model vil tage jordsandheden et skridt videre ved at bruge data-assimilering og maskinlæringsværktøjer til at "lære" modellen til at forbedre sig selv i realtid, udnytte både jordobservationer og de indlejrede højopløselige simuleringer.

"Succesen med beregningsmæssig vejrudsigt viser styrken ved at bruge data til at forbedre nøjagtigheden af computermodeller; vi sigter mod at bringe de samme succeser til klimaforudsigelser, " siger Andrew Stuart, Caltechs Bren-professor i computing og matematiske videnskaber.

Hver af partnerinstitutionerne tilfører projektet forskellig styrke og forskningsekspertise. Hos Caltech, Schneider og Stuart vil fokusere på at skabe data-assimilering og maskinlæringsalgoritmer, samt modeller til skyer, turbulens, og andre atmosfæriske træk. På MIT, Ferrari og John Marshall, også Cecil og Ida Green professor i oceanografi, vil lede et team, der vil modellere havet, inklusive dens store cirkulation og turbulente blanding. Hos NPS, Giraldo skal lede udviklingen af den beregningsmæssige kerne i den nye atmosfæremodel i samarbejde med Jeremy Kozdon og Lucas Wilcox. Hos JPL, en gruppe videnskabsmænd vil samarbejde med holdet på Caltechs campus for at udvikle procesmodeller for atmosfæren, biosfære, og kryosfære.

Sidste artikelRekordvåde og rekordtørre måneder steg i regioner verden over

Næste artikelDøden nær kystlinjen, ikke liv på land

Varme artikler

Varme artikler

-

Landmænd hjælper med at dyrke vandplanDet stærkt landbrugsmæssige La Vi-flodbassin i Vietnam var fokus for undersøgelsen. Kredit:Flinders University Overordnet placering af overfladevand til dyrkning af fødeafgrøder skifter landbrug o

Landmænd hjælper med at dyrke vandplanDet stærkt landbrugsmæssige La Vi-flodbassin i Vietnam var fokus for undersøgelsen. Kredit:Flinders University Overordnet placering af overfladevand til dyrkning af fødeafgrøder skifter landbrug o -

Marshalløerne først til at ratificere HFC-drivhusgasaftalenStranden ved Majuro på Marshalløerne Marshalløerne, en stillehavsøgruppe, der er meget udsat for klima-induceret havniveaustigning, sagde tirsdag, at det var det første land, der ratificerede en g

Marshalløerne først til at ratificere HFC-drivhusgasaftalenStranden ved Majuro på Marshalløerne Marshalløerne, en stillehavsøgruppe, der er meget udsat for klima-induceret havniveaustigning, sagde tirsdag, at det var det første land, der ratificerede en g -

Terrestriske økosystemers funktion er styret af tre hovedfaktorerForsøgsstedet i Torgnon (Italien), et græsareal beliggende på omkring 2100 m i de vestitalienske alper, og tilhører det integrerede kulstofobservationssystem (ICOS) og FLUXNET-netværket. Kredit:Marta

Terrestriske økosystemers funktion er styret af tre hovedfaktorerForsøgsstedet i Torgnon (Italien), et græsareal beliggende på omkring 2100 m i de vestitalienske alper, og tilhører det integrerede kulstofobservationssystem (ICOS) og FLUXNET-netværket. Kredit:Marta -

Varmebølge griber Nordeuropa, når Grækenland brænderStegende varmt vejr satte betingelserne for Grækenlands dødbringende naturbrande Stegende varmt vejr satte betingelserne for Grækenlands naturbrande - Europas dødeligste i dette århundrede med man

Varmebølge griber Nordeuropa, når Grækenland brænderStegende varmt vejr satte betingelserne for Grækenlands dødbringende naturbrande Stegende varmt vejr satte betingelserne for Grækenlands naturbrande - Europas dødeligste i dette århundrede med man

- Metalforurening:Hvis den er i luften - og vores iPhones - ender den i vores knogler

- Europæisk alliance vil investere op til 6 mia. euro i batterier til elbiler

- Virkningen af feedback i realtid i medarbejderanmeldelser

- Forskere åbner en vej mod kvanteberegning under virkelige forhold

- Ny varm Jupiter med kort omløbsperiode opdaget

- Forskning giver ny indsigt i at udnytte momentuminvesteringer