Simulerer 800, 000 års jordskælvshistorie i Californien for at udpege risici

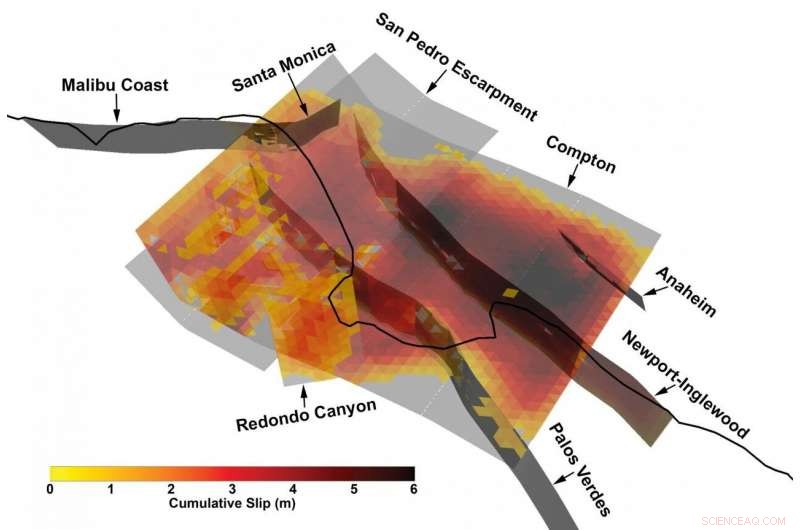

3D-visning af et særligt komplekst multi-fejlbrud fra det syntetiske jordskælvskatalog udviklet af Southern California Earthquake Center ved hjælp af en ny jordskælvsmodelleringsramme. Kredit:Kevin Milner, University of Southern California

Massive jordskælv er, heldigvis, sjældne begivenheder. Men den mangel på information gør os på nogle måder blinde for deres risici, især når det kommer til at bestemme risikoen for en bestemt placering eller struktur.

"Vi har ikke observeret de fleste af de mulige hændelser, der kan forårsage store skader, " forklarede Kevin Milner, en datalog og seismologiforsker ved Southern California Earthquake Center (SCEC) ved University of Southern California. "Ved at bruge det sydlige Californien som eksempel, vi har ikke haft et virkelig stort jordskælv siden 1857 - det var sidste gang, det sydlige San Andreas brød ind i et massivt jordskælv med en styrke på 7,9. Et San Andreas jordskælv kan påvirke et meget større område end Northridge jordskælvet i 1994, og andre store jordskælv kan også forekomme. Det er det, vi er bekymrede over«.

Den traditionelle måde at komme uden om denne mangel på data involverer at grave skyttegrave for at lære mere om tidligere brud, samle information fra masser af jordskælv rundt om i verden og skabe en statistisk model for fare, eller ved at bruge supercomputere til at simulere et specifikt jordskælv et bestemt sted med en høj grad af troskab.

Imidlertid, en ny ramme til at forudsige sandsynligheden for og virkningen af jordskælv over en hel region, udviklet af et team af forskere tilknyttet SCEC i løbet af det sidste årti, har fundet en mellemvej og måske en bedre måde at konstatere risiko på.

En ny undersøgelse ledet af Milner og Bruce Shaw fra Columbia University, offentliggjort i Bulletin fra Seismological Society of America i januar 2021, præsenterer resultater fra en prototype Rate-State jordskælvssimulator, eller RSQSim, der simulerer hundredtusinder af års seismisk historie i Californien. Sammen med en anden kode, CyberShake, rammen kan beregne mængden af rystelser, der ville forekomme for hvert jordskælv. Deres resultater kan sammenlignes godt med historiske jordskælv og resultaterne af andre metoder, og vise en realistisk fordeling af jordskælvssandsynligheder.

Ifølge udviklerne, den nye tilgang forbedrer evnen til at lokalisere, hvor stort et jordskælv kan forekomme på et givet sted, tillader udviklere af byggekoder, arkitekter, og konstruktionsingeniører til at designe mere modstandsdygtige bygninger, der kan overleve jordskælv på et bestemt sted.

"For første gang, vi har en hel pipeline fra start til slut, hvor jordskælvsforekomst og jordbevægelsessimulering er fysikbaseret, " sagde Milner. "Det kan simulere op til 100, 000'er af år på et virkelig kompliceret fejlsystem."

Anvender massiv computerkraft til store problemer

RSQSim transformerer matematiske repræsentationer af de geofysiske kræfter, der er på spil i jordskælv - standardmodellen for, hvordan brud opstår og udbreder sig - til algoritmer, og derefter løser dem på nogle af de mest kraftfulde supercomputere på planeten. Den beregningsintensive forskning blev muliggjort over flere år af regeringssponserede supercomputere ved Texas Advanced Computing Center, inklusive Frontera – det mest kraftfulde system på ethvert universitet i verden – Blue Waters ved National Center for Supercomputing Applications, og topmøde på Oak Ridge Leadership Computing Facility.

"En måde, hvorpå vi måske kan blive bedre til at forudsige risiko, er gennem fysikbaseret modellering, ved at udnytte kraften i systemer som Frontera til at køre simuleringer, " sagde Milner. "I stedet for en empirisk statistisk fordeling, vi simulerer forekomsten af jordskælv og udbredelsen af dets bølger."

"Vi har gjort store fremskridt på Frontera med at bestemme, hvilken slags jordskælv vi kan forvente, på hvilken fejl, og hvor ofte, " sagde Christine Goulet, Executive Director for Applied Science hos SCEC, også involveret i arbejdet. "Vi foreskriver eller fortæller ikke koden, hvornår jordskælvene kommer til at ske. Vi lancerer en simulering af hundredtusindvis af år, og lad bare koden overføre stress fra en fejl til en anden."

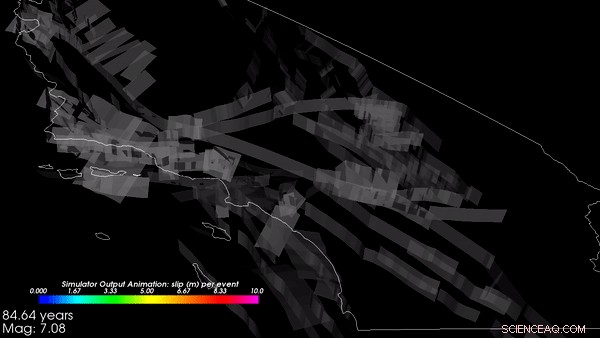

Simuleringerne begyndte med Californiens geologiske topografi og simulerede over 800, 000 virtuelle år hvordan spændinger dannes og forsvinder, når tektoniske kræfter virker på Jorden. Fra disse simuleringer, rammeværket genererede et katalog - en registrering af, at et jordskælv fandt sted et bestemt sted med en bestemt størrelse og egenskaber på et givet tidspunkt. Kataloget, som SCEC-teamet producerede på Frontera og Blue Waters, var blandt de største, der nogensinde er lavet, sagde Goulet. Outputtet fra RSQSim blev derefter ført ind i CyberShake, der igen brugte computermodeller af geofysik til at forudsige, hvor meget rystelse (i form af jordens acceleration, eller hastighed, og varighed) ville forekomme som et resultat af hvert jordskælv.

"Rammeværket udsender en fuld slip-time historie:hvor et brud opstår, og hvordan det voksede, Milner forklarede. "Vi fandt ud af, at det producerer realistiske jordbevægelser, som fortæller os, at fysikken implementeret i modellen fungerer efter hensigten." De har mere arbejde planlagt for validering af resultaterne, hvilket er kritisk før accept til designansøgninger.

Forskerne fandt ud af, at RSQSim-rammen producerer rig, variable jordskælv generelt - et tegn på, at det giver rimelige resultater - samtidig med at det genererer gentagelige kilde- og stieffekter.

En tilfældigt udvalgt 3, 000-års segment af det fysik-baserede simulerede katalog over jordskælv i Californien, oprettet på Frontera. Kredit:Kevin Milner, University of Southern California

"For mange websteder, rystefaren falder, i forhold til state-of-practice estimater" sagde Milner. "Men for et par steder, der har specielle konfigurationer af nærliggende forkastninger eller lokale geologiske træk, som i nærheden af San Bernardino, faren steg. Vi arbejder på at forstå disse resultater bedre og på at definere tilgange til at verificere dem."

Arbejdet hjælper med at bestemme sandsynligheden for, at et jordskælv opstår langs nogen af Californiens hundredvis af jordskælvsproducerende forkastninger, omfanget af jordskælv, der kunne forventes, og hvordan det kan udløse andre jordskælv.

Støtte til projektet kommer fra U.S. Geological Survey (USGS), National Science Foundation (NSF), og W.M. Keck Fonden. Frontera er NSF's nationale ressource i ledelsesklasse. Beregningstid på Frontera blev leveret gennem en Large-Scale Community Partnership (LSCP)-pris til SCEC, der giver hundredvis af amerikanske forskere adgang til maskinen for at studere mange aspekter af jordskælvsvidenskab. LSCP-priser giver forlængede tildelinger på op til tre år for at støtte langvarig forskningsindsats. SCEC - som blev grundlagt i 1991 og har beregnet på TACC-systemer i mere end et årti - er et fremragende eksempel på en sådan indsats.

Oprettelsen af kataloget krævede otte dages kontinuerlig databehandling på Frontera og brugte mere end 3, 500 processorer parallelt. Simulering af jordrystning på 10 steder i Californien krævede en sammenlignelig mængde databehandling på Summit, den næsthurtigste supercomputer i verden.

"Adoption af det bredere samfund vil forståeligt nok gå langsomt, " sagde Milner. "Fordi sådanne resultater vil påvirke sikkerheden, det er en del af vores due diligence at sikre, at disse resultater er teknisk forsvarlige af det bredere samfund, " tilføjede Goulet. Men forskningsresultater som disse er vigtige for at komme videre end generaliserede byggekoder, der i nogle tilfælde kan være utilstrækkeligt repræsenterende den risiko, en region står over for, mens den i andre tilfælde er for konservativ.

"Håbet er, at disse typer modeller vil hjælpe os med bedre at karakterisere seismisk fare, så vi bruger vores ressourcer på at bygge stærke, sikker, modstandsdygtige bygninger, hvor der er mest brug for dem, " sagde Milner.

Sidste artikelAtomkrig kan udløse store El Nino og mindske fisk og skaldyr

Næste artikelDet globale istab stiger med rekordhastighed

Varme artikler

Varme artikler

-

Naturen betyder noget - og det sender os en SOS, som vi ikke længere kan ignorereKredit:Adriano Gambarini / WWF-Brasilien Jorden, naturen og os. Vi er alle forbundet på en så subtil og smart måde, at vi ikke engang ved, hvor heldige vi er - før det ændrer sig. I går stolede vi

Naturen betyder noget - og det sender os en SOS, som vi ikke længere kan ignorereKredit:Adriano Gambarini / WWF-Brasilien Jorden, naturen og os. Vi er alle forbundet på en så subtil og smart måde, at vi ikke engang ved, hvor heldige vi er - før det ændrer sig. I går stolede vi -

Pres fra græssere fremskynder økosystemsammenbrud fra tørkeEn døende strandeng efter den ekstreme tørke i 2011 i Kina. Planter inde i et krabbeudelukkelsesbur formåede at overleve, men andre forsvandt, at forvandle de engang frodige moser til en bar saltflade

Pres fra græssere fremskynder økosystemsammenbrud fra tørkeEn døende strandeng efter den ekstreme tørke i 2011 i Kina. Planter inde i et krabbeudelukkelsesbur formåede at overleve, men andre forsvandt, at forvandle de engang frodige moser til en bar saltflade -

Et team af klimatologer studerer, hvordan man kan minimere fejl i observeret klimatendensKredit:Universitat Rovira i Virgili Den instrumentelle klimarekord er menneskehedens kulturarv, resultatet af det flittige arbejde fra mange generationer af mennesker over hele verden. Imidlertid,

Et team af klimatologer studerer, hvordan man kan minimere fejl i observeret klimatendensKredit:Universitat Rovira i Virgili Den instrumentelle klimarekord er menneskehedens kulturarv, resultatet af det flittige arbejde fra mange generationer af mennesker over hele verden. Imidlertid, -

Optøning af verdens fryser - optøning af permafrostAlex Kholodov (University of Alaska, Fairbanks) bruger en elektrisk snegl til at forberede huller til vandbrønde på NGEE Arctic Sites i Barrow, Alaska. Kredit:US Department of Energy Sneklædte tin

Optøning af verdens fryser - optøning af permafrostAlex Kholodov (University of Alaska, Fairbanks) bruger en elektrisk snegl til at forberede huller til vandbrønde på NGEE Arctic Sites i Barrow, Alaska. Kredit:US Department of Energy Sneklædte tin

- USA godkender jordudveksling til vej gennem Alaska -tilflugt

- Grafen er nøglen til at låse op for skabelsen af bærbare elektroniske enheder

- Værktøjer til tidlige mennesker

- Har en mands sociale klasse noget at gøre med sandsynligheden for, at helvede begår seksuelle over…

- End-to-end blodprøveapparat viser kapacitet til at tage prøve og give diagnostiske resultater

- Forskere designer en virtuel assistent med avanceret geolokalisering til guidede ture på museer