Nanostruktur komplekse materialer modellering

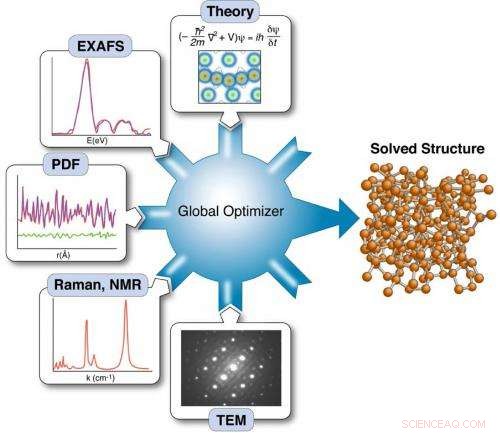

Forskere har demonstreret en måde at øge chancerne for at løse materialestrukturer ved at tilføre data fra flere eksperimenter og teori til en "global optimizer", der bruger matematiske algoritmer til at indsnævre rækken af mulige løsninger baseret på dens analyse af de komplementære datasæt.

Materialer med kemikalier, optisk, og elektroniske egenskaber drevet af strukturer, der måler milliardtedele af en meter, kan føre til forbedrede energiteknologier – fra mere effektive solceller til længerevarende energitætte batterier. Videnskabelige instrumenter som dem ved Brookhaven Labs Center for Functional Nanomaterials (CFN) og den netop åbnede National Synchrotron Light Source II (NSLS-II), både DOE Office of Science brugerfaciliteter, tilbyde nye måder at studere materialer på denne nanometerlængdeskala - også når de fungerer i faktiske enheder.

Disse eksperimenter producerer enorme mængder data, afsløre vigtige detaljer om materialer. Men lige nu har forskere ikke de beregningsværktøjer, de har brug for til at bruge disse data til rationelt materialedesign – et trin, der er afgørende for at fremskynde opdagelsen af materialer med de præstationskarakteristika, der kræves til den virkelige verden, storstilet implementering. For at nå det mål, det, der er brug for, er en ny måde at kombinere data fra en række eksperimenter sammen med teoretiske beskrivelser af materialers adfærd til valide forudsigelsesmodeller, som videnskabsmænd kan bruge til at udvikle kraftfulde nye materialer.

"Der er en meget god chance for, at ekspertise i højtydende databehandling og anvendte matematiske algoritmer udviklet med støtte fra DOE's Office of Advanced Scientific Computing Research (ASCR) kan hjælpe os med at gøre fremskridt på denne grænse, sagde Simon Billinge, en fysiker ved Brookhaven National Laboratory og Columbia University's School of Engineering and Applied Science. På SC14-konferencen, Simon præsenterede en potentiel løsning, der gør brug af matematisk teori og beregningsværktøjer til at udtrække den information, der er afgørende for at styrke modeller for materialeydelse.

"Mange af de modeller, vi har til disse materialer, er ikke robuste, " sagde han. "Ideelt set, vi vil gerne være i stand til at programmere i de egenskaber, vi ønsker - f.eks. effektiv konvertering af solenergi, superledningsevne, massiv elektrisk lagerkapacitet - og få modellen til at spytte designet ud for et nyt materiale, der vil have den egenskab, men det er klart umuligt med upålidelige modeller."

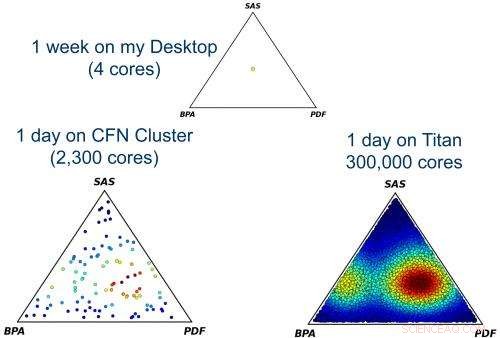

At finde mulige løsninger for et materiales struktur ved global optimering af en model, der inkorporerer data fra flere eksperimentelle teknikker, er beregningsmæssigt dyrt/tidskrævende, men skal gøres flere gange for at kontrollere, om der er mere end én løsning, der er kompatibel med dataene. Hver prik i disse trekantdiagrammer repræsenterer en anden måde at kæmme input fra de tre eksperimenter på, og farven angiver antallet af strukturløsninger fundet for den kombination (rød er den mest unikke løsning). Først når det er gjort for mange prikker, kan forskerne finde den mest sandsynlige fælles løsning, der tegner sig for alle data. Det kræver højtydende computere at håndtere den beregningsskala, der er nødvendig for at give klare resultater.

Kraftige eksperimentelle værktøjer såsom NSLS-II muliggør mere indviklede eksperimenter. Men ironisk nok, nogle af de nye teknikker gør opdagelsesprocessen vanskeligere.

Billinge forklarer:"Ægte materialer og virkelige anvendelser afhænger af fine detaljer i materialernes struktur, såsom defekter, overflader, og morfologi, så eksperimenter, der hjælper med at afsløre fine strukturelle detaljer, er afgørende. Men nogle af de mest interessante materialer er meget komplekse, og så bliver de gjort til endnu mere komplekse, multi-komponent enheder. Når vi placerer disse komplekse enheder i en røntgen- eller neutronspredningsstrålelinje, interaktioner mellem bjælkerne med alle de komplekse komponenter giver overlappende resultater. Du leder efter små signaler fra defekter og overflader skjult i en enorm baggrund af anden information fra de ekstra komponenter, alt sammen forringer den nyttige information."

På samme tid, kompleksiteten af de modeller, som forskerne forsøger at bygge for at forstå disse materialer, er også stigende, så de har brug for mere information om disse væsentlige detaljer for at kunne føres ind i modellen, ikke mindre. Løsning af disse problemer pålidelighed, i betragtning af alle usikkerheder, kræver avancerede matematiske tilgange og højtydende databehandling, så Simon og hans samarbejdspartnere arbejder med ASCR på en tostrenget tilgang til at forbedre processen.

På inputsiden, de kombinerer resultater fra flere eksperimenter - røntgenspredning, neutronspredning, og også teori. På udgangssiden, videnskabsmændene forsøger at reducere det, der kaldes modellens dimensionalitet. Billinge forklarede dette som at ligne den komprimering, der skaber en mp3-musikfil ved at afgive uvæsentlige oplysninger, som de fleste ikke ville bemærke, mangler.

"Hvis vi reducerer kompleksiteten for at minimere det nødvendige input for at gøre problemet løseligt, vi kan køre det gennem kraftfulde højtydende computere, der bruger avancerede matematiske metoder afledt af informationsteori, kvantificering af usikkerhed, og andre dataanalytiske teknikker til at sortere gennem alle detaljer, " sagde han. De matematiske algoritmer kan sammensætte den komplementære information fra de forskellige eksperimenter - lidt ligesom lignelsen om de blinde mænd, der udforsker forskellige dele af en elefant, men nu deler og kombinerer deres resultater - og brug det til at forudsige kompleks materialestruktur.

"I lighed med en mp3-fil, der mangler nogle oplysninger i disse modeller. Men med den rigtige repræsentation kan det være godt nok til at have prædiktiv værdi og give os mulighed for at designe nye materialer, " sagde Billinge.

Varme artikler

Varme artikler

-

Overraskende ion- og flowadfærd med funktionaliserede nanokanaler(venstre) Skematisk over det PE-børste-podede nanokanalsystem. (højre) Flowvending med påført elektrisk feltstyrke. Kredit:T.H. Pial et al., ACS Nano , 2021, DOI:10.1021/acsnano.0c09248 Nanokana

Overraskende ion- og flowadfærd med funktionaliserede nanokanaler(venstre) Skematisk over det PE-børste-podede nanokanalsystem. (højre) Flowvending med påført elektrisk feltstyrke. Kredit:T.H. Pial et al., ACS Nano , 2021, DOI:10.1021/acsnano.0c09248 Nanokana -

Nanoribbons til grafen -transistorerDette er en strukturel model og et tredimensionelt billede af scannings-tunnelmikroskopet af et zig-zag-formet grafen-nanoribbon. Kredit:Empa I det seneste nummer af Natur , Europæiske forskere

Nanoribbons til grafen -transistorerDette er en strukturel model og et tredimensionelt billede af scannings-tunnelmikroskopet af et zig-zag-formet grafen-nanoribbon. Kredit:Empa I det seneste nummer af Natur , Europæiske forskere -

Skæve mikrokapsler frigiver last ved lavere osmotiske tryk, der kræves til lægemiddelleveringMikrokapsler med skaller af varierende tykkelse (rød) kan stabilt indkapsle last og frigive den ved præcist kalibreret, lavt osmotisk tryk, tillader sikker levering af lægemidler og andre stoffer inde

Skæve mikrokapsler frigiver last ved lavere osmotiske tryk, der kræves til lægemiddelleveringMikrokapsler med skaller af varierende tykkelse (rød) kan stabilt indkapsle last og frigive den ved præcist kalibreret, lavt osmotisk tryk, tillader sikker levering af lægemidler og andre stoffer inde -

Molekylære broer forstærker trykt elektronikDi-thiols strukturelle mangfoldighed åbner en verden af muligheder for at regulere ledningsevnen, tilpasse den til hver specifik applikation. Kredit:University of Strasbourg Eksfolieringen af

Molekylære broer forstærker trykt elektronikDi-thiols strukturelle mangfoldighed åbner en verden af muligheder for at regulere ledningsevnen, tilpasse den til hver specifik applikation. Kredit:University of Strasbourg Eksfolieringen af

- Forskere skaber omvendt osmose-membraner med justerbar tykkelse

- Europæiske hedebølgedødsfald kan skyrocket:klimastudie

- NASA finder kraftig regn i den nye tropiske storm Krosa

- Naturbrande kan forurene drikkevandet. Det bekymrer nogle i bakkerne over Santa Cruz

- Ny undersøgelse viser, at offentligheden ønsker vedvarende energi - men regeringen lytter ikke

- Radise dække afgrøder fælder nitrogen; mysteriet følger