Køn er personligt - ikke beregningsmæssigt

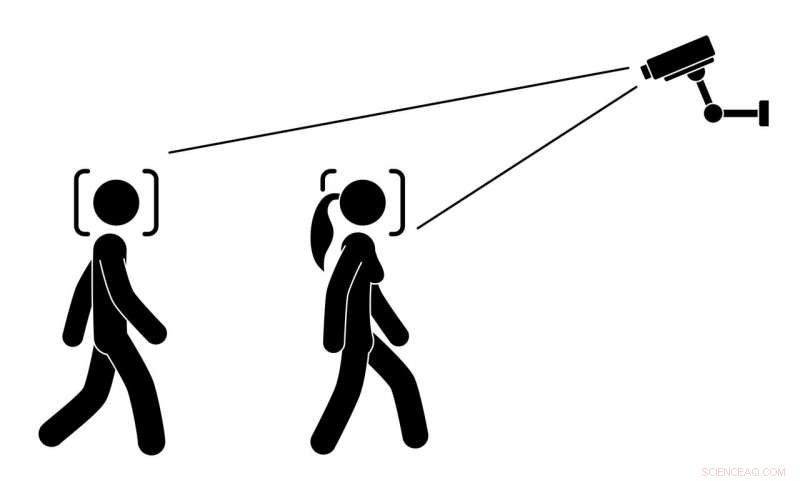

Skal en algoritme forsøge at gætte, hvad køn mennesker er, efter hvordan de ser ud? Kredit:all_is_magic/Shutterstock.com

Forestil dig at gå ned ad gaden og se reklameskærme ændre deres indhold baseret på, hvordan du går, hvordan du taler, eller endda formen på dit bryst. Disse skærme er afhængige af skjulte kameraer, mikrofoner og computere til at gætte, om du er mand eller kvinde. Det lyder måske futuristisk, men lånere i et norsk pizzeria opdagede, at det var præcis, hvad der skete:Kvinder så annoncer for salat, og mænd så annoncer for kødmuligheder. Softwaren, der kører et digitalt reklametavle, spildte bønnerne, da den styrtede ned og viste den underliggende kode. Motivationen bag brugen af denne teknologi kunne have været at forbedre annoncekvaliteten eller brugeroplevelsen. Alligevel, mange kunder blev ubehageligt overrasket over det.

Denne slags situation er ikke bare uhyggelig og invasiv. Det er værre:Bestræbelser på automatisk kønsgenkendelse - ved hjælp af algoritmer til at gætte en persons køn baseret på billeder, video eller lyd - rejser betydelige sociale og etiske bekymringer, som endnu ikke er fuldt udforsket. Den mest aktuelle forskning om automatiske kønsgenkendelsesteknologier fokuserer i stedet på teknologiske detaljer.

Vores nylige forskning viste, at mennesker med forskellig kønsidentitet, herunder dem, der identificerer sig som transseksuelle eller ikke -binære, er især bekymrede over, at disse systemer kan kategorisere dem forkert. Mennesker, der udtrykker deres køn forskelligt fra stereotype mandlige og kvindelige normer, oplever allerede diskrimination og skade som følge af at blive kategoriseret forkert eller misforstået. Ideelt set, teknologidesignere bør udvikle systemer for at gøre disse problemer mindre almindelige, ikke mere.

Brug af algoritmer til at klassificere mennesker

Efterhånden som digitale teknologier bliver mere kraftfulde og sofistikerede, deres designere forsøger at bruge dem til at identificere og kategorisere komplekse menneskelige egenskaber, såsom seksuel orientering, køn og etnicitet. Ideen er, at med nok træning i rigelige brugerdata, algoritmer kan lære at analysere folks udseende og adfærd - og måske en dag karakterisere mennesker såvel som, eller endda bedre end, andre mennesker gør.

Køn er et svært emne for folk at håndtere. Det er et komplekst koncept med vigtige roller både som en kulturel konstruktion og et kerneaspekt af en persons identitet. Forskere, lærde og aktivister afslører i stigende grad de forskellige, flydende og mangefacetterede aspekter af køn. I processen, de finder ud af, at ignorering af denne mangfoldighed kan føre til både skadelige oplevelser og social uretfærdighed. For eksempel, ifølge 2016 National Transgender Survey, 47 procent af transseksuelle deltagere oplyste, at de havde oplevet en eller anden form for forskelsbehandling på deres arbejdsplads på grund af deres kønsidentitet. Mere end halvdelen af transkønnede, der blev chikaneret, overfaldet eller bortvist på grund af deres kønsidentitet havde forsøgt selvmord.

Mange mennesker har, på et eller andet tidspunkt, blevet overrasket, eller forvirret eller endda vred over at finde sig i at være forvekslet med en person af et andet køn. Når det sker for en person, der er transkønnet - som anslået 0,6 procent af amerikanerne, eller 1,4 millioner mennesker, er - det kan forårsage betydelig stress og angst.

Effekter af automatisk kønsgenkendelse

I vores seneste forskning, vi interviewede 13 transkønnede og ikke-konforme mennesker, om deres generelle indtryk af automatisk kønsgenkendelsesteknologi. Vi bad dem også om at beskrive deres svar på imaginære fremtidsscenarier, hvor de måske støder på det. Alle 13 deltagere var bekymrede for denne teknologi og tvivlede på, om det kunne tilbyde deres samfund nogen fordele.

Af særlig bekymring var udsigten til at blive kønsbestemt af den; i deres erfaring, køn er stort set en intern, subjektiv karakteristik, ikke noget, der nødvendigvis eller helt udtrykkes udadtil. Derfor, hverken mennesker eller algoritmer kan nøjagtigt aflæse køn gennem fysiske træk, såsom ansigtet, krop eller stemme.

De beskrev, hvordan det at blive forkert kønsbestemt af algoritmer potentielt kunne føles værre, end hvis mennesker gjorde det. Teknologi opfattes ofte eller menes at være objektiv og upartisk, så at blive forkert kategoriseret af en algoritme ville understrege den misforståelse, at en transkønnet identitet er uautentisk. En deltager beskrev, hvordan de ville føle sig såret, hvis et "millionstykke software udviklet af så mange mennesker" besluttede, at de ikke er, hvem de selv tror, de er.

Fortrolighed og gennemsigtighed

De mennesker, vi interviewede, delte den almindelige offentligheds bekymring for, at automatiserede kameraer kunne bruges til overvågning uden deres samtykke eller viden; årevis, forskere og aktivister har løftet røde flag om stigende trusler mod privatlivets fred i en verden befolket af sensorer og kameraer.

Men vores deltagere beskrev, hvordan virkningerne af disse teknologier kunne være større for transkønnede. For eksempel, de kan blive udpeget som usædvanlige, fordi de ser eller opfører sig anderledes end, hvad de underliggende algoritmer forventer. Nogle deltagere var endda bekymrede for, at systemer fejlagtigt kunne afgøre, at de prøver at være en anden og bedrage systemet.

Deres bekymringer strakte sig også til cisgender, der måske ser ud eller handler anderledes end flertallet, såsom mennesker af forskellige racer, mennesker algoritmerne opfatter som androgyne, og mennesker med unikke ansigtsstrukturer. Dette sker allerede for mennesker fra minoritets racemæssige og etniske baggrunde, som jævnligt fejlagtigt identificeres af ansigtsgenkendelsesteknologi. For eksempel, eksisterende ansigtsgenkendelsesteknologi i nogle kameraer registrerer ikke de asiatiske brugeres ansigter korrekt og sender beskeder, så de holder op med at blinke eller åbner deres øjne.

Vores interviewpersoner ønskede at vide mere om, hvordan automatiske kønsgenkendelsessystemer fungerer, og hvad de bruges til. De ville ikke vide dybe tekniske detaljer, men ønskede at sikre, at teknologien ikke ville kompromittere deres privatliv eller identitet. De ville også have flere transkønnede involveret i de tidlige stadier af design og udvikling af disse systemer, i god tid inden de indsættes.

Oprettelse af inkluderende automatiske systemer

Vores resultater viser, hvordan designere af automatiske kategoriseringsteknologier utilsigtet kan forårsage skade ved at antage antagelser om enkelheden og forudsigeligheden af menneskelige egenskaber. Vores forskning tilføjer en voksende mængde arbejde, der forsøger mere omhyggeligt at inkorporere køn i teknologi.

Minoriteter er historisk blevet udeladt af samtaler om storstilet teknologiudbredelse, herunder etniske minoriteter og mennesker med handicap. Endnu, både forskere og designere ved, at inklusiv input fra minoritetsgrupper under designprocessen kan føre til tekniske innovationer, der gavner alle mennesker. Vi går ind for en mere kønsinkluderende og menneskecentrisk tilgang til automatisering, der inkorporerer forskellige perspektiver.

Efterhånden som digitale teknologier udvikler sig og modnes, de kan føre til imponerende innovationer. Men som mennesker leder det arbejde, de bør undgå at forstærke menneskelige fordomme og fordomme, der er negative og begrænsende. I tilfælde af automatisk kønsgenkendelse, vi konkluderer ikke nødvendigvis, at disse algoritmer bør opgives. Hellere, designere af disse systemer bør omfatte, og følsom over for, mangfoldigheden og kompleksiteten af menneskelig identitet.

Denne artikel blev oprindeligt offentliggjort på The Conversation. Læs den originale artikel.

Sidste artikelKæmper Toshiba vender tilbage til sort, undgår afnotering

Næste artikelSymantec bagatelliserer mystisk intern undersøgelse

Varme artikler

Varme artikler

-

Sådan bliver du en e-sportsstjerne uden at blive professionel, spille spil som Solitaire og Madden …Kredit:CC0 Public Domain Fernando Lewis vidste, at han var god til videospil som Madden NFL og NBA 2K, men han ville have et bedre barometer for sine færdigheder. Han tilmeldte sig nogle turnerin

Sådan bliver du en e-sportsstjerne uden at blive professionel, spille spil som Solitaire og Madden …Kredit:CC0 Public Domain Fernando Lewis vidste, at han var god til videospil som Madden NFL og NBA 2K, men han ville have et bedre barometer for sine færdigheder. Han tilmeldte sig nogle turnerin -

Årsagsforvirring er den næste grænse i AIVed hjælp af algoritmisk informationsteori, KAUST -forskere har udviklet en tilgang til at udlede årsagsprocesserne, der giver anledning til en kompleks observeret interaktion. Kredit:KAUST, Xavier Pi

Årsagsforvirring er den næste grænse i AIVed hjælp af algoritmisk informationsteori, KAUST -forskere har udviklet en tilgang til at udlede årsagsprocesserne, der giver anledning til en kompleks observeret interaktion. Kredit:KAUST, Xavier Pi -

Atlanta forbyder elektriske scootere om natten, efter dødbringende vragEn mand kører på el-scooter torsdag, 8. august, 2019, i Atlanta. Atlanta forbyder elektriske scootere i nattetimerne under en dødbringende sommer for ryttere. I Atlanta, tre ryttere er døde siden maj

Atlanta forbyder elektriske scootere om natten, efter dødbringende vragEn mand kører på el-scooter torsdag, 8. august, 2019, i Atlanta. Atlanta forbyder elektriske scootere i nattetimerne under en dødbringende sommer for ryttere. I Atlanta, tre ryttere er døde siden maj -

Forskere tilbageviser 20 år gamle antagelser i solcelleproduktionMikroskopisk billede af solcelleabsorberen lavet af et korn (sort og hvid) og tilsvarende kemisk analyse, der viser koncentrationen af gallium (orange) og indium (lilla). Kredit:University of Luxemb

Forskere tilbageviser 20 år gamle antagelser i solcelleproduktionMikroskopisk billede af solcelleabsorberen lavet af et korn (sort og hvid) og tilsvarende kemisk analyse, der viser koncentrationen af gallium (orange) og indium (lilla). Kredit:University of Luxemb

- Dodos hemmelige liv, afsløret

- Opnå optimalt samarbejde, når mål er i konflikt

- Fremtiden for kvanteinformationsbehandling:Vridende lys, der skifter retning ved stuetemperatur

- Hvor bliver surt øl så... surt

- Fordele og ulemper ved minedrift med åbne pit

- Californiens milepæl:4 millioner acres brændt i skovbrande