Accenture lancerer nyt værktøj til at hjælpe kunder med at identificere og rette unfair bias i AI-algoritmer

Kredit:CC0 Public Domain

Accenture, en professionel servicevirksomhed, vil snart lancere et nyt værktøj, der har til formål at hjælpe sine kunder med at finde unfair bias i AI-algoritmer. Når en sådan uretfærdig skævhed er opdaget, repræsentanter for virksomheden har fortalt pressen, de kan fjernes.

Mens videnskabsmænd og ingeniører fortsætter med at forbedre AI-teknologi, flere virksomheder bruger AI-baserede værktøjer til at drive forretning. At bruge AI-applikationer til at behandle kreditansøgninger er ved at blive rutine, for eksempel. Men der har været en bekymring for, at sådanne applikationer kan have indbyggede fordomme, som giver resultater, der kan opfattes som uretfærdige. Sådanne applikationer kan evt. for eksempel, har en indbygget racemæssig eller kønsmæssig skævhed, hvilket kan skævvride resultaterne. Som svar på sådanne påstande, mange store virksomheder er begyndt at tilføje bias screeners til deres suite af applikationer. Men som repræsentanter for Accenture har påpeget, mindre virksomheder har sandsynligvis ikke ressourcerne til at gøre det. Det nye værktøj, de har udviklet, vil blive markedsført med disse virksomheder i tankerne.

En prototype af det nye værktøj (som nogle er begyndt at kalde Fairness Tool) er i øjeblikket ved at blive felttestet med en ukendt partner om kreditrisikoapplikationer. Virksomheden har meddelt, at de planlægger en blød lancering i den nærmeste fremtid. De har også annonceret, at værktøjet vil være en del af et større program, der tilbydes af firmaet kaldet AI Launchpad. Ud over AI-værktøjer, programmet omfatter også træning i etik og ansvarlighed for medarbejdere.

For at finde ud af, hvilke slags data, der bruges af en AI-applikation, der kan repræsentere bias, værktøjet bruger statistiske metoder designet til at sammenligne foruddefinerede variabler som fair eller unfair. Den vil også se på andre variabler, der kan indeholde skjult bias. Data, der inkluderer indkomst, for eksempel, kan repræsentere en skjult bias mod kvinder eller minoriteter, selvom der ikke er data, der specificerer køn eller race. Værktøjet kan også bruges til at implementere ændringer i en kundes algoritme, forhåbentlig gør det mindre partisk. Men repræsentanter for Accenture bemærker, at dette har vist sig at forårsage, at nogle algoritmer generelt er mindre nøjagtige.

© 2018 Tech Xplore

Sidste artikelComputerprogram ser fem minutter ud i fremtiden

Næste artikelAT&T antitrust-sejr kan varsle en ny bølge af mediefusioner

Varme artikler

Varme artikler

-

Skulle du være bekymret for, at Google vil klare alle dine pligter?Kredit:CC0 Public Domain Google vil en dag kunne køre bil for dig. Det kan hjælpe dig med at skrive dine e-mails og afslutte dine tanker nu, automatisk. Og nu, i et uhyggeligt syn på fremtiden, de

Skulle du være bekymret for, at Google vil klare alle dine pligter?Kredit:CC0 Public Domain Google vil en dag kunne køre bil for dig. Det kan hjælpe dig med at skrive dine e-mails og afslutte dine tanker nu, automatisk. Og nu, i et uhyggeligt syn på fremtiden, de -

Bayer dropper Monsanto-navn efter megafusion (opdatering)Industrielle kilder sagde, at den fusionerede landbrugskemiske division vil blive kaldt Bayer Crop Science Den tyske kemikalie- og medicinalgigant Bayer vil kassere navnet Monsanto, når den i denn

Bayer dropper Monsanto-navn efter megafusion (opdatering)Industrielle kilder sagde, at den fusionerede landbrugskemiske division vil blive kaldt Bayer Crop Science Den tyske kemikalie- og medicinalgigant Bayer vil kassere navnet Monsanto, når den i denn -

NTSB overvejer teknologi til at undgå ulykker, luk opkaldDenne sammensætning af filbilleder frigivet af National Transportation Safety Board (NTSB) viser Air Canada flyvning 759 (ACA 759), der forsøger at lande i San Francisco International Airport i San Fr

NTSB overvejer teknologi til at undgå ulykker, luk opkaldDenne sammensætning af filbilleder frigivet af National Transportation Safety Board (NTSB) viser Air Canada flyvning 759 (ACA 759), der forsøger at lande i San Francisco International Airport i San Fr -

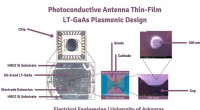

Små antenner viser løfte i forsvarssektorenKredit:University of Arkansas Elektroteknisk forskning i ekstremt små antenner har gjort fremskridt, der kan have stor indflydelse på sikker informationsudveksling, giver USA adgang til et frekven

Små antenner viser løfte i forsvarssektorenKredit:University of Arkansas Elektroteknisk forskning i ekstremt små antenner har gjort fremskridt, der kan have stor indflydelse på sikker informationsudveksling, giver USA adgang til et frekven

- Molekyler kunne skabe små kredsløb på computerchips

- Sådan skriver du en absolutværdi-ligning, der har givet løsninger

- At give indianere i landdistrikterne, hvad de vil, øger efterspørgslen efter komfur

- Undersøgelse af træringe giver flere beviser for poleward migration af tropiske storme

- Kvantedetektiver i jagten på verdens første kvantecomputer

- Ny Monte Carlo-kode til løsning af strålingsoverførselsligninger