Sådan træner du din robot:Forskning giver nye tilgange

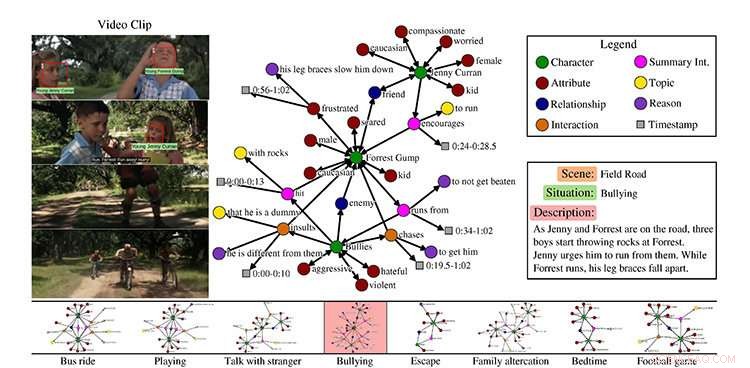

Et eksempel fra MovieGraphs-datasættet, scene fra filmen Forrest Gump. Kredit:University of Toronto

Hvis din ven er ked af det, du kan sige noget for at opmuntre dem. Hvis du beder din kollega om at lave kaffe, de kender trinene til at fuldføre denne opgave.

Men hvordan gør kunstigt intelligente robotter, eller AI'er, lære at opføre sig på samme måde som mennesker gør?

University of Toronto-forskere præsenterer nye tilgange til socialt intelligente AI'er, ved konferencen Computer Vision and Pattern Recognition (CVPR), den førende årlige computer vision -begivenhed i denne uge i Salt Lake City, Utah.

Hvordan træner vi en robot i at opføre sig?

I deres papir MovieGraphs:Towards Understanding Human-Centric Situations from Videos, Paul Vicol, en ph.d. studerende i datalogi, Makarand Tapaswi, en postdoktoral forsker, Lluis Castrejón, en kandidatgraduat fra U of T datalogi, som nu er ph.d. studerende ved University of Montreal Institute for Learning Algorithms, og Sanja Fidler, en assisterende professor ved U of T Mississaugas afdeling for matematiske og beregningsmæssige videnskaber og tri-campus graduate afdeling for datalogi, har samlet et datasæt af kommenterede videoklip fra mere end 50 film.

"MovieGraphs er et skridt i retning af den næste generation af kognitive agenter, der kan ræsonnere om, hvordan mennesker har det og om motivationen for deres adfærd, "siger Vicol." Vores mål er at sætte maskiner i stand til at opføre sig hensigtsmæssigt i sociale situationer. Vores grafer fanger en masse egenskaber på højt niveau i menneskelige situationer, som ikke er blevet udforsket i tidligere arbejde."

Deres datasæt fokuserer på film i dramaet, romantik, og komediegenrer, som Forrest Gump og Titanic, og følger tegn over tid. De inkluderer ikke superheltefilm som Thor, fordi de ikke er særlig repræsentative for den menneskelige oplevelse.

"Idéen var at bruge film som en proxy for den virkelige verden, " siger Vicol.

Hvert klip, han siger, er forbundet med en graf, der fanger rige detaljer om, hvad der sker i klippet:hvilke karakterer er til stede, deres forhold, interaktioner mellem hinanden sammen med årsagerne til, hvorfor de interagerer, og deres følelser.

Vicol forklarer, at datasættet viser, for eksempel, ikke kun at to mennesker skændes, men hvad de skændes om, og grundene til at de skændes, som kommer fra både visuelle signaler og dialog. Teamet skabte deres eget værktøj til at aktivere annotering, hvilket blev udført af en enkelt annotator for hver film.

"Alle klip i en film er kommenteret fortløbende, og hele den graf, der er knyttet til hvert klip, er oprettet af en person, hvilket giver os en sammenhængende struktur i hver graf, og mellem grafer over tid, " han siger.

Med deres datasæt på mere end 7, 500 klip, forskerne introducerer tre opgaver, forklarer Vicol. Den første er videohentning, baseret på, at graferne er funderet i videoerne.

"Så hvis du søger ved at bruge en graf, der siger, at Forrest Gump skændes med en anden, og at karakterernes følelser er triste og vrede, så kan du finde klippet, " han siger.

Det andet er interaktionsbestilling, som henviser til bestemmelse af den mest sandsynlige rækkefølge af karakterinteraktioner. For eksempel, han forklarer, hvis en karakter skulle give en anden karakter en gave, den person, der modtog gaven, ville sige "tak".

"Du ville normalt ikke sige 'tak' ' og derefter modtage en gave. Det er en måde at benchmarke på, om vi fanger semantikken i interaktioner."

Deres sidste opgave er fornuftsforudsigelse baseret på den sociale kontekst.

"Hvis vi fokuserer på én interaktion, kan vi bestemme motivationen bag denne interaktion, og hvorfor den opstod? Så det er i bund og grund at prøve at forudsige, hvornår nogen råber ad en anden, den egentlige sætning, der ville forklare hvorfor, " han siger

Tapaswi siger, at slutmålet er at lære adfærd.

"Forestil dig for eksempel i et klip, maskinen legemliggør grundlæggende Jenny [fra filmen Forrest Gump]. Hvad er en passende handling for Jenny? I en scene, det er for at opmuntre Forrest til at løbe væk fra bøller. Så vi forsøger at få maskiner til at lære passende adfærd."

"passende i den forstand, som film tillader, selvfølgelig."

Skærmbillede:MIT CSAIL/VirtualHome:Simulering af husholdningsaktiviteter via programmer

Hvordan lærer en robot husholdningsopgaver?

Ledet af ledet af Massachusetts Institute of Technology Assistant Professor Antonio Torralba og U of T's Fidler, VirtualHome:Simulering af husholdningsaktiviteter via programmer, træner en virtuel menneskelig agent ved hjælp af naturligt sprog og et virtuelt hjem, så robotten kan lære ikke kun gennem sprog, men ved at se, forklarer U of T masterstuderende i datalogi Jiaman Li, en medvirkende forfatter med U af T Ph.D. studerende i datalogi Wilson Tingwu Wang.

Li forklarer, at handlingen på højt niveau kan være "arbejde på computer", og beskrivelsen inkluderer:at tænde for computeren, sidder foran den, at skrive på tastaturet og tage fat i musen for at rulle.

"Så hvis vi fortæller et menneske denne beskrivelse, 'arbejde på computer, ' mennesket kan udføre disse handlinger ligesom beskrivelserne. Men hvis vi bare fortæller robotter denne beskrivelse, hvordan gør de det præcist? Robotten har ikke denne sunde fornuft. Det kræver meget klare trin, eller programmer."

Fordi der ikke er noget datasæt, der inkluderer al denne viden, hun siger, at forskerne byggede en ved hjælp af en webgrænseflade til at samle programmerne, som angiver handlingsnavnet og beskrivelsen.

"Derefter byggede vi en simulator, så vi har et virtuelt menneske i et virtuelt hjem, der kan udføre disse opgaver, " hun siger.

For hendes del i det igangværende projekt, Li bruger deep learning – en gren af maskinlæring, der træner computere til at lære – til automatisk at generere programmer fra tekst eller video til disse programmer.

Imidlertid, det er ingen nem opgave at udføre hver handling i simulatoren, siger Li, da datasættet resulterede i mere end 5, 000 programmer.

"At simulere alt, hvad man gør i et hjem, er ekstremt svært, og vi tager et skridt i retning af dette ved at implementere de hyppigste atomaktioner såsom gang, sidde, og hente, «siger Fidler.

"Vi håber, at vores simulator vil blive brugt til at træne robotters komplekse opgaver i et virtuelt miljø, før du går videre til den virkelige verden."

MovieGraphs blev delvist understøttet af Natural Sciences and Engineering Research Council of Canada (NSERC), og VirtualHome understøttes delvist af NSERC Computing Hardware for Emerging Intelligent Sensing Applications (COHESA) Network.

Varme artikler

Varme artikler

-

Atomaffald kunne genanvendes til diamantbatteriStrukturen af grafitblokke i en atomreaktor. Kredit:EDF Energy Et team af fysikere og kemikere fra University of Bristol håber at genbruge radioaktivt materiale direkte fra et tidligere atomkraf

Atomaffald kunne genanvendes til diamantbatteriStrukturen af grafitblokke i en atomreaktor. Kredit:EDF Energy Et team af fysikere og kemikere fra University of Bristol håber at genbruge radioaktivt materiale direkte fra et tidligere atomkraf -

Søger efter mangfoldighed i Silicon Valley tech -virksomheder - og finder nogleKredit:Samtalen Silicon Valley -teknologivirksomheder har haft alvorlige problemer med den demografiske mangfoldighed, herunder beskyldninger om fjendtligt klima over for kvinder og minoritetsmeda

Søger efter mangfoldighed i Silicon Valley tech -virksomheder - og finder nogleKredit:Samtalen Silicon Valley -teknologivirksomheder har haft alvorlige problemer med den demografiske mangfoldighed, herunder beskyldninger om fjendtligt klima over for kvinder og minoritetsmeda -

Google-annoncer:effektiv, lidt frustrerende, siger virksomhederI denne tirsdag, 17. september, 2019 foto, Gabe Uribe, medejer af L.A. Tech House, et PR-firma, der fokuserer på teknologivirksomheder, poserer på sit kontor i Beverly Hills, Californien. Da han begyn

Google-annoncer:effektiv, lidt frustrerende, siger virksomhederI denne tirsdag, 17. september, 2019 foto, Gabe Uribe, medejer af L.A. Tech House, et PR-firma, der fokuserer på teknologivirksomheder, poserer på sit kontor i Beverly Hills, Californien. Da han begyn -

Retten dømmer kaution for Nissan-direktøren i forbindelse med Ghosn-sagenTokyo District Court sagde, at den havde godkendt en anmodning fra advokater for Greg Kelly og sat kaution for hans løsladelse til 70 millioner yen ($635, 000) En domstol i Tokyo har tirsdag givet

Retten dømmer kaution for Nissan-direktøren i forbindelse med Ghosn-sagenTokyo District Court sagde, at den havde godkendt en anmodning fra advokater for Greg Kelly og sat kaution for hans løsladelse til 70 millioner yen ($635, 000) En domstol i Tokyo har tirsdag givet

- Forskere afslører, at amerikanske majsafgrøder vokser følsomme over for tørke

- Bakterier bruges til at rense dieselforurenet jord i Grønland

- Ældste menneskelige spor fra det sydlige tibetanske plateau i et nyt lys

- Når rødglødende smartphone-marked ser en køligere tendens

- Hummer gør comeback, men denne gang er det elektrisk

- At forme atomisk tynde materialer i suspenderede strukturer