Forskere forbedrer deep learning-metoden til neurale netværk

AI vil tjene til at udvikle et netværkskontrolsystem, der ikke kun registrerer og reagerer på problemer, men også kan forudsige og undgå dem. Kredit:CC0 Public Domain

Forskere fra Institute of Cyber Intelligence Systems ved National Research Nuclear University MEPhI (Rusland) har for nylig udviklet en ny læringsmodel for den begrænsede Boltzmann-maskine (et neuralt netværk), som optimerer processerne for semantisk kodning, visualisering og datagenkendelse. Resultaterne af denne forskning er offentliggjort i tidsskriftet Optisk hukommelse og neurale netværk .

I dag, dybe neurale netværk med forskellige arkitekturer, såsom foldning, tilbagevendende og autoencoder netværk, bliver et stadig mere populært forskningsområde. En række højteknologiske virksomheder, inklusive Microsoft og Google, bruger dybe neurale netværk til at designe intelligente systemer.

I deep learning-systemer, processerne for valg af funktioner og konfiguration er automatiserede, hvilket betyder, at netværkene på egen hånd kan vælge mellem de mest effektive algoritmer til hierarkisk feature-ekstraktion. Deep learning er kendetegnet ved læring ved hjælp af store samples ved hjælp af en enkelt optimeringsalgoritme. Typiske optimeringsalgoritmer konfigurerer parametrene for alle operationer samtidigt, og effektivt estimere hver neurale netværksparameters effekt på fejl ved hjælp af den såkaldte backpropagation-metode.

"De neurale netværks evne til at lære på egen hånd er en af deres mest spændende egenskaber, " forklarede Vladimir Golovko, professor ved MEPhI Institute of Cyber Intelligence Systems. "Ligesom biologiske systemer, neurale netværk kan modellere sig selv, søger at udvikle den bedst mulige adfærdsmodel."

I 2006 sfæren for neurale netværkstræning fik et gennembrud, da Geoffrey Hinton offentliggjorde en forskningsartikel om før-træning af neurale netværk. Han udtalte, at flerlags neurale netværk kunne fortrænes ved at træne et lag ad gangen ved hjælp af den begrænsede Boltzmann-maskine og derefter finjustere dem ved hjælp af backpropagation. Disse netværk blev kaldt dybe trosnetværk, eller DBN.

Golovko analyserede de vigtigste problemer og paradigmer ved dyb maskinlæring og foreslog en ny indlæringsmetode til den begrænsede Boltzmann-maskine. Forskeren viste, at den klassiske regel om at træne dette neurale netværk er et særligt tilfælde af den metode, han udviklede.

"De amerikanske videnskabsmænd Minsky og Papert viste engang, at ud fra et mønsterklassificeringssynspunkt, enkeltlagsperceptronen med tærskelaktiveringsfunktionen danner en lineær adskillende overflade, hvilket er grunden til, at det ikke kan løse "eksklusive eller"-problemet, " Golovko bemærkede. "Dette førte til pessimistiske konklusioner om den videre udvikling af neurale netværk. Imidlertid, det sidste udsagn er kun sandt for en enkeltlagsperceptron med en tærskelværdi eller en monoton kontinuerlig aktiveringsfunktion, for eksempel, en sigmoid funktion. Når man bruger signalaktiveringsfunktionen, enkeltlagsperceptronen kan løse "eksklusive eller"-problemet, da den kan opdele arealet af enere og nuller i klasser ved hjælp af to lige linjer."

Forskningen involverede også en analyse af mulighederne for at bruge dybe neurale netværk til kompression, visualisering og genkendelse af data. I øvrigt, Golovko foreslog også en ny tilgang til implementering af semantisk kodning, eller hashing, som er baseret på brugen af dybe auto-associative neurale netværk.

Denne dybe læringsmetode kan være meget nyttig til at træne søgemaskinernes neurale netværk, forfatteren udtaler, da det vil forbedre hastigheden for at søge efter relevante billeder.

Disse resultater har stor praktisk værdi:de har allerede fundet anvendelse inden for computersyn, talegenkendelse og bioinformatik.

Varme artikler

Varme artikler

-

AI -reklamer spiller med skræmmende musik, mange kostumeidéer som en del af HalloweenKredit:Matt Reed Åh, boo og eek af det hele. Kunstig intelligens er ved hovedbordet takket være teknologiske kreatører, der ønsker at gøre Halloween 2018 ret specielt. AI frigives til Halloween-c

AI -reklamer spiller med skræmmende musik, mange kostumeidéer som en del af HalloweenKredit:Matt Reed Åh, boo og eek af det hele. Kunstig intelligens er ved hovedbordet takket være teknologiske kreatører, der ønsker at gøre Halloween 2018 ret specielt. AI frigives til Halloween-c -

Kina CATL bygger første EU -elbilbatteri i TysklandBMW skal købe batterier til en værdi af næsten $ 5 milliarder fra CATL Det kinesiske firma CATL vil bygge en batterifabrik i det centrale Tyskland for at levere landets vigtigste bilindustri i sin

Kina CATL bygger første EU -elbilbatteri i TysklandBMW skal købe batterier til en værdi af næsten $ 5 milliarder fra CATL Det kinesiske firma CATL vil bygge en batterifabrik i det centrale Tyskland for at levere landets vigtigste bilindustri i sin -

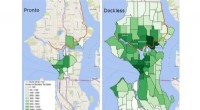

Hvordan cykeldeling i Seattle rejste sig fra asken efter Prontos fiaskoForskere fra University of Washington fandt ud af, at Pronto-cykler ikke altid var i områder, som folk ville hen. Dette kort over Seattle-kvarterer viser antallet af startpunkter for Pronto (venstre)

Hvordan cykeldeling i Seattle rejste sig fra asken efter Prontos fiaskoForskere fra University of Washington fandt ud af, at Pronto-cykler ikke altid var i områder, som folk ville hen. Dette kort over Seattle-kvarterer viser antallet af startpunkter for Pronto (venstre) -

Avolon annullerer ordre på 75 Boeing 737 MAX-flyDet irske flyleasingselskab Avolon sagde, at det annullerer en ordre på 75 737 MAX-fly på grund af den massive forværring af rejser forårsaget af COVID-19-pandemien Det irske flyleasingselskab Avo

Avolon annullerer ordre på 75 Boeing 737 MAX-flyDet irske flyleasingselskab Avolon sagde, at det annullerer en ordre på 75 737 MAX-fly på grund af den massive forværring af rejser forårsaget af COVID-19-pandemien Det irske flyleasingselskab Avo

- Forskere udvikler alsidige optomekaniske sensorer til atomkraftmikroskopi

- Interessante fakta om Beaches

- En stor asteroide nok til at ødelægge en netop savnet jord

- Hvordan vil vandkraft se ud i fremtiden?

- Når et flylandingssystem bringes ind i spoofing-zonen

- Ny ikke-destruktiv optisk teknik afslører strukturen af perlemor