End-to-end læring af generering af co-tale gestus til humanoide robotter

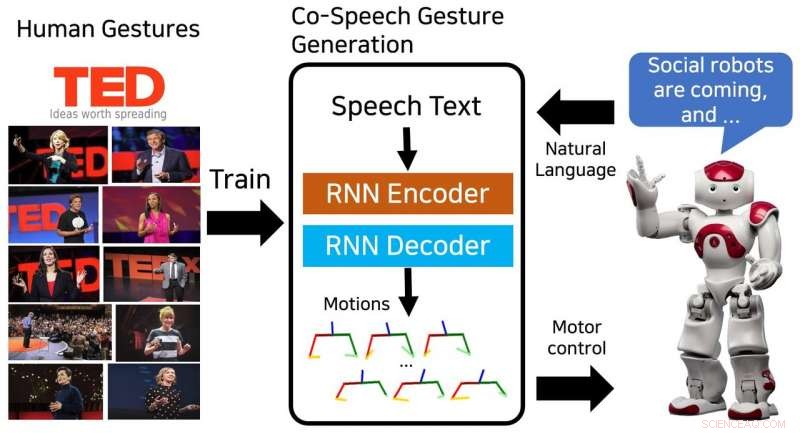

Den foreslåede model genererer en sekvens af overkropsstillinger og er trænet på menneskelige gestus fra TED-foredrag. Kredit:Yoon et al.

Forskere ved Electronics and Telecommunications Research Institute (ETRI) i Sydkorea har for nylig udviklet en neural netværksmodel, der kan generere sekvenser af co-tale gestus. Deres model, trænet i 52 timers TED-foredrag, med succes produceret menneskelignende bevægelser, der matchede taleindhold.

"Smart-enheder, vi interagerer med, har udviklet sig fra personlige computere til mobiltelefoner og smarte højttalere, "Youngwoo Yoon, en af de forskere, der har udført undersøgelsen, fortalte TechXplore. "Vi tror, at sociale robotter kunne være den næste interaktionsplatform. Fysisk bevægelse er en af de vigtigste forskelle mellem sociale robotter og andre smarte enheder, åbner nye muligheder for at efterligne menneske- eller dyrelignende adfærd, som kan øge intimiteten."

Samtalebevægelser kunne i høj grad forbedre kvaliteten af interaktioner mellem mennesker og sociale robotter. De fleste eksisterende robotter producerer bevægelser ved hjælp af regelbaserede tale-gestik-tilknytningsmetoder. Imidlertid, disse teknikker kræver en betydelig indsats, da de er baseret på menneskelig ekspertise og viden.

"Vi ønskede at skabe naturlig og menneskelignende social adfærd, især håndbevægelser, mens du taler, " sagde Yoon. "At observere andre er en meget naturlig måde at lære en ny adfærd på, så vi foreslog en læringsbaseret gestusgenereringsmodel, der blev trænet på et datasæt af TED-foredrag."

Modellen udviklet af Yoon og hans kolleger blev trænet på et datasæt indeholdende 52 timers videooptagelser fra TED-foredrag. Efter træning, modellen kunne generere sekvenser af menneskelignende bevægelser og overkroppspositurer for at matche skrevet taletekst.

"Det er svært og tidskrævende at designe robotters sociale adfærd, fordi vi skal overveje sammenhænge, naturlighed, bevægelsens æstetik, robotternes kontrolrum, og en række andre faktorer, " Yoon forklarede. "Nylige end-to-end læringsstudier har kastet lys over potentialet af kunstig intelligens til at generere så kompleks adfærd. Efter at have set succesfulde applikationer inden for autonom kørsel og generering af ansigtsbevægelser, vi besluttede at anvende ende-til-ende-læring til generering af co-tale gestus."

Den neurale netværksmodel udviklet af Yoon og hans kolleger genererede med succes flere typer bevægelser, herunder ikoniske, metaforisk, deiktisk, og slå bevægelser. I øvrigt, det var i stand til at generere kontinuerlige sekvenser af gestus til taletekster af enhver længde.

Forskerne fandt ud af, at deres metode overgik baseline-metoderne ved at skabe gestus, der ligner menneskers. I en subjektiv vurdering, 46 personer, der blev rekrutteret på Amazon Mechanical Turk, mente, at de bevægelser, det genererede, var menneskelignende og passede nøje til talens indhold.

"Vi fandt ud af, at robotter kan lære sociale færdigheder, " sagde Yoon. "For generationen af fællestalebevægelser, modellen trænet på det store datasæt er generel nok, så robotten kan lave menneskelignende bevægelser til enhver tale. Vi tror, at denne tilgang kan anvendes på andre sociale færdigheder, såvel som til karakterer i videospil og VR-verdener."

Undersøgelsen udført af Yoon og hans kolleger fremhævede potentialet ved ende-til-ende-læring til generering af fællestalebevægelser. I fremtiden, det kunne bruges til at forbedre menneske-robot-interaktioner og kunne også inspirere til lignende forskning, da det TED talks-datasæt, de brugte, er offentligt tilgængeligt. Forskerne planlægger nu at tage deres undersøgelse et skridt fremad, ved at generere personlige gestus til forskellige robotter.

"Robotter kan have deres egen personlighed, som mennesker, " sagde Yoon. "En personlig gestusgenereringsmetode kunne sikre, at forskellige robotter udtrykker sig med forskellige stilarter af gestus, efter deres personlighed."

© 2018 Science X Network

Varme artikler

Varme artikler

-

Apple buster Facebook for at distribuere datasugende appDenne 19. feb. 2014, filbillede viser Facebook-app-ikonet på en iPhone i New York. Apple siger, at det har forbudt en Facebook-fremstillet app, der betalte brugere, herunder teenagere, til omfattende

Apple buster Facebook for at distribuere datasugende appDenne 19. feb. 2014, filbillede viser Facebook-app-ikonet på en iPhone i New York. Apple siger, at det har forbudt en Facebook-fremstillet app, der betalte brugere, herunder teenagere, til omfattende -

Google Assistant er nu i 5, 000 smart-home-enhederKredit:CC0 Public Domain Hvad angår Google, der er intet sted som hjemme. Forud for I/O -udviklerkonferencen i næste uge, Google meddelte, at dens kunstig intelligens-fusionerede Google Assistant

Google Assistant er nu i 5, 000 smart-home-enhederKredit:CC0 Public Domain Hvad angår Google, der er intet sted som hjemme. Forud for I/O -udviklerkonferencen i næste uge, Google meddelte, at dens kunstig intelligens-fusionerede Google Assistant -

5G trådløs race varmer opDe første kommercielle 5G-udrulninger begynder i år og næste gang i USA, Korea og Japan Kapløbet om at bringe superhurtige 5G trådløse tjenester på markedet er ved at blive varmere med de første k

5G trådløs race varmer opDe første kommercielle 5G-udrulninger begynder i år og næste gang i USA, Korea og Japan Kapløbet om at bringe superhurtige 5G trådløse tjenester på markedet er ved at blive varmere med de første k -

Sådan finder og sletter du, hvor Google ved, du har væretI denne 25. juli, 2018 foto, Kalyanaraman Shankari, ret, og hendes mand Thomas Raffill holder deres telefoner, mens de poserer til billeder i Mountain View, Californien En Associated Press-undersøgels

Sådan finder og sletter du, hvor Google ved, du har væretI denne 25. juli, 2018 foto, Kalyanaraman Shankari, ret, og hendes mand Thomas Raffill holder deres telefoner, mens de poserer til billeder i Mountain View, Californien En Associated Press-undersøgels

- Ny undersøgelse viser, at risikoen for oversvømmelser for amerikanere er stærkt undervurderet

- Mellem relativistiske og klassiske bølgeregimer, nyopdaget hukommelseseffekt ændrer Doppler -bølg…

- Næsten en femtedel af Jordens overflade transformeret siden 1960

- Sådan beregnes længden af DNA-fragmenter

- Hvordan tæller man dødsfald fra en orkan?

- Køkkenforstyrrelser:bedre mad gennem kunstig intelligens