Ny teknik til maskinlæring til simulering af hverdags klædningsopgave

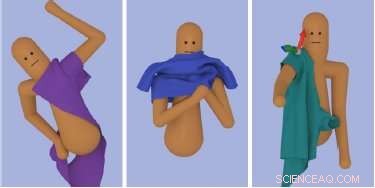

Computerforskere fra Georgia Institute of Technology og Google Brain, Googles forskningsarm for kunstig intelligens, har udtænkt en ny beregningsmetode, drevet af maskinlæringsteknikker, med succes og realistisk at simulere processen i flere trin med at tage tøj på. Kredit:SIGGRAPH Asia

At tage tøj på er en daglig, dagligdags opgave, som de fleste af os udfører med lidt eller ingen tanke. Vi tager muligvis aldrig de mange trin og fysiske bevægelser i betragtning, når vi klæder os om morgenen. Men det er netop det, der skal undersøges, når man forsøger at fange bevægelsen ved påklædning og simulering af klud til computeranimation.

Computerforskere fra Georgia Institute of Technology og Google Brain, Googles forskningsarm for kunstig intelligens, har udtænkt en ny beregningsmetode, drevet af maskinlæringsteknikker, med succes og realistisk at simulere processen i flere trin med at tage tøj på. Ved dissektion, opgaven med påklædning er ret kompleks, og involverer flere forskellige fysiske interaktioner mellem karakteren og hans eller hendes tøj, primært styret af personens følesans.

Oprettelse af en animation af en karakter, der tager tøj på, er udfordrende på grund af de komplekse interaktioner mellem karakteren og den simulerede beklædningsgenstand. De fleste arbejder i meget begrænset karakteranimation omhandler statiske miljøer, der ikke reagerer særlig meget på karakterens bevægelse, bemærker forskerne. I modsætning, tøj kan reagere øjeblikkeligt og drastisk på små ændringer i kroppens position; tøj har en tendens til at folde, holde fast og klamre sig til kroppen, gør haptic, eller berøringsfornemmelse, afgørende for opgaven.

En anden unik udfordring ved påklædning er, at det kræver, at karakteren udfører en lang række bevægelser, der involverer et mangfoldigt sæt underopgaver, såsom at gribe det forreste lag af en skjorte, stikke en hånd ind i skjorteåbningen og skubbe en hånd gennem et ærme.

"Påklædning virker let for mange af os, fordi vi øver det hver eneste dag. I virkeligheden kludens dynamik gør det meget udfordrende at lære at klæde sig fra bunden, "siger Alexander Clegg, hovedforfatter af forskningen og en datalogi ph.d. studerende ved Georgia Institute of Technology. "Vi udnytter simulering til at lære et neuralt netværk at udføre disse komplekse opgaver ved at opdele opgaven i mindre stykker med veldefinerede mål, giver karakteren mulighed for at prøve opgaven tusinder af gange og levere belønnings- eller strafsignaler, når karakteren forsøger gavnlige eller skadelige ændringer i sin politik. "

Forskernes metode opdaterer derefter det neurale netværk et trin ad gangen for at gøre de opdagede positive ændringer mere tilbøjelige til at forekomme i fremtiden. "På denne måde, vi lærer karakteren, hvordan man lykkes med opgaven, "bemærker Clegg.

Clegg og hans samarbejdspartnere hos Georgia Tech omfatter computerforskere Wenhao Yu, Greg Turk og Karen Liu. Sammen med Google Brainforsker Jie Tan, gruppen præsenterer deres arbejde på SIGGRAPH Asia 2018 i Tokyo 4. december til 7. december. Den årlige konference byder på de mest respekterede tekniske og kreative medlemmer inden for computergrafik og interaktive teknikker, og viser førende forskning inden for videnskab, kunst, spil og animation, blandt andre sektorer.

I dette studie, forskerne demonstrerede deres tilgang til flere påklædningsopgaver:at tage en t-shirt på, smide på en jakke og robot-assisteret påklædning af et ærme. Med det uddannede neurale netværk, de var i stand til at opnå kompleks reenactment på forskellige måder, en animeret karakter tager tøj på. Nøglen er at inkorporere følesansen i deres rammer for at overvinde udfordringerne i kludssimulering. Forskerne fandt ud af, at omhyggeligt valg af kludobservationer og belønningsfunktionerne i deres uddannede netværk er afgørende for rammens succes. Som resultat, denne nye tilgang muliggør ikke kun enkelt forbindingssekvenser, men en karaktercontroller, der med succes kan klæde sig på under forskellige forhold.

"Vi har åbnet døren til en ny måde at animere multi-step interaktionsopgaver i komplekse miljøer ved hjælp af forstærkningslæring, "siger Clegg." Der er stadig masser af arbejde, der skal udføres på denne vej, giver simulering mulighed for at give erfaring og praksis til opgavetræning i en virtuel verden. "Ved at udvide dette arbejde, teamet samarbejder i øjeblikket med andre forskere i Georgia Techs Healthcare Robotics -laboratorium for at undersøge anvendelsen af robotik til påklædningshjælp.

Varme artikler

Varme artikler

-

Frankrig anklager Google for at forfalske EU's lov om ophavsret, der skal hjælpe nyhedsudgivereFrankrig har anklaget den amerikanske internetgigant Google for at ignorere ånden og brevet i en europæisk lov om ophavsret, der har til formål at give udgivere et større snit af den økonomiske fordel

Frankrig anklager Google for at forfalske EU's lov om ophavsret, der skal hjælpe nyhedsudgivereFrankrig har anklaget den amerikanske internetgigant Google for at ignorere ånden og brevet i en europæisk lov om ophavsret, der har til formål at give udgivere et større snit af den økonomiske fordel -

En 3-D printer, der kan udskrive datasæt som fysiske objekterKredit: Videnskabens fremskridt (2018). DOI:10.1126/sciadv.aas8652 Et team af forskere fra MIT og Harvard University har fundet på en måde at få 3-D-printere til at udskrive objekter ved hjælp af

En 3-D printer, der kan udskrive datasæt som fysiske objekterKredit: Videnskabens fremskridt (2018). DOI:10.1126/sciadv.aas8652 Et team af forskere fra MIT og Harvard University har fundet på en måde at få 3-D-printere til at udskrive objekter ved hjælp af -

Lufthansa-aktien dykker efter overskudsadvarselLufthansas aktier faldt efter en overskudsadvarsel fra flyselskabet Aktierne i den tyske flyselskab Lufthansa faldt mere end 12 procent mandag, efter at koncernen udsendte en overskudsadvarsel. V

Lufthansa-aktien dykker efter overskudsadvarselLufthansas aktier faldt efter en overskudsadvarsel fra flyselskabet Aktierne i den tyske flyselskab Lufthansa faldt mere end 12 procent mandag, efter at koncernen udsendte en overskudsadvarsel. V -

Comcast udfordrer Murdoch med et konkurrerende bud på Sky i StorbritannienI denne 12. oktober, 2017, fil foto en fodgænger går ved et Comcast servicecenter, i Miami. Comcast Corp. rapporterer indtjening onsdag, 25. april kl. 2018. (AP Photo/Alan Diaz, Fil) Den amerikans

Comcast udfordrer Murdoch med et konkurrerende bud på Sky i StorbritannienI denne 12. oktober, 2017, fil foto en fodgænger går ved et Comcast servicecenter, i Miami. Comcast Corp. rapporterer indtjening onsdag, 25. april kl. 2018. (AP Photo/Alan Diaz, Fil) Den amerikans

- Sådan beregnes diameter til firkantet føde

- Tencent-investering i Reddit vækker bekymring for censur

- Nyt bevis til støtte for Planet Nine -hypotesen

- De Broglie Bølgelængde: Definition, ligning og hvordan man beregner

- United Technologies bryder ind i 3 uafhængige virksomheder

- RNA Mutation Vs. DNA Mutation