At lære at undervise for at fremskynde læringen

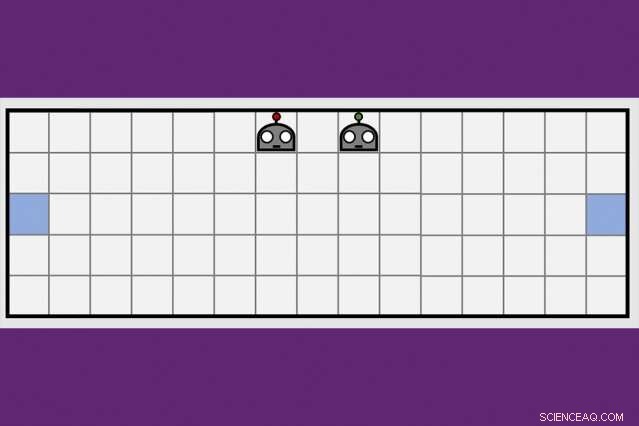

Ved at bruge en ny kooperativ læringsteknik, MIT-IBM Watson AI Lab-forskere reducerede med halvdelen af den tid, det tog et par robotagenter at lære at manøvrere til modsatte sider af et virtuelt rum. Kredit:Dong-ki Kim

De første programmer med kunstig intelligens til at besejre verdens bedste spillere i skak og spillet Go modtog i det mindste noget instruktion af mennesker, og i sidste ende, ville vise sig ikke at matche en ny generation af AI-programmer, der lærer helt på egen hånd, gennem forsøg og fejl.

En kombination af dyb læring og forstærkende læringsalgoritmer er ansvarlige for, at computere opnår dominans i udfordrende brætspil som skak og Go, et stigende antal videospil, herunder ms. Pac-Man, og nogle kortspil, inklusive poker. Men for alle fremskridt, computere sidder stadig fast, jo tættere et spil ligner det virkelige liv, med skjult information, flere spillere, kontinuerlig spil, og en blanding af kort- og langsigtede belønninger, der gør computing til det optimale træk håbløst komplekst.

For at komme forbi disse forhindringer, AI-forskere udforsker komplementære teknikker til at hjælpe robotagenter med at lære, modelleret efter den måde, mennesker opfanger ny information ikke kun på egen hånd, men fra mennesker omkring os, og fra aviser, bøger, og andre medier. En strategi for kollektiv læring udviklet af MIT-IBM Watson AI Lab tilbyder en lovende ny retning. Forskere viser, at et par robotagenter kan reducere den tid, det tager at lære en simpel navigationsopgave, med 50 procent eller mere, når agenterne lærer at udnytte hinandens voksende viden.

Algoritmen lærer agenterne, hvornår de skal bede om hjælp, og hvordan man kan skræddersy deres råd til det, der er blevet lært indtil da. Algoritmen er unik ved, at ingen af agenterne er eksperter; hver er fri til at fungere som elev-lærer for at anmode om og tilbyde mere information. Forskerne præsenterer deres arbejde i denne uge på AAAI Conference on Artificial Intelligence på Hawaii.

Medforfattere på papiret, som modtog en hæderlig omtale for bedste studenteropgave på AAAI, er Jonathan How, en professor i MIT's Department of Aeronautics and Astronautics; Shayegan Omidshafiei, en tidligere MIT kandidatstuderende nu på Alphabet's DeepMind; Dong-ki Kim fra MIT; Miao Liu, Gerald Tesauro, Matthew Riemer, og Murray Campbell fra IBM; og Christopher Amato fra Northeastern University.

"Denne idé om at levere handlinger til mest muligt at forbedre elevens læring, i stedet for bare at fortælle den, hvad den skal gøre, er potentielt ret kraftig, " siger Matthew E. Taylor, en forskningsdirektør hos Borealis AI, forskningsafdelingen af Royal Bank of Canada, som ikke var involveret i undersøgelsen. "Mens avisen fokuserer på relativt simple scenarier, Jeg tror, at elev/lærer-rammen kunne skaleres op og være nyttig i multi-player videospil som Dota 2, robot fodbold, eller scenarier for genopretning efter katastrofe."

For nu, de professionelle har stadig fordelen i Dota2, og andre virtuelle spil, der favoriserer teamwork og hurtige, strategisk tænkning. (Selvom Alphabets AI-forskningsarm, DeepMind, for nylig lavet nyheder efter at have besejret en professionel spiller i real-time strategispil, Starcraft.) Men efterhånden som maskiner bliver bedre til at manøvrere dynamiske miljøer, de kan snart være klar til opgaver i den virkelige verden som at styre trafikken i en storby eller koordinere eftersøgnings- og redningshold på jorden og i luften.

"Maskiner mangler den sunde fornuft, vi udvikler som børn, " siger Liu, en tidligere MIT postdoc nu på MIT-IBM laboratoriet. "Det er derfor, de skal se millioner af videoframes, og bruge en masse regnetid, lære at spille et spil godt. Selv da, de mangler effektive måder at overføre deres viden til teamet på, eller generalisere deres færdigheder til et nyt spil. Hvis vi kan træne robotter til at lære af andre, og generalisere deres læring til andre opgaver, vi kan begynde bedre at koordinere deres interaktioner med hinanden, og med mennesker."

MIT-IBM-teamets nøgleindsigt var, at et team, der deler sig og erobrer for at lære en ny opgave – i dette tilfælde, at manøvrere til modsatte ender af et rum og røre ved væggen på samme tid - vil lære hurtigere.

Deres undervisningsalgoritme veksler mellem to faser. Først og fremmest, både elev og lærer beslutter for hvert trin, om de vil bede om, eller give, råd baseret på deres tillid til, at det næste skridt, eller de råd, de er ved at give, vil bringe dem tættere på deres mål. Dermed, eleven spørger kun om råd, og læreren giver det kun, når de tilføjede oplysninger sandsynligvis vil forbedre deres ydeevne. Med hvert trin, agenterne opdaterer deres respektive opgavepolitikker, og processen fortsætter, indtil de når deres mål eller løber tør for tid.

Med hver iteration, algoritmen registrerer elevens beslutninger, lærerens råd, og deres indlæringsfremskridt målt ved spillets endelige score. I anden fase, en dyb forstærkende læringsteknik bruger de tidligere registrerede undervisningsdata til at opdatere begge rådgivningspolitikker. "Med hver opdatering bliver læreren bedre til at give de rigtige råd på det rigtige tidspunkt, siger Kim, en kandidatstuderende ved MIT.

I et opfølgningspapir, der skal diskuteres i en workshop på AAAI, forskerne forbedrer algoritmens evne til at spore, hvor godt agenterne lærer den underliggende opgave – i dette tilfælde, en bokspressende opgave - at forbedre agenternes evne til at give og modtage rådgivning. Det er endnu et skridt, der bringer holdet tættere på dets langsigtede mål om at deltage i RoboCup, en årlig robotkonkurrence startet af akademiske AI-forskere.

"Vi bliver nødt til at skalere til 11 agenter, før vi kan spille en omgang fodbold, " siger Tesauro, en IBM-forsker, der udviklede det første AI-program til at mestre spillet backgammon. "Det kommer til at kræve noget mere arbejde, men vi er håbefulde."

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Boeing rapporterer endnu et stort fald i leverancerne i 3QBoeing leverede kun 63 kommercielle fly i forhold til 190 for et år siden, på grund af jordforbindelsen af dets topsælgende 737 MAX, som fortsat buler resultaterne Boeing rapporterede tirsdag en

Boeing rapporterer endnu et stort fald i leverancerne i 3QBoeing leverede kun 63 kommercielle fly i forhold til 190 for et år siden, på grund af jordforbindelsen af dets topsælgende 737 MAX, som fortsat buler resultaterne Boeing rapporterede tirsdag en -

Ghosn holdt $260, 000 Rio-fest faktureret til Renault-Nissan, dokumenter viserCarlos Ghosn inviterede adskillige gæster til en karnevalsfest i Rio de Janeiro i 2018, som blev betalt af den Renault-Nissan-alliance, han førte i spidsen. Den tidligere Renault- og Nissan-chef C

Ghosn holdt $260, 000 Rio-fest faktureret til Renault-Nissan, dokumenter viserCarlos Ghosn inviterede adskillige gæster til en karnevalsfest i Rio de Janeiro i 2018, som blev betalt af den Renault-Nissan-alliance, han førte i spidsen. Den tidligere Renault- og Nissan-chef C -

GM kæmper mod regeringen for at beholde skattefradrag for elbilerGeneral Motors CEO Mary Barra taler til journalister efter et møde med senator Sherrod Brown, D-Ohio, og senator Rob Portman, R-Ohio, for at diskutere GMs meddelelse, at den ville stoppe med at fremst

GM kæmper mod regeringen for at beholde skattefradrag for elbilerGeneral Motors CEO Mary Barra taler til journalister efter et møde med senator Sherrod Brown, D-Ohio, og senator Rob Portman, R-Ohio, for at diskutere GMs meddelelse, at den ville stoppe med at fremst -

Airbnb, Ubers problemer viser, at Japan ikke deler letMens madleveringstjenesten UberEATS har været et hit i Tokyo siden ankomsten i 2016, Japans deleøkonomi er en brøkdel af størrelsen af markeder i Europa, USA og Kina Tusindvis af Airbnb-reservat

Airbnb, Ubers problemer viser, at Japan ikke deler letMens madleveringstjenesten UberEATS har været et hit i Tokyo siden ankomsten i 2016, Japans deleøkonomi er en brøkdel af størrelsen af markeder i Europa, USA og Kina Tusindvis af Airbnb-reservat

- Sådan beregnes frysepunktet og kogepunktet

- Optrævling af en væsentlig årsag til havisens tilbagetrækning i det arktiske hav

- Hvad tidevandet svarer til en solformørkelse?

- Sådan finder du bredden af et rektangulært prisme

- Hvad er nogle af de kræfter, der ændrer landformer?

- Asteroid orus okkultation observeret for første gang nogensinde af eVscope