Effektiv kontradiktorisk robusthedsevaluering af AI-modeller med begrænset adgang

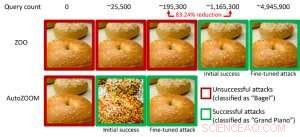

Figur 1:Præstationssammenligning ved at omdanne et bagelbillede til et modstridende bagelbillede klassificeret som et "flygel" ved hjælp af ZOO- og AutoZOOM-angreb. Kredit:IBM

Nylige undersøgelser har identificeret manglen på robusthed i nuværende AI-modeller over for modstridende eksempler - bevidst manipulerede forudsigelsesundvigende datainput, der ligner normale data, men vil få veltrænede AI-modeller til at opføre sig forkert. For eksempel, visuelt umærkelige forstyrrelser til et stopskilt kan nemt fremstilles og føre en højpræcision AI-model i retning af fejlklassificering. I vores tidligere papir offentliggjort på European Conference on Computer Vision (ECCV) i 2018, vi validerede, at 18 forskellige klassifikationsmodeller blev trænet på ImageNet, et stort offentligt objektgenkendelsesdatasæt, er alle sårbare over for modstridende forstyrrelser.

Især modstridende eksempler genereres ofte i indstillingen "white-box", hvor AI-modellen er fuldstændig gennemsigtig for en modstander. I det praktiske scenarie, når du implementerer en selvtrænet AI-model som en service, såsom en online billedklassificerings-API, man kan fejlagtigt tro, at den er robust over for modstridende eksempler på grund af begrænset adgang og viden om den underliggende AI-model (også kaldet "black-box"-indstillingen). Imidlertid, vores seneste arbejde offentliggjort på AAAI 2019 viser, at robustheden på grund af begrænset modeladgang ikke er jordet. Vi leverer en generel ramme til generering af modstridende eksempler fra den målrettede AI-model ved kun at bruge modellens input-output-svar og få modelforespørgsler. Sammenlignet med det tidligere arbejde (ZOO-angreb), vores foreslåede ramme, kaldet AutoZOOM, reducerer mindst 93 % modelforespørgsler i gennemsnit, mens der opnås lignende angrebsydelse, leverer en forespørgselseffektiv metode til evaluering af modstandsdygtigheden af AI-systemer med begrænset adgang. Et illustrerende eksempel er vist i figur 1, hvor et modstridende bagel-billede genereret fra en sort-boks billedklassifikator vil blive klassificeret som angrebsmålet "flygel". Denne artikel er udvalgt til mundtlig præsentation (29. januar, 11:30-12:30 @ coral 1) og plakatpræsentation (29. januar, 18.30-20.30) på AAAI 2019.

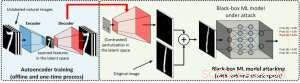

I indstillingen for hvid boks, modstridende eksempler er ofte udformet ved at udnytte gradienten af et designet angrebsmål i forhold til datainputtet til vejledning af modstridende forstyrrelser, hvilket kræver at kende modelarkitekturen samt modelvægtene til slutning. Imidlertid, i black-box-indstillingen er det umuligt at opnå gradienten på grund af begrænset adgang til disse modeldetaljer. I stedet, en modstander kan kun få adgang til input-output-svarene fra den implementerede AI-model, ligesom almindelige brugere (f.eks. upload et billede og modtag forudsigelsen fra en online billedklassificerings-API). Det blev først vist i ZOO-angrebet, at generering af modstridende eksempler fra modeller med begrænset adgang er muligt ved at bruge gradient-estimeringsteknikker. Imidlertid, det kan tage en enorm mængde modelforespørgsler at lave et modstridende eksempel. For eksempel, i figur 1, ZOO-angreb kræver mere end 1 million modelforespørgsler for at finde det modstridende bagelbillede. For at fremskynde forespørgselseffektiviteten ved at finde modstridende eksempler i black-box-indstillingen, vores foreslåede AutoZOOM-ramme har to nye byggeklodser:(i) en adaptiv tilfældig gradient-estimeringsstrategi til at balancere forespørgselsantal og forvrængning, og (ii) en autoencoder, der enten trænes offline med umærkede data eller en bilineær størrelsesændringsoperation til acceleration. For (i), AutoZOOM har en optimeret og forespørgselseffektiv gradientestimator, som har et adaptivt skema, der bruger få forespørgsler til at finde den første vellykkede modstridende forstyrrelse og derefter bruger flere forespørgsler til at finjustere forvrængningen og gøre det modstridende eksempel mere realistisk. For (ii), som vist i figur 2, AutoZOOM implementerer en teknik kaldet "dimensionsreduktion" for at reducere kompleksiteten i at finde modstridende eksempler. Dimensionsreduktionen kan realiseres af en offline trænet autoencoder til at fange datakarakteristika eller en simpel bilineær billedresizer, som ikke kræver nogen træning.

Figur 2:Illustration af dimensionsreduktionsteknikken brugt i AutoZOOM til forespørgselsindløsninger. Dekoderen kan enten være en offline trænet autoencoder eller en bilineær størrelsesændring, der ikke kræver nogen træning. Kredit:IBM

Med disse to kerneteknikker, vores eksperimenter med black-box dybe neurale netværksbaserede billedklassifikatorer trænet på MNIST, CIFAR-10 og ImageNet viser, at AutoZOOM opnår en lignende angrebsydelse, mens den opnår en betydelig reduktion (mindst 93%) i det gennemsnitlige antal forespørgsler sammenlignet med ZOO-angrebet. På ImageNet, denne drastiske reduktion betyder millioner af færre modelforespørgsler, gør AutoZOOM til et effektivt og praktisk værktøj til at evaluere modstandsdygtigheden af AI-modeller med begrænset adgang. I øvrigt, AutoZOOM er en generel forespørgselsindløsningsaccelerator, der let kan anvendes på forskellige metoder til at generere modstridende eksempler i den praktiske black-box-indstilling.

AutoZOOM-koden er open source og kan findes her. Tjek også IBM's Adversarial Robustness Toolbox for flere implementeringer af modstridende angreb og forsvar.

Denne historie er genudgivet med tilladelse fra IBM Research. Læs den originale historie her.

Varme artikler

Varme artikler

-

Boeing fordriver Muilenburg, udnævner David Calhoun til CEO midt i MAX-krisenBoeings 737 MAX har været jordet over hele verden siden den 16. 2019 styrt af et Ethiopian Airways-fly, det andet dødbringende styrt af flyet, hvilket har rejst spørgsmål om virksomhedens håndtering a

Boeing fordriver Muilenburg, udnævner David Calhoun til CEO midt i MAX-krisenBoeings 737 MAX har været jordet over hele verden siden den 16. 2019 styrt af et Ethiopian Airways-fly, det andet dødbringende styrt af flyet, hvilket har rejst spørgsmål om virksomhedens håndtering a -

Stater opkræver mere for elbiler, efterhånden som nye love træder i kraftI denne fredag, 20. december, 2019, Foto, Neda Deylami poserer til et portræt, mens hun oplader sit elektriske køretøj i en købmand i Chicago-området. Ejere af elektriske køretøjer i en række stater v

Stater opkræver mere for elbiler, efterhånden som nye love træder i kraftI denne fredag, 20. december, 2019, Foto, Neda Deylami poserer til et portræt, mens hun oplader sit elektriske køretøj i en købmand i Chicago-området. Ejere af elektriske køretøjer i en række stater v -

Boeing indtager en "business as usual"-holdning ved 737-medieturenMedarbejdere arbejder på Boeing 737 MAX-fly på fabrikken i Renton, Washington Efter to dødsulykker på fem måneder, Boeing prøver hårdt – meget hårdt – på at fremstille sig selv som upåvirket af de

Boeing indtager en "business as usual"-holdning ved 737-medieturenMedarbejdere arbejder på Boeing 737 MAX-fly på fabrikken i Renton, Washington Efter to dødsulykker på fem måneder, Boeing prøver hårdt – meget hårdt – på at fremstille sig selv som upåvirket af de -

Rejsende er uenige om, hvorvidt de ville tage ture i autonome køretøjer, undersøgelse finderEn person med hænderne fra rattet i en Tesla, et køretøj med semi-autonome køreegenskaber. Kredit:Pexels.com Autonome køretøjer bliver mere og mere en realitet, efterhånden som teknologien forbedr

Rejsende er uenige om, hvorvidt de ville tage ture i autonome køretøjer, undersøgelse finderEn person med hænderne fra rattet i en Tesla, et køretøj med semi-autonome køreegenskaber. Kredit:Pexels.com Autonome køretøjer bliver mere og mere en realitet, efterhånden som teknologien forbedr

- Sådan fungerer Zumwalt Class Destroyer

- Undersøgelse afslører, hvordan iltfattigt protein binder løst til et mineral

- Skaber bølger:Forskere kaster lys over, hvordan cilia fungerer

- Forskere kombinerer højtryksforskning med NMR-spektroskopi

- Forskere kaster lys over modulering af termisk blegning af koralrev ved indre bølger

- Spørgsmål og svar:Holder effektivt køligt under hedebølger