OpenAIs GPT-2-algoritme er god til at strikke falske nyheder

Kredit:CC0 Public Domain

Falsk. Farligt. Skræmmende. For godt. Når overskrifter svømmer med domme som dem, du har mistanke om, korrekt, at du er i landet med kunstig intelligens, hvor nogen har fundet på endnu en AI-model.

Så, dette er , GPT-2, en algoritme og om det gør én bekymret eller forundret, "Det udmærker sig ved en opgave kendt som sprogmodellering, " sagde Randen , "som tester et programs evne til at forudsige det næste ord i en given sætning."

Alt efter hvordan man ser på det, du kan bebrejde, eller lykønske, et team hos Californien-baserede OpenAI, der skabte GPT-2. Deres sprogmodelleringsprogram har skrevet et overbevisende essay om et emne, som de var uenige i.

Sådan gjorde de det:De gav den tekstbeskeder. Den var i stand til at færdiggøre opdigtede sætninger og afsnit. Deres model blev trænet til at forudsige det næste ord i internettekst, sagde OpenAI blogindlægget.

David Luan, Vicedirektør for ingeniørarbejde ved laboratoriet i Californien, fortalte, hvad der skete Randen . Holdet besluttede at bede det "for at argumentere for et punkt, de mente var kontraintuitivt. I dette tilfælde:hvorfor genbrug er dårligt for verden." Resultatet:En lærer-behagelig, velbegrundet essay, "noget du kunne have indsendt til US SAT og få en god score på, " sagde Luan.

Deri ligger grunden til, at nogle mennesker, der bekymrer sig over Armageddon med robotter, måske ikke sover så godt om natten. Giv det en falsk overskrift, sagde James Vincent ind Randen , og det går i gang med at skrive resten af artiklen.

"Vi begyndte at teste det, og opdagede hurtigt, at det er muligt at generere ondsindet indhold ganske nemt, " sagde Jack Clark, policy director hos OpenAI, i MIT Technology Review . Falske citater? Intet problem. Falske statistikker? Færdig.

Vincent tilføjede, der var en anden grund til, at GPT-2 fik fokus. Det blev også kendt for sin fleksibilitet. At skrive falske essays var ikke den eneste mulighed; det kunne også udføre nogle andre opgaver:"oversætte tekst fra et sprog til et andet, opsummerer lange artikler, og besvare trivia spørgsmål, sagde Vincent.

Alt i alt, OpenAI-bloggen, som blev lagt ud torsdag, opsummerede, hvad de har gjort. Bemærk deres sidste par ord, uden opgavespecifik træning:

"Vi har trænet en storstilet uovervåget sprogmodel, som genererer sammenhængende tekstafsnit, opnår state-of-the-art ydeevne på mange sprogmodelleringsbenchmarks, og udfører rudimentær læseforståelse, maskinoversættelse, besvare spørgsmål, og opsummering - alt sammen uden opgavespecifik træning."

Dette er "zero-shot"-sektoren for AI-forskning.

"Vores model er ikke trænet i nogen af de data, der er specifikke for nogen af disse opgaver og evalueres kun på dem som en afsluttende test; dette er kendt som 'zero-shot'-indstillingen. GPT-2 klarer sig bedre end modeller trænet på domænespecifikke datasæt (f.eks. Wikipedia, nyheder, bøger), når det evalueres på de samme datasæt." Programmet genkender mønstre i de data, som det fodres; Knight skrev, at "i modsætning til de fleste sprogalgoritmer, OpenAI-programmet kræver ikke mærket eller kurateret tekst."

Holdet sagde, at deres system satte rekord for ydeevne på såkaldte Winograd-skemaer, en hård læseforståelsesopgave; opnår næsten menneskelig præstation på børnebogstesten, endnu et tjek af læseforståelse; og genererer sin egen tekst, inklusive meget overbevisende nyhedsartikler og Amazon-anmeldelser, ifølge Vox .

Bloomberg henvendte sig til Sam Bowman, en datalog ved New York University, der har specialiseret sig i naturlig sprogbehandling. Bowman var ikke en del af OpenAI-projektet, lige orienteret om det. ""Det er i stand til at gøre ting, der er kvalitativt meget mere sofistikerede end noget, vi har set før."

Til sidst, hvad har vi her? Skabte de et gennembrud eller et monster?

Tilføjer lidt perspektiv, Vil ridder ind MIT Technology Review sagde, at sådan teknologi kunne have gavnlige anvendelser, såsom at opsummere tekst eller forbedre chatbots' samtaleevner. Også, en ekspert i behandling af naturligt sprog og chefforskeren hos Salesforce anerkendte dette OpenAI-arbejde som et eksempel på et sprogindlæringssystem til mere generelle formål. Richard Socher, eksperten, kommenterede potentialet for bedrag og misinformation. "Du behøver ikke AI for at skabe falske nyheder, " sagde han. "Folk kan sagtens gøre det :)"

Ikke desto mindre, "OpenAI træder forsigtigt med afsløringen af GPT-2, " skrev Vincent. "I modsætning til de fleste betydningsfulde forskningsmilepæle inden for AI, laboratoriet vil ikke dele det datasæt, det brugte til træning af algoritmen eller al den kode, det kører på (selvom det har givet midlertidig adgang til algoritmen til en række mediepublikationer, inklusive Randen )."

Det oplyser holdet i deres blogindlæg. "På grund af vores bekymringer om ondsindede anvendelser af teknologien, vi frigiver ikke den trænede model. Som et eksperiment i ansvarlig afsløring, vi udgiver i stedet en meget mindre model, som forskere kan eksperimentere med, samt et teknisk papir."

Specifikt, de sagde, at de kun udgav en meget mindre version af GPT-2 sammen med samplingkode. "Vi frigiver ikke datasættet, træningskode, eller GPT-2 modelvægte."

OpenAI foretrækker at tale om farer, før de ankommer. Jack Clark, policy director hos OpenAI talte om sprogmodelleringsalgoritmer som GPT-2. "Vores hypotese er, at det kan være en bedre og sikrere verden, hvis du taler om [disse farer], før de ankommer, " han sagde.

GPT-2 blev trænet på et datasæt med millioner af websider. Dave Lee, Nordamerika teknologireporter, BBC, tilføjede den "uovervågede" karakter af det, de skabte, sådan at det ikke skulle omskoles for at flytte til et andet emne.

Lee, mens de anerkender, at deres arbejde var imponerende realistisk i tonen, når det fungerede godt, også bemærket mangler.

"AI'en genererer historien ord for ord. Den resulterende tekst er ofte sammenhængende, men sjældent sandfærdige - alle citater og tilskrivninger er opdigtede. Sætningerne er baseret på oplysninger, der allerede er offentliggjort online, men sammensætningen af disse oplysninger er beregnet til at være unik. Nogle gange spytter systemet tekststykker ud, der strukturelt ikke giver særlig mening, eller indeholde latterlige unøjagtigheder."

Til grin nu, men vil AI'en blive forbedret over tid? Ifølge Knight, Clark sagde, at det måske ikke vare længe, før de falske historier produceret af AI var mere overbevisende. "Det er meget klart, at hvis denne teknologi modnes - og jeg ville give den et eller to år - kan den bruges til desinformation eller propaganda, " sagde Clark, og "Vi forsøger at komme foran det her."

© 2019 Science X Network

Varme artikler

Varme artikler

-

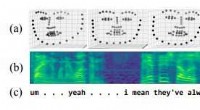

Analyse af talesprog og 3-D ansigtsudtryk for at måle sværhedsgraden af depressionMultimodale data. For hver klinisk samtale, forskerne bruger:(a) video af 3D-ansigtsscanninger, (b) lydoptagelse, visualiseret som et log-mel spektrogram, og (c) teksttransskription af patientens tale

Analyse af talesprog og 3-D ansigtsudtryk for at måle sværhedsgraden af depressionMultimodale data. For hver klinisk samtale, forskerne bruger:(a) video af 3D-ansigtsscanninger, (b) lydoptagelse, visualiseret som et log-mel spektrogram, og (c) teksttransskription af patientens tale -

Nordøstlige studerende designer og bygger enheder til at hjælpe med at forbedre livet for personer…Studerende Alex Rivas og Rachel Biega arbejder på en Gate Trainer Harness, som bruges til fysioterapibehandling af patienter, der har begrænsede gangmuligheder, i Enabling Engineering Lab i Hayden Hal

Nordøstlige studerende designer og bygger enheder til at hjælpe med at forbedre livet for personer…Studerende Alex Rivas og Rachel Biega arbejder på en Gate Trainer Harness, som bruges til fysioterapibehandling af patienter, der har begrænsede gangmuligheder, i Enabling Engineering Lab i Hayden Hal -

Renter er en afgørende faktor for konkurrencedygtig vedvarende energiDa vedvarende energi er mere kapitalintensiv end fossile brændstoffer, omkostningerne stiger kraftigere med stigende renter, gør det mindre attraktivt. Kredit:Shutterstock Vedvarende energi er ble

Renter er en afgørende faktor for konkurrencedygtig vedvarende energiDa vedvarende energi er mere kapitalintensiv end fossile brændstoffer, omkostningerne stiger kraftigere med stigende renter, gør det mindre attraktivt. Kredit:Shutterstock Vedvarende energi er ble -

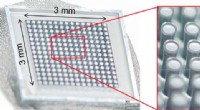

3-D-batterier pakker strøm til små fodspor3-D batterierne udviklet af Janet I. Hur, Leland C. Smith, og Bruce Dunn. Kredit:Hur et al./ Joule Batterier kan virke som om de kommer i enhver form og størrelse, som du kan forestille dig. Men

3-D-batterier pakker strøm til små fodspor3-D batterierne udviklet af Janet I. Hur, Leland C. Smith, og Bruce Dunn. Kredit:Hur et al./ Joule Batterier kan virke som om de kommer i enhver form og størrelse, som du kan forestille dig. Men

- Sådan klæber du sensorer til huden uden klæbemiddel

- Brug af lyskraft til at studere enkelte molekyler

- Mars-fund katalogiseret på Navajo-sprog

- Hvorfor har planter brug for fotosyntesen og cellulær respiration?

- Neutroner låser op for egenskaber ved nyt porøst metalhydrid til mulige nye energilagringsapplikat…

- Som bitcoin gyrer, mindre eufori i bevis ved blockchain-indsamling