Generering af tværmodale sensoriske data til robot-visuel-taktil perception

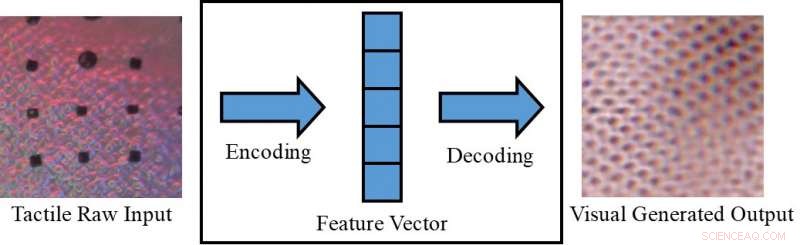

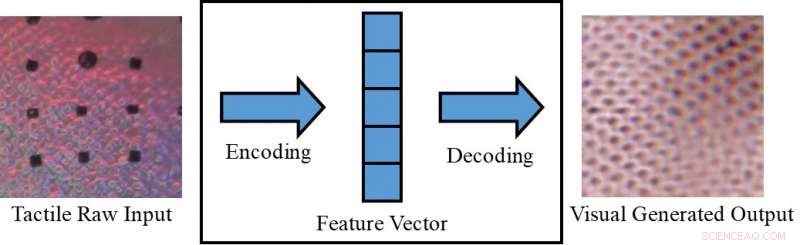

Konvertering af et taktilt billede til et visuelt billede. Kredit:Lee, Bollegala &Luo.

Opfatter et objekt kun visuelt (f.eks. på en skærm) eller kun ved at berøre det, kan nogle gange begrænse, hvad vi er i stand til at udlede om det. Mennesker, imidlertid, har den medfødte evne til at integrere visuelle og taktile stimuli, udnytte alle sensoriske data til rådighed for at fuldføre deres daglige opgaver.

Forskere ved University of Liverpool har for nylig foreslået en ny ramme til at generere tværmodale sensoriske data, som kunne hjælpe med at replikere både visuel og taktil information i situationer, hvor en af de to ikke er direkte tilgængelig. Deres rammer kunne, for eksempel, give folk mulighed for at opfatte objekter på en skærm (f.eks. tøj på e-handelswebsteder) både visuelt og taktisk.

"I vores daglige erfaring, vi kan kognitivt skabe en visualisering af et objekt baseret på en taktil respons, eller en taktil reaktion fra at se en overflades tekstur, "Dr. Shan Luo, en af de forskere, der har udført undersøgelsen, fortalte TechXplore. "Dette perceptuelle fænomen, kaldet synestesi, hvor stimulering af en sans forårsager en ufrivillig reaktion i en eller flere af de andre sanser, kan bruges til at danne en utilgængelig mening. For eksempel, når man griber et objekt, vores syn vil blive blokeret af hånden, men der vil blive genereret et berøringssvar for at 'se' de tilsvarende funktioner. "

Det perceptuelle fænomen beskrevet af Dr. Luo opstår typisk, når en perceptionskilde ikke er tilgængelig (f.eks. når man rører genstande inde i en pose uden at kunne se dem). I sådanne situationer, mennesker kan "røre for at se" eller "se for at føle, " fortolkning af træk relateret til en bestemt sans baseret på information indsamlet ved hjælp af deres andre sanser. Hvis de replikeres i maskiner, denne visuel-taktile mekanisme kunne have flere interessante anvendelser, især inden for robotteknologi og e-handel.

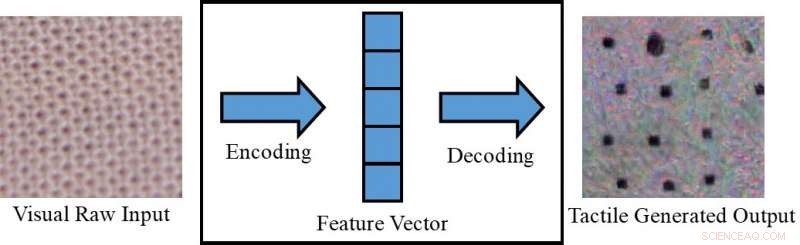

Konvertering af et visuelt billede til et taktilt billede. Kredit:Lee, Bollegala &Luo.

Hvis robotter var i stand til at integrere visuel og taktil perception, de kunne planlægge deres gribe- og manipulationsstrategier mere effektivt baseret på de visuelle karakteristika ved de objekter, de arbejder med (f.eks. form, størrelse, etc.). Med andre ord, robotter ville opfatte objekternes overordnede taktile egenskaber, før de greb dem, ved hjælp af visuel information indsamlet af kameraer. Mens du griber fat i et objekt uden for kameraets synsfelt, på den anden side, de ville bruge taktile-lignende svar for at kompensere for manglen på visuel information tilgængelig.

Hvis parret med en taktil enhed, som endnu ikke er udviklet, den ramme foreslået af Dr. Luo og hans kolleger kunne også bruges i e-handel, for eksempel, giver kunderne mulighed for at mærke stoffet i tøjet, før de køber det. Med denne applikation i tankerne, forskerne brugte betingede generative modstridende netværk til at generere pseudo visuelle billeder ved hjælp af taktile data og omvendt (dvs. at generere taktile output ved hjælp af visuelle data).

"På online markedspladser, kunder handler ved at se billeder af tøj eller andre varer, "Sagde Dr. Luo." Dog, de er ude af stand til at røre ved disse genstande for at føle deres materialer. At føle en vare er ret vigtig, mens du handler, især når du køber sarte ting, såsom undertøj. Giver brugerne mulighed for at føle genstande derhjemme, ved hjælp af en taktil enhed, der endnu ikke er udviklet, den tværmodale sensoriske datagenereringsordning, der foreslås i vores artikel, kan hjælpe e-handelskunder med at træffe mere informerede valg. "

Dr. Luo og hans kolleger evaluerede deres model på VITac -datasættet, som indeholder makrobilleder og taktile aflæsninger (taget med en GelSight -sensor) af 100 forskellige stoftyper. De fandt ud af, at det effektivt kunne forudsige sensoriske output for den ene sans (dvs. vision eller berøring) ved hjælp af data, der er relevante for den anden.

GelSight sensor. Kredit:Lee, Bollegala &Luo.

"Vi tager teksturopfattelse som et eksempel:visuelle inputbilleder af en kludtekstur bruges til at generere en pseudo-taktil læsning af det samme stykke stof; omvendt, taktile aflæsninger af en klud bruges til at forudsige et visuelt billede af den samme klud, " Dr. Luo forklarede. "Teksturerne af stoffer, dvs. garnfordelingsmønstrene, vises på samme måde i et visuelt billede og en trykfordeling (dvs. taktil) aflæsning. Imidlertid, dette arbejde kan også udvides til at opnå tværmodal visuel-taktil datagenerering til opfattelse af andre objektegenskaber, ved at overveje forskellene mellem de to domæner."

Undersøgelsen udført af Dr. Luo og hans kolleger opnåede bemærkelsesværdige resultater i at generere realistiske taktile og visuelle mønstre for forskellige stoffer i fravær af taktil eller visuel information, derfor. Ved hjælp af deres rammer, forskerne har succesfuldt 'repliceret' taktile elementer af stoffer ved hjælp af visuelle data, og omvendt.

"Så vidt vi ved, dette arbejde er det første forsøg på at opnå robotisk cross-modal visuel-taktil datagenerering, som også kan udvides til tværmodal datagenerering til andre modaliteter, "Dr. Luo sagde. "De praktiske implikationer af vores undersøgelse er, at vi kan gøre brug af andre sanser til at finde på en utilgængelig mening."

I fremtiden, den ramme foreslået af Dr. Luo og hans kolleger kunne bruges til at forbedre greb og manipulationsstrategier i robotter, samt at forbedre online shoppingoplevelser. Deres metode kunne også bruges til at udvide datasæt til klassifikationsopgaver, ved at generere sensoriske data, som ellers ville være utilgængelige.

Kredit:Lee, Bollegala &Luo.

"I fremtidig forskning, vi vil forsøge at anvende vores metode til en række forskellige opgaver, såsom visuel og taktil klassificering i en virkelig verden, med genstande, der varierer i udseende (f.eks. form, farve osv.), " sagde Dr. Luo. Desuden, den foreslåede visuelt-taktile datagenereringsmetode vil blive brugt til at lette robotopgaver, såsom greb og manipulation. "

Papiret, der skitserer denne nylige undersøgelse, forudgivet på arXiv, vil blive præsenteret på 2019 International Conference on Robotics and Automation (ICRA), som finder sted i Montreal, Canada, mellem den 20. og 24. maj. På konferencen, Dr. Luo vil også afholde en workshop relateret til emnet for hans undersøgelse, kaldet "ViTac:Integration af vision og berøring for multimodal og tværmodal perception."

© 2019 Science X Network

Varme artikler

Varme artikler

-

PixelGreen:En hybrid, grøn medievæg til eksisterende højhuseDen hypotetiske implementering af PixelGreen i den tætte bykontekst i Hong Kong. Til højre:Potentielle steder, der kombinerer de lodrette og vandrette overflader (fremhævet med grønt) af eksisterende

PixelGreen:En hybrid, grøn medievæg til eksisterende højhuseDen hypotetiske implementering af PixelGreen i den tætte bykontekst i Hong Kong. Til højre:Potentielle steder, der kombinerer de lodrette og vandrette overflader (fremhævet med grønt) af eksisterende -

2020:Hvad skal der ske inden for teknologi – AirPods Pro, Oculus Quest vender tilbage til butikkerneKredit:Apple De AirPods Pros, som du eftertragtede før ferien? De er tilbage den 27. januar. Og det rødglødende Oculus Quest virtual reality-headset? Også udsolgt. Du skal vente til den 19. feb

2020:Hvad skal der ske inden for teknologi – AirPods Pro, Oculus Quest vender tilbage til butikkerneKredit:Apple De AirPods Pros, som du eftertragtede før ferien? De er tilbage den 27. januar. Og det rødglødende Oculus Quest virtual reality-headset? Også udsolgt. Du skal vente til den 19. feb -

Uber afregner hollandsk sonde for 2,3 millioner euroUber-forliget med Holland er det seneste i en serie rundt om i verden, der har set den amerikanske ridehagrende kæmpe skille millioner ud af lovovertrædelser Den amerikanske ridehilsen gigant Uber

Uber afregner hollandsk sonde for 2,3 millioner euroUber-forliget med Holland er det seneste i en serie rundt om i verden, der har set den amerikanske ridehagrende kæmpe skille millioner ud af lovovertrædelser Den amerikanske ridehilsen gigant Uber -

Stigende oliepriser for at skade flyselskabernes overskud:IATAIATA er klar til at offentliggøre en lavere profitprognose for den globale luftfartsindustri, med stigende brændstofomkostninger en nøglefaktor Stigende oliepriser forventes at ødelægge flyselskab

Stigende oliepriser for at skade flyselskabernes overskud:IATAIATA er klar til at offentliggøre en lavere profitprognose for den globale luftfartsindustri, med stigende brændstofomkostninger en nøglefaktor Stigende oliepriser forventes at ødelægge flyselskab

- At tale om videnskabelige resultater uden at overdrive resultaterne

- NASA-NOAA satellitsporing Super Typhoon Mangkhut

- Nanoskala billeddannelse af dopant nanostrukturer i silicium-baserede enheder

- Mikroplastikforurening skader hummerlarver, undersøgelse finder

- Fødevareteknologi:Insektmel

- Spotify siger, at de vil springe over politiske annoncer i 2020