Undervisning i maskiner til at ræsonnere om, hvad de ser

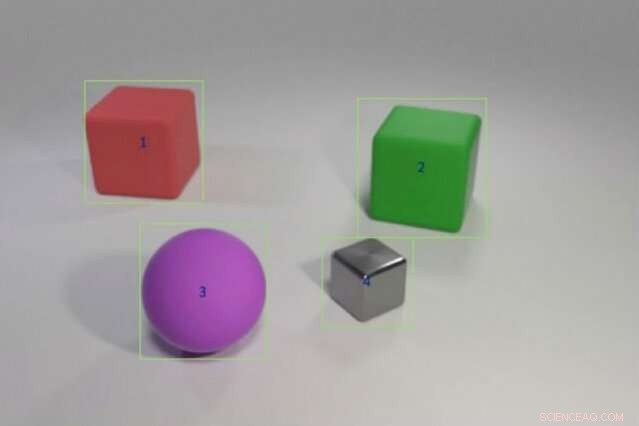

Forskere uddannede en hybrid AI -model til at besvare spørgsmål som "Har den røde genstand til venstre for den grønne terning samme form som den lilla matte ting?" ved at fodre eksempler på objektfarver og former efterfulgt af mere komplekse scenarier, der involverer sammenligning af flere objekter. Modellen kunne overføre denne viden til nye scenarier såvel som eller bedre end state-of-the-art modeller ved hjælp af en brøkdel af træningsdataene. Kredit:Justin Johnson

Et barn, der aldrig har set en lyserød elefant, kan stadig beskrive en - i modsætning til en computer. "Computeren lærer af data, "siger Jiajun Wu, en ph.d. studerende på MIT. "Evnen til at generalisere og genkende noget, du aldrig har set før - en lyserød elefant - er meget vanskelig for maskiner."

Deep learning -systemer fortolker verden ved at udvælge statistiske mønstre i data. Denne form for maskinlæring er nu overalt, automatisk tagge venner på Facebook, fortæller Alexas seneste vejrudsigt, og levere sjove fakta via Google -søgning. Men statistisk læring har sine grænser. Det kræver masser af data, har problemer med at forklare sine beslutninger, og er frygtelig til at anvende tidligere viden på nye situationer; Den kan ikke forstå en elefant, der er lyserød i stedet for grå.

For at give computere mulighed for at ræsonnere mere som os, forskere fra kunstig intelligens (AI) vender tilbage til abstrakt, eller symbolsk, programmering. Populær i 1950'erne og 1960'erne, symbolske AI -ledninger i reglerne og logikken, der gør det muligt for maskiner at foretage sammenligninger og fortolke, hvordan objekter og enheder forholder sig. Symbolsk AI bruger færre data, registrerer kæden af trin, det tager for at nå til en beslutning, og når det kombineres med den brutale behandlingskraft i statistiske neurale netværk, det kan endda slå mennesker i en kompliceret billedforståelsestest.

En ny undersøgelse af et team af forskere ved MIT, MIT-IBM Watson AI Lab, og DeepMind viser løftet om at fusionere statistisk og symbolsk AI. Anført af Wu og Joshua Tenenbaum, en professor i MIT's afdeling for hjerne- og kognitive videnskaber og datalogi og laboratorium for kunstig intelligens, teamet viser, at dets hybridmodel kan lære objektrelaterede begreber som farve og form, og udnytte denne viden til at fortolke komplekse objektforhold i en scene. Med minimal træningsdata og ingen eksplicit programmering, deres model kunne overføre koncepter til større scener og besvare stadig mere vanskelige spørgsmål såvel som eller bedre end dets topmoderne jævnaldrende. Teamet præsenterer sine resultater på den internationale konference om læringsrepræsentationer i maj.

"En måde børn lærer begreber på, er ved at forbinde ord med billeder, "siger undersøgelsens hovedforfatter Jiayuan Mao, en bachelor på Tsinghua University, der arbejdede på projektet som gæst på MIT. "En maskine, der kan lære på samme måde, har brug for meget mindre data, og er bedre i stand til at overføre sin viden til nye scenarier. "

Undersøgelsen er et stærkt argument for at gå tilbage mod abstrakte programtilgange, siger Jacob Andreas, en nyuddannet fra University of California i Berkeley, der starter på MIT som adjunkt i efteråret og ikke var involveret i arbejdet. "Tricket, det viser sig, er at tilføje mere symbolsk struktur, og for at fodre de neurale netværk en repræsentation af verden, der er opdelt i objekter og egenskaber i stedet for at fodre den med rå billeder, "siger han." Dette arbejde giver os indsigt i, hvad maskiner skal forstå, før sprogindlæring er mulig. "

Teamet uddannede deres model på billeder parret med relaterede spørgsmål og svar, del af CLEVR -billedforståelsestesten udviklet ved Stanford University. Som modellen lærer, spørgsmålene vokser gradvist sværere, fra, "Hvad er objektets farve?" til "Hvor mange objekter er begge til højre for den grønne cylinder og har samme materiale som den lille blå kugle?" Når objekter på objektniveau mestres, modellen går videre til at lære at forholde objekter og deres egenskaber til hinanden.

Ligesom andre hybrid AI -modeller, MIT fungerer ved at opdele opgaven. Et opfattelsesmodul af neurale netværk knuser pixel i hvert billede og kortlægger objekterne. Et sprogmodul, også lavet af neurale net, udtrækker en betydning fra ordene i hver sætning og opretter symbolske programmer, eller instruktioner, der fortæller maskinen, hvordan man besvarer spørgsmålet. Et tredje ræsonnementsmodul kører de symbolske programmer på scenen og giver et svar, opdatering af modellen, når den laver fejl.

Nøglen til teamets tilgang er et opfattelsesmodul, der oversætter billedet til en objektbaseret repræsentation, gør programmerne lettere at udføre. Også unikt er det, de kalder curriculum learning, eller selektivt træne modellen om koncepter og scener, der gradvist bliver sværere. Det viser sig, at fodring af maskindata på en logisk måde, frem for tilfældigt, hjælper modellen med at lære hurtigere og forbedrer nøjagtigheden.

Når modellen har et solidt fundament, det kan fortolke nye scener og begreber, og stadig vanskeligere spørgsmål næsten perfekt. Bedt om at besvare et ukendt spørgsmål som, "Hvad er formen på den store gule ting?" det klarede sig bedre end sine jævnaldrende i Stanford og det nærliggende MIT Lincoln Laboratory med en brøkdel af dataene.

Mens andre modeller uddannede sig i det fulde CLEVR -datasæt på 70, 000 billeder og 700, 000 spørgsmål, MIT-IBM-modellen brugt 5, 000 billeder og 100, 000 spørgsmål. Da modellen byggede på tidligere indlærte koncepter, det absorberede programmerne bag hvert spørgsmål, fremskynde uddannelsesprocessen.

Selvom det er statistisk, dybe læringsmodeller er nu integreret i dagligdagen, meget af deres beslutningsproces forbliver skjult for synet. Denne mangel på gennemsigtighed gør det svært at forudse, hvor systemet er modtageligt for manipulation, fejl, eller bias. Tilføjelse af et symbolsk lag kan åbne den sorte boks, forklarer den stigende interesse for hybrid AI -systemer.

"At dele opgaven op og lade programmer gøre noget af arbejdet er nøglen til at opbygge fortolkningsevne i deep learning -modeller, "siger Lincoln Laboratory -forsker David Mascharka, hvis hybridmodel, Gennemsigtighed ved designnetværk, er benchmarket i MIT-IBM-undersøgelsen.

MIT-IBM-teamet arbejder nu på at forbedre modelens ydeevne på virkelige fotos og udvide det til videoforståelse og robotmanipulation. Andre forfattere af undersøgelsen er Chuang Gan og Pushmeet Kohli, forskere ved MIT-IBM Watson AI Lab og DeepMind, henholdsvis.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT -forskning, innovation og undervisning.

Sidste artikelTesla viser fremskridt med selvkørende biler til investorer

Næste artikelDyreintelligens og AI:Konkurrence er i vingerne

Varme artikler

Varme artikler

-

Solar farm i Kings Park til power 1, 000 boligerKredit:CC0 Public Domain En 27 hektar stor Kings Park-ejendom, der startede som en losseplads i løbet af 1940erne og derefter blev en golf driving range i 80erne, er nu hjemsted for en solfarm. N

Solar farm i Kings Park til power 1, 000 boligerKredit:CC0 Public Domain En 27 hektar stor Kings Park-ejendom, der startede som en losseplads i løbet af 1940erne og derefter blev en golf driving range i 80erne, er nu hjemsted for en solfarm. N -

Tesla ændrer kurs, vil holde flere udstillingslokaler åbneTesla vil have færre butikker med begrænsede tilbud, og de fleste kunder får simpelthen vist, hvordan man bestiller et køretøj online Elbilproducenten Tesla vender kursen om sin beslutning om at f

Tesla ændrer kurs, vil holde flere udstillingslokaler åbneTesla vil have færre butikker med begrænsede tilbud, og de fleste kunder får simpelthen vist, hvordan man bestiller et køretøj online Elbilproducenten Tesla vender kursen om sin beslutning om at f -

FTC idømmer Facebook en bøde på 5 mia. tilføjer begrænset tilsyn med privatlivets fredI denne 1. maj 2018, fil foto, Facebooks administrerende direktør Mark Zuckerberg holder hovedtalen på F8, Facebooks udviklerkonference, i San Jose, Californiens føderale tilsynsmyndigheder idømmer Fa

FTC idømmer Facebook en bøde på 5 mia. tilføjer begrænset tilsyn med privatlivets fredI denne 1. maj 2018, fil foto, Facebooks administrerende direktør Mark Zuckerberg holder hovedtalen på F8, Facebooks udviklerkonference, i San Jose, Californiens føderale tilsynsmyndigheder idømmer Fa -

En smart bil, der kan læse hjernens signalerKredit:Nissan EPFL- og Nissan-forskere er i stand til at læse en førers hjernesignaler og sende dem til et smart køretøj, så det kan forudse førerens bevægelser og lette kørselsprocessen. Nissan a

En smart bil, der kan læse hjernens signalerKredit:Nissan EPFL- og Nissan-forskere er i stand til at læse en førers hjernesignaler og sende dem til et smart køretøj, så det kan forudse førerens bevægelser og lette kørselsprocessen. Nissan a

- Udvikling af verdens første funktionelle polymer nanotrådsfremstillingsteknologi ved hjælp af pul…

- Ny marine svovlcyklusmodel efter Snowball Earth-glaciationen

- Informationsteori som et retsmedicinsk værktøj til at undersøge klimamysterier

- En liberal accent:Lingvistikhold dokumenterer sprogændringer i det sydvestlige Kansas

- Robotisk ubåd tager de første billeder nogensinde ved grundlæggelsen af den berygtede antarktis…

- Vejtrafik mikroplastik oversvømmer verdenshavene:undersøgelse