Stop med at spille med black box og modeller, der kan forklares om beslutninger med høje indsatser

Cynthia Rudin. Kredit:Duke University

I takt med at buzzwords "machine learning" fortsætter med at vokse i popularitet, flere industrier henvender sig til computeralgoritmer for at besvare vigtige spørgsmål, herunder højsatsede områder såsom sundhedspleje, finans og strafferet. Selvom denne tendens kan føre til store forbedringer i disse områder, det kan også føre til store problemer, når maskinlæringsalgoritmen er en såkaldt "black box".

En sort boks er et maskinlæringsprogram, der ikke forklarer, hvordan det når sine konklusioner, enten fordi det er for kompliceret for et menneske at forstå, eller fordi dets indre funktioner er proprietære. Som svar på bekymringer om, at disse typer modeller kan omfatte uretfærdige indre handlinger – såsom racisme – er en anden voksende tendens at skabe yderligere modeller for at "forklare" disse sorte bokse.

I en ny leder udgivet i Nature Machine Intelligence , Cynthia Rudin, lektor i datalogi, el- og computerteknik, matematik, og statistisk videnskab ved Duke University, argumenterer for, at sorte boks-modeller skal opgives for at træffe beslutninger med høj indsats. Selv når der laves såkaldte forklaringsmodeller, hun siger, beslutningstagere bør vælge fortolkbare modeller, som er fuldstændig gennemsigtige og let forståelige for sine brugere.

Forklarlige modeller er forkerte

"Forklarlige" maskinlæringsmodeller er bygget i et forsøg på at forstå, hvad der foregår inde i en sort boks. Hvis det kan give de samme resultater, folk antager, at det er en nøjagtig gengivelse.

Men det er det ikke.

Forklarlige algoritmer giver forklaringer, der er unøjagtige per definition - ellers ville den komplekse sorte boks indre funktion være unødvendig. Mens en forklaringsmodel kan give lignende eller endda nøjagtige resultater til den originale sorte boks-algoritme, der er ingen måde at vide, om den bruger de samme parametre eller ej.

"Hvis en tiendedel af forklaringerne er forkerte, du kan ikke stole på forklaringerne, og derfor kan du ikke stole på den originale sorte boks, " siger Rudin. "Hvis vi ikke kan vide med sikkerhed, om vores forklaring er korrekt, vi kan ikke vide, om vi skal stole på hverken forklaringen eller den originale model."

Mere er ikke lig bedre

Folk antager typisk, at bare fordi en maskinlæringsalgoritme er kompliceret, at den er mere nøjagtig end en simpel. Men denne tro er ubegrundet.

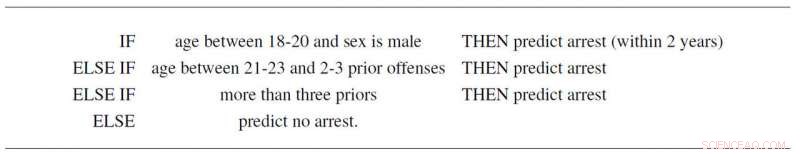

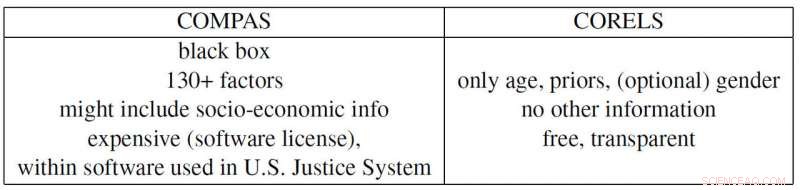

For eksempel, Rudin og samarbejdspartnere Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone og Daniel Alabi har skabt en simpel fortolkelig model for kriminel tilbagefald udelukkende baseret på alder, køn og tidligere rekord. Ikke alene følger det tre enkle regler, som alle kan forstå, det forudsiger sandsynligheden for fremtidige arrestationer lige så godt som det kontroversielle "COMPAS"-program, som er meget udbredt i det amerikanske retssystem. Og udover at være en sort boks, som mange mistænker anvender racistiske skævheder, COMPAS bruger mere end 130 stykker information til at lave sine forudsigelser, hvilket er et stort problem af sig selv.

"Hvis de personer, der indtaster disse data, laver en typografisk fejl kun én procent af tiden, så vil mere end 1 ud af hver 2 undersøgelser i gennemsnit have mindst én fejl, " siger Rudin. "Plus en alt for kompliceret sort boks-model kan være mangelfuld, uden at nogen er klar over det, fordi det er svært at fejlfinde."

Propublica-eksemplet

ProPublica beskyldte for nylig COMPAS recidivisme black box-algoritmen for at være racemæssigt forudindtaget, fordi de skabte en forklarlig model baseret på race, der gengiver COMPAS' resultater. Men fordi det samfundsmæssige pres har skabt et strafferetssystem, hvor kriminel historie og alder er korreleret med race i hvert datasæt, den faktiske COMPAS sorte boks kan faktisk kun stole på de to første variabler. Men så igen, det kunne også være at bruge race som en faktor, ligesom ProPublica hævder. Problemet er, at det er umuligt at sige, fordi COMPAS er en (dyr) proprietær sort boks, som ingen andre end dens ejere kan kigge ind i.

Rudin peger også på flere andre nutidige problematiske eksempler. Den proprietære sorte boks BreezoMeter fortalte brugere i Californien, at deres luftkvalitet var helt i orden, når luftkvaliteten var farlig dårlig ifølge flere andre modeller. En maskinlæringsmodel designet til at læse røntgenstråler opfangede ordet "bærbar" i et røntgenbillede, der repræsenterer typen af røntgenudstyr snarere end det medicinske indhold af billedet, og dermed rapportere dårlige konklusioner.

"Der er en ansvarskonflikt i brugen af black box-modeller til beslutninger med høj indsats. De virksomheder, der profiterer på disse modeller, er ikke nødvendigvis ansvarlige for kvaliteten af individuelle forudsigelser, " siger Rudin. "En fange, der afsoner en alt for lang dom på grund af en fejl, der er indtastet i en alt for kompliceret risikoscore, kan lide i årevis, hvorimod virksomheden, der konstruerede denne model, drager fordel af dens kompleksitet og ordentlighed. I den forstand modellens designere er ikke tilskyndet til at være forsigtige i designet, ydeevne og brugervenlighed. Det er nogle af de samme typer problemer, som rammer de kreditvurderingsbureauer, der prissatte realkreditlån i 2008."

"Jeg håber, at folk indser risiciene ved modeller, der kan forklares, og at de faktisk slet ikke har brug for sorte bokse. De kan bruge modeller, der er fuldstændigt fortolkelige, " siger Rudin. "Jeg kunne godt tænke mig at se et system, hvor der ikke bruges en sort boks-algoritme til en beslutning med høj indsats, medmindre der ikke er en lige så præcis fortolkelig model. Jeg har arbejdet på mange forskellige applikationer – medicinsk behandling, energi, Kreditrisiko, kriminel tilbagefald, computersyn - og jeg har aldrig fundet et program, hvor der faktisk er brug for en sort boks."

Varme artikler

Varme artikler

-

Aber om at løse problemerDusky Titi Monkey (Callicebus brunneus). Kredit:Wikipedia Der er utallige computeralgoritmer, der simulerer biologisk adfærd fra springende frøer, at slå fodermad, fra gøgssøgning til optimering a

Aber om at løse problemerDusky Titi Monkey (Callicebus brunneus). Kredit:Wikipedia Der er utallige computeralgoritmer, der simulerer biologisk adfærd fra springende frøer, at slå fodermad, fra gøgssøgning til optimering a -

Undskyld, Facebook og Google, Ellen Pao siger, at startups vil løse Silicon Valleys mangfoldighedsp…Kredit:CC0 Public Domain I 2013 Harry Glaser og Tom ONeill begyndte at ansætte til deres nye firma Periscope Data fra deres professionelle netværk. De vidste, at de havde et problem, da vi kom op

Undskyld, Facebook og Google, Ellen Pao siger, at startups vil løse Silicon Valleys mangfoldighedsp…Kredit:CC0 Public Domain I 2013 Harry Glaser og Tom ONeill begyndte at ansætte til deres nye firma Periscope Data fra deres professionelle netværk. De vidste, at de havde et problem, da vi kom op -

VPN-udbydere adresserer sårbarhedsfund fra forskereKredit:CC0 Public Domain Virtuelle private netværk (VPNer) er udviklet til at kryptere trafik mellem punkter på internettet. Som Computing Læg det, de udvider et privat netværk på tværs af et of

VPN-udbydere adresserer sårbarhedsfund fra forskereKredit:CC0 Public Domain Virtuelle private netværk (VPNer) er udviklet til at kryptere trafik mellem punkter på internettet. Som Computing Læg det, de udvider et privat netværk på tværs af et of -

Vand ud af den blå luft:Californiens par-enhed vinder $1,5 mioSkysource/Skywater Alliance medstiftere David Hertz, ret, og hans kone Laura Doss-Hertz demonstrerer, hvordan Skywater 300 fungerer onsdag, 24. okt. 2018, i Los Angeles. Virksomheden modtog $1,5 milli

Vand ud af den blå luft:Californiens par-enhed vinder $1,5 mioSkysource/Skywater Alliance medstiftere David Hertz, ret, og hans kone Laura Doss-Hertz demonstrerer, hvordan Skywater 300 fungerer onsdag, 24. okt. 2018, i Los Angeles. Virksomheden modtog $1,5 milli

- Investorer vil se kontanter, produktion i Tesla 1Q indtjening

- Udledning af temperaturstrukturen af circumstellare skiver fra polariseret emission

- NASAs IMERG anslår kraftig nedbør over det østlige USA

- Liste over måder at reducere brugen af fossile brændstoffer

- Kromosomale abnormiteter: Hvad er det ?, Typer og årsager

- Har du en drone? Lær lovene, før du tager flyvning