Sporing af misinformation online via kunstig intelligens

Kredit:iStock/champja

Vi lever i en æra med for meget information – en endeløs strøm af statusopdateringer, memes, genposter, infografik, citater og hashtags ruller dagligt gennem vores sociale medier feeds, beregnet til at udtrykke synspunkter, tromme solidaritet, give information, ændre mening eller skabe kontroverser.

Problemet er, den gennemsnitlige online browser/bruger af sociale medier har ikke tid eller råd til at undersøge legitimiteten eller herkomsten af alt, hvad der dukker op på deres feeds. Og det er denne sårbarhed, som mindre omhyggelige indholdsgeneratorer udnytter til at sprede misinformation, med resultater, der kan variere fra lidt æg-i-ansigt-forlegenhed til direkte livsændrende eller potentielt dødelige konsekvenser.

For UC Santa Barbara datalog William Wang, dette kaotiske morads er et frugtbart grundlag for udforskning. Wang mener, at deep learning-teknikker, når de er implementeret på tekst- og hyperlinknetværket af onlineindlæg og nyhedsartikler, kan hjælpe os med nogle af de kritisk tænkning tunge løft. Dette koncept ligger i hjertet af hans treårige projekt "Dynamo:Dynamic Multichannel Modeling of Misinformation."

"Så spørgsmålet er, givet et indlæg, hvordan ville du være i stand til at forstå, om dette er specifikt vildledende, eller om dette er et ægte indlæg, " sagde Wang, "og, givet netværkets struktur, kan du identificere spredningen af misinformation, og hvordan den vil være anderledes sammenlignet med standard- eller ikke-standardartikler?"

En høj ordre

Det er en stor ordre, især på de sociale medier, som har udjævnet spillereglerne mellem lovlige, etablerede nyhedswebsteder og tvivlsomme websteder, der gør deres bedste for at se officielle ud, eller appellere til en brugers følelser, før de kan træde tilbage og stille spørgsmålstegn ved kilden til deres information.

Imidlertid, takket være naturlig sprogbehandling – Wangs speciale – kan teksten i disse indlæg og artikler bruges til at afsløre information om deres skabere og formidlere, såsom deres tilhørsforhold, ideologier og incitamenter til udstationering, samt hvem deres tilsigtede publikum kan være. Algoritmen gennemgår millioner af nyhedsartikler postet af anonymiserede brugere på platforme som Twitter og Reddit og undersøger artiklernes titler, indhold og links. Formålet er ikke kun at få en fornemmelse af entiteterne bag dem, men også af deres formidlingsmønstre på tværs af netværket.

"Mange af os tager websteder for givet og retweeter tilfældigt eller genposter misinformation, og det er sådan, det bliver udbredt, kaskader og spredes viralt, " sagde Wang. "Nogle af de vigtigste spørgsmål, vi stiller, er:Hvad er mønstrene? Hvad er incitamenterne?"

At finde ud af, han og hans team foreslog en læringsmekanisme, der forklarer, hvorfor visse historier bliver genpostet eller retweetet, ud over om selve indholdet er sandt eller falsk. Langs vejen, Wang sagde, de kunne finde ud af, hvem der er involveret i spredningen af misinformationen, og hvilke mønstre der kan opstå i den proces. Billeder bliver også en del af datasættet, han tilføjede.

Senere, forskerne planlægger at integrere andre aspekter af deres arbejde med misinformation, såsom clickbait, som bruger iørefaldende, ofte opsigtsvækkende titler for at lokke læserne til at klikke på et link, der i bedste fald sender dem til en risikable hjemmeside, eller i værste fald, stjæler deres oplysninger.

"Clickbait er primært artikler af lav kvalitet, som faktisk kan indeholde en masse misinformation og falsk information, fordi de skal overdrive, " sagde Wang. Sammen med datalogi Ph.D.-studerende Jiawei Wu, holdet udviklede en metode kaldet "forstærket co-træning, " som anvender et effektivt system til at mærke nogle få hundrede artikler, som derefter bruges til at træne en maskinlæringsklassifikator til at mærke, hvad den tror kan være clickbait i en enorm, million-etagers datasæt.

"Så tager vi disse nyligt mærkede forekomster og genoplærer klassificereren, " sagde Wang. "Denne iterative proces giver os mulighed for at indsamle flere etiketdata over tid, " han tilføjede, som forfiner værktøjets nøjagtighed.

At bruge kunstig intelligens til at forstå og finde mønstre i den flodbølge af tekst, vi sender til hinanden hver dag, ville give os indsigt i, hvordan vi bevidst eller ubevidst, udbrede misinformation.

"Det er virkelig skønheden ved naturlig sprogbehandling og maskinlæring, " sagde Wang. "Vi har en enorm mængde data i forskellige formater, og spørgsmålet er:Hvordan gør man ustruktureret data til struktureret viden? Det er et af målene for dyb læring og datavidenskab."

Varme artikler

Varme artikler

-

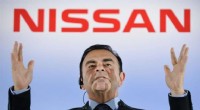

Eks-Nissan-chef Ghosn benægter påstande:medierCarlos Ghosn blev fyret som Nissan -formand torsdag, et spektakulært fald fra nåde for den engang ærede chef, hvis anholdelse og afvisning har bedøvet erhvervslivet Nissans tidligere formand Carlo

Eks-Nissan-chef Ghosn benægter påstande:medierCarlos Ghosn blev fyret som Nissan -formand torsdag, et spektakulært fald fra nåde for den engang ærede chef, hvis anholdelse og afvisning har bedøvet erhvervslivet Nissans tidligere formand Carlo -

Den græske domstol har besluttet at udlevere mistænkt for cyberkriminalitet til FrankrigI denne onsdag, 4. okt. 2017 filbillede, politibetjente eskorterer Alexander Vinnik, centrum, da de forlader et retshus i den nordgræske by Thessaloniki. En græsk domstol har fredag afgjort, 13. jul

Den græske domstol har besluttet at udlevere mistænkt for cyberkriminalitet til FrankrigI denne onsdag, 4. okt. 2017 filbillede, politibetjente eskorterer Alexander Vinnik, centrum, da de forlader et retshus i den nordgræske by Thessaloniki. En græsk domstol har fredag afgjort, 13. jul -

London fører Europa for teknologiinvesteringer:undersøgelseLondons teknologiske risikokapitalscene flyver højt, finder en undersøgelse London er det bedste valg i Europa for venturekapitalinvesteringer i teknologivirksomheder, ifølge en undersøgelse fra r

London fører Europa for teknologiinvesteringer:undersøgelseLondons teknologiske risikokapitalscene flyver højt, finder en undersøgelse London er det bedste valg i Europa for venturekapitalinvesteringer i teknologivirksomheder, ifølge en undersøgelse fra r -

Vedvarende transportbrændstoffer fra vand og kuldioxidHeliostatsporing på SUN-to-LIQUID facilitet på IMDEA (Foto:Erik Koepf) © ETH Zürich 2017 Overgangen fra fossile til vedvarende brændstoffer er en af fremtidens vigtigste udfordringer. SUN-to-LIQ

Vedvarende transportbrændstoffer fra vand og kuldioxidHeliostatsporing på SUN-to-LIQUID facilitet på IMDEA (Foto:Erik Koepf) © ETH Zürich 2017 Overgangen fra fossile til vedvarende brændstoffer er en af fremtidens vigtigste udfordringer. SUN-to-LIQ

- Rekordstor terahertz laserstråle

- Selvkørende biler skal reducere trafikdræbte med mindst 75 procent for at blive på vejene

- Hvad er meningen med en Ph-skala?

- Sådan checker du efter rimelighed i Multiplication

- Indiske bønder chokerede, da formodet meteorit styrter ned i rismarken

- Længerevarende fejl i sensoraflæsninger kan føre til opvarmnings- og køledesignfejl