Giver smarte køretøjer deres retningssans

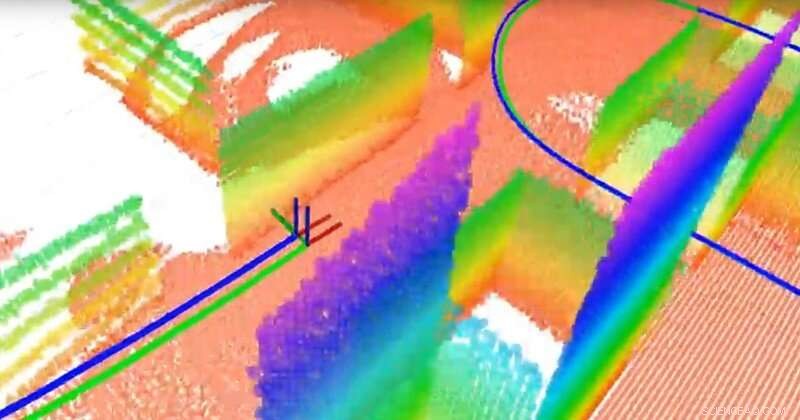

Holdet byggede et 3-D-planbaseret kort ved hjælp af en 3-D LiDAR og en inertisensor. LiDAR er ligesom radar, men bruger lys i stedet for radiobølger. Punkter med forskellige farver er de forskellige fly (som tjener som vartegn for navigation), den grønne linje er den sande bane, og den blå linje er den estimerede bane beregnet af teamets simultane lokalisering og kortlægning (SLAM) algoritme. Kredit:University of Delaware

Forskere rundt om i verden ræser om at udvikle selvkørende køretøjer, men nogle få væsentlige komponenter mangler endnu at blive perfektioneret. Den ene er lokalisering - køretøjets evne til at bestemme sin plads og bevægelse. En anden er kortlægning - køretøjernes evne til at modellere sine omgivelser, så de sikkert kan transportere passagerer til det rigtige sted.

Spørgsmålet er:Hvordan giver man et køretøj en retningsfølelse? Mens GPS-enheder (Global Positioning Satellite) kan hjælpe, de er ikke tilgængelige eller pålidelige i alle sammenhænge. I stedet, mange eksperter undersøger samtidig lokalisering og kortlægning, eller SLAM, et notorisk vanskeligt problem inden for robotteknologi. Nye algoritmer udviklet af Guoquan (Paul) Huang, en adjunkt i maskinteknik, el- og computerteknik, og computer- og informationsvidenskab ved University of Delaware, bringer svaret tættere på øjnene.

Huang bruger visuelle-inerti-navigationssystemer, der kombinerer inerti-sensorer, som indeholder gyroskoper til at bestemme orientering og accelerometre til at bestemme acceleration, sammen med kameraer. Ved at bruge data fra disse relativt billige, bredt tilgængelige komponenter, Huang måler og beregner bevægelse og lokalisering.

For eksempel, da hans team sluttede deres system til en bærbar computer og bar det rundt i UD's Spencer Laboratory, hjemsted for Institut for Maskinteknik, de genererede tilstrækkelige data til at kortlægge bygningen, mens de sporede selve den bærbare computers bevægelse. I et selvkørende køretøj, lignende sensorer og kameraer ville blive knyttet til en robot i køretøjet.

Et autonomt køretøjs evne til at spore sin egen bevægelse og bevægelsen af objekter omkring det er kritisk. "Vi er nødt til at lokalisere køretøjet, før vi automatisk kan kontrollere køretøjet, " sagde Huang. "Køretøjet skal kende sin placering for at kunne fortsætte."

Så er der spørgsmålet om sikkerhed. "I et byscenarie, for eksempel, der er fodgængere og andre køretøjer, så ideelt set skal køretøjet være i stand til at spore sin egen bevægelse såvel som bevægelsen af bevægelige genstande i sine omgivelser, " sagde Huang.

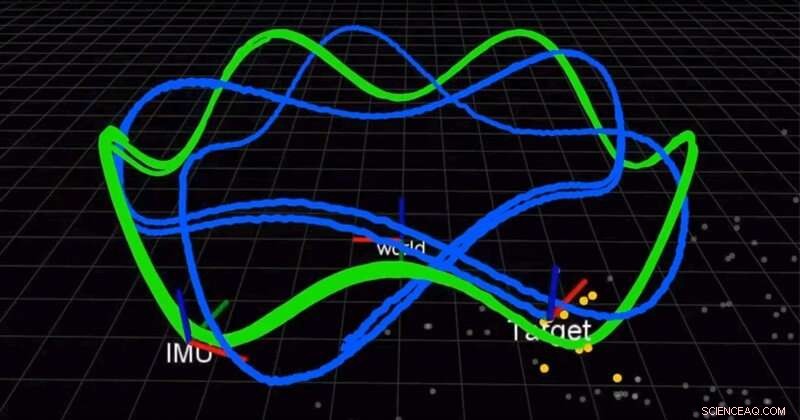

Holdet bruger et kamera og en inertimålenhed (IMU) til samtidig at lokalisere en robot og spore et bevægende mål. Den grønne linje er robottens bane, og den blå linje er målets bane. Kredit:University of Delaware

I et papir offentliggjort tidligere på året i International Journal of Robotics Research (IJRR), Huang og hans team fandt en bedre, mere nøjagtig løsning til at kombinere inertimålingerne. Indtil nu, videnskabsmænd brugte diskret integration, en calculus-teknik, der tilnærmer arealet under en kurve, at tilnærme løsningen. I stedet, Huangs gruppe fandt en løsning og beviste, at den var bedre end eksisterende metoder. Endnu bedre, de deler deres løsning.

"Vi åbner vores kode. Den er på GitHub, " sagde Huang. "Mange mennesker har brugt vores kode til deres systemer." I et andet nyligt IJRR papir, Huang og hans team omformulerede SLAM-problemet som en formel, der beregner små trin af bevægelse af robotterne udstyret med de visuelle og inertisensorer. Mange af disse forskningsvideoer kan findes på Huangs Lab YouTube-kanal.

Disse opdagelser kunne have applikationer ud over autonome køretøjer, fra biler til luftdroner til undervandsfartøjer og meget mere. Huangs algoritmer kan også bruges til at udvikle augmented reality og virtual reality-applikationer til mobile enheder såsom smartphones, som allerede har kameraer og inertisensorer ombord.

"Disse sensorer er meget almindelige, så de fleste mobile enheder, smartphones, selv droner og køretøjer har disse sensorer, " sagde Huang. "Vi forsøger at udnytte de eksisterende billige sensorer og levere en lokaliseringsløsning, en bevægelsessporingsløsning."

I 2018 og igen i 2019, Huang modtog en Google Daydream (AR/VR) Faculty Research Award for at støtte dette arbejde.

"Folk ser, at robotter bliver den næste store ting i det virkelige liv, så det er derfor industrien faktisk driver dette forskningsfelt meget, " sagde Huang.

Sidste artikelFem måder AI kan gøre din bil så smart som en menneskelig passager

Næste artikelArgonspray bevarer rester af flaskevin

Varme artikler

Varme artikler

-

Franske myndigheder afviser Fords lukningsplanFord, som annoncerede Acquitaine-fabrikkens lukning for næsten et år siden, sidste måned afviste det franske statsstøttede Punch-Powerglide-udkøbstilbud De franske myndigheder har afvist en plan f

Franske myndigheder afviser Fords lukningsplanFord, som annoncerede Acquitaine-fabrikkens lukning for næsten et år siden, sidste måned afviste det franske statsstøttede Punch-Powerglide-udkøbstilbud De franske myndigheder har afvist en plan f -

Ny teknik bruger strømanomalier til at identificere malware i integrerede systemerKredit:CC0 Public Domain Forskere fra North Carolina State University og University of Texas i Austin har udviklet en teknik til at opdage typer af malware, der bruger et systems arkitektur til at

Ny teknik bruger strømanomalier til at identificere malware i integrerede systemerKredit:CC0 Public Domain Forskere fra North Carolina State University og University of Texas i Austin har udviklet en teknik til at opdage typer af malware, der bruger et systems arkitektur til at -

Æble, Broadcom dømt til at betale 1,1 mia. USD for patentkrænkelseBåde Apple og Broadcom indikerede, at de planlagde at anke dommen, der fandt, at de krænkede et californisk universitets patent En jury i Los Angeles beordrede onsdag Apple og Broadcom til at beta

Æble, Broadcom dømt til at betale 1,1 mia. USD for patentkrænkelseBåde Apple og Broadcom indikerede, at de planlagde at anke dommen, der fandt, at de krænkede et californisk universitets patent En jury i Los Angeles beordrede onsdag Apple og Broadcom til at beta -

Vil en Apple iPhone 12 med 5G endelig få dig til at opgradere?Kredit:CC0 Public Domain Mange af jer har ikke følt sig tvunget til at opdatere din iPhone eller anden smartphone på det seneste. De nyeste håndsæt fra Apple, Samsung og alle de andre har bestemt

Vil en Apple iPhone 12 med 5G endelig få dig til at opgradere?Kredit:CC0 Public Domain Mange af jer har ikke følt sig tvunget til at opdatere din iPhone eller anden smartphone på det seneste. De nyeste håndsæt fra Apple, Samsung og alle de andre har bestemt

- Fysikere demonstrerer afblandingsadfærd af roterende partikler

- Plads, ikke Brexit, er sidste grænse for skotsk forpost

- Brug af calculus i Engineering

- Hvilke elementer gør jordens atmosfære?

- Sådan konverteres gallons til metriske toner

- Underminerer coronavirus-hjælp til nyhedsmedier journalistisk troværdighed?