At vise robotter hård kærlighed hjælper dem med at lykkes, finder en ny undersøgelse

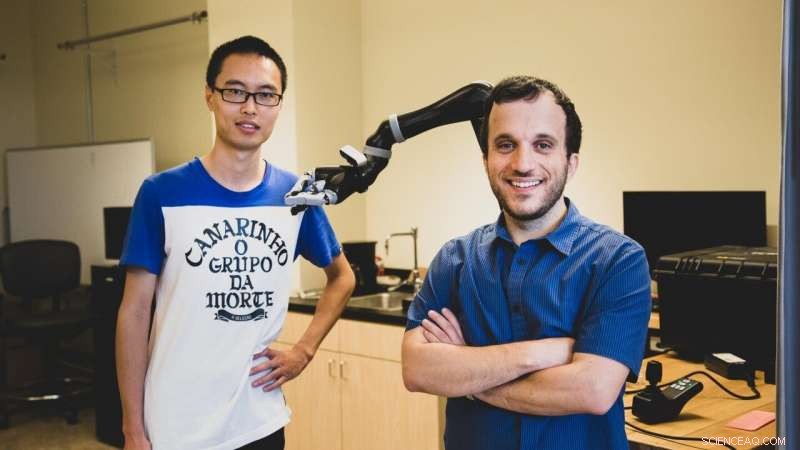

USC -ph.d. -studerende Jiali Duan (tv) og Stefanos Nikolaidis, en adjunkt i datalogi, bruge forstærkningslæring, en teknik, hvor kunstig intelligens programmer 'lærer' ved gentagne eksperimenter. Kredit:Haotian Mai.

Ifølge en ny undersøgelse foretaget af computerforskere fra USC, at hjælpe en robot med at lykkes, du skal muligvis vise det en hård kærlighed.

I en computersimuleret manipulationsopgave, forskerne fandt ud af, at træning af en robot med en menneskelig modstander væsentligt forbedrede grebet om objekter.

"Dette er den første robotindlæringsindsats ved hjælp af modstridende menneskelige brugere, "sagde studieforfatter Stefanos Nikolaidis, en adjunkt i datalogi.

"Forestil dig det som at spille en sport:hvis du spiller tennis med en, der altid lader dig vinde, du bliver ikke bedre. Det samme med robotter. Hvis vi vil have dem til at lære en manipulationsopgave, såsom at gribe, så de kan hjælpe mennesker, vi er nødt til at udfordre dem. "

Studiet, "Robotlæring via menneskelige modspil, "blev præsenteret den 4. november på den internationale konference om intelligente robotter og systemer. USC Ph.D. -studerende Jiali Duan og Qian Wang er hovedforfattere, rådgivet af professor C. C. Jay Kuo, med yderligere medforfatter Lerrel Pinto fra Carnegie Mellon University.

At lære af praksis

Nikolaidis, der sluttede sig til USC Viterbi School of Engineering i 2018, og hans team bruger forstærkningslæring, en teknik, hvor kunstig intelligens programmer "lærer" fra gentagne eksperimenter.

I stedet for at være begrænset til at udføre en lille række gentagne opgaver, såsom industrielle robotter, Robotsystemet "lærer" baseret på tidligere eksempler, i teorien øger omfanget af opgaver, den kan udføre.

Men at skabe robotter til generelle formål er notorisk udfordrende, skyldes delvis den nødvendige uddannelse. Robotsystemer skal se et stort antal eksempler for at lære at manipulere et objekt på en menneskelig måde.

For eksempel, OpenAIs imponerende robotsystem lærte at løse en Rubiks terning med en humanoid hånd, men krævede tilsvarende 10, 000 års simuleret træning for at lære at manipulere terningen.

Vigtigere, robotens fingerfærdighed er meget specifik. Uden omfattende uddannelse, den kan ikke opfange et objekt, manipulere det med et andet greb, eller tag fat i og håndter en anden genstand.

"Som et menneske, selvom jeg kender objektets placering, Jeg ved ikke præcis, hvor meget den vejer, eller hvordan den vil bevæge sig eller opføre sig, når jeg tager den, alligevel gør vi dette med succes næsten hele tiden, "sagde Nikolaidis.

"Det er fordi folk er meget intuitive om, hvordan verden opfører sig, men robotten er som en nyfødt baby. "

Med andre ord, Robotsystemer har svært ved at generalisere, en færdighed, som mennesker tager for givet. Det kan virke trivielt, men det kan have alvorlige konsekvenser. Hvis der er hjælpemidler til robotter, såsom at gribe robotter, skal opfylde deres løfte om at hjælpe mennesker med handicap, Robotsystemer skal kunne fungere pålideligt i virkelige miljøer.

Menneske i sløjfen

En forskningslinje, der har været ganske vellykket med at overvinde dette problem, er at have et "menneske i løkken". Med andre ord, mennesket giver feedback til robotsystemet ved at demonstrere evnen til at fuldføre opgaven.

Men, indtil nu, disse algoritmer har gjort en stærk antagelse om, at en samarbejdende menneskelig vejleder hjælper robotten.

"Jeg har altid arbejdet på samarbejde mellem mennesker og robotter, men i virkeligheden, mennesker vil ikke altid være samarbejdspartnere med robotter i naturen, "sagde Nikolaidis.

Som et eksempel, han peger på en undersøgelse foretaget af japanske forskere, som satte en robot løs i et offentligt indkøbskompleks og observerede børn "handle voldeligt" mod det flere gange.

Så, tænkte Nikolaidis, hvad hvis vi udnyttede vores menneskelige tilbøjelighed til i stedet at gøre tingene sværere for robotten? I stedet for at vise det, hvordan man bedre griber et objekt, hvad hvis vi prøvede at trække det væk? Ved at tilføje udfordring, tankegangen går, systemet ville lære at være mere robust over for den virkelige verdens kompleksitet.

Udfordringselement

Eksperimentet gik sådan her:i en computersimulering, robotten forsøger at gribe et objekt. Mennesket, ved computeren, observerer den simulerede robots greb. Hvis grebet er vellykket, mennesket forsøger at rive genstanden fra robotens greb, ved hjælp af tastaturet til at signalere retning.

Tilføjelse af dette element af udfordring hjælper robotten med at lære forskellen mellem en svag forståelse (f.eks. holder en flaske øverst), mod et fast greb (holder det i midten), hvilket gør det meget sværere for den menneskelige modstander at rive væk.

Det var en lidt skør idé, indrømmer Nikolaidis, men det virkede.

Forskerne fandt, at systemet uddannet med den menneskelige modstander afviste ustabile greb, og hurtigt lært robuste greb til disse objekter. I et eksperiment, modellen opnåede en succesfrekvens på 52 procent med en menneskelig modstander mod en 26,5 procent, der fatte succesraten med en menneskelig samarbejdspartner.

"Robotten lærte ikke kun at gribe objekter mere robust, men også oftere at lykkes med nye objekter i en anden retning, fordi den har lært en mere stabil forståelse, "sagde Nikolaidis.

De fandt også ud af, at modellen, der blev trænet med en menneskelig modstander, klarede sig bedre end en simuleret modstander, som havde 28 procent, der forstod succesraten. Så, Robotsystemer lærer bedst af kød-og-blod-modstandere.

"Det er fordi mennesker bedre kan forstå stabilitet og robusthed end lærde modstandere, "forklarede Nikolaidis.

"Robotten forsøger at samle ting op og hvis mennesket forsøger at forstyrre, det fører til mere stabile greb. Og fordi den har lært en mere stabil forståelse, det vil lykkes oftere, selvom objektet er i en anden position. Med andre ord, det har lært at generalisere. Det er en stor ting. "

At finde en balance

Nikolaidis håber at få systemet til at fungere på en rigtig robotarm inden for et år. Dette vil præsentere en ny udfordring - i den virkelige verden, den mindste smule friktion eller støj i en robots led kan smide tingene af. Men Nikolaidis er håbefuld om fremtiden for modstridende læring til robotteknologi.

"Jeg tror, vi lige har skrabet overfladen af potentielle anvendelser af læring via modstridende menneskelige spil, "sagde Nikolaidis.

"Vi er begejstrede for at udforske menneskelig in-the-loop modstridende læring også i andre opgaver, såsom forhindring af forhindringer for robotarme og mobile robotter, såsom selvkørende biler. "

Dette rejser spørgsmålet:hvor langt er vi villige til at tage modstridende læring? Ville vi være villige til at sparke og slå robotter til underkastelse? Svaret, sagde Nikolaidis, ligger i at finde en balance mellem hård kærlighed og opmuntring med vores robotteknikker.

"Jeg føler, at hård kærlighed - i forbindelse med den algoritme, vi foreslår - igen er som en sport:den falder inden for bestemte regler og begrænsninger, "sagde Nikolaidis.

"Hvis mennesket bare bryder robotens griber, robotten vil konstant mislykkes og aldrig lære. Med andre ord, robotten skal udfordres, men stadig få lov til at lykkes for at lære. "

Varme artikler

Varme artikler

-

Undersøgelse tyder på, at solenergi er en god mulighed for bjergrige schweiziske regionerKredit:CC0 Public Domain En trio af forskere ved École Polytechnique Fédérale de Lausanne har fundet ud af, at solpaneler kan give meget mere strøm til Schweiz, end man tidligere har troet. I dere

Undersøgelse tyder på, at solenergi er en god mulighed for bjergrige schweiziske regionerKredit:CC0 Public Domain En trio af forskere ved École Polytechnique Fédérale de Lausanne har fundet ud af, at solpaneler kan give meget mere strøm til Schweiz, end man tidligere har troet. I dere -

Sådan beregnes trådtemperaturresistens Når strøm er kendtMetal trådstænger, tråde og filamenter udviser modstandsværdier, der er baseret på deres metalliske sammensætning, tværsnitsareal og driftstemperatur ved steady state strømningsforhold. Modstanden af

Sådan beregnes trådtemperaturresistens Når strøm er kendtMetal trådstænger, tråde og filamenter udviser modstandsværdier, der er baseret på deres metalliske sammensætning, tværsnitsareal og driftstemperatur ved steady state strømningsforhold. Modstanden af -

Al magt til protonen:Forskere gør batteriets gennembrudDet RMIT-udviklede protonbatteri forbundet til et voltmeter. Den fungerende prototype har en energi pr. masseenhed, der allerede kan sammenlignes med kommercielt tilgængelige lithium-ion-batterier. Kr

Al magt til protonen:Forskere gør batteriets gennembrudDet RMIT-udviklede protonbatteri forbundet til et voltmeter. Den fungerende prototype har en energi pr. masseenhed, der allerede kan sammenlignes med kommercielt tilgængelige lithium-ion-batterier. Kr -

Fantomprojekt:Student 3-D udskriver det første menneske til stråleterapiforskningFor det seneste år, LSU Biological and Agricultural Engineering senior Meagan Moore fra Baton Rouge har arbejdet på at 3D-printe den første menneskelige krop i faktisk størrelse til forskning i stråle

Fantomprojekt:Student 3-D udskriver det første menneske til stråleterapiforskningFor det seneste år, LSU Biological and Agricultural Engineering senior Meagan Moore fra Baton Rouge har arbejdet på at 3D-printe den første menneskelige krop i faktisk størrelse til forskning i stråle

- Sådan beregnes konduktivitet på grund af koncentration

- Hvorfor offentlige rum i europæiske byer bliver homogeniserede

- Rene carbon nanorør med suveræne egenskaber

- Indonesien Mt Merapi bryder ud, spytte aske 6 km høj

- En tredjedel af vores affald kommer fra bygninger. Denne er designet til genbrug og reducerer emissi…

- Undersøgelse gør indhug i landbruget af svanehals-barnakler