Forudsige, hvor godt neurale netværk vil skalere

Kredit:Massachusetts Institute of Technology

For alle de fremskridt, forskerne har gjort med maskinlæring, når de har hjulpet os med at gøre ting som f.eks. køre bil og opdage kræft, vi tænker sjældent over, hvor energikrævende det er at vedligeholde de massive datacentre, der gør sådan et arbejde muligt. Ja, en undersøgelse fra 2017 forudsagde, at inden 2025, internetforbundne enheder ville bruge 20 procent af verdens elektricitet.

Maskinlæringens ineffektivitet er til dels en funktion af, hvordan sådanne systemer skabes. Neurale netværk udvikles typisk ved at generere en indledende model, justere et par parametre, prøver igen, og derefter skylning og gentagelse. Men denne tilgang betyder, at betydelig tid, energi og computerressourcer bliver brugt på et projekt, før nogen ved, om det rent faktisk vil fungere.

MIT kandidatstuderende Jonathan Rosenfeld sammenligner det med 1600-tallets videnskabsmænd, der søger at forstå tyngdekraften og planeternes bevægelse. Han siger, at den måde, vi udvikler maskinlæringssystemer på i dag - i mangel af sådanne forståelser - har begrænset forudsigelseskraft og er derfor meget ineffektiv.

"Der er stadig ikke en samlet måde at forudsige, hvor godt et neuralt netværk vil præstere givet visse faktorer som modellens form eller mængden af data, den er blevet trænet på, siger Rosenfeld, som for nylig udviklede en ny ramme om emnet sammen med kolleger ved MIT's Computer Science and Artificial Intelligence Lab (CSAIL). "Vi ønskede at undersøge, om vi kunne flytte maskinlæring fremad ved at prøve at forstå de forskellige relationer, der påvirker nøjagtigheden af et netværk."

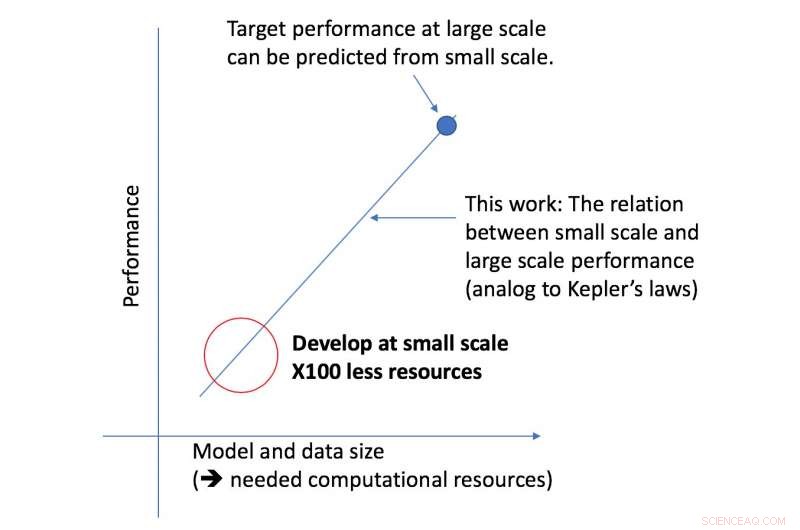

CSAIL-teamets nye ramme ser på en given algoritme i mindre skala, og, baseret på faktorer som dens form, kan forudsige, hvor godt det vil fungere i større skala. Dette giver en dataforsker mulighed for at afgøre, om det er værd at fortsætte med at bruge flere ressourcer på at træne systemet yderligere.

"Vores tilgang fortæller os ting som mængden af data, der er nødvendig for, at en arkitektur kan levere en specifik målydelse, eller den mest beregningseffektive afvejning mellem data og modelstørrelse, " siger MIT-professor Nir Shavit, som skrev det nye papir sammen med Rosenfeld, tidligere ph.d.-studerende Yonatan Belinkov og Amir Rosenfeld fra York University. "Vi ser disse resultater som at have vidtrækkende implikationer på området ved at give forskere i den akademiske verden og industrien mulighed for bedre at forstå sammenhængen mellem de forskellige faktorer, der skal vejes, når man udvikler modeller for dyb læring, og at gøre det med de begrænsede beregningsressourcer, der er tilgængelige for akademikere."

Rammen gjorde det muligt for forskere at præcist forudsige ydeevne på den store model- og dataskala ved hjælp af halvtreds gange mindre beregningskraft.

Det aspekt af dyb læringspræstation, som teamet fokuserede på, er den såkaldte "generaliseringsfejl, " som refererer til den fejl, der genereres, når en algoritme testes på data fra den virkelige verden. Holdet brugte konceptet modelskalering, hvilket involverer at ændre modellens form på specifikke måder for at se dens effekt på fejlen.

Som et næste skridt, holdet planlægger at udforske de underliggende teorier om, hvad der får en specifik algoritmes præstation til at lykkes eller mislykkes. Dette inkluderer at eksperimentere med andre faktorer, der kan påvirke træningen af deep learning-modeller.

Sidste artikelSværmende robotter undgår kollisioner, trafikpropper

Næste artikelEnheden efterligner mangrovernes vandrensende kraft

Varme artikler

Varme artikler

-

Toyota rapporterer rekordstort nettoresultat i første halvår, salgToyotas nettoresultat blev styrket af bestræbelser på at reducere omkostningerne Den japanske bilgigant Toyota rapporterede torsdag et rekordstort nettooverskud og salg for første halvår, med en o

Toyota rapporterer rekordstort nettoresultat i første halvår, salgToyotas nettoresultat blev styrket af bestræbelser på at reducere omkostningerne Den japanske bilgigant Toyota rapporterede torsdag et rekordstort nettooverskud og salg for første halvår, med en o -

Smart home dashboard for bedre at visualisere energiforbrugetDukes Smart Home. Kredit:Duke University Dukes Smart Home genererer en masse data om dets energiforbrug, men ingen forstår, hvad det betyder - endnu. For at give mening med det hele, et tværfaglig

Smart home dashboard for bedre at visualisere energiforbrugetDukes Smart Home. Kredit:Duke University Dukes Smart Home genererer en masse data om dets energiforbrug, men ingen forstår, hvad det betyder - endnu. For at give mening med det hele, et tværfaglig -

Lyft fører patentsnak om selvkørende sikkerhed via beskeder til fodgængere, cyklisterKredit:Patentnummer:US010152892 Lyft er i nyhederne, da den amerikanske patentmyndighed har givet Lyft et patent på et autonomt køretøjsnotifikationssystem. Patentet diskuterer sikkerhedsadvarsl

Lyft fører patentsnak om selvkørende sikkerhed via beskeder til fodgængere, cyklisterKredit:Patentnummer:US010152892 Lyft er i nyhederne, da den amerikanske patentmyndighed har givet Lyft et patent på et autonomt køretøjsnotifikationssystem. Patentet diskuterer sikkerhedsadvarsl -

Højteknologisk, kugleformet arena, der kommer til Las Vegas StripDenne konceptuelle gengivelse udgivet af Madison Square Garden viser et transparent udseende tema udvendigt på MSG Sphere Las Vegas arena. En 18, 000-sæde, kugleformet mødested, der vil være vært for

Højteknologisk, kugleformet arena, der kommer til Las Vegas StripDenne konceptuelle gengivelse udgivet af Madison Square Garden viser et transparent udseende tema udvendigt på MSG Sphere Las Vegas arena. En 18, 000-sæde, kugleformet mødested, der vil være vært for

- Havde den gamle Maya parker?

- Scholes finder en ny magnetfelteffekt i diamagnetiske molekyler

- Mening:Antropocæn eksisterer ikke, og fremtidens arter vil ikke genkende det

- Selvsamlende silikonebaserede polymerer

- Tvivlsom stabilitet af dissipative topologiske modeller for klassiske og kvantesystemer

- Luftforureningen faldt kraftigt under nedlukningen