Tillid til algoritmiske råd fra computere kan gøre os blinde for fejl, siger undersøgelse

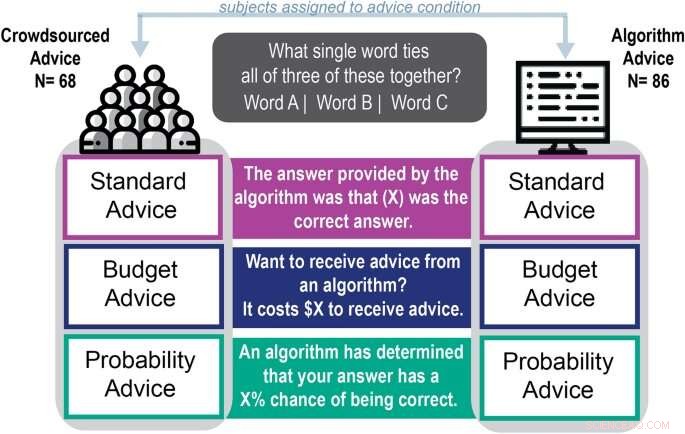

Skematisk af eksperimentel procedure. Kredit:Scientific Reports (2022). DOI:10.1038/s41598-022-18638-2

Med autokorrektur og automatisk genererede e-mail-svar tilbyder algoritmer masser af hjælp til at hjælpe folk med at udtrykke sig.

Men ny forskning fra University of Georgia viser, at folk, der er afhængige af computeralgoritmer til hjælp med sprogrelaterede, kreative opgaver, ikke forbedrede deres ydeevne og var mere tilbøjelige til at stole på rådgivning af lav kvalitet.

Aaron Schecter, en assisterende professor i ledelsesinformationssystemer ved Terry College of Business, fik sin undersøgelse "Human preferences to algorithmic advice in a word association task" offentliggjort i denne måned i Scientific Reports . Hans medforfattere er Nina Lauharatanahirun, en biobehavioral sundhedsassistent professor ved Pennsylvania State University, og nylig Terry College Ph.D. kandidat og nuværende assisterende professor ved Northeastern University, Eric Bogert.

Artiklen er den anden i teamets undersøgelse af individuel tillid til rådgivning genereret af algoritmer. I et papir fra april 2021 fandt teamet ud af, at folk var mere afhængige af algoritmiske råd til at tælle opgaver end på råd, der angiveligt blev givet af andre deltagere.

Denne undersøgelse havde til formål at teste, om folk udskudte til en computers råd, når de tacklede mere kreative og sprogafhængige opgaver. Holdet fandt ud af, at deltagerne var 92,3 % mere tilbøjelige til at bruge råd tilskrevet en algoritme end til at tage imod råd tilskrevet mennesker.

"Denne opgave krævede ikke den samme type tænkning (som tælleopgaven i den tidligere undersøgelse), men faktisk så vi de samme skævheder," sagde Schecter. "De ville stadig bruge algoritmens svar og have det godt med det, selvom det ikke hjælper dem med at gøre det bedre."

Brug af en algoritme under ordtilknytning

For at se, om folk ville stole mere på computergenererede råd til sprogrelaterede opgaver, gav Schecter og hans medforfattere 154 onlinedeltagere dele af Remote Associates Test, en ordassocieringstest, der blev brugt i seks årtier til at vurdere en deltagers kreativitet.

"Det er ikke ren kreativitet, men ordforening er en fundamentalt anden slags opgave end at lave en stockprojektion eller tælle objekter på et foto, fordi det involverer lingvistik og evnen til at forbinde forskellige ideer," sagde han. "Vi tænker på dette som mere subjektivt, selvom der er et rigtigt svar på spørgsmålene."

Under testen blev deltagerne bedt om at finde på et ord, der binder tre eksempelord sammen. Hvis ordene for eksempel var base, room og bowling, ville svaret være bold.

Deltagerne valgte et ord til at besvare spørgsmålet og blev tilbudt et hint tilskrevet en algoritme eller et tip tilskrevet en person og fik lov til at ændre deres svar. Præferencen for algoritme-afledt rådgivning var stærk på trods af spørgsmålets sværhedsgrad, måden rådgivningen var formuleret på eller rådgivningens kvalitet.

Deltagerne, der tog imod algoritmens råd, var også dobbelt så sikre på deres svar som folk, der brugte personens råd. På trods af deres tillid til deres svar, var de 13 % mindre tilbøjelige end dem, der brugte menneskebaserede råd til at vælge rigtige svar.

"Jeg vil ikke sige, at rådet gjorde folk værre, men det faktum, at de ikke gjorde det bedre, men alligevel havde det bedre med deres svar, illustrerer problemet," sagde han. "Deres selvtillid steg, så de vil sandsynligvis bruge algoritmiske råd og have det godt med det, men de vil ikke nødvendigvis have ret.

Skal du acceptere autokorrektur, når du skriver en e-mail?

"Hvis jeg har en autofuldførelse eller autokorrekt funktion på min e-mail, som jeg tror på, tænker jeg måske ikke på, om det gør mig bedre. Jeg vil bare bruge det, fordi jeg føler mig sikker på at gøre det."

Schechter og kolleger kalder denne tendens til at acceptere computergenereret rådgivning uden øje for dets kvalitet som automatiseringsbias. At forstå, hvordan og hvorfor menneskelige beslutningstagere afholder sig fra maskinlæringssoftware for at løse problemer, er en vigtig del af forståelsen af, hvad der kunne gå galt på moderne arbejdspladser, og hvordan man kan afhjælpe det.

"Ofte, når vi taler om, hvorvidt vi kan tillade algoritmer at træffe beslutninger, er det at have en person i løkken givet som løsningen til at forhindre fejl eller dårlige resultater," sagde Schecter. "Men det kan ikke være løsningen, hvis folk er mere tilbøjelige end ikke til at udsætte sig for, hvad algoritmen rådgiver." + Udforsk yderligere

Folk stoler måske mere på computere end mennesker

Sidste artikelBetyder lastbiler Trump? AI viser, hvordan mennesker fejlbedømmer billeder

Næste artikelFøler tryk ved hjælp af papir

Varme artikler

Varme artikler

-

Dyson skifter gear med elbilens navEfter at have revolutioneret den ydmyge støvsuger, Brexit-støttende milliardær James Dyson har nu rettet blikket mod elbilmarkedet James Dyson, den Brexit-støttende milliardær bag støvsugerne, der

Dyson skifter gear med elbilens navEfter at have revolutioneret den ydmyge støvsuger, Brexit-støttende milliardær James Dyson har nu rettet blikket mod elbilmarkedet James Dyson, den Brexit-støttende milliardær bag støvsugerne, der -

CyLab-forskere foreslår nye regler for retfærdighed på internettetRanysha Ware, en CSD Ph.D. studerende, præsenterer nye regler for internetretfærdighed på HotNets2019 på Princeton University. Kredit:Carnegie Mellon Universitys College of Engineering Kun få uger

CyLab-forskere foreslår nye regler for retfærdighed på internettetRanysha Ware, en CSD Ph.D. studerende, præsenterer nye regler for internetretfærdighed på HotNets2019 på Princeton University. Kredit:Carnegie Mellon Universitys College of Engineering Kun få uger -

Hvordan intelligente arbejdsstationer vil bruge AI til at forbedre sundhed og lykkeKredit:CC0 Public Domain Statistikker viser, at hvis du læser dette på arbejdet, du er sandsynligvis indendørs ved et bord eller et skrivebord. Hvis så, pause et øjeblik:Hvordan er din kropsholdni

Hvordan intelligente arbejdsstationer vil bruge AI til at forbedre sundhed og lykkeKredit:CC0 Public Domain Statistikker viser, at hvis du læser dette på arbejdet, du er sandsynligvis indendørs ved et bord eller et skrivebord. Hvis så, pause et øjeblik:Hvordan er din kropsholdni -

De gigantiske kinesiske virksomheder, der former verdens industrierCRRC, verdens største togproducent, er ikke den eneste industrielle gigant, der dukker op fra Kina Det var frygten for at blive domineret af en kinesisk gigant, der udløste et forsøg fra store fra

De gigantiske kinesiske virksomheder, der former verdens industrierCRRC, verdens største togproducent, er ikke den eneste industrielle gigant, der dukker op fra Kina Det var frygten for at blive domineret af en kinesisk gigant, der udløste et forsøg fra store fra

- Kondensationsbaseret metode kunne skabe stabile emulsioner i nanoskala

- Hvad gør en klassisk sang? Økonomien i de hotteste 100

- Hvad er de seks processer i en faseændring?

- Seagull Behaviors I Jordskælv og Ændringer i Weather

- De største strukturer i universet viser tydeligt lysforskudt rotationssignal

- Flere nyheder, flere bekymringer under pandemi