Undersøgelse fremhæver, hvordan AI-modeller tager potentielt farlige genveje til at løse komplekse genkendelsesopgaver

Kredit:York University

Dybe konvolutionelle neurale netværk (DCNN'er) ser ikke objekter, som mennesker gør - ved at bruge konfigureret formopfattelse - og det kan være farligt i AI-applikationer i den virkelige verden, siger professor James Elder, medforfatter af en undersøgelse fra York University offentliggjort i dag.

Udgivet i Cell Press-tidsskriftet iScience , Deep learning-modeller formår ikke at fange den konfigurerede natur af menneskelig formopfattelse, er en samarbejdsundersøgelse foretaget af Elder, som besidder York Research Chair in Human and Computer Vision og er meddirektør for Yorks Center for AI &Society, og assisterende psykologiprofessor Nicholas Baker ved Loyola College i Chicago, tidligere VISTA-postdoc ved York.

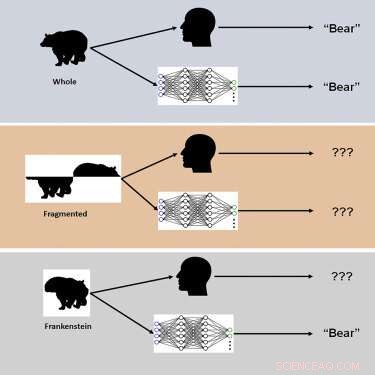

Undersøgelsen brugte nye visuelle stimuli kaldet "Frankensteins" til at udforske, hvordan den menneskelige hjerne og DCNN'er behandler holistiske, konfigurerede objektegenskaber.

"Frankensteins er simpelthen genstande, der er blevet adskilt og sat sammen igen den forkerte vej rundt," siger ældste. "Som et resultat har de alle de rigtige lokale funktioner, men de forkerte steder."

Efterforskerne fandt ud af, at selvom det menneskelige visuelle system er forvirret af Frankensteins, er DCNN'er det ikke - hvilket afslører en ufølsomhed over for konfigurerede objektegenskaber.

"Vores resultater forklarer, hvorfor dybe AI-modeller fejler under visse forhold og peger på behovet for at overveje opgaver ud over objektgenkendelse for at forstå visuel behandling i hjernen," siger Elder. "Disse dybe modeller har en tendens til at tage 'genveje', når de løser komplekse genkendelsesopgaver. Selvom disse genveje kan fungere i mange tilfælde, kan de være farlige i nogle af de AI-applikationer i den virkelige verden, vi i øjeblikket arbejder på med vores industri- og regeringspartnere, " Ældste påpeger.

En sådan applikation er trafikvideosikkerhedssystemer:"Objekterne i en travl trafikplads - køretøjer, cykler og fodgængere - hindrer hinanden og ankommer til en førers øje som et virvar af afbrudte fragmenter," forklarer Elder. "Hjernen er nødt til at gruppere disse fragmenter korrekt for at identificere de korrekte kategorier og placeringer af objekterne. Et AI-system til trafiksikkerhedsovervågning, der kun er i stand til at opfatte fragmenterne individuelt, vil fejle denne opgave, hvilket potentielt misforstår risici for sårbare trafikanter. "

Ifølge forskerne førte ændringer til træning og arkitektur, der havde til formål at gøre netværk mere hjerne-lignende, ikke til konfigureret behandling, og ingen af netværkene var i stand til nøjagtigt at forudsige prøve-for-prøve menneskelige objektdomme. "Vi spekulerer i, at for at matche menneskelig konfigurationsfølsomhed skal netværk trænes til at løse bredere række af objektopgaver uden for kategorigenkendelse," bemærker Elder. + Udforsk yderligere

Fremme menneskelignende opfattelse i selvkørende køretøjer

Varme artikler

Varme artikler

-

Folk bruger ikke deres ferietid - her er en måde at løse det påDer var en følelse af, at du ikke var en dedikeret medarbejder, hvis du faktisk tog på ferie, og holdt op med at arbejde, mens du var væk, sagde Kevin Corliss, grundlægger af Treehoppr. Kredit:Adam G

Folk bruger ikke deres ferietid - her er en måde at løse det påDer var en følelse af, at du ikke var en dedikeret medarbejder, hvis du faktisk tog på ferie, og holdt op med at arbejde, mens du var væk, sagde Kevin Corliss, grundlægger af Treehoppr. Kredit:Adam G -

En metode til at reducere antallet af neuroner i tilbagevendende neurale netværkKredit:Marquez, Suarez-Vargas og Shastri. Et team af forskere ved Queens University, i Canada, har for nylig foreslået en ny metode til at reducere tilfældige tilbagevendende neurale netværk (rRNN

En metode til at reducere antallet af neuroner i tilbagevendende neurale netværkKredit:Marquez, Suarez-Vargas og Shastri. Et team af forskere ved Queens University, i Canada, har for nylig foreslået en ny metode til at reducere tilfældige tilbagevendende neurale netværk (rRNN -

Radikalt lukket flydesign kunne se grønnere himmel tage flugtenEn kunstners syn på PrandtlPlane viser, hvordan fremtidens kommercielle fly kunne se ud. Kredit:Vittorio C/ University of Pisa, Italien, licenseret under CC BY-SA 3.0 Luftfart er en af de mest m

Radikalt lukket flydesign kunne se grønnere himmel tage flugtenEn kunstners syn på PrandtlPlane viser, hvordan fremtidens kommercielle fly kunne se ud. Kredit:Vittorio C/ University of Pisa, Italien, licenseret under CC BY-SA 3.0 Luftfart er en af de mest m -

Orlando -forlaget vedtager realistisk stemmeteknologiKredit:CC0 Public Domain En digital digital udgiver i Orlando har vedtaget teknologi distribueret af Amazon, der får de stilede robotstemmer, der ofte er forbundet med tekst-til-tale-tjenester, ti

Orlando -forlaget vedtager realistisk stemmeteknologiKredit:CC0 Public Domain En digital digital udgiver i Orlando har vedtaget teknologi distribueret af Amazon, der får de stilede robotstemmer, der ofte er forbundet med tekst-til-tale-tjenester, ti

- Ny polymer tackler PFAS -forurening

- Trafikforurening falder i lås - men andre risici for luftkvaliteten stiger, forskere afslører

- Gay-venlige Apple vejer North Carolina trods LGBT-love

- Forskere bruger varme Jupiter-data til at mine exoplanetkemi

- Undersøgelse finder fysisk forvitring af stenbrud vigtigere end tidligere anerkendt

- Hvorfor arbejdsløshedskrav ikke fanger den fulde økonomiske virkning af COVID-19