Skal vi være bekymrede over, at Google AI er sansende?

Kredit:Unsplash/CC0 Public Domain

Fra virtuelle assistenter som Apples Siri og Amazons Alexa, til robotstøvsugere og selvkørende biler, til automatiserede investeringsporteføljeforvaltere og marketingbots, er kunstig intelligens blevet en stor del af vores hverdag. Alligevel, når vi tænker på AI, forestiller mange af os os menneskelignende robotter, som ifølge utallige science fiction-historier vil blive uafhængige og gøre oprør en dag.

Ingen ved dog, hvornår mennesker vil skabe en intelligent eller sansende AI, sagde John Basl, lektor i filosofi ved Northeastern's College of Social Sciences and Humanities, hvis forskning fokuserer på etikken i nye teknologier som AI og syntetisk biologi.

"Når du hører Google tale, taler de, som om det her er lige rundt om hjørnet eller helt sikkert inden for vores liv," sagde Basl. "Og de er meget cavaliere omkring det."

Måske er det derfor, en nylig Washington Post-historie har gjort så stort et sprøjt. I historien siger Googles ingeniør Blake Lemoine, at virksomhedens kunstigt intelligente chatbot-generator, LaMDA, som han havde adskillige dybe samtaler med, kan være sansende. Det minder ham om et 7- eller 8-årigt barn, fortalte Blake til Washington Post.

Basl mener dog, at beviserne nævnt i Washington Post-artiklen ikke er nok til at konkludere, at LaMDA er sansende.

"Reaktioner som 'Vi har skabt sansende AI' synes jeg er ekstremt overdrevne," sagde Basl.

Beviset ser ud til at være funderet i LaMDAs sproglige evner og de ting, det taler om, sagde Basl. LaMDA, en sprogmodel, blev imidlertid designet specifikt til at tale, og optimeringsfunktionen, der bruges til at træne den til at behandle sprog og konversere, tilskynder dens algoritme til at producere denne sproglige evidens.

"Det er ikke sådan, at vi tog til en fremmed planet og en ting, som vi aldrig gav nogen incitamenter til at begynde at kommunikere med os [begyndte at tale eftertænksomt]," sagde Basl.

Det faktum, at denne sprogmodel kan narre et menneske til at tro, at det er sansende, taler om dets kompleksitet, men det ville være nødvendigt at have nogle andre kapaciteter ud over, hvad det er optimeret til for at vise sansning, sagde Basl.

Der er forskellige definitioner af sansning. Sentient defineres som at være i stand til at opfatte eller føle ting og sammenlignes ofte med sapient.

Basl mener, at sansende AI ville være minimalt bevidst. Den kan være opmærksom på den oplevelse, den har, have positive eller negative holdninger som at føle smerte eller ikke at føle smerte og have ønsker.

"Vi ser den slags række af kapaciteter i dyreverdenen," sagde han.

For eksempel sagde Basl, at hans hund ikke foretrækker, at verden er på den ene måde frem for den anden i nogen dyb forstand, men hun foretrækker tydeligvis sine kiks frem for kiks.

"Det ser ud til at spore noget indre mentalt liv," sagde Basl. "[Men] hun føler ikke terror over klimaændringer."

Det er uklart fra Washington Post-historien, hvorfor Lemoine sammenligner LaMDA med et barn. Han mener måske, at sprogmodellen er lige så intelligent som et lille barn, eller at den har evnen til at lide eller begære som et lille barn, sagde Basl.

"Det kan være forskellige ting. Vi kunne skabe en tænkende AI, der ikke har nogen følelser, og vi kan skabe en følelses-AI, der ikke er rigtig god til at tænke," sagde Basl.

De fleste forskere i AI-samfundet, som består af specialister i maskinlæring, specialister i kunstig intelligens, filosoffer, teknologietikere og kognitive videnskabsmænd, tænker allerede på disse fjerntliggende problemer og bekymrer sig ifølge Basl om tænkedelen.

"Hvis vi skaber en AI, der er super smart, kan det ende med at dræbe os alle," sagde han.

Men Lemoines bekymring handler ikke om det, men snarere om en forpligtelse til at behandle hurtigt skiftende AI-kapaciteter anderledes.

"Jeg er i en bred forstand sympatisk over for den slags bekymringer. Vi er ikke særlig forsigtige med, at det [er] muligt," sagde Basl. "Vi tænker ikke nok over de moralske ting omkring AI, som, hvad kan vi skylde en sansende AI?"

Han mener, at mennesker med stor sandsynlighed vil mishandle en sansende AI, fordi de sandsynligvis ikke vil genkende, at de har gjort det, idet de tror, at det er kunstigt og er ligeglad.

"Vi er bare ikke særlig indstillet på de ting," sagde Basl.

Der er ingen god model at vide, når en AI har opnået sansning. Hvad hvis Googles LaMDA ikke har evnen til at udtrykke sin sansning overbevisende, fordi den kun kan tale via et chatvindue i stedet for noget andet?

"Det er ikke sådan, at vi kan lave hjernescanninger for at se, om det ligner os," sagde han.

En anden tankegang er, at sansende AI kan være umulig generelt på grund af universets fysiske begrænsninger eller begrænset forståelse af bevidsthed.

I øjeblikket har ingen af de virksomheder, der arbejder med AI, inklusive de store spillere som Google, Meta, Microsoft, Apple og statslige agenturer, et eksplicit mål om at skabe sansende AI, sagde Basl. Nogle organisationer er interesserede i at udvikle AGI, eller kunstig generel intelligens, en teoretisk form for AI, hvor en maskine, intelligent som et menneske, ville have evnerne til at løse en lang række problemer, lære og planlægge for fremtiden, ifølge IBM .

"Jeg tror, at den virkelige lære af dette er, at vi ikke har den infrastruktur, vi har brug for, selvom denne person tager fejl," sagde Basl med henvisning til Lemoine.

En infrastruktur omkring AI-spørgsmål kunne bygges på gennemsigtighed, informationsdeling med statslige og/eller offentlige organer og regulering af forskning. Basl går ind for et tværfagligt udvalg, der vil hjælpe med at opbygge en sådan infrastruktur, og det andet, der skal føre tilsyn med teknologerne, der arbejder med kunstig intelligens, og evaluere forskningsforslag og -resultater.

"Bevisproblemet er virkelig svært," sagde Basl. "Vi har ikke en god teori om bevidsthed, og vi har ikke god adgang til beviserne for bevidsthed. Og så har vi heller ikke infrastrukturen. Det er de vigtigste ting."

Varme artikler

Varme artikler

-

Ny ethanolkonverteringsmetode kan reducere drivhusgasemissionerne mellem 40 og 96 procentKredit:CC0 Public Domain En måde at øge bæredygtigheden på er at reducere kulstofemissionerne inden for transport. I 2017 overgik drivhusgasemissioner (GHG) fra denne sektor alle andre i USA, tegn

Ny ethanolkonverteringsmetode kan reducere drivhusgasemissionerne mellem 40 og 96 procentKredit:CC0 Public Domain En måde at øge bæredygtigheden på er at reducere kulstofemissionerne inden for transport. I 2017 overgik drivhusgasemissioner (GHG) fra denne sektor alle andre i USA, tegn -

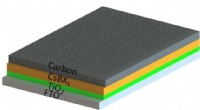

Lys fremtid for solcelleteknologiDe helt uorganiske perovskit solceller er bygget i flere lag. Bundlaget er glas, som er flere millimeter tyk. Det andet lag er et gennemsigtigt ledende materiale kaldet FTO. Derefter kommer et elektro

Lys fremtid for solcelleteknologiDe helt uorganiske perovskit solceller er bygget i flere lag. Bundlaget er glas, som er flere millimeter tyk. Det andet lag er et gennemsigtigt ledende materiale kaldet FTO. Derefter kommer et elektro -

BA aflyser næsten alle britiske fly i skelsættende strejkeRejseplanerne på næsten 300, 000 mennesker forventes at blive forstyrret på grund af to dages strejke fra piloter over løn British Airways aflyste mandag næsten alle fly, der afgår og ankommer til

BA aflyser næsten alle britiske fly i skelsættende strejkeRejseplanerne på næsten 300, 000 mennesker forventes at blive forstyrret på grund af to dages strejke fra piloter over løn British Airways aflyste mandag næsten alle fly, der afgår og ankommer til -

FTC sagsøger om at blokere Harrys salg til Schick -ejer EdgewellI denne 15. juni, 2018, fil foto, Winston -barbermaskinen og Harrys ansigtscreme vises på hovedkvarteret for Harrys Inc., i New York. Føderale antitrustregulatorer siger, at en foreslået fusion, der v

FTC sagsøger om at blokere Harrys salg til Schick -ejer EdgewellI denne 15. juni, 2018, fil foto, Winston -barbermaskinen og Harrys ansigtscreme vises på hovedkvarteret for Harrys Inc., i New York. Føderale antitrustregulatorer siger, at en foreslået fusion, der v

- Fysikeren beskriver formen af et ormehul

- Er fødevareforsyningen stærk nok til at klare COVID-19-pandemien?

- Her ser på dug:edderkopper snarer vand fra luften

- Sådan fortæller du forskellen mellem en mandlig Crappie & en Kvinde Crappie

- Regn hjælper med at bekæmpe monsterild i Spanien

- Konstruktion af hule nanoreaktorer til forbedrede fotooxidationer