Rekordstore 45-qubit quantum computing simulering kørt på NERSC

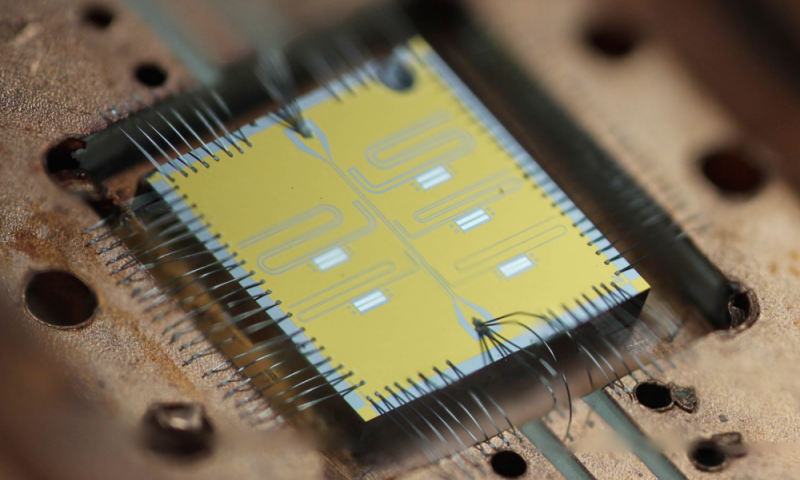

En multi-qubit chip udviklet i Quantum Nanoelectronics Laboratory på Lawrence Berkeley National Laboratory.

Da to forskere fra det schweiziske føderale institut for teknologi (ETH Zürich) i april meddelte, at de med succes havde simuleret et 45-qubit kvantekredsløb, videnskabssamfundet bemærkede:det var den største nogensinde simulering af en kvantecomputer, og endnu et skridt tættere på at simulere "kvanteoverherredømme" - det punkt, hvor kvantecomputere bliver mere kraftfulde end almindelige computere.

Beregningerne blev udført på National Energy Research Scientific Computing Center (NERSC), en DOE Office of Science User Facility ved US Department of Energy's Lawrence Berkeley National Laboratory. Forskere Thomas Häner og Damien Steiger, både ph.d. studerende på ETH, brugt 8, 192 af 9, 688 Intel Xeon Phi -processorer på NERSCs nyeste supercomputer, Cori, for at understøtte denne simulering, den største i en serie, de løb på NERSC til projektet.

"Quantum computing" har været genstand for dedikeret forskning i årtier, og med god grund:kvantecomputere har potentialet til at bryde almindelige kryptografiteknikker og simulere kvantesystemer på en brøkdel af den tid, det ville tage på nuværende "klassiske" computere. De gør dette ved at udnytte partiklernes kvantetilstande til at gemme information i qubits (kvantebit), en enhed af kvanteinformation, der ligner en almindelig bit i klassisk databehandling. Endnu bedre, qubits har en hemmelig magt:de kan udføre mere end en beregning ad gangen. Én qubit kan udføre to beregninger i en kvante -superposition, to kan udføre fire, tre otte, og så videre, med en tilsvarende eksponentiel stigning i kvanteparallalisme. Men det er svært at udnytte denne kvanteparallellisme, som at observere kvantetilstanden får systemet til at falde sammen til kun ét svar.

Så hvor tæt er vi på at realisere en ægte fungerende prototype? Det menes generelt, at en kvantecomputer, der anvender 49 qubits - en enhed med kvanteinformation - vil kunne matche computerkraften i nutidens mest kraftfulde supercomputere. Mod dette formål, Häner og Steigers simuleringer vil hjælpe med benchmarking og kalibrering af kortsigtede kvantecomputere ved at udføre kvanteoverlegenhedseksperimenter med disse tidlige enheder og sammenligne dem med deres simuleringsresultater. I mellemtiden, vi ser en stigning i investeringer i kvantecomputerteknologi fra folk som Google, IBM og andre førende teknologivirksomheder – selv Volkswagen – som dramatisk kunne accelerere udviklingsprocessen.

Simulering og emulering af kvantecomputere

Både emulering og simulering er vigtige for kalibrering, validering og benchmarking af nye kvantecomputere hardware og arkitekturer. I et papir fremlagt på SC16, Häner og Steiger skrev:"Selvom store kvantecomputere endnu ikke er tilgængelige, deres ydeevne kan udledes ved hjælp af kvantesammensætningsrammer og estimater af potentielle hardwarespecifikationer. Imidlertid, uden at teste og debugge kvanteprogrammer på småskala problemer, deres rigtighed kan ikke tages for givet. Simulatorer og emulatorer ... er afgørende for at imødekomme dette behov. "

Det papir diskuterede emulering af kvantekredsløb-en almindelig fremstilling af kvanteprogrammer-mens papiret på 45 qubit fokuserer på at simulere kvantekredsløb. Emulering er kun mulig for visse typer kvanteunderrutiner, mens simulering af kvantekredsløb er en generel metode, der også tillader inklusion af effekter af støj. Sådanne simuleringer kan være meget udfordrende selv på nutidens hurtigste supercomputere, Häner og Steiger forklarede. For 45-qubit simuleringen, for eksempel, de brugte det meste af den tilgængelige hukommelse på hver af de 8, 192 noder. "Dette øger sandsynligheden for nodefejl betydeligt, og vi kunne ikke forvente at køre på hele systemet i mere end en time uden fejl, "sagde de." Vi var derfor nødt til at reducere tid til løsning på alle skalaer (node-niveau såvel som klynge-niveau) for at opnå denne simulering. "

Optimering af kvantekredsløbssimulatoren var nøglen. Häner og Steiger anvendte automatisk kodegenerering, optimeret beregningskernerne og anvendt en planlægningsalgoritme til kvanteoverherredeskredsløbene, dermed reduceres den nødvendige node-to-node kommunikation. Under optimeringsprocessen arbejdede de med NERSC -medarbejdere og brugte Berkeley Labs Roofline Model til at identificere potentielle områder, hvor ydelsen kunne øges.

Ud over 45-qubit simuleringen, som brugte 0,5 petabyte hukommelse på Cori og opnåede en ydeevne på 0,428 petaflops, de simulerede også 30-, 36- og 42-qubit kvantekredsløb. Da de sammenlignede resultaterne med simuleringer af 30- og 36-qubit kredsløb, der kører på NERSCs Edison-system, de fandt ud af, at Edison-simuleringerne også kørte hurtigere.

"Vores optimeringer forbedrede ydeevnen – antallet af flydende kommaoperationer pr. gang – med 10x for Edison og mellem 10x og 20x for Cori (afhængigt af det kredsløb, der skal simuleres og størrelsen pr. node), "Sagde Häner og Steiger." Tiden til løsning faldt med over 12x sammenlignet med tiderne for en lignende simulering rapporteret i et nyligt papir om kvanteoverherredømme af Boixo og samarbejdspartnere, hvilket gjorde 45-qubit simuleringen mulig. "

Ser frem til, duoen er interesseret i at udføre flere kvantekredsløbssimuleringer på NERSC for at bestemme ydelsen af nærtidskvantumcomputere, der løser kvantekemiproblemer. De håber også at bruge solid-state-drev til at gemme større bølgefunktioner og dermed forsøge at simulere endnu flere qubits.

Sidste artikelInd i kvanteverdenen med en tennisracket

Næste artikelFysikere studerer magnetiske urenheder i topologiske isolatorer

Varme artikler

Varme artikler

-

Tekstureret LED giver grønt lys til Li-FiV-gruber på overfladen af en InGaN LED (til venstre) spreder lys ind i enhedens aktive lag, kendt som kvantebrønde (QWer - til højre). Kredit:American Chemical Society. Standard lysdioder (LEDer

Tekstureret LED giver grønt lys til Li-FiV-gruber på overfladen af en InGaN LED (til venstre) spreder lys ind i enhedens aktive lag, kendt som kvantebrønde (QWer - til højre). Kredit:American Chemical Society. Standard lysdioder (LEDer -

CLEAR undersøgelse baner vejen for ny elektronbaseret cancerterapiCERNs CLEAR facilitet, hvor der blev udført test på meget højenergi-elektronstråler. Kredit:CERN Der er nogle kræftsvulster, som ikke engang opereres, kemoterapi eller traditionel strålebehandling

CLEAR undersøgelse baner vejen for ny elektronbaseret cancerterapiCERNs CLEAR facilitet, hvor der blev udført test på meget højenergi-elektronstråler. Kredit:CERN Der er nogle kræftsvulster, som ikke engang opereres, kemoterapi eller traditionel strålebehandling -

Fysik-team anvender kvantitative metoder til at modellere, hvor langt virusbelastede aerosoler rejse…Kredit:University of Florida Som videnskabelige tomrum går, det ville være svært lige nu at finde et mere presserende spørgsmål:Hvordan rejser aerosolerne, der bærer det usynlige coronavirus, i lu

Fysik-team anvender kvantitative metoder til at modellere, hvor langt virusbelastede aerosoler rejse…Kredit:University of Florida Som videnskabelige tomrum går, det ville være svært lige nu at finde et mere presserende spørgsmål:Hvordan rejser aerosolerne, der bærer det usynlige coronavirus, i lu -

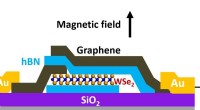

Første demonstration låser yderligere opdagelse af kvanteteknologier opKredit:Rensselaer Polytechnic Institute Skjult i utallige materialer er værdifulde egenskaber, der muliggør den næste generation af teknologier, som kvanteberegning og forbedrede solceller. På Re

Første demonstration låser yderligere opdagelse af kvanteteknologier opKredit:Rensselaer Polytechnic Institute Skjult i utallige materialer er værdifulde egenskaber, der muliggør den næste generation af teknologier, som kvanteberegning og forbedrede solceller. På Re

- Kan en kvantestrategi hjælpe med at ødelægge huset?

- Frisk havspray bliver sur efter at have været i luften

- Vanilje får mælkedrikke til at virke sødere

- 10 år senere:Hvordan syriske flygtningeledede forsyningsnetværk forbedrer livskvaliteten

- Sorte børn udsat for højere discipliner end jævnaldrende

- De sundhedsmæssige konsekvenser af tilbageslagspolitik