Berkeley Lab baner vejen for ptykografisk datastreaming i realtid

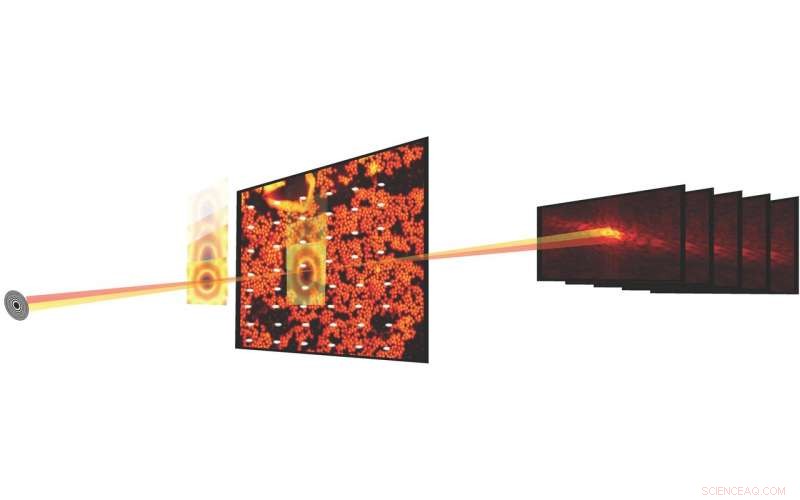

I videnskabelige forsøg, ptykografisk billeddannelse kombinerer scanningsmikroskopi med diffraktionsmålinger for at karakterisere strukturen og egenskaberne af stof og materialer. Fremskridt inden for detektorer og røntgenmikroskoper ved lyskilder har gjort det muligt nu at måle et ptykografisk datasæt på få sekunder. Kredit:Stefano Marchesini, Berkeley Lab

Hvad der begyndte for næsten ti år siden som et Berkeley Lab Laboratory-Directed Research and Development (LDRD) forslag, er nu en realitet, og det er allerede ved at ændre den måde, videnskabsmænd udfører eksperimenter på ved Advanced Light Source (ALS) - og, til sidst, andre lyskilder på tværs af Department of Energy (DOE) komplekset - ved at muliggøre realtidsstreaming af ptykografiske billeddata i et produktionsmiljø.

I videnskabelige forsøg, ptykografisk billeddannelse kombinerer scanningsmikroskopi med diffraktionsmålinger for at karakterisere strukturen og egenskaberne af stof og materialer. Mens metoden har eksisteret i omkring 50 år, bred udnyttelse er blevet hæmmet af det faktum, at den eksperimentelle proces var langsom, og den beregningsmæssige behandling af dataene til at producere et rekonstrueret billede var dyr. Men i de senere år har fremskridt inden for detektorer og røntgenmikroskoper ved lyskilder som ALS gjort det muligt at måle et ptykografisk datasæt på få sekunder.

Rekonstruering af ptykografiske datasæt, imidlertid, er ingen triviel sag; processen involverer løsning af et vanskeligt fase-hentningsproblem, kalibrering af optiske elementer og håndtering af eksperimentelle outliers og "støj". Indtast SHARP (skalerbar heterogen adaptiv realtidsptykografi), en algoritmisk ramme og computersoftware, der muliggør rekonstruktion af millioner af faser af ptykografiske billeddata pr. sekund. Udviklet på Berkeley Lab gennem et internationalt samarbejde og rullet ud i 2016, SHARP har haft en påviselig indflydelse på produktiviteten for forskere, der arbejder ved ALS og andre lyskilder på tværs af Department of Energy-komplekset.

Nu finansierer et mellemstatsligt agentur samarbejde mellem forskere fra Berkeley Labs DOE-finansierede Center for Advanced Mathematics for Energy Research Applications (CAMERA), ALS og STROBE, National Science Foundations Science and Technology Center, har givet endnu et første af sin slags fremskridt inden for ptykografisk billeddannelse:en software/algoritmisk pipeline, der muliggør streaming af ptykografiske billeddata i realtid under et beamline-eksperiment, give gennemløb, komprimering og opløsning samt hurtig feedback til brugeren, mens eksperimentet stadig kører.

Integreret, Modulær, Skalerbar

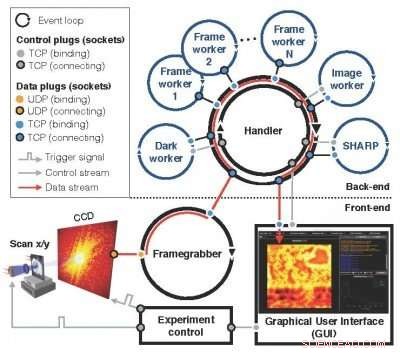

En efterfølger af Nanosurveyor-konceptet, der først blev introduceret i et LDRD-forslag fra 2010, det modulære, skalerbart Nanosurveyor II-system - nu oppe og køre på ALS - anvender en tosidet infrastruktur, der integrerer den ptykografiske billeddataopsamling, forbehandling, transmissions- og visualiseringsprocesser. Front-end-komponenten ved beamline omfatter detektoren, rammefanger, en skalerbar præprocessor og grafisk brugergrænseflade (GUI), mens back-end-komponenten i computerklyngen indeholder SHARP til højopløselig billedrekonstruktion kombineret med kommunikationskanaler til dataflow, instruktioner og synkronisering. I Operation, når en ny scanning er blevet udløst af eksperimentkontrollen, frame-grabberen modtager kontinuerligt rådatapakker fra kameraet, samler dem til en ramme og, parallelt, forbehandler et sæt rå rammer til en ren og reduceret blok til den beregningsmæssige bagende. Indgående blokke er fordelt blandt SHARP-arbejderne i beregningsbackend, og reducerede data sendes tilbage til frontend og visualiseres i en GUI. Det nye streamingsoftwaresystem er ved at blive udrullet på ALS til aktiv brug i eksperimenter på beamlines, såsom COSMIC X-ray mikroskopi-platformen, der for nylig kom online.

"Det, vi er lykkedes med at gøre, er at gøre meget komplekse beregninger og data workflow så gennemsigtige som muligt, " sagde David Shapiro, en stabsforsker i Experimental Systems Group ved ALS, som har været medvirkende til at lette implementeringen og afprøvningen af det nye system. "Når softwaren er i gang, mikroskopoperatører aner ikke, at de genererer gigabyte data, og det går gennem denne pipeline og vender så tilbage til dem."

ALS-brugere er typisk i stand til at bruge beamlines i omkring to dage, hvor de kan studere omkring et dusin prøver, Shapiro bemærkede. Det betyder, at de kun har et par timer pr. prøve, og de skal træffe en række beslutninger om dataene inden for disse timer. Den pytkografiske streaming i realtid giver dem feedback i realtid og hjælper dem med at træffe mere præcise beslutninger.

Den modulære, skalerbart Nanosurveyor II-system - nu oppe og køre på ALS - anvender en tosidet infrastruktur, der integrerer den ptykografiske billeddataopsamling, forbehandling, transmissions- og visualiseringsprocesser. Kredit:Lawrence Berkeley National Laboratory

"Det faktum, at SHARP nu kan tage data i realtid og behandle dem med det samme, selvom eksperimentet ikke er afsluttet, gør det højtydende og operationelt for videnskaben i et produktionsmiljø, " sagde Stefano Marchesini, en CAMERA videnskabsmand og PI på det oprindelige LDRD-forslag.

Produktionsklar miljø

At integrere alle komponenterne var en af de største udfordringer ved implementeringen af Nanosurveyor II, som gjorde det klar til at fungere i et produktionsklar miljø versus et testbed, ifølge Hari Krishnan, en computersystemingeniør hos CAMERA, som var ansvarlig for udviklingen af rørledningens kommunikationsmotor. Det tog en flerårig indsats at bringe real-time databehandlingsfunktionerne til virkelighed, med bidrag fra matematikere, dataloger, software ingeniører, fysikere og strålelinjeforskere. Ud over Marchesini og Krishnan, KAMERA-forskerne Pablo Enfedaque og Huibin Chang var involveret i udviklingen af SHARP-grænsefladen og kommunikationsmotoren. Ud over, Filipe Maia og Benedict Daurer fra Uppsala Universitet, som har et samarbejde med CAMERA, spillet en integreret del i udviklingen af streamingsoftwaren. I mellemtiden fysiker Bjoern Enders fra Berkeley's Physics Department og STROBE var fokuseret på detektoren og præprocessoren, og Berkeley Physics Ph.D. studerende Kasra Nowrouzi var involveret i pipeline-implementering.

"Det var vigtigt at adskille systemets ansvar og opgaver og derefter finde en fælles grænseflade at kommunikere over, Enders sagde om teamindsatsen. "Dette satte en del af ansvaret tilbage i beamline. Vi arbejdede alle sammen for at adskille streamingalgoritmen fra forbehandlingsdelen, så vi kan sikre, at beamline rent faktisk fungerer."

Ser frem til, Nanosurveyor II's skalerbarhed vil være afgørende, da den næste generation af lyskilder og detektorer kommer online. Rørledningens datahastigheder afspejler detektorens; strømdetektoren fungerer med en hastighed på op til 400 megabyte pr. sekund og kan generere nogle få terabyte data pr. dag. Næste generations detektorer vil producere data 100 til 1, 000 gange hurtigere.

"Streamingløsningen fungerer lige så hurtigt som dataindsamlingen på dette tidspunkt, " sagde Enfedaque. "Du kan rekonstruere det ptykografiske billede med den hastighed, som dataene bliver fanget og forbehandlet."

Ud over, holdet søger at forbedre pipelinens muligheder ved at inkorporere maskinlæringsalgoritmer, der yderligere kan automatisere dataanalyseprocessen.

"Målet er at gøre det problemfrit, " sagde Krishnan. "Lige nu er det, brugerne ser på, et groft billede til at træffe hurtige beslutninger og et finere billede til at træffe mere komplekse beslutninger. Til sidst vil vi helt væk fra de rå rammer og data og ende i dette rige, hvor alle beslutninger og alle punkter kun er et enkelt rekonstrueret billede. Alle disse andre mellemting forsvinder."

"Data-streaming-kapaciteten bringer analyse ind i tidsskalaen for menneskelig beslutningstagning for operatører, men det letter også fremtiden, som ville være maskiner, der træffer beslutninger og vejleder målingerne, " tilføjede Shapiro.

Sidste artikelForskere opnår 3D-akustisk gulvtæppet kappe med Black Panther-lignende funktioner

Næste artikelAt se alle plasmavindens farver

Varme artikler

Varme artikler

-

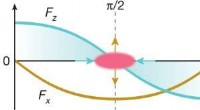

Fysikere styrer strømmen af elektronpulser gennem en nanostrukturkanalFig. 1:Kræfter, der fungerer som en funktion af synkronfasen φs. Kredit:DOI:10.1038/s41586-021-03812-9 Partikelacceleratorer er vigtige værktøjer inden for forskningsområder som biologi, materiale

Fysikere styrer strømmen af elektronpulser gennem en nanostrukturkanalFig. 1:Kræfter, der fungerer som en funktion af synkronfasen φs. Kredit:DOI:10.1038/s41586-021-03812-9 Partikelacceleratorer er vigtige værktøjer inden for forskningsområder som biologi, materiale -

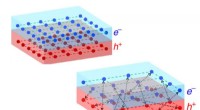

Regler for superledning spejlet i excitonisk isolatorRices topologiske excitoniske isolatorer er lavet af plader af halvledere (øverst), der bliver til isolatorer ved en kritisk temperatur omkring 10 kelvin. På det kritiske punkt, en superflydende kvant

Regler for superledning spejlet i excitonisk isolatorRices topologiske excitoniske isolatorer er lavet af plader af halvledere (øverst), der bliver til isolatorer ved en kritisk temperatur omkring 10 kelvin. På det kritiske punkt, en superflydende kvant -

Sporing af flyvebane for fordampende hostedråberRecirkulerende strømme, nemlig vågner, observeres både foran hosten (venstre) og bag på lytteren (højre). En dråbe kan blive medtaget og fanget i kølvandet, markant ændret dens bane og skæbne. Kredit:

Sporing af flyvebane for fordampende hostedråberRecirkulerende strømme, nemlig vågner, observeres både foran hosten (venstre) og bag på lytteren (højre). En dråbe kan blive medtaget og fanget i kølvandet, markant ændret dens bane og skæbne. Kredit: -

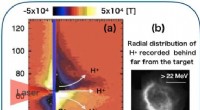

En magnetisk bremse på protonaccelerationFigur 1:Kvasistatiske magnetfelter beregnet af en laser-plasmasimuleringskode, PICLS (a). Radiografiske billeder af højenergiprotoner, som har en ringstruktur på grund af den magnetiske diffraktion. K

En magnetisk bremse på protonaccelerationFigur 1:Kvasistatiske magnetfelter beregnet af en laser-plasmasimuleringskode, PICLS (a). Radiografiske billeder af højenergiprotoner, som har en ringstruktur på grund af den magnetiske diffraktion. K

- Seniorer kæmper med teknologi, og ofte hjælper deres børn ikke

- Utilsigtet konsekvens af COVID-19:cybermobning kan øges

- Bekæmpelse af antibiotikaresistens med fager

- Forskere skabte en umulig superledende forbindelse

- Hvorfor vejrudsigten altid vil være en smule forkert

- Sydafrika er ikke længere plakatbarnet for at give adgang til rent vand