Lær mere om partikelkollisioner med maskinlæring

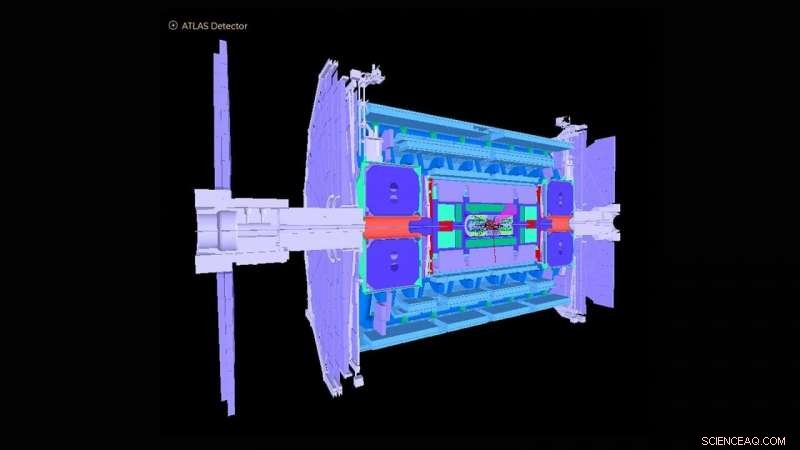

Skematisk af ATLAS -detektor i Large Hadron Collider. Kredit:ATLAS Collaboration

The Large Hadron Collider (LHC) nær Genève, Schweiz blev berømt over hele verden i 2012 med påvisningen af Higgs-bosonen. Observationen markerede en afgørende bekræftelse af standardmodellen for partikelfysik, som organiserer de subatomære partikler i grupper svarende til grundstoffer i det periodiske system fra kemi.

Det amerikanske energiministeriums (DOE) Argonne National Laboratory har ydet mange afgørende bidrag til konstruktionen og driften af ATLAS-eksperimentelle detektor ved LHC og til analysen af signaler optaget af detektoren, som afdækker den underliggende fysik af partikelkollisioner. Argonne spiller nu en hovedrolle i højlysstyrkeopgraderingen af ATLAS-detektoren til operationer, der er planlagt til at begynde i 2027. Til det formål et hold af Argonne-fysikere og beregningsforskere har udtænkt en maskinlæringsbaseret algoritme, der tilnærmer, hvordan den nuværende detektor ville reagere på de stærkt øgede data, der forventes med opgraderingen.

Som den største fysikmaskine, der nogensinde er bygget, LHC skyder to stråler af protoner i modsatte retninger omkring en 17-mile ring, indtil de nærmer sig lysets hastighed, smadrer dem sammen og analyserer kollisionsprodukterne med gigantiske detektorer som ATLAS. ATLAS-instrumentet er omtrent på højde med en seks-etagers bygning og vejer cirka 7, 000 tons. I dag, LHC fortsætter med at studere Higgs boson, samt tage fat på grundlæggende spørgsmål om, hvordan og hvorfor stof i universet er, som det er.

"De fleste af forskningsspørgsmålene hos ATLAS involverer at finde en nål i en kæmpe høstak, hvor videnskabsmænd kun er interesserede i at finde én begivenhed, der finder sted blandt en milliard andre, " sagde Walter Hopkins, assisterende fysiker i Argonnes High Energy Physics (HEP) division.

Som en del af LHC-opgraderingen, indsatsen skrider nu frem for at øge LHC's lysstyrke - antallet af proton-til-proton-interaktioner pr. kollision af de to protonstråler - med en faktor på fem. Dette vil producere omkring 10 gange flere data om året, end hvad der i øjeblikket er erhvervet af LHC-eksperimenterne. Det mangler stadig at blive forstået, hvor godt detektorerne reagerer på denne øgede hændelsesrate. Dette kræver at køre højtydende computersimuleringer af detektorerne for nøjagtigt at vurdere kendte processer, der er et resultat af LHC-kollisioner. Disse simuleringer i stor skala er dyre og kræver store bidder af computertid på verdens bedste og mest kraftfulde supercomputere.

Argonne-teamet har skabt en maskinlæringsalgoritme, der vil blive kørt som en foreløbig simulering før enhver fuldskala-simulering. Denne algoritme tilnærmer, på meget hurtige og billigere måder, hvordan den nuværende detektor ville reagere på de stærkt øgede data, der forventes med opgraderingen. Det involverer simulering af detektorresponser på et partikel-kollisionseksperiment og rekonstruktion af objekter fra de fysiske processer. Disse rekonstruerede objekter omfatter stråler eller sprays af partikler, samt individuelle partikler som elektroner og myoner.

"Opdagelsen af ny fysik på LHC og andre steder kræver stadig mere komplekse metoder til big data-analyser, "sagde Doug Benjamin, en beregningsforsker i HEP. "I disse dage betyder det normalt brug af maskinlæring og andre kunstige intelligensteknikker."

De tidligere anvendte analysemetoder til indledende simuleringer har ikke brugt maskinlæringsalgoritmer og er tidskrævende, fordi de involverer manuel opdatering af eksperimentelle parametre, når forholdene ved LHC ændres. Nogle kan også savne vigtige datakorrelationer for et givet sæt inputvariabler til et eksperiment. Den Argonne-udviklede algoritme lærer, i realtid, mens en træningsprocedure anvendes, de forskellige funktioner, der skal introduceres gennem detaljerede fulde simuleringer, derved undgås behovet for håndlavede eksperimentelle parametre. Metoden kan også fange komplekse indbyrdes afhængigheder af variabler, der ikke har været mulige før.

"Med vores strippede simulering, du kan lære det grundlæggende til forholdsvis små beregningsomkostninger og tid, så kan du meget mere effektivt fortsætte med komplette simuleringer på et senere tidspunkt, " sagde Hopkins. "Vores maskinlæringsalgoritme giver også brugerne bedre kendskab til, hvor de skal lede efter nye eller sjældne hændelser i et eksperiment, " han tilføjede.

Holdets algoritme kan vise sig at være uvurderlig ikke kun for ATLAS, men for de mange eksperimentelle detektorer på LHC, såvel som andre partikelfysiske eksperimenter, der nu udføres rundt om i verden.

Dette studie, med titlen "Automatiseret detektorsimulering og rekonstruktionsparametrisering ved hjælp af maskinlæring, "dukkede op i Journal of Instrumentation .

Varme artikler

Varme artikler

-

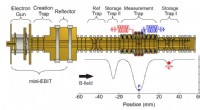

Højere præcisionsmålinger viser protonmasse mindre end antagetSkitse af opsætningen af fælden. Fældetårnet indeholder to separate opbevaringsfælder (ST-I, ST-II), målefælden (MT) og en referencefælde (RT) til magnetfeltovervågning, som i øjeblikket ikke bruges

Højere præcisionsmålinger viser protonmasse mindre end antagetSkitse af opsætningen af fælden. Fældetårnet indeholder to separate opbevaringsfælder (ST-I, ST-II), målefælden (MT) og en referencefælde (RT) til magnetfeltovervågning, som i øjeblikket ikke bruges -

Forskning identificerer detektionsbegrænsninger for mørke fotonerSkematisk tegning af fremtidigt CDEX-100 eksperiment. Kredit:Hun et al. Tidligere kosmologiske og astrofysiske observationer tyder på, at over en fjerdedel af universets energitæthed består af en

Forskning identificerer detektionsbegrænsninger for mørke fotonerSkematisk tegning af fremtidigt CDEX-100 eksperiment. Kredit:Hun et al. Tidligere kosmologiske og astrofysiske observationer tyder på, at over en fjerdedel af universets energitæthed består af en -

Sådan bygges en model rullebane til et skoleprojektEn rutschebane har ingen motor og fungerer kun ud fra tyngdekraften fra den første bakke, den trækkes op. I processen overfører en rutschebane potentiel energi til kinetisk eller reel bevægelse, alt f

Sådan bygges en model rullebane til et skoleprojektEn rutschebane har ingen motor og fungerer kun ud fra tyngdekraften fra den første bakke, den trækkes op. I processen overfører en rutschebane potentiel energi til kinetisk eller reel bevægelse, alt f -

Hvilke lyspærer udsender ikke UV-stråling?Selvom få lyskilder overhovedet ikke producerer UV, falder de fleste pærer godt inden for accepterede sikre grænser. Især udsender glødepærer, LED og natriumdampe meget små mængder UV-stråling. Ifø

Hvilke lyspærer udsender ikke UV-stråling?Selvom få lyskilder overhovedet ikke producerer UV, falder de fleste pærer godt inden for accepterede sikre grænser. Især udsender glødepærer, LED og natriumdampe meget små mængder UV-stråling. Ifø

- Kvinder har en tendens til at føre mere sofistikerede politiske kampagner

- Forskere udvikler unik polymerbelægning til at tackle skadelige svampe

- Motor, andre komponenter, i hjul kan forme fremtiden for bilindustrien

- EPA hører bekymringer om klimaet i hjertet af kullandet

- At have ansatte i udlandet hjælper virksomheder med at høste amerikanske skattefordele

- At se lyset:Undersøgelse finder på en ny måde, hvorpå novaer lyser himlen op