En statistisk løsning på replikationskrisen i videnskaben

Mange videnskabelige undersøgelser holder ikke i yderligere test. Kredit:A og N photography/Shutterstock.com

I et forsøg med et nyt lægemiddel til at helbrede kræft, 44 procent af 50 patienter opnåede remission efter behandling. Uden stoffet, kun 32 procent af tidligere patienter gjorde det samme. Den nye behandling lyder lovende, men er det bedre end standarden?

Det spørgsmål er svært, så statistikere har en tendens til at svare på et andet spørgsmål. De ser på deres resultater og beregner noget, der kaldes en p-værdi. Hvis p-værdien er mindre end 0,05, resultaterne er "statistisk signifikante" – med andre ord, det er usandsynligt, at det kun skyldes en tilfældig tilfældighed.

Problemet er, mange statistisk signifikante resultater gentager sig ikke. En behandling, der viser lovende i ét forsøg, viser ingen fordel overhovedet, når den gives til den næste gruppe patienter. Dette problem er blevet så alvorligt, at et psykologitidsskrift faktisk helt forbød p-værdier.

Mine kolleger og jeg har studeret dette problem, og vi tror, vi ved, hvad det skyldes. Baren for at påstå statistisk signifikans er simpelthen for lav.

De fleste hypoteser er falske

Det åbne videnskabssamarbejde, en nonprofitorganisation med fokus på videnskabelig forskning, forsøgte at replikere 100 offentliggjorte psykologiske eksperimenter. Mens 97 af de indledende eksperimenter rapporterede statistisk signifikante fund, kun 36 af de gentagne undersøgelser gjorde det.

Flere kandidatstuderende og jeg brugte disse data til at estimere sandsynligheden for, at et tilfældigt udvalgt psykologieksperiment testede en reel effekt. Vi fandt ud af, at kun omkring 7 procent gjorde det. I en lignende undersøgelse, økonom Anna Dreber og kolleger vurderede, at kun 9 procent af eksperimenterne ville replikere.

Begge analyser tyder på, at kun omkring én ud af 13 nye eksperimentelle behandlinger i psykologi – og formentlig mange andre samfundsvidenskaber – vil vise sig at være en succes.

Dette har vigtige implikationer ved fortolkning af p-værdier, især når de er tæt på 0,05.

Bayes-faktoren

P-værdier tæt på 0,05 er mere tilbøjelige til at skyldes tilfældige tilfældigheder, end de fleste er klar over.

For at forstå problemet, lad os vende tilbage til vores imaginære lægemiddelforsøg. Husk, 22 ud af 50 patienter på det nye lægemiddel gik i remission, sammenlignet med et gennemsnit på blot 16 ud af 50 patienter på den gamle behandling.

Sandsynligheden for at se 22 eller flere succeser ud af 50 er 0,05, hvis det nye lægemiddel ikke er bedre end det gamle. Det betyder, at p-værdien for dette eksperiment er statistisk signifikant. Men vi vil gerne vide, om den nye behandling virkelig er en forbedring, eller hvis det ikke er bedre end den gamle måde at gøre tingene på.

At finde ud af, vi er nødt til at kombinere oplysningerne i dataene med de tilgængelige oplysninger, før eksperimentet blev udført, eller "forudgående odds". De forudgående odds afspejler faktorer, der ikke er direkte målt i undersøgelsen. For eksempel, de kan forklare det faktum, at i 10 andre forsøg med lignende lægemidler, ingen viste sig at være vellykket.

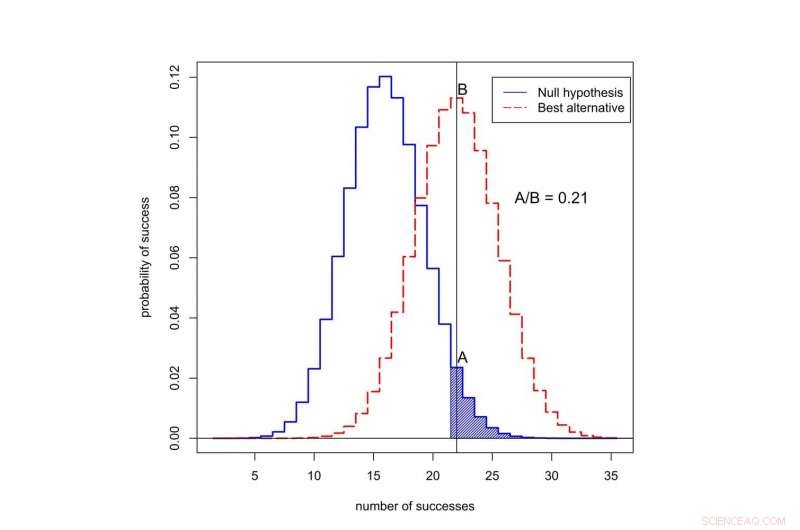

Hvis det nye lægemiddel ikke er bedre end det gamle lægemiddel, så fortæller statistikken os, at sandsynligheden for at se præcis 22 ud af 50 succeser i dette forsøg er 0,0235 – relativt lav.

Hvad hvis det nye lægemiddel faktisk er bedre? Vi kender faktisk ikke succesraten for det nye lægemiddel, men et godt gæt er, at det er tæt på den observerede succesrate, 22 ud af 50. Hvis vi antager, at så er sandsynligheden for at observere præcis 22 ud af 50 succeser 0,113 - omkring fem gange mere sandsynlig. (Ikke næsten 20 gange mere sandsynligt, selvom, som du måske kunne gætte, hvis du vidste, at p-værdien fra eksperimentet var 0,05.)

Hvad er sandsynligheden for at observere succes i 50 forsøg? Den sorte kurve repræsenterer sandsynligheder under "nulhypotesen", ’ når den nye behandling ikke er bedre end den gamle. Den røde kurve repræsenterer sandsynligheder, når den nye behandling er bedre. Det skraverede område repræsenterer p-værdien. I dette tilfælde, forholdet mellem de tildelte sandsynligheder til 22 succeser er A divideret med B, eller 0,21. Kredit:Valen Johnson, CC BY-SA

Dette forhold mellem sandsynligheder kaldes Bayes-faktoren. Vi kan bruge Bayes-sætningen til at kombinere Bayes-faktoren med de forudgående odds for at beregne sandsynligheden for, at den nye behandling er bedre.

For argumentets skyld, lad os antage, at kun 1 ud af 13 eksperimentelle kræftbehandlinger vil vise sig at være en succes. Det er tæt på den værdi, vi estimerede for psykologiske eksperimenter.

Når vi kombinerer disse tidligere odds med Bayes-faktoren, det viser sig, at sandsynligheden for, at den nye behandling ikke er bedre end den gamle, er mindst 0,71. Men den statistisk signifikante p-værdi på 0,05 tyder på præcis det modsatte!

En ny tilgang

Denne inkonsekvens er typisk for mange videnskabelige undersøgelser. Det er især almindeligt for p-værdier omkring 0,05. Dette forklarer, hvorfor en så høj andel af statistisk signifikante resultater ikke replikeres.

Så hvordan skal vi vurdere indledende påstande om en videnskabelig opdagelse? I september, mine kolleger og jeg foreslog en ny idé:Kun P-værdier mindre end 0,005 skal betragtes som statistisk signifikante. P-værdier mellem 0,005 og 0,05 skal blot kaldes suggestive.

I vores forslag statistisk signifikante resultater er mere tilbøjelige til at replikere, selv efter at have taget højde for de små forudgående odds, der typisk vedrører studier i det sociale, biologiske og medicinske videnskaber.

Hvad mere er, vi mener, at statistisk signifikans ikke bør tjene som en lyslinjetærskel for offentliggørelse. Statistisk antydende resultater - eller endda resultater, der stort set er inkonklusive - kan også blive offentliggjort, baseret på, hvorvidt de rapporterede vigtige foreløbige beviser vedrørende muligheden for, at en ny teori kunne være sand.

Den 11. okt. vi præsenterede denne idé for en gruppe statistikere ved ASA Symposium on Statistical Inference i Bethesda, Maryland. Vores mål med at ændre definitionen af statistisk signifikans er at genskabe den tilsigtede betydning af dette udtryk:at data har givet væsentlig støtte til en videnskabelig opdagelse eller behandlingseffekt.

Kritik af vores idé

Ikke alle er enige i vores forslag, herunder en anden gruppe videnskabsmænd ledet af psykolog Daniel Lakens.

De hævder, at definitionen af Bayes-faktorer er for subjektiv, og at forskere kan gøre andre antagelser, der kan ændre deres konklusioner. I det kliniske forsøg, for eksempel, Lakens kunne hævde, at forskere kunne rapportere tre-måneders snarere end seks-måneders remissionsrate, hvis det gav stærkere beviser til fordel for det nye lægemiddel.

Lakens og hans gruppe føler også, at estimatet for, at kun omkring et ud af 13 eksperimenter vil replikere, er for lavt. De påpeger, at dette skøn ikke inkluderer effekter som p-hacking, en betegnelse for, når forskere gentagne gange analyserer deres data, indtil de finder en stærk p-værdi.

I stedet for at hæve barren for statistisk signifikans, Lakens-gruppen mener, at forskere bør indstille og begrunde deres eget niveau af statistisk signifikans, før de udfører deres eksperimenter.

Jeg er uenig i mange af Lakens-gruppens påstande – og, fra et rent praktisk perspektiv, Jeg føler, at deres forslag er en nonstarter. De fleste videnskabelige tidsskrifter giver ikke en mekanisme for forskere til at registrere og begrunde deres valg af p-værdier, før de udfører eksperimenter. Vigtigere, At tillade forskere at sætte deres egne bevistærskler virker ikke som en god måde at forbedre reproducerbarheden af videnskabelig forskning.

Lakens' forslag ville kun fungere, hvis tidsskriftsredaktører og finansieringsbureauer på forhånd var enige om at offentliggøre rapporter om eksperimenter, der ikke er blevet udført baseret på kriterier, som videnskabsmænd selv har pålagt. Jeg tror, det er usandsynligt, at det sker i den nærmeste fremtid.

Indtil det gør, Jeg anbefaler, at du ikke stoler på påstande fra videnskabelige undersøgelser baseret på p-værdier nær 0,05. Insister på en højere standard.

Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.

Varme artikler

Varme artikler

-

Teenagers datingvold rammer én ud af tre, men skumle politikker betyder, at de fleste voksne ikke v…Datingvold påvirker uforholdsmæssigt unge, der er marginaliserede, herunder trans og ikke-binære unge, unge, der lever i fattigdom og raciserede unge. Kredit:Shutterstock Ungdomsdatingsvold er et

Teenagers datingvold rammer én ud af tre, men skumle politikker betyder, at de fleste voksne ikke v…Datingvold påvirker uforholdsmæssigt unge, der er marginaliserede, herunder trans og ikke-binære unge, unge, der lever i fattigdom og raciserede unge. Kredit:Shutterstock Ungdomsdatingsvold er et -

Babytrin:Gammelt kranium hjælper med at spore vejen til moderne barndomDet originale Dikika barnekranie (til venstre), en 3D-model produceret med synkrotron-scanning (midten), og en model korrigeret for forvrængning under fossilisering (højre). Kredit:Gunz et al. (2020)

Babytrin:Gammelt kranium hjælper med at spore vejen til moderne barndomDet originale Dikika barnekranie (til venstre), en 3D-model produceret med synkrotron-scanning (midten), og en model korrigeret for forvrængning under fossilisering (højre). Kredit:Gunz et al. (2020) -

Kun 1 ud af 5 chefredaktører af førende medicinske tidsskrifter er kvinder, undersøgelse finderKredit:CC0 Public Domain Kvinder er fortsat underrepræsenteret på den højeste position i internationale medicinske tidsskrifter, finder en ny undersøgelse, der undersøger kønsfordelingen af chef

Kun 1 ud af 5 chefredaktører af førende medicinske tidsskrifter er kvinder, undersøgelse finderKredit:CC0 Public Domain Kvinder er fortsat underrepræsenteret på den højeste position i internationale medicinske tidsskrifter, finder en ny undersøgelse, der undersøger kønsfordelingen af chef -

Psykologiforskere undersøger, hvordan juryer vurderer fængselsinformantvidnesbyrdKredit:CC0 Public Domain Fængselsinformantens vidneudsagn i en juridisk retssag ser ud til at eksistere i skæringspunktet mellem to gamle tv-shows, Lov og orden og Lad os lave en aftale. Der er næ

Psykologiforskere undersøger, hvordan juryer vurderer fængselsinformantvidnesbyrdKredit:CC0 Public Domain Fængselsinformantens vidneudsagn i en juridisk retssag ser ud til at eksistere i skæringspunktet mellem to gamle tv-shows, Lov og orden og Lad os lave en aftale. Der er næ

- Hvad er valenselektroner og hvordan er de relateret til atomerens adfærdsadfærd?

- I et nyt skridt mod kvanteteknologi, forskere syntetiserer lyse kvantebits

- Når COVID-19 sætter forfædres andinske ritualer i karantæne

- Ikke flere Hoover-dæmninger:Vanddrevne lande lider under højere niveauer af fattigdom, korruption …

- Sådan konverteres fra mol pr. Liter til procent

- Mitose vs meiose: Hvad er lighederne og forskellene?