YouTube er mere tilbøjelige til at anbefale valgsvindelvideoer til brugere, der allerede er skeptiske over for valgets legitimitet i 2020

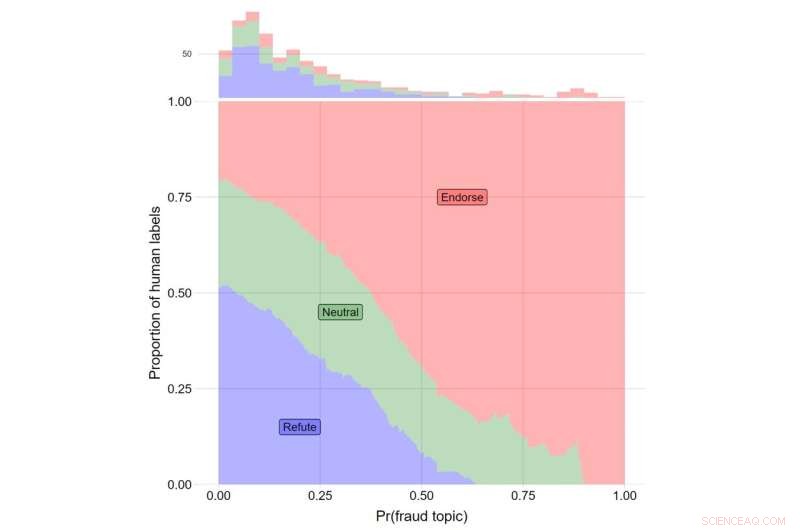

Y-aksen angiver andelen af menneskelige etiketter for videoer, der modbeviser Trumps påstande (i blåt), dem, der rapporterer om Trumps påstande neutralt (grøn), og dem, der støtter Trumps påstande (rød). X-aksen angiver θ-værdien for emne #108. Det samlede antal videoer, der falder ind under hver kategori, er angivet med histogrammet øverst i plottet. Kredit:Journal of Online Trust and Safety (2022). https://doi.org/10.54501/jots.v1i3.60

YouTube var mere tilbøjelige til at anbefale videoer om valgsvindel til brugere, der allerede var skeptiske over for legitimiteten af det amerikanske præsidentvalg i 2020, viser en ny undersøgelse, der undersøger virkningen af webstedets algoritmer.

Resultaterne af forskningen, som er offentliggjort i Journal of Online Trust and Safety , viste, at de, der var mest skeptiske over for valgets legitimitet, blev vist tre gange så mange valgsvindel-relaterede videoer, som de mindst skeptiske deltagere var – omkring 8 yderligere anbefalinger ud af cirka 400 videoer, der blev foreslået til hver undersøgelsesdeltager.

Mens den samlede udbredelse af disse typer videoer var lav, afslører resultaterne konsekvenserne af et anbefalingssystem, der giver brugerne det indhold, de ønsker. For dem, der er mest bekymrede over mulig valgsvindel, var det at vise dem relateret indhold en mekanisme, hvorved misinformation, desinformation og konspirationer kan finde vej til dem, der mest sandsynligt tror på dem, observer forfatterne af undersøgelsen. Det er vigtigt, at disse mønstre afspejler algoritmens uafhængige indflydelse på, hvad rigtige brugere får vist, mens de bruger platformen.

"Vores resultater afdækker de skadelige konsekvenser af anbefalingsalgoritmer og sår tvivl om, at online informationsmiljøer udelukkende bestemmes af brugernes valg," siger James Bisbee, der ledede undersøgelsen som postdoktor ved New York Universitys Center for Social Media and Politics. (CSMaP).

Næsten to år efter præsidentvalget i 2020 tror et stort antal amerikanere, især republikanere, ikke på legitimiteten af resultatet.

"Omtrent 70% af republikanerne ser ikke Biden som den legitime vinder," på trods af "flere gentællinger og revisioner, der bekræftede Joe Bidens sejr," skrev Poynter Institutes PolitiFact tidligere i år.

Selvom det er velkendt, at sociale medieplatforme, såsom YouTube, dirigerer indhold til brugere baseret på deres søgepræferencer, er konsekvenserne af denne dynamik muligvis ikke fuldt ud realiseret.

I CSMaP-undersøgelsen udtog forskerne mere end 300 amerikanere med YouTube-konti i november og december 2020. Forsøgspersonerne blev spurgt, hvor bekymrede de var over en række aspekter af valgsvindel, herunder svigagtige stemmesedler, der tælles, gyldige stemmesedler blev kasseret, udenlandske regeringer, der blander sig, og ikke-amerikanske borgere, der stemmer, blandt andre spørgsmål.

Disse deltagere blev derefter bedt om at installere en browserudvidelse, der kunne registrere listen over anbefalinger, de blev vist. Forsøgspersonerne blev derefter instrueret i at klikke på en tilfældigt tildelt YouTube-video ("frø"-videoen), og derefter klikke på en af de anbefalinger, de blev vist i henhold til en tilfældigt tildelt "gennemløbsregel". For eksempel vil brugere, der er tildelt "den anden traverseringsregel", være forpligtet til altid at klikke på den anden video på listen over viste anbefalinger, uanset dens indhold. By restricting user behavior in these ways, the researchers were able to isolate the recommendation algorithm's influence on what real users were being suggested in real time.

The subjects then proceeded through a sequence of YouTube recommended videos, allowing the researchers to observe what the YouTube algorithm suggested to its users. Bisbee and his colleagues then compared the number of videos about election fraud in the 2020 U.S. presidential election that were recommended to participants who were more skeptical about the legitimacy of the election to those recommended to participants who were less skeptical. These results showed that election skeptics were recommended an average of eight additional videos about possible fraud in the 2020 US election, relative to non-skeptical participants (12 vs. 4).

"Many believe that automated recommendation algorithms have little influence on online 'echo chambers' in which users only see content that reaffirms their preexisting views," observes Bisbee, now an assistant professor at Vanderbilt University.

"Our study, however, suggests that YouTube's recommendation algorithm was able to determine which users were more likely to be concerned about fraud in the 2020 U.S. presidential election and then suggested up to three times as many videos about election fraud to these users compared to those less concerned about election fraud. This highlights the need for further investigation into how opaque recommendation algorithms operate on an issue-by-issue basis." + Udforsk yderligere

YouTube to remove misleading videos about the outcome of the U.S. presidential election

Varme artikler

Varme artikler

-

Hvem falder for falske nyheder?Kredit:CC0 Public Domain Folk, der læser falske nyheder online, er ikke dømt til at falde ned i et dybt ekkokammer, hvor den eneste lyd, de hører, er deres egen ideologi, ifølge en ny undersøgelse

Hvem falder for falske nyheder?Kredit:CC0 Public Domain Folk, der læser falske nyheder online, er ikke dømt til at falde ned i et dybt ekkokammer, hvor den eneste lyd, de hører, er deres egen ideologi, ifølge en ny undersøgelse -

Om grundlæggende matematikfærdighedstestStandard Achievement Test (SAT) er typisk taget af gymnasier og seniorer, og er en af de test, der bruges til at bestemme indgangen til college. Der er tre emner testet i SAT: matematik, kritisk

Om grundlæggende matematikfærdighedstestStandard Achievement Test (SAT) er typisk taget af gymnasier og seniorer, og er en af de test, der bruges til at bestemme indgangen til college. Der er tre emner testet i SAT: matematik, kritisk -

Frygter du den team-building øvelse?Kredit:University of East Anglia En ny undersøgelse ledet af University of East Anglia for What Works Center for Wellbeing afslører, at fælles aktiviteter på vores arbejdspladser kan forbedre triv

Frygter du den team-building øvelse?Kredit:University of East Anglia En ny undersøgelse ledet af University of East Anglia for What Works Center for Wellbeing afslører, at fælles aktiviteter på vores arbejdspladser kan forbedre triv -

Sådan beregnes en kvintilBeregning af en kvintil kan hjælpe dig med at indtaste interessante og informative mønstre i et datasæt. En kvintil er en gruppe af tal, der repræsenterer 20 procent af de værdier, der bor i et større

Sådan beregnes en kvintilBeregning af en kvintil kan hjælpe dig med at indtaste interessante og informative mønstre i et datasæt. En kvintil er en gruppe af tal, der repræsenterer 20 procent af de værdier, der bor i et større

- Kompakt søgning efter mørke objekter:Scanning af jordens kerne med superledende gravimetre

- Sådan Fortyndes Acid

- Nyudviklet COVID-19-test registrerer og identificerer specifikke varianter med 100 % nøjagtighed

- 7 Klassifikationer af jordorme

- Endnu en satellitopsendelse til Europas jordovervågningssystem

- NASA udvælger forslag til at demonstrere smallSat-teknologier til at studere interplanetarisk rum