Misinformation og skævheder inficerer sociale medier, både med vilje og ved et uheld

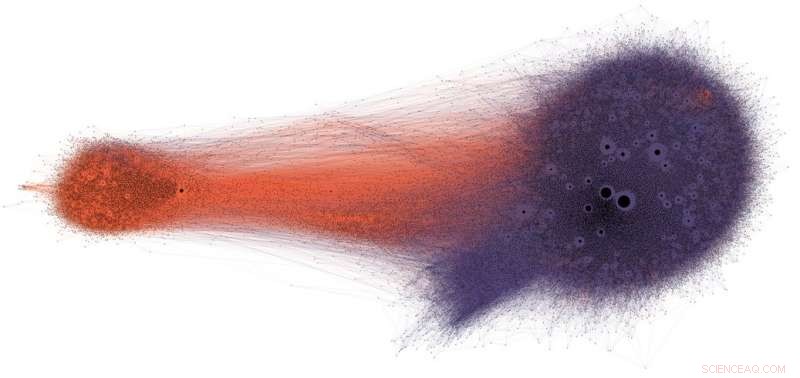

Folk, der deler potentiel misinformation på Twitter (i lilla), får sjældent at se rettelser eller faktatjek (i orange). Kredit:Shao et al., CC BY-ND

Sociale medier er blandt de primære kilder til nyheder i USA og i hele verden. Alligevel bliver brugere udsat for indhold af tvivlsom nøjagtighed, inklusive konspirationsteorier, clickbait, hyperpartisk indhold, pseudovidenskab og endda opdigtede "falske nyheder"-rapporter.

Det er ikke overraskende, at der er så meget desinformation offentliggjort:Spam og onlinesvindel er lukrative for kriminelle, og regerings- og politisk propaganda giver både partipolitiske og økonomiske fordele. Men det faktum, at indhold med lav troværdighed spredes så hurtigt og nemt, tyder på, at mennesker og algoritmerne bag sociale medieplatforme er sårbare over for manipulation.

Vores forskning har identificeret tre typer bias, der gør det sociale medie-økosystem sårbart over for både tilsigtet og utilsigtet misinformation. Det er grunden til, at vores observatorium for sociale medier på Indiana University bygger værktøjer til at hjælpe folk med at blive opmærksomme på disse skævheder og beskytte sig selv mod udefrakommende påvirkninger designet til at udnytte dem.

Bias i hjernen

Kognitive skævheder opstår i den måde, hjernen behandler den information, som hver person møder hver dag. Hjernen kan kun håndtere en begrænset mængde information, og for mange indkommende stimuli kan forårsage overbelastning af information. Det har i sig selv alvorlige konsekvenser for kvaliteten af information på sociale medier. Vi har fundet ud af, at stejl konkurrence om brugernes begrænsede opmærksomhed betyder, at nogle ideer bliver virale på trods af deres lave kvalitet – selv når folk foretrækker at dele indhold af høj kvalitet.

For at undgå at blive overvældet, hjernen bruger en række tricks. Disse metoder er normalt effektive, men kan også blive skævheder, når de anvendes i de forkerte sammenhænge.

En kognitiv genvej sker, når en person beslutter, om han vil dele en historie, der vises på deres sociale medier. Folk er meget påvirkede af de følelsesmæssige konnotationer af en overskrift, selvom det ikke er en god indikator for en artikels nøjagtighed. Meget vigtigere er, hvem der har skrevet stykket.

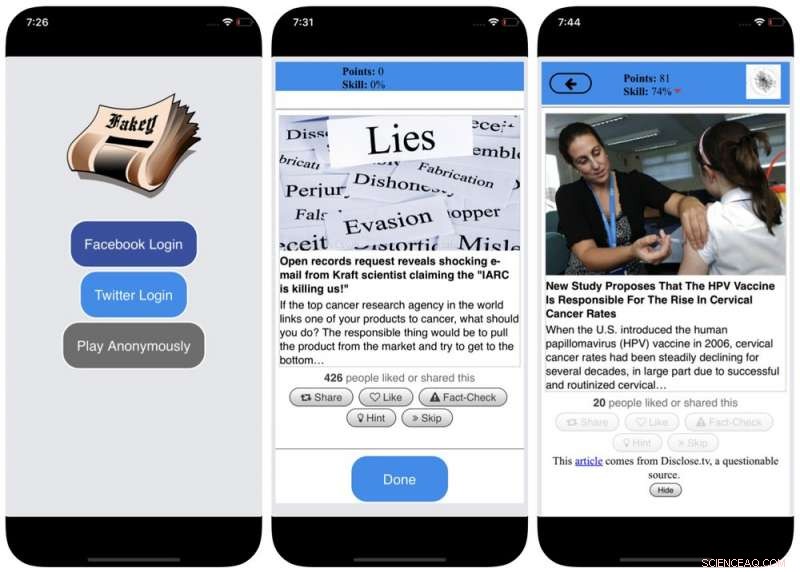

For at imødegå denne skævhed, og hjælpe folk med at være mere opmærksomme på kilden til et krav, før de deler det, vi udviklede Fakey, et mobilt nyhedsfærdighedsspil (gratis på Android og iOS), der simulerer et typisk nyhedsfeed på sociale medier, med en blanding af nyhedsartikler fra almindelige kilder og kilder med lav troværdighed. Spillere får flere point for at dele nyheder fra pålidelige kilder og markere mistænkeligt indhold til faktatjek. I processen, de lærer at genkende signaler om kildens troværdighed, såsom hyperpartiske påstande og følelsesladede overskrifter.

Bias i samfundet

En anden kilde til bias kommer fra samfundet. Når folk forbinder sig direkte med deres jævnaldrende, de sociale skævheder, der styrer deres valg af venner, kommer til at påvirke den information, de ser.

Faktisk, i vores forskning har vi fundet ud af, at det er muligt at bestemme en Twitter-brugers politiske holdninger ved blot at se på deres venners partiske præferencer. Vores analyse af strukturen af disse partipolitiske kommunikationsnetværk fandt, at sociale netværk er særligt effektive til at formidle information - nøjagtig eller ej - når de er tæt knyttet sammen og adskilt fra andre dele af samfundet.

Tendensen til at vurdere information mere positivt, hvis den kommer fra deres egne sociale kredse, skaber "ekkokamre", der er modne til manipulation, enten bevidst eller utilsigtet. Dette hjælper med at forklare, hvorfor så mange onlinesamtaler udvikler sig til "os versus dem"-konfrontationer.

Skærmbilleder af Fakey-spillet. Kredit:Mihai Avram og Filippo Menczer

For at studere, hvordan strukturen af online sociale netværk gør brugere sårbare over for desinformation, vi byggede Hoaxy, et system, der sporer og visualiserer spredningen af indhold fra kilder med lav troværdighed, og hvordan det konkurrerer med faktatjek indhold. Vores analyse af data indsamlet af Hoaxy under det amerikanske præsidentvalg i 2016 viser, at Twitter-konti, der delte misinformation, næsten fuldstændigt blev afskåret fra rettelserne foretaget af faktatjekkerne.

Da vi dykkede ned i de misinformationsspredningskonti, vi fandt en meget tæt kernegruppe af konti, der næsten udelukkende retweetede hinanden – inklusive flere bots. De eneste gange, hvor faktatjekorganisationer nogensinde blev citeret eller nævnt af brugerne i den misinformerede gruppe, var når de satte spørgsmålstegn ved deres legitimitet eller hævdede det modsatte af, hvad de skrev.

Bias i maskinen

Den tredje gruppe af skævheder opstår direkte fra de algoritmer, der bruges til at bestemme, hvad folk ser online. Både sociale medieplatforme og søgemaskiner anvender dem. Disse personaliseringsteknologier er designet til kun at vælge det mest engagerende og relevante indhold for hver enkelt bruger. Men ved at gøre det, det kan ende med at forstærke brugernes kognitive og sociale skævheder, dermed gøre dem endnu mere sårbare over for manipulation.

For eksempel, de detaljerede reklameværktøjer, der er indbygget i mange sociale medieplatforme, lader disinformationskampagnefolk udnytte bekræftelsesbias ved at skræddersy beskeder til folk, der allerede er tilbøjelige til at tro på dem.

Også, hvis en bruger ofte klikker på Facebook-links fra en bestemt nyhedskilde, Facebook vil have en tendens til at vise denne person mere af webstedets indhold. Denne såkaldte "filterboble"-effekt kan isolere mennesker fra forskellige perspektiver, styrkelse af bekræftelsesbias.

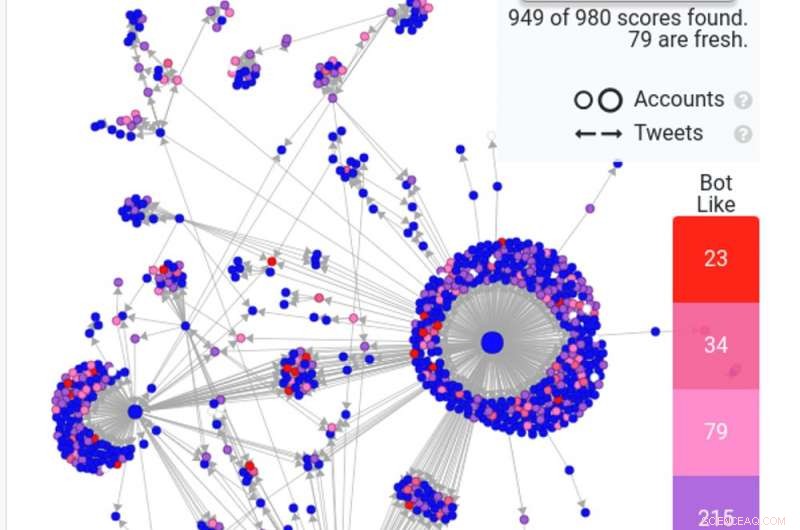

Et skærmbillede af en Hoaxy-søgning viser, hvordan almindelige bots – i rød og mørk pink – spreder en falsk historie på Twitter. Kredit:Hoaxy

Vores egen forskning viser, at sociale medieplatforme udsætter brugere for et mindre forskelligartet sæt af kilder end ikke-sociale mediesider som Wikipedia. Fordi dette er på niveau med en hel platform, ikke af en enkelt bruger, vi kalder dette homogenitetsbias.

En anden vigtig ingrediens i sociale medier er information, der er trending på platformen, alt efter hvad der får flest klik. Vi kalder dette popularitetsbias, fordi vi har fundet ud af, at en algoritme designet til at promovere populært indhold kan påvirke den overordnede kvalitet af information på platformen negativt. Dette bidrager også til eksisterende kognitiv bias, forstærker det, der ser ud til at være populært uanset dets kvalitet.

Alle disse algoritmiske skævheder kan manipuleres af sociale bots, computerprogrammer, der interagerer med mennesker gennem konti på sociale medier. De fleste sociale bots, ligesom Twitters Big Ben, er harmløse. Imidlertid, nogle skjuler deres virkelige natur og bruges i ondsindede hensigter, såsom at øge desinformation eller fejlagtigt skabe udseendet af en græsrodsbevægelse, også kaldet "astroturfing". Vi fandt beviser for denne type manipulation i tiden op til det amerikanske midtvejsvalg i 2010.

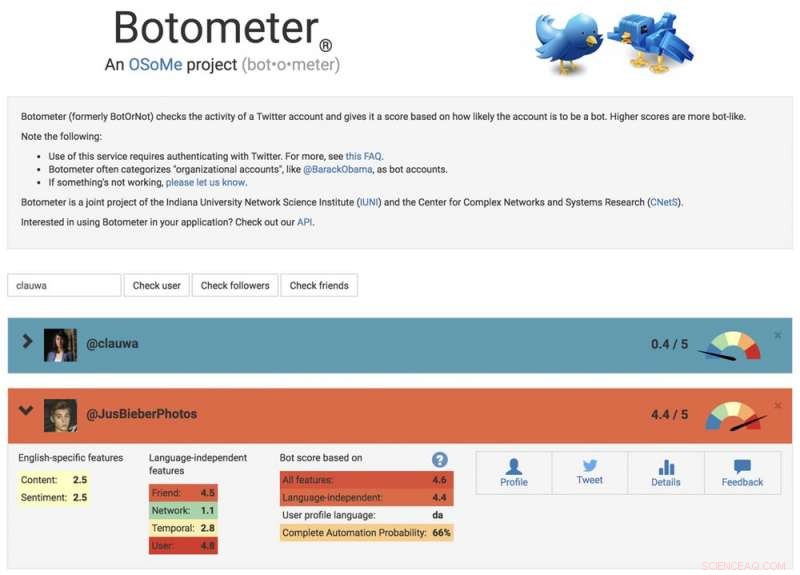

For at studere disse manipulationsstrategier, vi udviklede et værktøj til at opdage sociale bots kaldet Botometer. Botometer bruger maskinlæring til at registrere botkonti, ved at inspicere tusindvis af forskellige funktioner på Twitter-konti, ligesom tidspunkterne for sine indlæg, hvor ofte den tweeter, og de konti, den følger og retweets. Det er ikke perfekt, men det har afsløret, at så mange som 15 procent af Twitter-konti viser tegn på at være bots.

Brug af Botometer i forbindelse med Hoaxy, vi analyserede kernen af misinformationsnetværket under den amerikanske præsidentkampagne i 2016. Vi fandt mange bots, der udnyttede både den kognitive, bekræftelses- og popularitetsforstyrrelser af deres ofre og Twitters algoritmiske skævheder.

Disse bots er i stand til at konstruere filterbobler omkring sårbare brugere, fodre dem med falske påstande og misinformation. Først, de kan tiltrække opmærksomhed fra menneskelige brugere, der støtter en bestemt kandidat, ved at tweete den pågældende kandidats hashtags eller ved at nævne og retweete personen. Så kan bots forstærke falske påstande, der udsværte modstandere ved at retweete artikler fra kilder med lav troværdighed, der matcher bestemte søgeord. Denne aktivitet gør også, at algoritmen fremhæver falske historier for andre brugere, der bliver delt bredt.

Et skærmbillede af Botometer-webstedet, viser én menneskelig og én bot-konto. Kredit:Botometer

Forstå komplekse sårbarheder

Selv som vores forskning, og andre', viser, hvordan individer, institutioner og endda hele samfund kan manipuleres på sociale medier, der er mange spørgsmål tilbage at besvare. Det er især vigtigt at opdage, hvordan disse forskellige fordomme interagerer med hinanden, potentielt skabe mere komplekse sårbarheder.

Værktøjer som vores tilbyder internetbrugere mere information om desinformation, og derfor en vis grad af beskyttelse mod dens skader. Løsningerne vil sandsynligvis ikke kun være teknologiske, selvom der nok vil være nogle tekniske aspekter ved dem. Men de skal tage højde for de kognitive og sociale aspekter af problemet.

Redaktørens note:Denne artikel blev opdateret den 10. januar, 2019, for at fjerne et link til en undersøgelse, der er blevet trukket tilbage. Artiklens tekst er stadig korrekt, og forbliver uændret.

Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.

Varme artikler

Varme artikler

-

Ruslands Kalashnikov forgrener sig fra rifler til robotter og e-bilerPrototypen af elbilen, kaldet CV-1, produceret af den russiske våbenproducent Kalashnikov, som søger at diversificere Et nyligt løfte fra Kalashnikov om at konkurrere med Elon Musks Tesla med en

Ruslands Kalashnikov forgrener sig fra rifler til robotter og e-bilerPrototypen af elbilen, kaldet CV-1, produceret af den russiske våbenproducent Kalashnikov, som søger at diversificere Et nyligt løfte fra Kalashnikov om at konkurrere med Elon Musks Tesla med en -

EU-domstol:Facebook kan blive tvunget til at fjerne indhold på verdensplanDenne 16. juli, 2013, fil foto, viser et skilt ved Facebook-hovedkvarteret i Menlo Park, Calif. Facebook siger, at det har suspenderet titusindvis af apps lavet af omkring 400 udviklere som led i en u

EU-domstol:Facebook kan blive tvunget til at fjerne indhold på verdensplanDenne 16. juli, 2013, fil foto, viser et skilt ved Facebook-hovedkvarteret i Menlo Park, Calif. Facebook siger, at det har suspenderet titusindvis af apps lavet af omkring 400 udviklere som led i en u -

Det er måske ikke godt for dig at omdanne dine sundhedsdata til en wellness-scoreDe data, der lagres af din smartphone, kan bruges til at bestemme din sundhedsrisiko, og det kan være forkert. Kredit:Shutterstock Kameraer ser os næsten overalt, hvor vi går. Vi ved, at internett

Det er måske ikke godt for dig at omdanne dine sundhedsdata til en wellness-scoreDe data, der lagres af din smartphone, kan bruges til at bestemme din sundhedsrisiko, og det kan være forkert. Kredit:Shutterstock Kameraer ser os næsten overalt, hvor vi går. Vi ved, at internett -

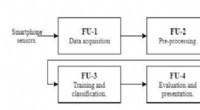

Et nyt smartphone-brugergodkendelsessystem baseret på ganganalyseSystemets oversigt. Kredit:Mufandaidza, Ramotsoela &Hancke. Et team af forskere ved University of Pretoria og City University of Hong Kong har for nylig udviklet et kontinuerligt smartphone-bruger

Et nyt smartphone-brugergodkendelsessystem baseret på ganganalyseSystemets oversigt. Kredit:Mufandaidza, Ramotsoela &Hancke. Et team af forskere ved University of Pretoria og City University of Hong Kong har for nylig udviklet et kontinuerligt smartphone-bruger

- Frygt ikke robotterne:Hjælp fremtidige arbejdere med at lære at innovere

- Hvad er havskum egentlig?

- Ung,

- Topvirksomhedsledere deler erfaringer fra COVID-krisen i ny rapport

- Sådan regnes ud af den ioniske procentdel, når du har fået forskellen mellem elektronegativitet

- Kolonisering af Antillerne af sydamerikansk fauna:kæmpe nedsænkede øer som en passage?