Personlig dybdelæring ruster robotter til autismeterapi

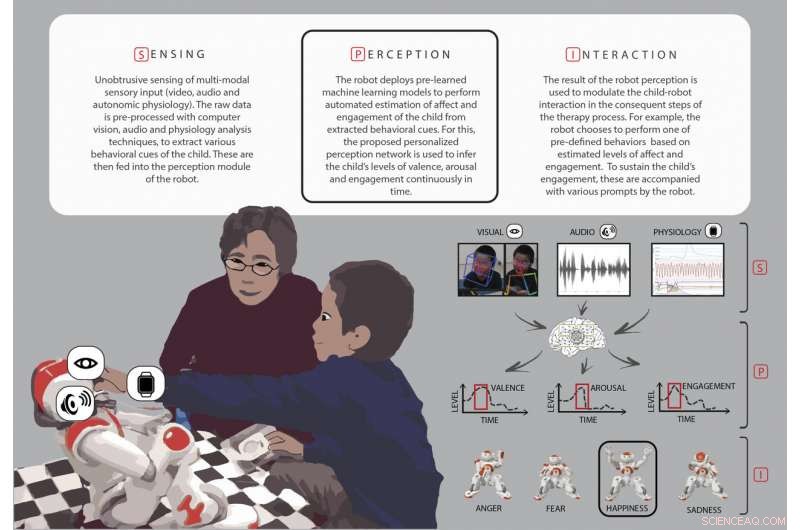

Oversigt over de vigtigste stadier (sansning, opfattelse, og interaktion) under robotassisteret autismeterapi. Kredit:Rudovic et al., Sci. Robot . 3, eaao6760 (2018)

Børn med autismespektrumtilstande har ofte problemer med at genkende de følelsesmæssige tilstande hos mennesker omkring dem - ved at skelne et glad ansigt fra et frygtsomt ansigt, for eksempel. For at afhjælpe dette, nogle terapeuter bruger en børnevenlig robot til at demonstrere disse følelser og til at engagere børnene i at efterligne følelserne og reagere på dem på passende måder.

Denne type terapi virker bedst, imidlertid, hvis robotten uden problemer kan fortolke barnets egen adfærd – uanset om han eller hun er interesseret og spændt eller opmærksom – under terapien. Forskere ved MIT Media Lab har nu udviklet en form for personlig maskinlæring, der hjælper robotter med at vurdere engagementet og interessen for hvert enkelt barn under disse interaktioner, ved hjælp af data, der er unikke for det pågældende barn.

Bevæbnet med dette personlige "deep learning" netværk, robotternes opfattelse af børnenes svar stemmer overens med vurderinger fra menneskelige eksperter, med en korrelationsscore på 60 procent, forskerne rapporterer 27. juni i Videnskab robotik .

Det kan være udfordrende for menneskelige observatører at nå høje niveauer af enighed om et barns engagement og adfærd. Deres korrelationsscore er normalt mellem 50 og 55 procent. Rudovic og hans kolleger foreslår, at robotter, der er trænet i menneskelige observationer, som i denne undersøgelse, kunne en dag give mere konsistente skøn over denne adfærd.

"Det langsigtede mål er ikke at skabe robotter, der vil erstatte menneskelige terapeuter, men for at udvide dem med nøgleinformation, som terapeuterne kan bruge til at tilpasse terapiindholdet og også skabe mere engagerende og naturalistiske interaktioner mellem robotterne og børn med autisme, " forklarer Oggi Rudovic, en postdoc på Media Lab og førsteforfatter på undersøgelsen.

Rosalind Picard, en medforfatter på papiret og professor ved MIT, der leder forskning i affektiv computing, siger, at personalisering er særlig vigtig i autismeterapi:Et berømt ordsprog er, "Hvis du har mødt én person, med autisme, du har mødt en person med autisme."

"Udfordringen med at skabe maskinlæring og AI [kunstig intelligens], der virker i autisme, er særlig irriterende, fordi de sædvanlige AI-metoder kræver en masse data, der ligner hinanden for hver kategori, der læres. I autisme, hvor heterogenitet hersker, de normale AI-tilgange fejler, " siger Picard. Rudovic, Picard, og deres holdkammerater har også brugt personlig dyb læring på andre områder, konstaterer, at det forbedrer resultaterne for smerteovervågning og til at forudsige Alzheimers sygdomsprogression.

Møde NAO

Robot-assisteret terapi for autisme fungerer ofte sådan her:En menneskelig terapeut viser et barn billeder eller flash-kort af forskellige ansigter, der er beregnet til at repræsentere forskellige følelser, at lære dem at genkende udtryk for frygt, sorg, eller glæde. Terapeuten programmerer derefter robotten til at vise de samme følelser til barnet, og observerer barnet, mens hun eller han engagerer sig i robotten. Barnets adfærd giver værdifuld feedback, som robotten og terapeuten har brug for for at gå videre med lektionen.

Forskerne brugte SoftBank Robotics NAO humanoide robotter i denne undersøgelse. Næsten 2 fod høj og ligner en pansret superhelt eller en droid, NAO formidler forskellige følelser ved at ændre farven på sine øjne, dens lemmers bevægelse, og tonen i dens stemme.

De 35 børn med autisme, der deltog i denne undersøgelse, 17 fra Japan og 18 fra Serbien, varierede i alderen fra 3 til 13. De reagerede på forskellige måder på robotterne under deres 35-minutters sessioner, fra at se træt og søvnig ud i nogle tilfælde til at hoppe rundt i rummet med spænding, klapper i hænderne, og griner eller rører ved robotten.

De fleste af børnene i undersøgelsen reagerede på robotten "ikke bare som et legetøj, men relateret til NAO respektfuldt, som om det var en rigtig person, "især under historiefortælling, hvor terapeuterne spurgte, hvordan NAO ville have det, hvis børnene tog robotten til en is-godbid, ifølge Rudovic.

En 4-årig pige gemte sig bag sin mor, mens hun deltog i sessionen, men blev meget mere åben over for robotten og endte med at grine ved slutningen af terapien. Søsteren til et af de serbiske børn gav NAO et kram og sagde "Robot, Jeg elsker dig!" i slutningen af en session, sagde, at hun var glad for at se, hvor meget hendes bror kunne lide at lege med robotten.

"Terapeuter siger, at det kan være en stor udfordring for dem at engagere barnet i blot et par sekunder. og robotter tiltrækker barnets opmærksomhed, " siger Rudovic, forklarer, hvorfor robotter har været nyttige i denne type terapi. "Også, mennesker ændrer deres udtryk på mange forskellige måder, men robotterne gør det altid på samme måde, og det er mindre frustrerende for barnet, fordi barnet lærer på en meget struktureret måde, hvordan udtrykkene vil blive vist."

Personlig maskinlæring

MIT-forskerholdet indså, at en slags maskinlæring kaldet deep learning ville være nyttig for terapirobotterne at have, at opfatte børnenes adfærd mere naturligt. Et dybt læringssystem bruger hierarkiske, flere lag af databehandling for at forbedre sine opgaver, hvor hvert efterfølgende lag svarer til en lidt mere abstrakt repræsentation af de originale rådata.

Selvom begrebet deep learning har eksisteret siden 1980'erne, siger Rudovic, det er først for nylig, at der har været nok computerkraft til at implementere denne form for kunstig intelligens. Deep learning er blevet brugt i automatiske tale- og objektgenkendelsesprogrammer, hvilket gør det velegnet til et problem som f.eks. at forstå de mange træk i ansigtet, legeme, og stemme, der går ind i at forstå et mere abstrakt begreb, såsom et barns engagement.

"I tilfælde af ansigtsudtryk, for eksempel, hvilke dele af ansigtet er de vigtigste for estimering af engagement?" siger Rudovic. "Dyb læring gør det muligt for robotten direkte at udtrække de vigtigste informationer fra disse data uden behov for, at mennesker manuelt skal lave disse funktioner." For terapirobotterne , Rudovic og hans kolleger tog ideen om dyb læring et skridt videre og byggede en personlig ramme, der kunne lære af data indsamlet om hvert enkelt barn. Forskerne optog video af hvert barns ansigtsudtryk, hoved- og kropsbevægelser, stillinger og fagter, lydoptagelser og data om puls, kropstemperatur, og hudsvedrespons fra en skærm på barnets håndled.

Robotternes personlige deep learning-netværk blev bygget ud fra lag af disse videoer, lyd, og fysiologiske data, information om barnets autismediagnose og evner, deres kultur og deres køn. Forskerne sammenlignede derefter deres estimater af børns adfærd med estimater fra fem menneskelige eksperter, hvem kodede børnenes video- og lydoptagelser på en kontinuerlig skala for at afgøre, hvor glad eller ked af det, hvor interesseret, og hvor engageret barnet virkede under sessionen.

Trænet på disse personlige data kodet af mennesker, og testet på data, der ikke bruges til træning eller tuning af modellerne, netværkene forbedrede markant robottens automatiske estimering af barnets adfærd for de fleste af børnene i undersøgelsen, ud over, hvad der ville blive estimeret, hvis netværket kombinerede alle børns data i en "one-size-fits-all" tilgang, fandt forskerne.

Rudovic og kolleger var også i stand til at undersøge, hvordan deep learning-netværket lavede sine vurderinger, som afslørede nogle interessante kulturelle forskelle mellem børnene. "For eksempel, børn fra Japan viste flere kropsbevægelser under episoder med højt engagement, mens store kropsbevægelser hos serbere var forbundet med tilbagetrækningsepisoder, " siger Rudovic.

Sidste artikelLavprisfodprotese efterligner naturlig gang

Næste artikelWPA3-sikkerhedsprotokol holder Wi-Fi-forbindelser sikrere

Varme artikler

Varme artikler

-

Team demonstrerer fungerende prototype af nødudluftningFørste fungerende prototype af RapidVent ventilator Kredit:RapidVent Et team ledet af University of Illinois ved Urbana-Champaigns Grainger College of Engineering og Carle Health har produceret en

Team demonstrerer fungerende prototype af nødudluftningFørste fungerende prototype af RapidVent ventilator Kredit:RapidVent Et team ledet af University of Illinois ved Urbana-Champaigns Grainger College of Engineering og Carle Health har produceret en -

Bærbare sensorer efterligner hud for at hjælpe med sårhelingsprocessenSensoren på en tekstil-silicium bandage. Kredit:Matthew Brown Forskere ved Binghamton University, State University of New York, har udviklet hud-inspireret elektronik til at tilpasse sig huden, gi

Bærbare sensorer efterligner hud for at hjælpe med sårhelingsprocessenSensoren på en tekstil-silicium bandage. Kredit:Matthew Brown Forskere ved Binghamton University, State University of New York, har udviklet hud-inspireret elektronik til at tilpasse sig huden, gi -

Efter det historiske kvarter, Tesla ser mod Europa, KinaAktier i elbilproducenten Tesla sprang i eftermarkedet efter selskabets kvartalsvise indtjeningsrapport Elbilproducenten Tesla rapporterede onsdag et historisk kvartalsresultat drevet af efterspør

Efter det historiske kvarter, Tesla ser mod Europa, KinaAktier i elbilproducenten Tesla sprang i eftermarkedet efter selskabets kvartalsvise indtjeningsrapport Elbilproducenten Tesla rapporterede onsdag et historisk kvartalsresultat drevet af efterspør -

Walmart begynder temperaturtjek af arbejdereWalmart vil begynde at måle temperaturen på sine amerikanske arbejdere, afspejler en praksis, der nu er udbredt i Kina, da den reagerer på coronavirus Walmart meddelte tirsdag, at det vil begynde

Walmart begynder temperaturtjek af arbejdereWalmart vil begynde at måle temperaturen på sine amerikanske arbejdere, afspejler en praksis, der nu er udbredt i Kina, da den reagerer på coronavirus Walmart meddelte tirsdag, at det vil begynde

- Unge studerendes læsefærdigheder gik i stå under pandemien

- Ny kvantehukommelse gemmer information i timevis

- Hvordan kommunikation om miljøspørgsmål kan bygge bro over den politiske kløft

- FAA godkendte lige et hybrid luftskib,

- Stor kosmologisk simulation til at køre på Mira

- Investeringsnøgle i tilpasning til klimaændringer i Vestafrika